超長視頻生成新突破!LongVie框架問世,創作不再受時長限制

文章來源:Poixe AI

在AI技術飛速發展的當下,視頻生成領域取得了令人矚目的進步,尤其是在短視頻創作方面。然而,當視頻時長超過一分鐘時,保持畫質、風格和內容的高度一致性,仍然是一個巨大的技術挑戰。

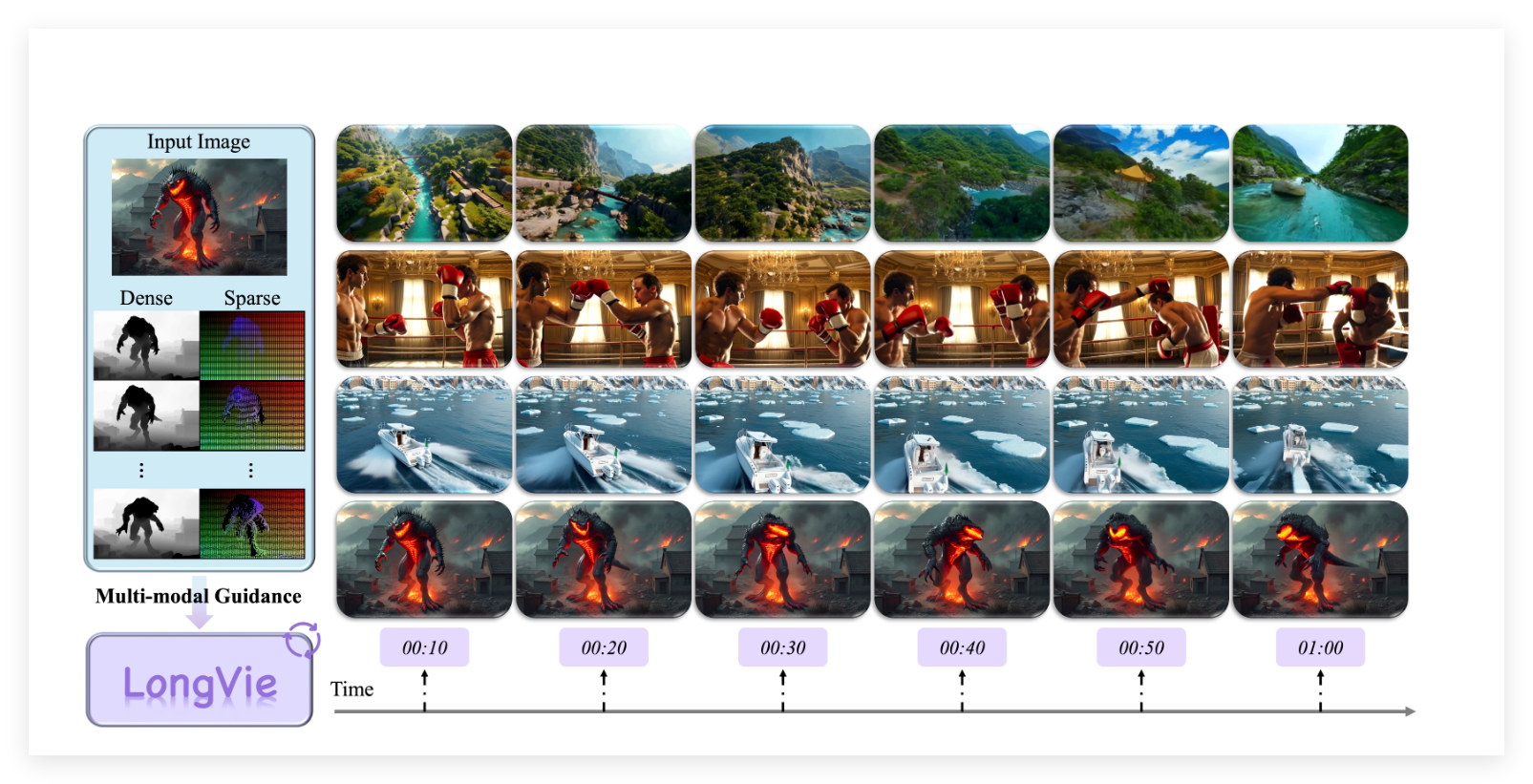

為攻克這一難題,上海人工智能實驗室聯合南京大學、復旦大學、南洋理工大學S-Lab以及英偉達等頂尖機構,共同推出了革命性的 LongVie 框架。這款框架旨在系統性解決超長視頻生成中的核心問題,為創作者們開啟一個無界限的創作新時代。

核心挑戰:時序不一致與視覺退化

傳統視頻生成模型在處理長視頻時,主要面臨兩大核心挑戰:

- 時序不一致: 畫面細節與內容在不同片段間缺乏連貫性,導致視頻整體感覺不自然。

- 視覺退化: 隨著視頻時長的增加,畫面顏色和清晰度會逐漸下降,影響最終的視覺質量。

LongVie 框架正是為了解決這些痛點而生。

LongVie框架:從根源解決問題

為了確保超長視頻的連貫性與高質量,LongVie 框架從“控制信號”和“初始噪聲”兩個關鍵方面入手,提出了創新的解決方案:

- 全局歸一化控制信號:

- 創新點: 傳統的生成模型只在單個片段內進行歸一化。

- LongVie 策略: 統一整個視頻段的控制信號(如深度圖、關鍵點等),從而顯著提升跨片段的連貫性和流暢性。

- 統一噪聲初始化:

- 創新點: 確保視頻的各個片段共享相同的初始噪聲。

- LongVie 策略: 從源頭上減少不同片段之間的視覺漂移,保證整體風格和畫質的一致性。

此外,在解決視覺退化問題上,LongVie 采用了多模態精細控制方法,結合了密集控制信號和稀疏控制信號,并引入了“退化感知訓練策略”,確保模型在處理長視頻時,能夠持續保持高畫質和細節的穩定性。

行業新標桿:LongVGenBench數據集與SOTA性能

為了推動整個領域的進步,LongVie 團隊還推出了 LongVGenBench,這是首個專為可控超長視頻生成設計的基準數據集。該數據集包含100個超過1分鐘的高分辨率視頻,為研究人員提供了統一的評測標準。

根據定量指標和用戶評測結果,LongVie 在多個評估維度上均超越了現有技術,贏得了用戶的高度認可,達到了 SOTA(State-of-the-Art,最先進技術) 水平。

總結:

LongVie 框架的問世,無疑是AI視頻生成領域的一個重要里程碑。它系統性地解決了超長視頻生成中的核心挑戰,為創作者們提供了前所未有的自由度和控制力。隨著這項技術的普及,我們有理由相信,AI生成視頻的未來將不再受時長限制,創意將能夠真正無界限地實現。

項目地址: https://vchitect.github.io/LongVie-project/

)

)

- DRM簡介)

C++入門(下))