論文標題

Learning to Reason under Off-Policy Guidance

論文地址

https://arxiv.org/pdf/2504.14945

代碼地址

https://github.com/ElliottYan/LUFFY

作者背景

上海人工智能實驗室,西湖大學,南京大學,香港中文大學

動機

目前大模型的后訓練方法有 SFT 和 RL 兩種形式,前者強調模仿,后者強調探索。兩類后訓練方法各有千秋,基于模仿的訓練能夠快速調整模型的行為模式,但這種調整很可能流于表面而非真正掌握解題策略;基于探索的訓練能夠使模型自行找出獎勵最高的行為策略,但受限于基礎模型本身的能力,探索時很可能只是反復嘗試當前已掌握的行為模式,難以利用全新的思路去解決問題,實踐中我們也經常遇到RL訓練進入瓶頸的問題

于是作者希望結合“模仿”與“探索”兩種學習方式,讓模型自主探索解題策略的同時,也有機會模仿外部強模型的行為模式,從而使大模型獲得超越其初始認知邊界的推理能力

本文方法

本文提出 LUFFY(Learning to reason Under oFF-policY guidance),核心思想是引入外部強模型(deepseek-R1)作為off-policy,與當前策略模型(on-policy)一同參與采樣,從而指導 RL 進行更高效的學習,避免純 on-policy 模型在面臨復雜問題時遲遲探索不出有效策略

一、LUFFY流程與優化目標

如上圖所示,對于問題q,由當前策略模型與外部強模型共同采樣一組輸出,然后使用統一的獎勵函數對所有采樣評分(檢查格式正確性與答案正確性)

和標準GRPO一樣,對所有回答的獎勵分數做標準化作為優勢,即高于均值的優勢為正,低于均值的優勢為負或較小。由于外部強模型采樣得更少,只有當策略模型難以獨立生成正確解時它才占據產生梯度的主導地位,一旦策略模型能夠產生成功的推理軌跡, GRPO便開始鼓勵自主探索

grpo算法通常需要進行重要性采樣,因為它在策略更新過程中,使用舊策略上采樣的數據去預估新策略的期望回報

LUFFY中使用了off-policy模型,更需要進行這一校準,其優化目標如下所示:

為了更好地模擬外部強模型的行為,作者最終移除了梯度裁剪

二、梯度塑形

作者發現,直接按照上述流程將外部強模型引入RL訓練后,盡管利用重要性采樣加速了收斂,但模型表現出低熵、探索行為明細變少。這是因為策略模型在模仿外部模型時,對不同概率的token存在偏差,即策略模型傾向于強化那些【同時常見于 onPolicy 分布與 offPolicy 分布的token】,忽略了【不常見于 OnPolicy 分布的 token】,即便這些token在offPolicy中出現概率很高。如此一來,模型便忽略了這部分體現強模型關鍵推理能力的低概率token

教師正在認真糾正學生的錯誤想法,但學生只想著“求同存異”,迅速理解了老師的思想與自己的共同之處,而沒關注到老師的獨特之處

為了解決這一問題,作者提出了“梯度塑形”方法,本質上便是根據 token 不同的概率對梯度進行加權。具體地,作者使用了 f(x)=γ/(γ+x) 這一變換函數(γ為超參數,實驗中取0.1),其函數圖像為:

加入梯度塑形后,訓練過程中策略模型的熵始終保持在一個較高的狀態,即具有更好的探索能力,并且有效避免了 Entropy Collapse

實驗結果

基于 Qwen2.5-Math-7B 模型,在OpenR1-Math-220k上進行訓練,外部強模型使用DeepSeek-R1,在6個常用的數學推理基準上測試

可見 LUFFY 方法全面超越了各類on-policy與off-policy方法

實驗各策略的資源開銷對比

其他模型實驗結果

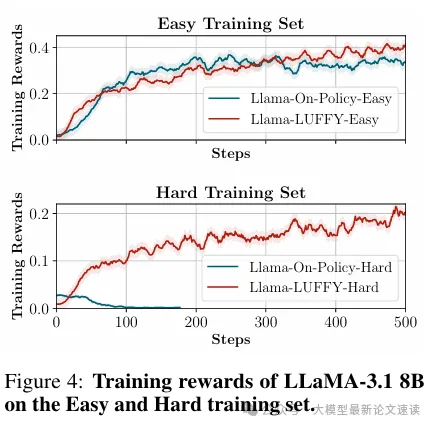

LUFFY與on-policy RL訓練動態對比

LUFFY 在困難問題上能夠問答訓練,而on-policy 方法崩潰

各組件消融實驗

結合稀缺數據預測嬰兒腦連接|文獻速遞-深度學習醫療AI最新文獻)

![[特殊字符] 深入理解 Linux 內核進程管理:架構、核心函數與調度機制](http://pic.xiahunao.cn/[特殊字符] 深入理解 Linux 內核進程管理:架構、核心函數與調度機制)

)