文章目錄

- 發現寶藏

- 一、 目標

- 二、 淺析

- 三、獲取所有模塊

- 四、請求處理模塊、版面、文章

- 1. 分析切換頁面的參數傳遞

- 2. 獲取共有多少頁標簽并遍歷版面

- 3.解析版面并保存版面信息

- 4. 解析文章列表和文章

- 5. 清洗文章

- 6. 保存文章圖片

- 五、完整代碼

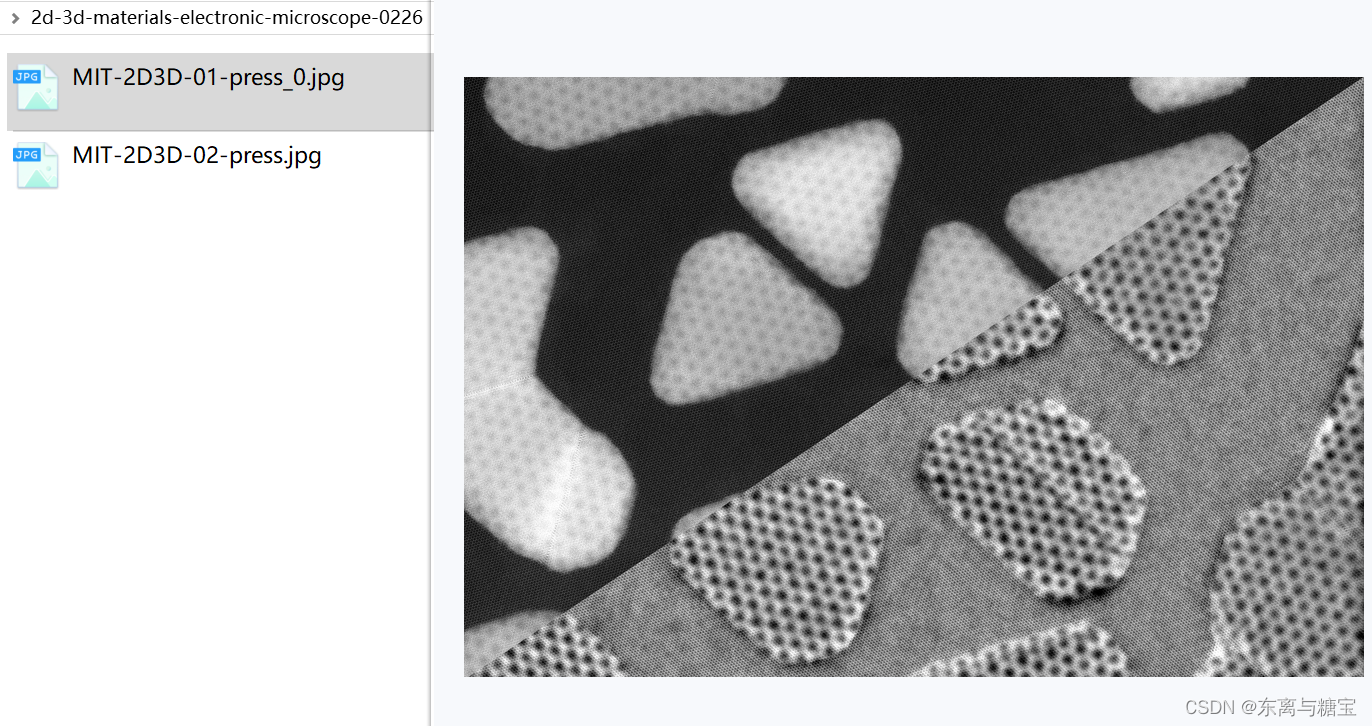

- 六、效果展示

發現寶藏

前些天發現了一個巨牛的人工智能學習網站,通俗易懂,風趣幽默,忍不住分享一下給大家。【寶藏入口】。

一、 目標

爬取news.mit.edu的字段,包含標題、內容,作者,發布時間,鏈接地址,文章快照 (可能需要翻墻才能訪問)

二、 淺析

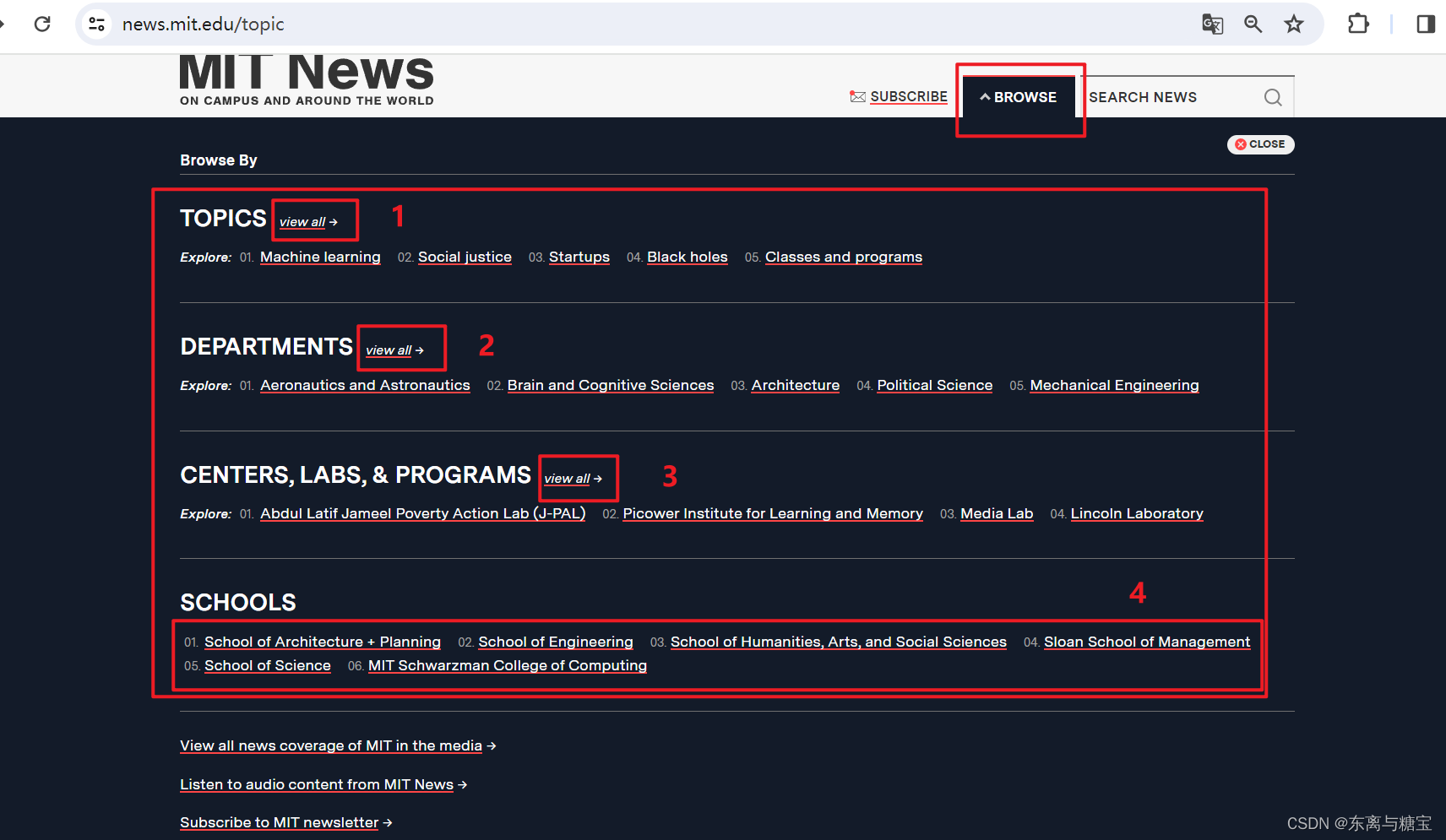

1.全部新聞大致分為4個模塊

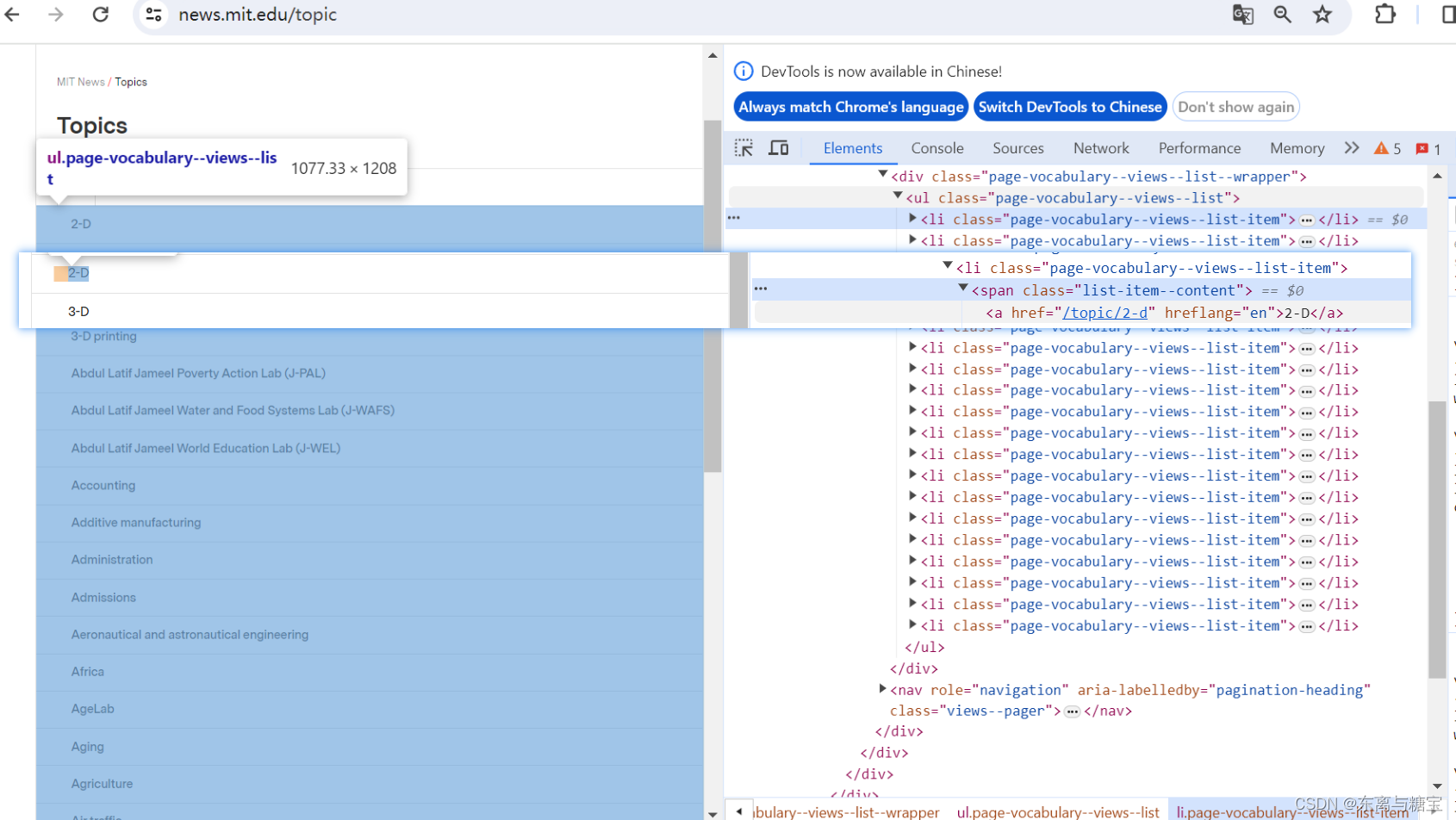

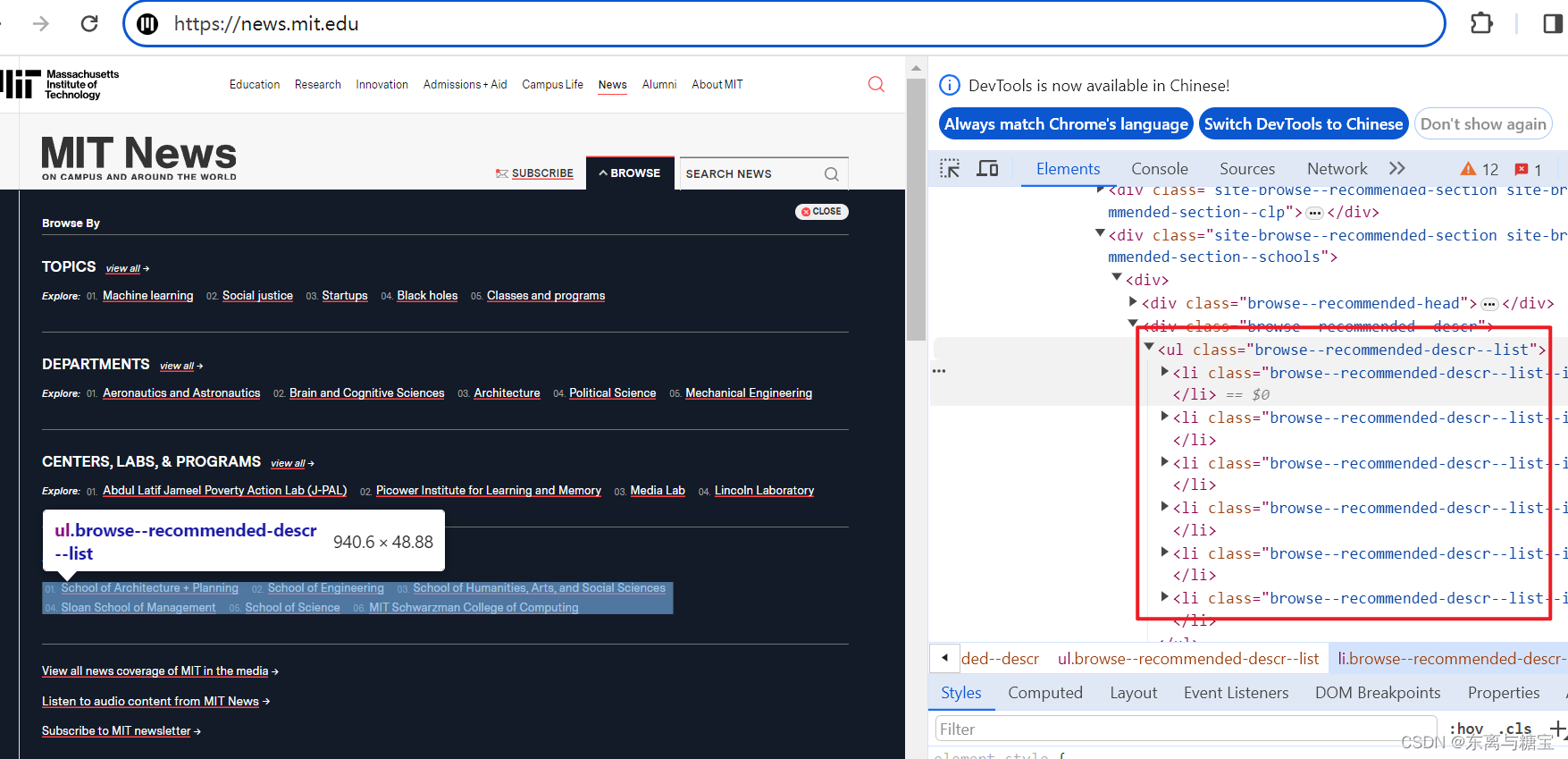

2.每個模塊的標簽列表大致如下

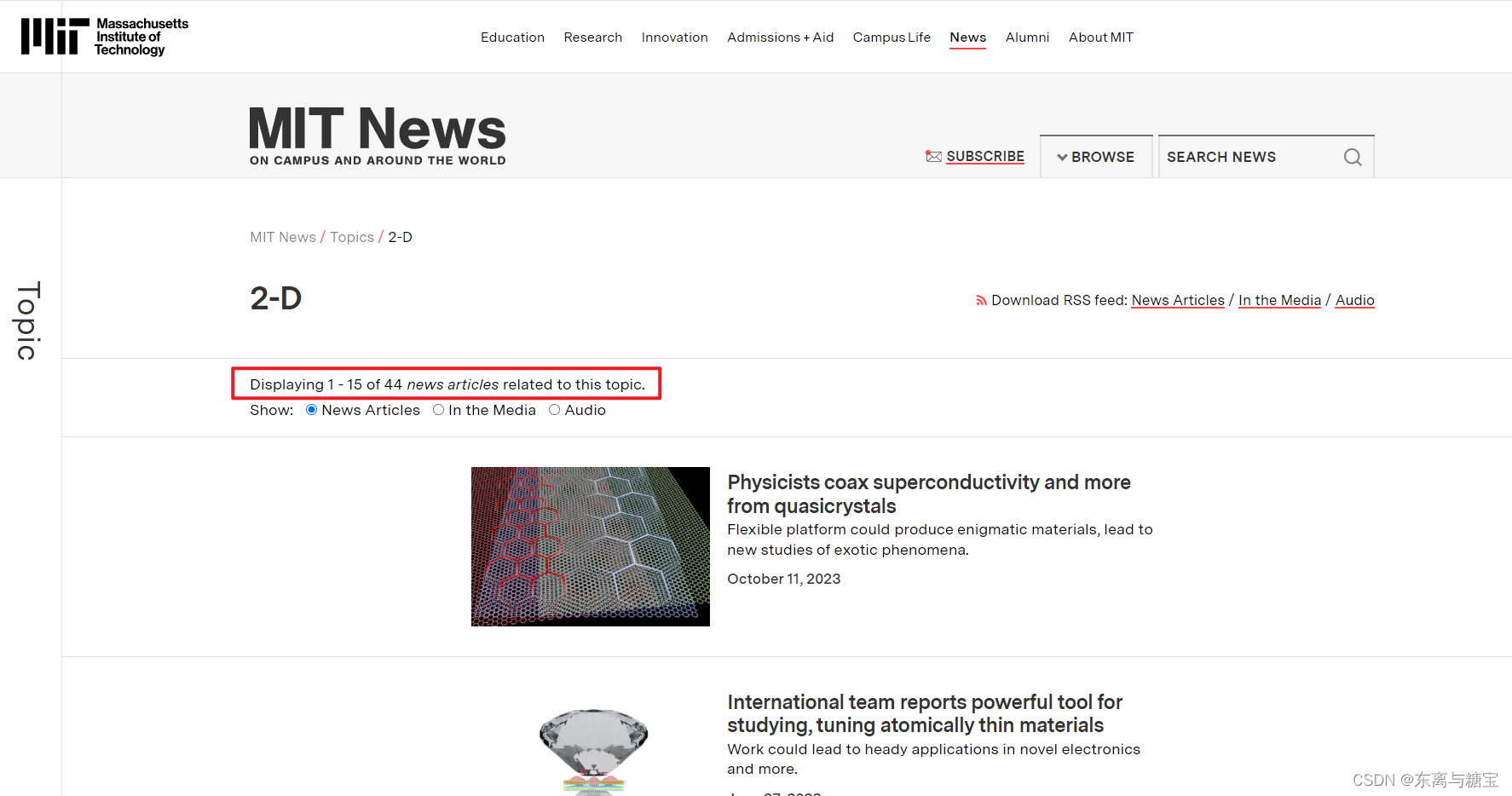

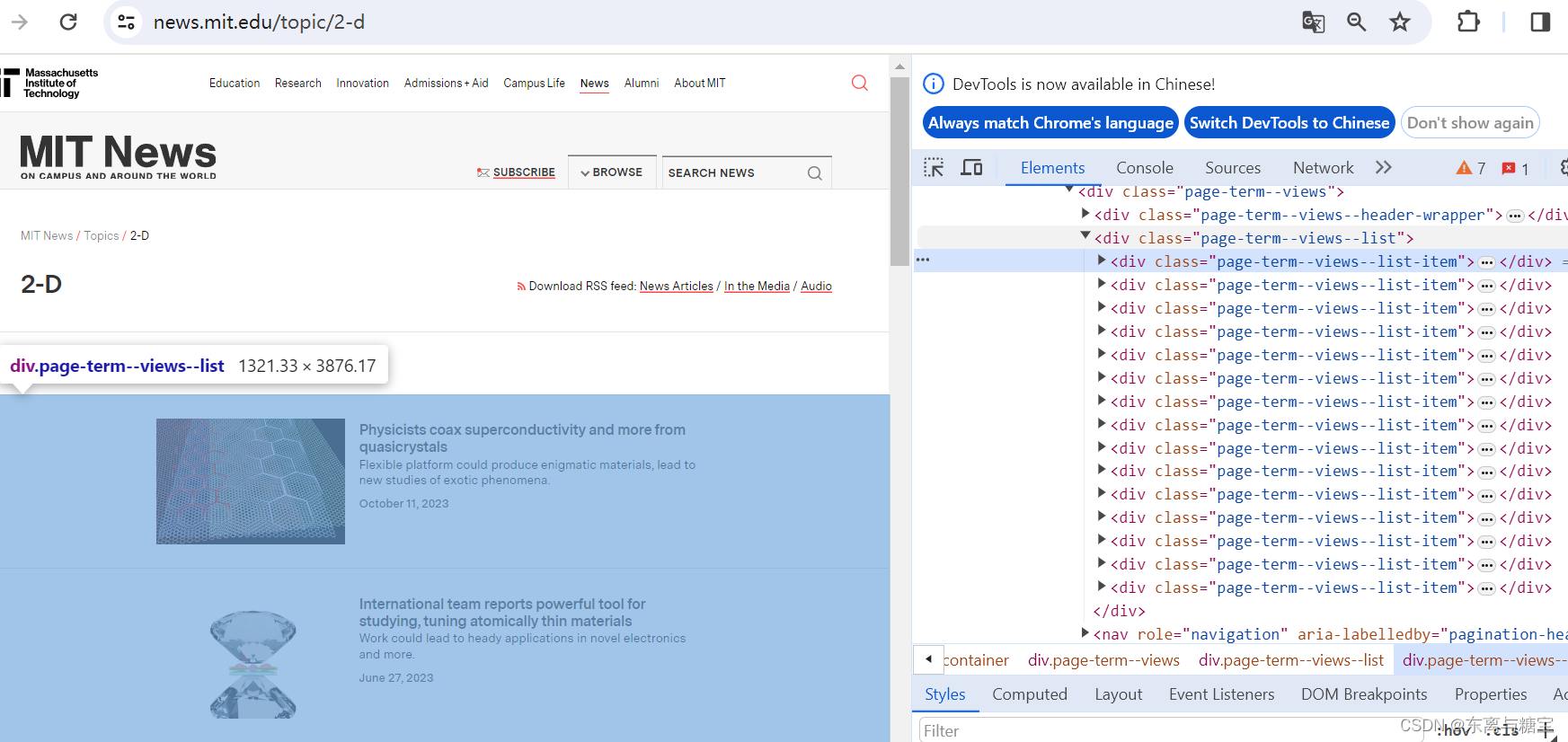

3.每個標簽對應的文章列表大致如下

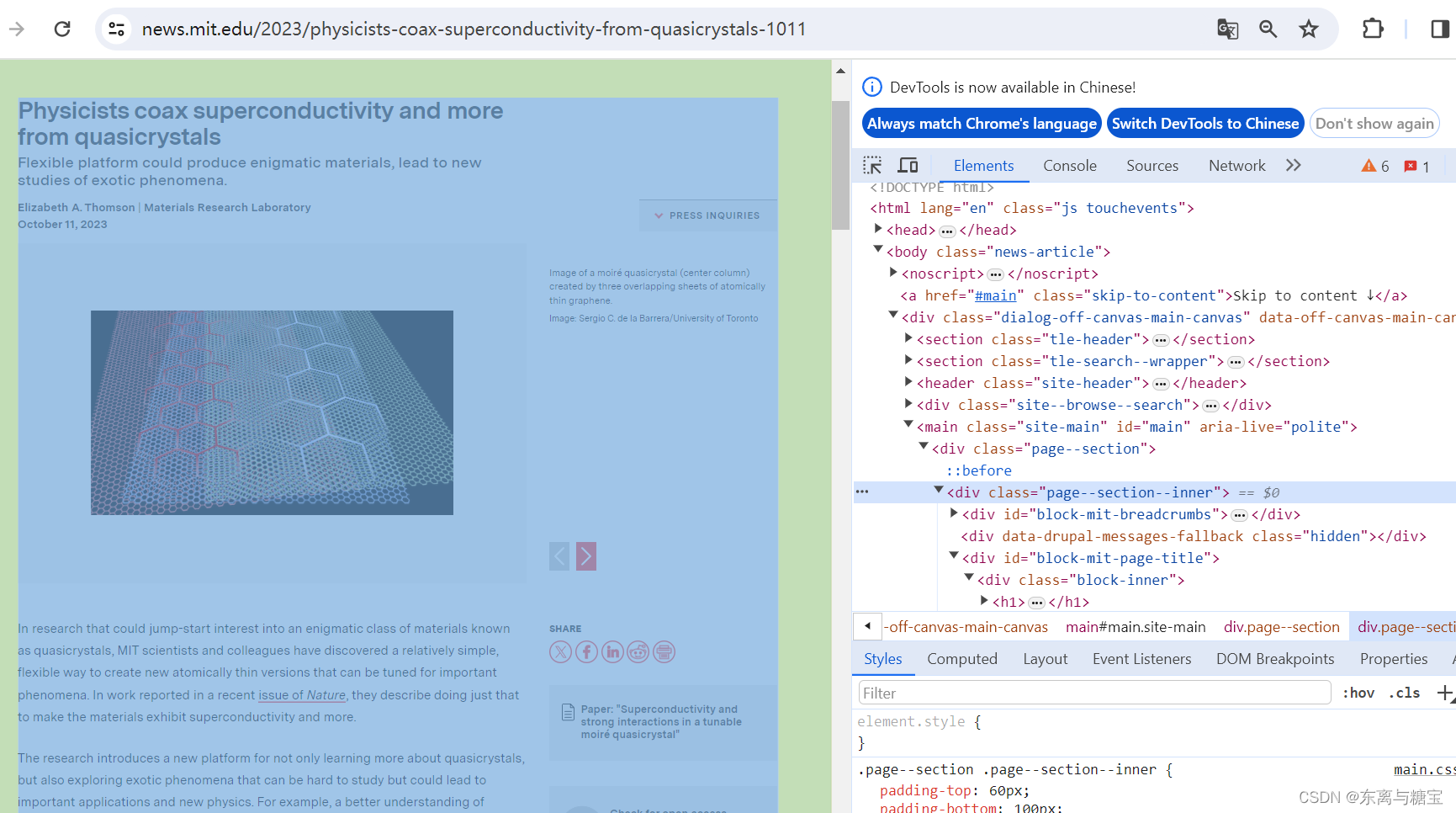

4.具體每篇文章對應的結構如下

三、獲取所有模塊

其實就四個模塊,列舉出來就好,然后對每個分別解析爬取每個模塊

class MitnewsScraper:def __init__(self, root_url, model_url, img_output_dir):self.root_url = root_urlself.model_url = model_urlself.img_output_dir = img_output_dirself.headers = {'Referer': 'https://news.mit.edu/','User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) ''Chrome/122.0.0.0 Safari/537.36','Cookie': '替換成你自己的',}...def run():root_url = 'https://news.mit.edu/'model_urls = ['https://news.mit.edu/topic', 'https://news.mit.edu/clp','https://news.mit.edu/department', 'https://news.mit.edu/']output_dir = 'D:\imgs\mit-news'for model_url in model_urls:scraper = MitnewsScraper(root_url, model_url, output_dir)scraper.catalogue_all_pages()

四、請求處理模塊、版面、文章

先處理一個模塊(TOPICS)

1. 分析切換頁面的參數傳遞

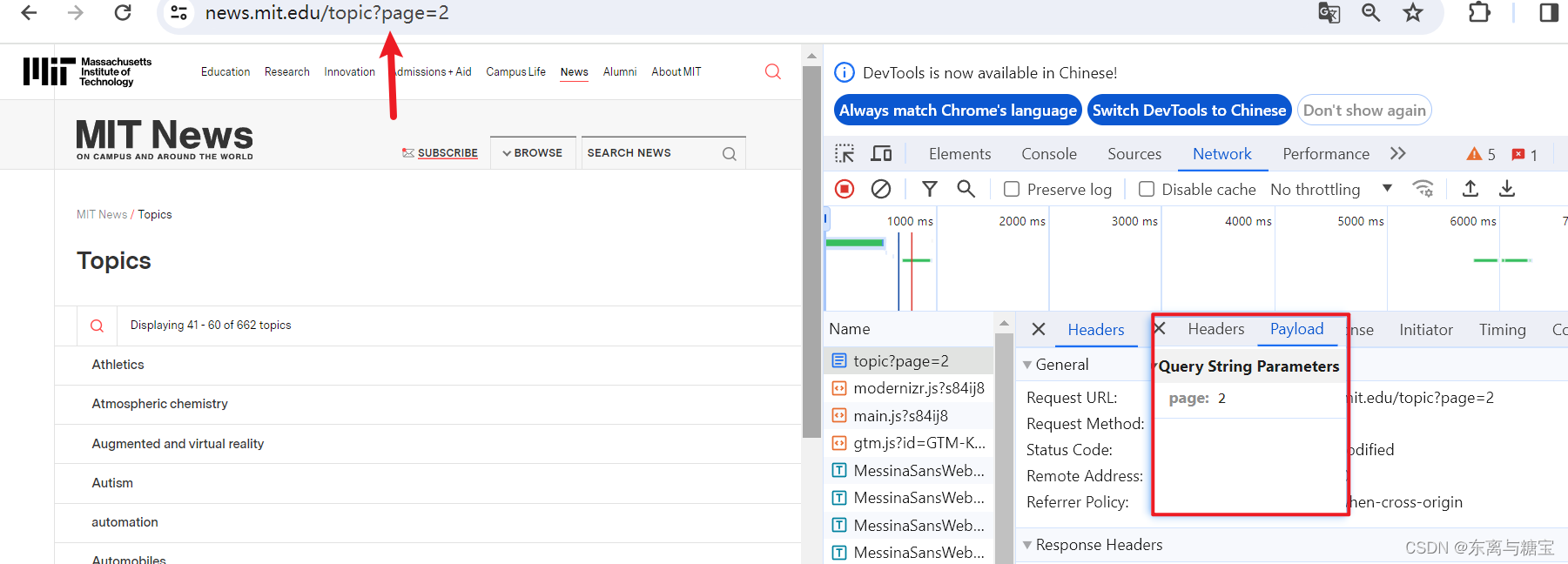

如圖可知是get請求,需要傳一個參數page

2. 獲取共有多少頁標簽并遍歷版面

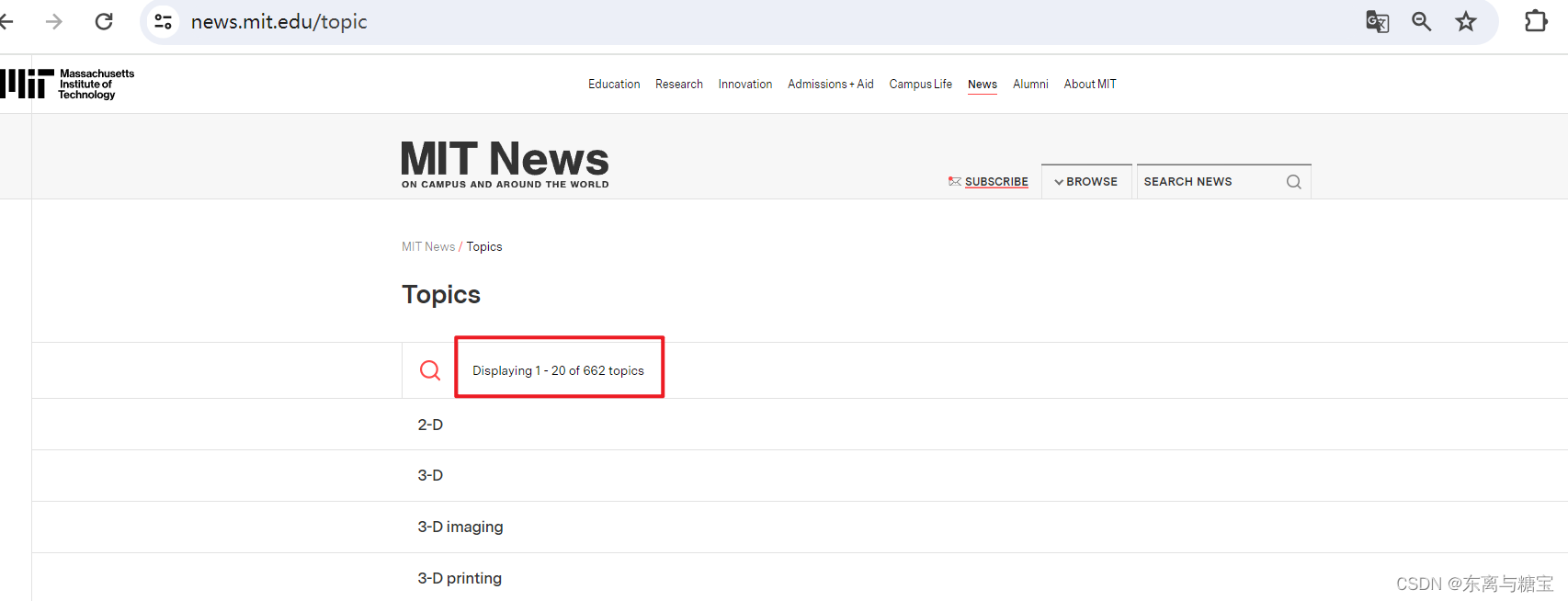

實際上是獲取所有的page參數,然后進行遍歷獲取所有的標簽

# 獲取一個模塊有多少版面def catalogue_all_pages(self):response = requests.get(self.model_url, headers=self.headers)soup = BeautifulSoup(response.text, 'html.parser')try:match = re.search(r'of (\d+) topics', soup.text)total_catalogues = int(match.group(1))total_pages = math.ceil(total_catalogues / 20)print('topics模塊一共有' + match.group(1) + '個版面,' + str(total_pages) + '頁數據')for page in range(0, total_pages):self.parse_catalogues(page)print(f"========Finished catalogues page {page + 1}========")except:self.parse_catalogues(0)

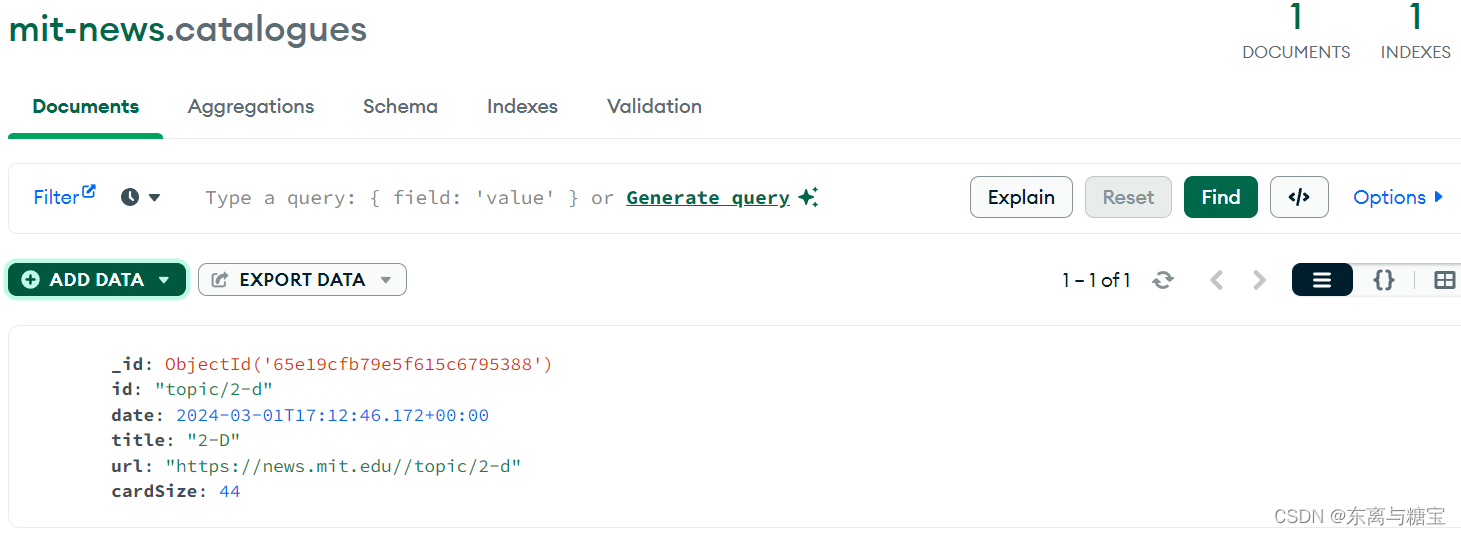

3.解析版面并保存版面信息

前三個模塊的版面列表

第四個模塊的版面列表

# 解析版面列表里的版面def parse_catalogues(self, page):params = {'page': page}response = requests.get(self.model_url, params=params, headers=self.headers)if response.status_code == 200:soup = BeautifulSoup(response.text, 'html.parser')if self.root_url == self.model_url:catalogue_list = soup.find('div','site-browse--recommended-section site-browse--recommended-section--schools')catalogues_list = catalogue_list.find_all('li')else:catalogue_list = soup.find('ul', 'page-vocabulary--views--list')catalogues_list = catalogue_list.find_all('li')for index, catalogue in enumerate(catalogues_list):# 操作時間date = datetime.now()# 版面標題catalogue_title = catalogue.find('a').get_text(strip=True)print('第' + str(index + 1) + '個版面標題為:' + catalogue_title)catalogue_href = catalogue.find('a').get('href')# 版面idcatalogue_id = catalogue_href[1:]catalogue_url = self.root_url + catalogue_hrefprint('第' + str(index + 1) + '個版面地址為:' + catalogue_url)# 根據版面url解析文章列表response = requests.get(catalogue_url, headers=self.headers)soup = BeautifulSoup(response.text, 'html.parser')match = re.search(r'of (\d+)', soup.text)# 查找一個版面有多少篇文章total_cards = int(match.group(1))total_pages = math.ceil(total_cards / 15)print(f'{catalogue_title}版面一共有{total_cards}篇文章,' + f'{total_pages}頁數據')for page in range(0, total_pages):self.parse_cards_list(page, catalogue_url, catalogue_id)print(f"========Finished {catalogue_title} 版面 page {page + 1}========")# 連接 MongoDB 數據庫服務器client = MongoClient('mongodb://localhost:27017/')# 創建或選擇數據庫db = client['mit-news']# 創建或選擇集合catalogues_collection = db['catalogues']# 插入示例數據到 catalogues 集合catalogue_data = {'id': catalogue_id,'date': date,'title': catalogue_title,'url': catalogue_url,'cardSize': total_cards}catalogues_collection.insert_one(catalogue_data)return Trueelse:raise Exception(f"Failed to fetch page {page}. Status code: {response.status_code}")

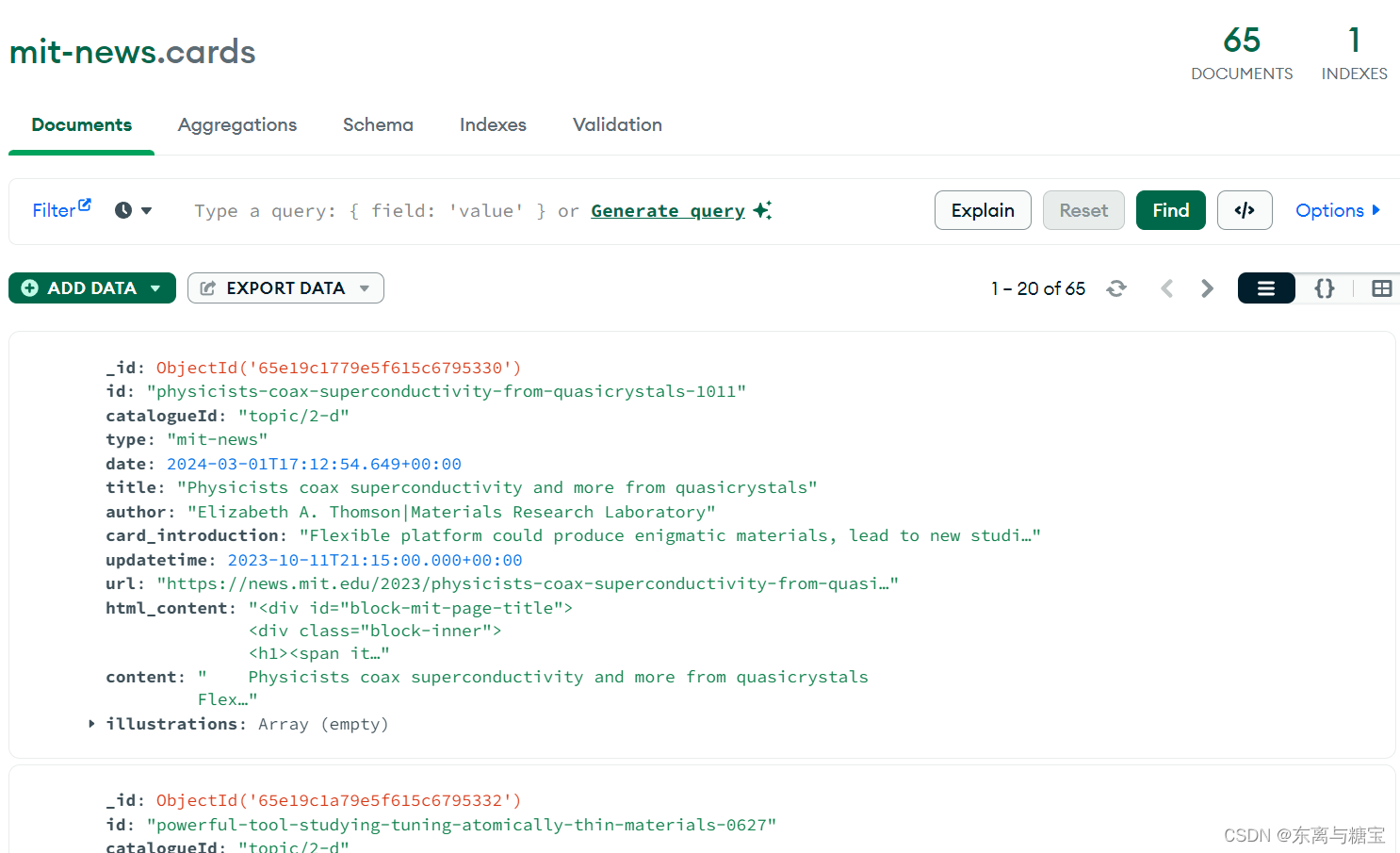

4. 解析文章列表和文章

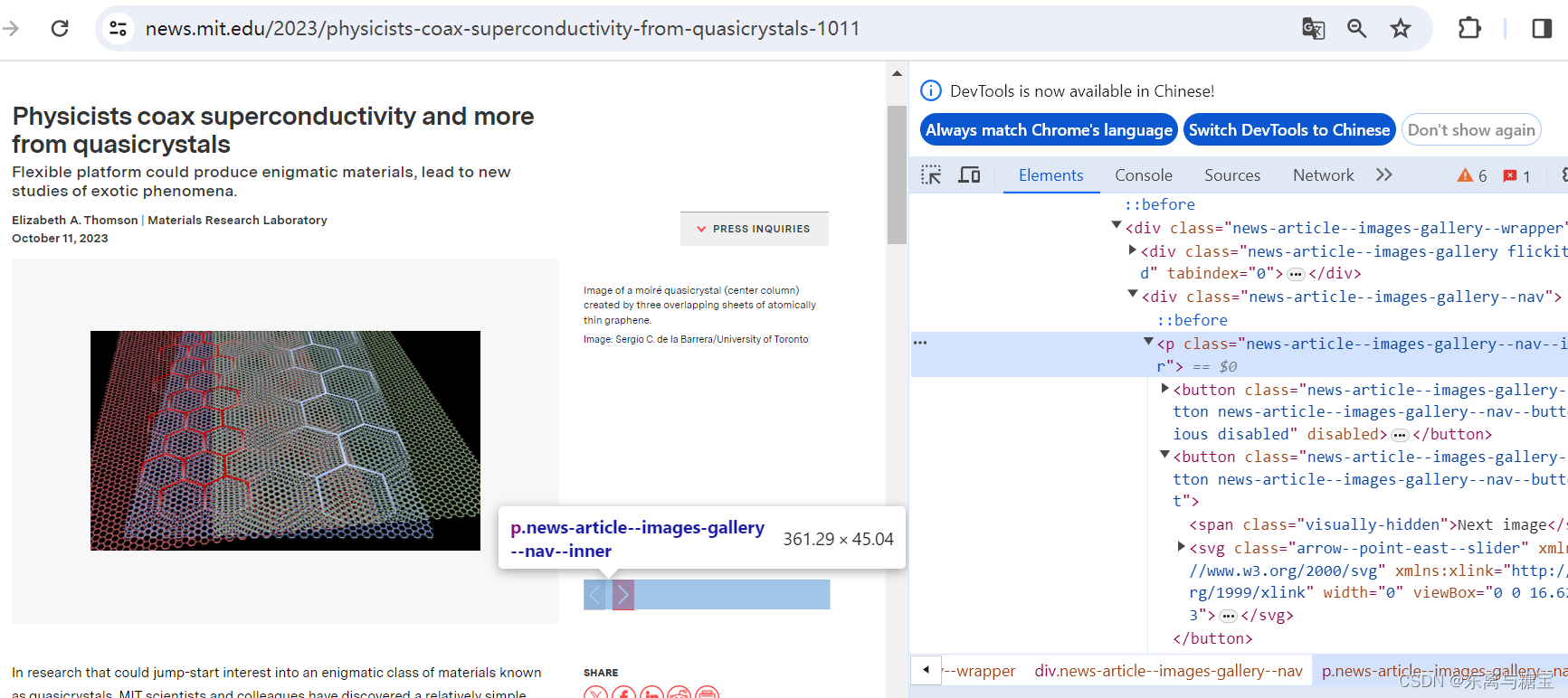

尋找冗余部分并刪除,例如

# 解析文章列表里的文章def parse_cards_list(self, page, url, catalogue_id):params = {'page': page}response = requests.get(url, params=params, headers=self.headers)if response.status_code == 200:soup = BeautifulSoup(response.text, 'html.parser')card_list = soup.find('div', 'page-term--views--list')cards_list = card_list.find_all('div', 'page-term--views--list-item')for index, card in enumerate(cards_list):# 對應的版面idcatalogue_id = catalogue_id# 操作時間date = datetime.now()# 文章標題card_title = card.find('a', 'term-page--news-article--item--title--link').find('span').get_text(strip=True)# 文章簡介card_introduction = card.find('p', 'term-page--news-article--item--dek').find('span').get_text(strip=True)# 文章更新時間publish_time = card.find('p', 'term-page--news-article--item--publication-date').find('time').get('datetime')updateTime = datetime.strptime(publish_time, '%Y-%m-%dT%H:%M:%SZ')# 文章地址temp_url = card.find('div', 'term-page--news-article--item--cover-image').find('a').get('href')url = 'https://news.mit.edu' + temp_url# 文章idpattern = r'(\w+(-\w+)*)-(\d+)'match = re.search(pattern, temp_url)card_id = str(match.group(0))card_response = requests.get(url, headers=self.headers)soup = BeautifulSoup(card_response.text, 'html.parser')# 原始htmldom結構html_title = soup.find('div', id='block-mit-page-title')html_content = soup.find('div', id='block-mit-content')# 合并標題和內容html_title.append(html_content)html_cut1 = soup.find('div', 'news-article--topics')html_cut2 = soup.find('div', 'news-article--archives')html_cut3 = soup.find('div', 'news-article--content--side-column')html_cut4 = soup.find('div', 'news-article--press-inquiries')html_cut5 = soup.find_all('div', 'visually-hidden')html_cut6 = soup.find('p', 'news-article--images-gallery--nav--inner')# 移除元素if html_cut1:html_cut1.extract()if html_cut2:html_cut2.extract()if html_cut3:html_cut3.extract()if html_cut4:html_cut4.extract()if html_cut5:for item in html_cut5:item.extract()if html_cut6:html_cut6.extract()# 獲取合并后的內容文本html_content = html_title# 文章作者author_list = html_content.find('div', 'news-article--authored-by').find_all('span')author = ''for item in author_list:author = author + item.get_text()# 增加保留html樣式的源文本origin_html = html_content.prettify() # String# 轉義網頁中的圖片標簽str_html = self.transcoding_tags(origin_html)# 再包裝成temp_soup = BeautifulSoup(str_html, 'html.parser')# 反轉譯文件中的插圖str_html = self.translate_tags(temp_soup.text)# 綁定更新內容content = self.clean_content(str_html)# 下載圖片imgs = []img_array = soup.find_all('div', 'news-article--image-item')for item in img_array:img_url = self.root_url + item.find('img').get('data-src')imgs.append(img_url)if len(imgs) != 0:# 下載圖片illustrations = self.download_images(imgs, card_id)# 連接 MongoDB 數據庫服務器client = MongoClient('mongodb://localhost:27017/')# 創建或選擇數據庫db = client['mit-news']# 創建或選擇集合cards_collection = db['cards']# 插入示例數據到 catalogues 集合card_data = {'id': card_id,'catalogueId': catalogue_id,'type': 'mit-news','date': date,'title': card_title,'author': author,'card_introduction': card_introduction,'updatetime': updateTime,'url': url,'html_content': str(html_content),'content': content,'illustrations': illustrations,}cards_collection.insert_one(card_data)return Trueelse:raise Exception(f"Failed to fetch page {page}. Status code: {response.status_code}")

5. 清洗文章

# 工具 轉義標簽def transcoding_tags(self, htmlstr):re_img = re.compile(r'\s*<(img.*?)>\s*', re.M)s = re_img.sub(r'\n @@##\1##@@ \n', htmlstr) # IMG 轉義return s# 工具 轉義標簽def translate_tags(self, htmlstr):re_img = re.compile(r'@@##(img.*?)##@@', re.M)s = re_img.sub(r'<\1>', htmlstr) # IMG 轉義return s# 清洗文章def clean_content(self, content):if content is not None:content = re.sub(r'\r', r'\n', content)content = re.sub(r'\n{2,}', '', content)content = re.sub(r' {6,}', '', content)content = re.sub(r' {3,}\n', '', content)content = re.sub(r'<img src="../../../image/zxbl.gif"/>', '', content)content = content.replace('<img border="0" src="****處理標記:[Article]時, 字段 [SnapUrl] 在數據源中沒有找到! ****"/> ', '')content = content.replace(''' <!--/enpcontent<INPUT type=checkbox value=0 name=titlecheckbox sourceid="<Source>SourcePh " style="display:none">''','') \.replace(' <!--enpcontent', '').replace('<TABLE>', '')content = content.replace('<P>', '').replace('<\P>', '').replace(' ', ' ')return content

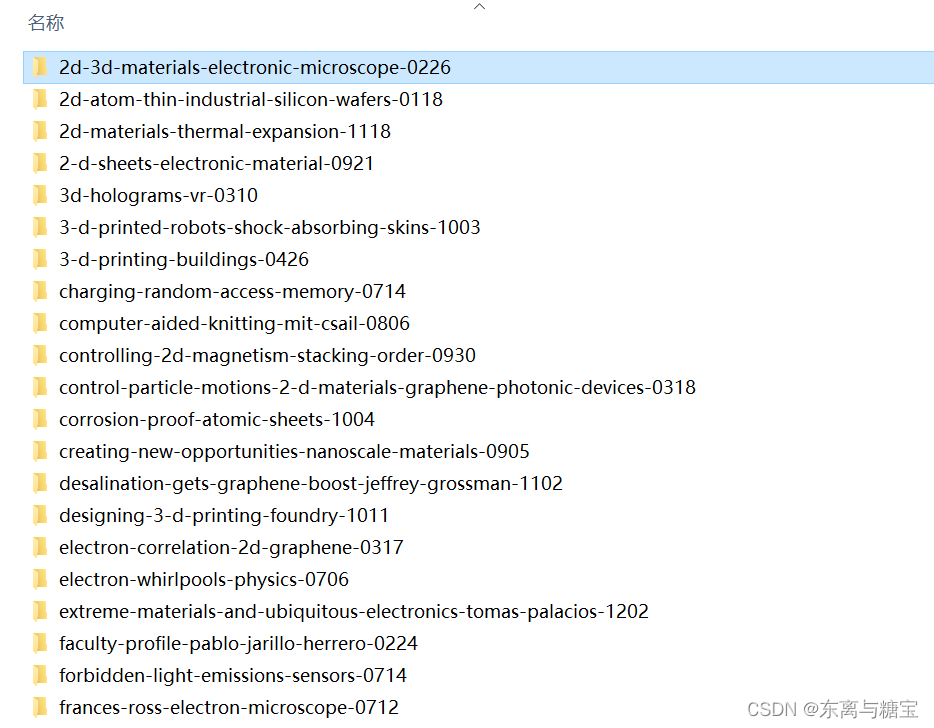

6. 保存文章圖片

# 下載圖片def download_images(self, img_urls, card_id):# 根據card_id創建一個新的子目錄images_dir = os.path.join(self.img_output_dir, card_id)if not os.path.exists(images_dir):os.makedirs(images_dir)downloaded_images = []for index, img_url in enumerate(img_urls):try:response = requests.get(img_url, stream=True, headers=self.headers)if response.status_code == 200:# 從URL中提取圖片文件名img_name_with_extension = img_url.split('/')[-1]pattern = r'^[^?]*'match = re.search(pattern, img_name_with_extension)img_name = match.group(0)# 保存圖片with open(os.path.join(images_dir, img_name), 'wb') as f:f.write(response.content)downloaded_images.append([img_url, os.path.join(images_dir, img_name)])except requests.exceptions.RequestException as e:print(f'請求圖片時發生錯誤:{e}')except Exception as e:print(f'保存圖片時發生錯誤:{e}')return downloaded_images# 如果文件夾存在則跳過else:print(f'文章id為{card_id}的圖片文件夾已經存在')return []

五、完整代碼

import os

from datetime import datetime

import requests

from bs4 import BeautifulSoup

from pymongo import MongoClient

import re

import mathclass MitnewsScraper:def __init__(self, root_url, model_url, img_output_dir):self.root_url = root_urlself.model_url = model_urlself.img_output_dir = img_output_dirself.headers = {'Referer': 'https://news.mit.edu/','User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) ''Chrome/122.0.0.0 Safari/537.36','Cookie': '_fbp=fb.1.1708485200443.423329752; _ga_HWFLFTST95=GS1.2.1708485227.1.0.1708485227.0.0.0; ''_hp2_id.2065608176=%7B%22userId%22%3A%228766180140632296%22%2C%22pageviewId%22%3A''%223284419326231258%22%2C%22sessionId%22%3A%228340313071591018%22%2C%22identity%22%3Anull%2C''%22trackerVersion%22%3A%224.0%22%7D; _ga_RP0185XJY9=GS1.1.1708485227.1.0.1708485301.0.0.0; ''_ga_PW4Z02MCFS=GS1.1.1709002375.3.0.1709002380.0.0.0; ''_ga_03E2REYYWV=GS1.1.1709002375.3.0.1709002380.0.0.0; _gid=GA1.2.2012514268.1709124148; ''_gat_UA-1592615-17=1; _gat_UA-1592615-30=1; ''_ga_342NG5FVLH=GS1.1.1709256315.12.1.1709259230.0.0.0; _ga=GA1.1.1063081174.1708479841; ''_ga_R8TSBG6RMB=GS1.2.1709256316.12.1.1709259230.0.0.0; ''_ga_5BGKP7GP4G=GS1.2.1709256316.12.1.1709259230.0.0.0',}# 獲取一個模塊有多少版面def catalogue_all_pages(self):response = requests.get(self.model_url, headers=self.headers)soup = BeautifulSoup(response.text, 'html.parser')try:match = re.search(r'of (\d+) topics', soup.text)total_catalogues = int(match.group(1))total_pages = math.ceil(total_catalogues / 20)print('topics模塊一共有' + match.group(1) + '個版面,' + str(total_pages) + '頁數據')for page in range(0, total_pages):self.parse_catalogues(page)print(f"========Finished catalogues page {page + 1}========")except:self.parse_catalogues(0)# 解析版面列表里的版面def parse_catalogues(self, page):params = {'page': page}response = requests.get(self.model_url, params=params, headers=self.headers)if response.status_code == 200:soup = BeautifulSoup(response.text, 'html.parser')if self.root_url == self.model_url:catalogue_list = soup.find('div','site-browse--recommended-section site-browse--recommended-section--schools')catalogues_list = catalogue_list.find_all('li')else:catalogue_list = soup.find('ul', 'page-vocabulary--views--list')catalogues_list = catalogue_list.find_all('li')for index, catalogue in enumerate(catalogues_list):# 操作時間date = datetime.now()# 版面標題catalogue_title = catalogue.find('a').get_text(strip=True)print('第' + str(index + 1) + '個版面標題為:' + catalogue_title)catalogue_href = catalogue.find('a').get('href')# 版面idcatalogue_id = catalogue_href[1:]catalogue_url = self.root_url + catalogue_hrefprint('第' + str(index + 1) + '個版面地址為:' + catalogue_url)# 根據版面url解析文章列表response = requests.get(catalogue_url, headers=self.headers)soup = BeautifulSoup(response.text, 'html.parser')match = re.search(r'of (\d+)', soup.text)# 查找一個版面有多少篇文章total_cards = int(match.group(1))total_pages = math.ceil(total_cards / 15)print(f'{catalogue_title}版面一共有{total_cards}篇文章,' + f'{total_pages}頁數據')for page in range(0, total_pages):self.parse_cards_list(page, catalogue_url, catalogue_id)print(f"========Finished {catalogue_title} 版面 page {page + 1}========")# 連接 MongoDB 數據庫服務器client = MongoClient('mongodb://localhost:27017/')# 創建或選擇數據庫db = client['mit-news']# 創建或選擇集合catalogues_collection = db['catalogues']# 插入示例數據到 catalogues 集合catalogue_data = {'id': catalogue_id,'date': date,'title': catalogue_title,'url': catalogue_url,'cardSize': total_cards}catalogues_collection.insert_one(catalogue_data)return Trueelse:raise Exception(f"Failed to fetch page {page}. Status code: {response.status_code}")# 解析文章列表里的文章def parse_cards_list(self, page, url, catalogue_id):params = {'page': page}response = requests.get(url, params=params, headers=self.headers)if response.status_code == 200:soup = BeautifulSoup(response.text, 'html.parser')card_list = soup.find('div', 'page-term--views--list')cards_list = card_list.find_all('div', 'page-term--views--list-item')for index, card in enumerate(cards_list):# 對應的版面idcatalogue_id = catalogue_id# 操作時間date = datetime.now()# 文章標題card_title = card.find('a', 'term-page--news-article--item--title--link').find('span').get_text(strip=True)# 文章簡介card_introduction = card.find('p', 'term-page--news-article--item--dek').find('span').get_text(strip=True)# 文章更新時間publish_time = card.find('p', 'term-page--news-article--item--publication-date').find('time').get('datetime')updateTime = datetime.strptime(publish_time, '%Y-%m-%dT%H:%M:%SZ')# 文章地址temp_url = card.find('div', 'term-page--news-article--item--cover-image').find('a').get('href')url = 'https://news.mit.edu' + temp_url# 文章idpattern = r'(\w+(-\w+)*)-(\d+)'match = re.search(pattern, temp_url)card_id = str(match.group(0))card_response = requests.get(url, headers=self.headers)soup = BeautifulSoup(card_response.text, 'html.parser')# 原始htmldom結構html_title = soup.find('div', id='block-mit-page-title')html_content = soup.find('div', id='block-mit-content')# 合并標題和內容html_title.append(html_content)html_cut1 = soup.find('div', 'news-article--topics')html_cut2 = soup.find('div', 'news-article--archives')html_cut3 = soup.find('div', 'news-article--content--side-column')html_cut4 = soup.find('div', 'news-article--press-inquiries')html_cut5 = soup.find_all('div', 'visually-hidden')html_cut6 = soup.find('p', 'news-article--images-gallery--nav--inner')# 移除元素if html_cut1:html_cut1.extract()if html_cut2:html_cut2.extract()if html_cut3:html_cut3.extract()if html_cut4:html_cut4.extract()if html_cut5:for item in html_cut5:item.extract()if html_cut6:html_cut6.extract()# 獲取合并后的內容文本html_content = html_title# 文章作者author_list = html_content.find('div', 'news-article--authored-by').find_all('span')author = ''for item in author_list:author = author + item.get_text()# 增加保留html樣式的源文本origin_html = html_content.prettify() # String# 轉義網頁中的圖片標簽str_html = self.transcoding_tags(origin_html)# 再包裝成temp_soup = BeautifulSoup(str_html, 'html.parser')# 反轉譯文件中的插圖str_html = self.translate_tags(temp_soup.text)# 綁定更新內容content = self.clean_content(str_html)# 下載圖片imgs = []img_array = soup.find_all('div', 'news-article--image-item')for item in img_array:img_url = self.root_url + item.find('img').get('data-src')imgs.append(img_url)if len(imgs) != 0:# 下載圖片illustrations = self.download_images(imgs, card_id)# 連接 MongoDB 數據庫服務器client = MongoClient('mongodb://localhost:27017/')# 創建或選擇數據庫db = client['mit-news']# 創建或選擇集合cards_collection = db['cards']# 插入示例數據到 catalogues 集合card_data = {'id': card_id,'catalogueId': catalogue_id,'type': 'mit-news','date': date,'title': card_title,'author': author,'card_introduction': card_introduction,'updatetime': updateTime,'url': url,'html_content': str(html_content),'content': content,'illustrations': illustrations,}cards_collection.insert_one(card_data)return Trueelse:raise Exception(f"Failed to fetch page {page}. Status code: {response.status_code}")# 下載圖片def download_images(self, img_urls, card_id):# 根據card_id創建一個新的子目錄images_dir = os.path.join(self.img_output_dir, card_id)if not os.path.exists(images_dir):os.makedirs(images_dir)downloaded_images = []for index, img_url in enumerate(img_urls):try:response = requests.get(img_url, stream=True, headers=self.headers)if response.status_code == 200:# 從URL中提取圖片文件名img_name_with_extension = img_url.split('/')[-1]pattern = r'^[^?]*'match = re.search(pattern, img_name_with_extension)img_name = match.group(0)# 保存圖片with open(os.path.join(images_dir, img_name), 'wb') as f:f.write(response.content)downloaded_images.append([img_url, os.path.join(images_dir, img_name)])except requests.exceptions.RequestException as e:print(f'請求圖片時發生錯誤:{e}')except Exception as e:print(f'保存圖片時發生錯誤:{e}')return downloaded_images# 如果文件夾存在則跳過else:print(f'文章id為{card_id}的圖片文件夾已經存在')return []# 工具 轉義標簽def transcoding_tags(self, htmlstr):re_img = re.compile(r'\s*<(img.*?)>\s*', re.M)s = re_img.sub(r'\n @@##\1##@@ \n', htmlstr) # IMG 轉義return s# 工具 轉義標簽def translate_tags(self, htmlstr):re_img = re.compile(r'@@##(img.*?)##@@', re.M)s = re_img.sub(r'<\1>', htmlstr) # IMG 轉義return s# 清洗文章def clean_content(self, content):if content is not None:content = re.sub(r'\r', r'\n', content)content = re.sub(r'\n{2,}', '', content)content = re.sub(r' {6,}', '', content)content = re.sub(r' {3,}\n', '', content)content = re.sub(r'<img src="../../../image/zxbl.gif"/>', '', content)content = content.replace('<img border="0" src="****處理標記:[Article]時, 字段 [SnapUrl] 在數據源中沒有找到! ****"/> ', '')content = content.replace(''' <!--/enpcontent<INPUT type=checkbox value=0 name=titlecheckbox sourceid="<Source>SourcePh " style="display:none">''','') \.replace(' <!--enpcontent', '').replace('<TABLE>', '')content = content.replace('<P>', '').replace('<\P>', '').replace(' ', ' ')return contentdef run():root_url = 'https://news.mit.edu/'model_urls = ['https://news.mit.edu/topic', 'https://news.mit.edu/clp','https://news.mit.edu/department', 'https://news.mit.edu/']output_dir = 'D:\imgs\mit-news'for model_url in model_urls:scraper = MitnewsScraper(root_url, model_url, output_dir)scraper.catalogue_all_pages()if __name__ == "__main__":run()六、效果展示

和 post() 方法—— W3school 詳解 簡單易懂(二十四))

)

)

)

:高級模擬算法)

- 12分庫分表)

CSS 概述)