前言

看看以前寫的文章,業余搞人工智能還是很早之前的事情了,之前為了高工資,一直想從事人工智能相關的工作都沒有實現。現在終于可以安靜地系統地學習一下了。也是一邊學習一邊寫博客記錄吧。

昨天Google發布了最新的開源模型Gemma,今天我就來簡單體驗一下

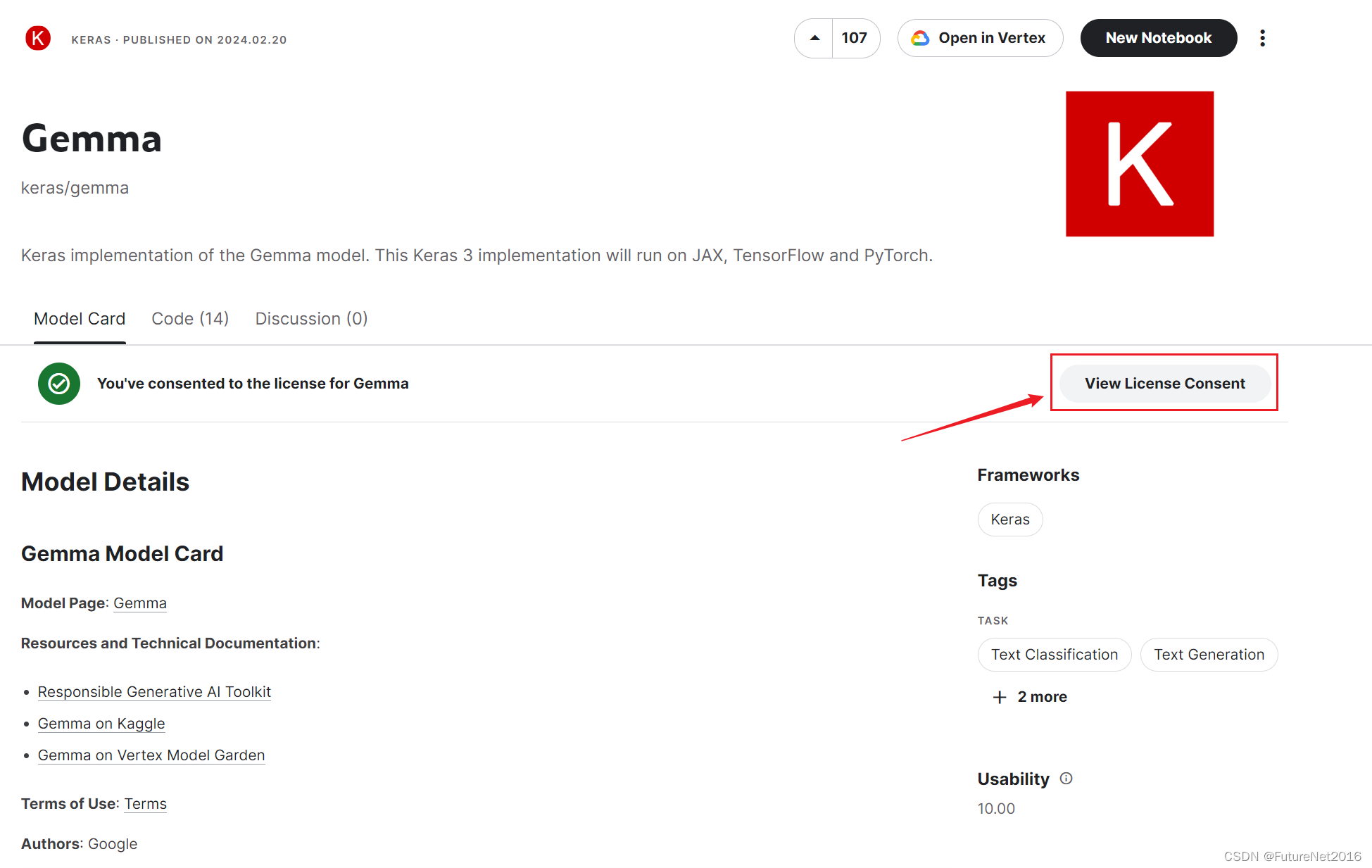

第一步 去Kaggle申請模型權限

https://www.kaggle.com/models/keras/gemma/

先用我的Google賬戶注冊登陸一下Kaggle,然后在點擊一下那個紅框里面的按鈕,填個申請表格,立馬就可以了,下面是我申請后的樣子

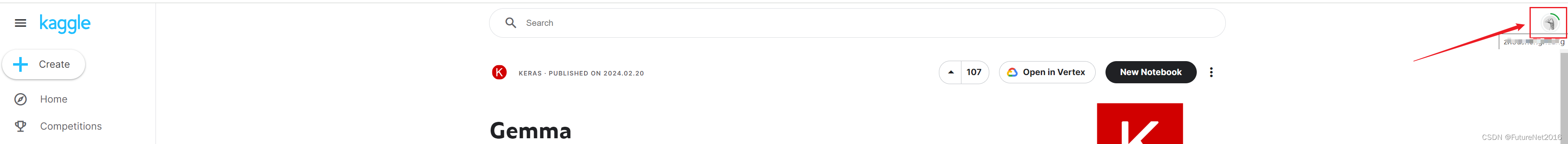

第二步 搞個Kaggle的API key 后面會用到

點擊頁面右上角的用戶頭像那里

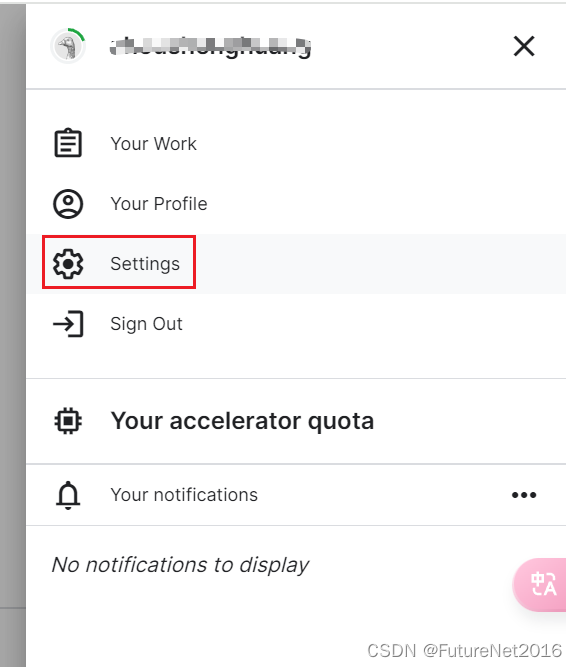

選擇Settings

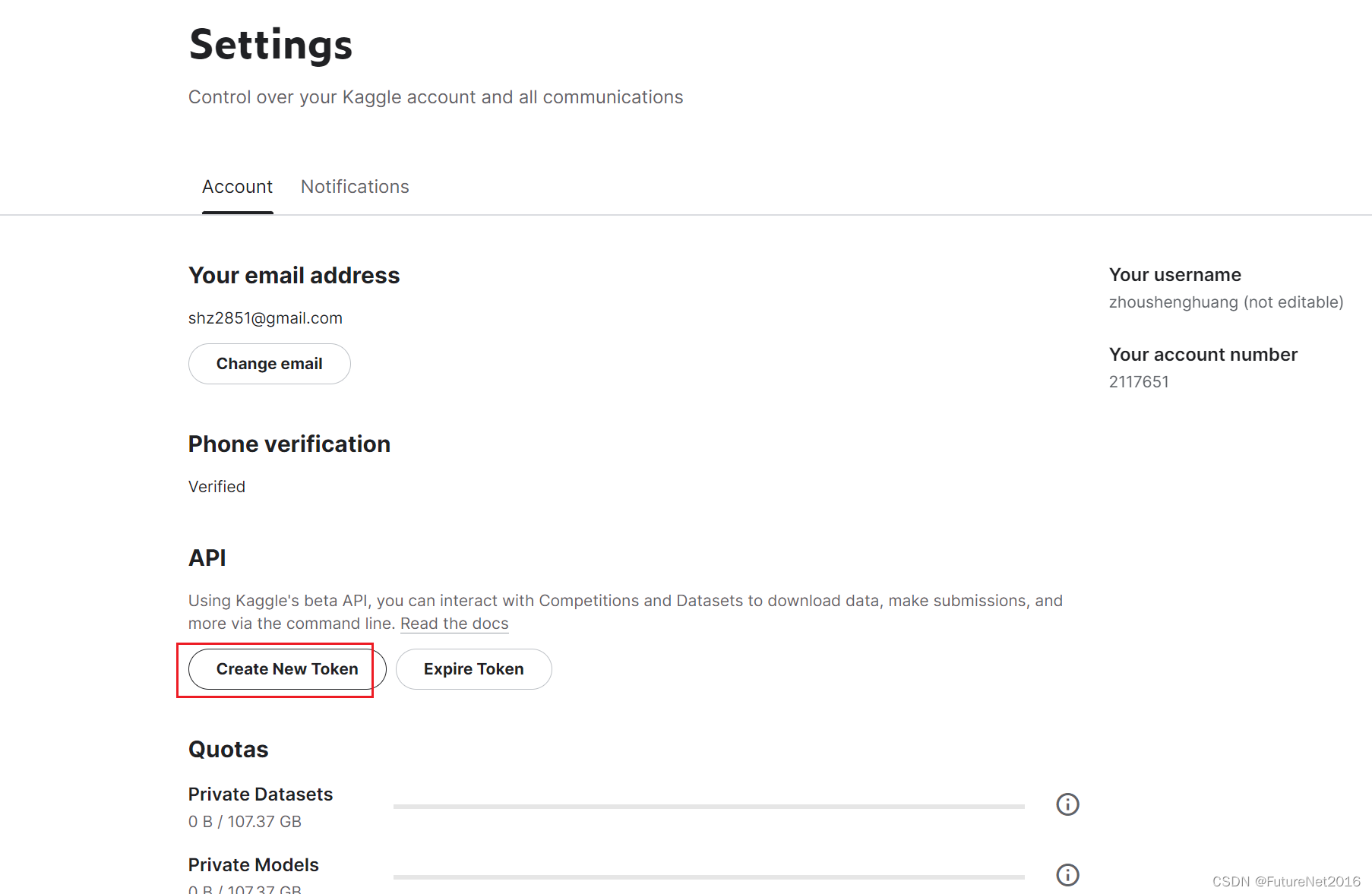

創建token

自動下載下來了

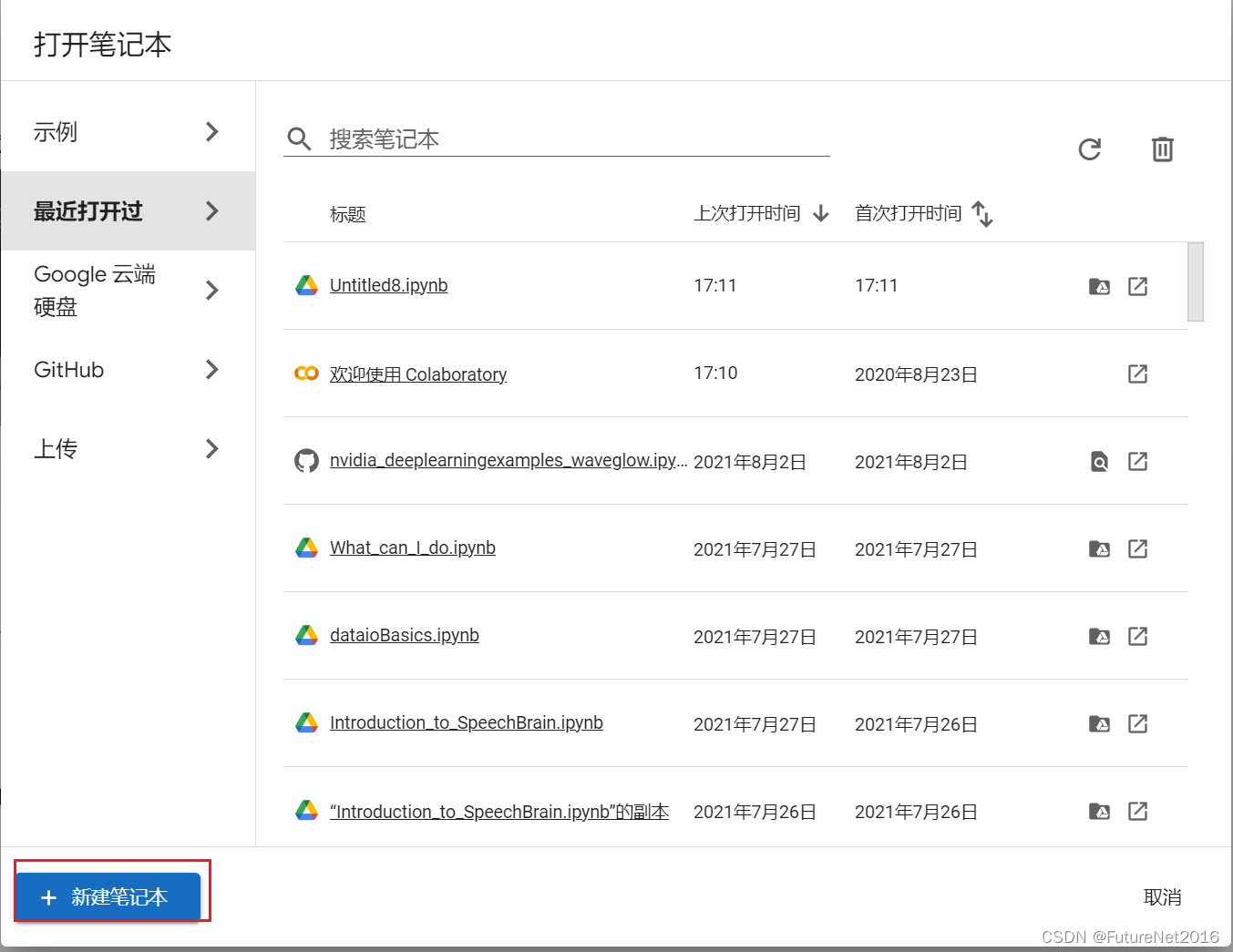

第三步,打開Google colab 運行模型

https://colab.research.google.com/

新建一個筆記

把剛才下載的Kaggle的apikey 填到colab中

填好之后,把開關打開一下

設置兩個:KAGGLE_USERNAME KAGGLE_KEY

設置一下運行時

改為T4 GPU

右上角連接資源后可以查看使用情況

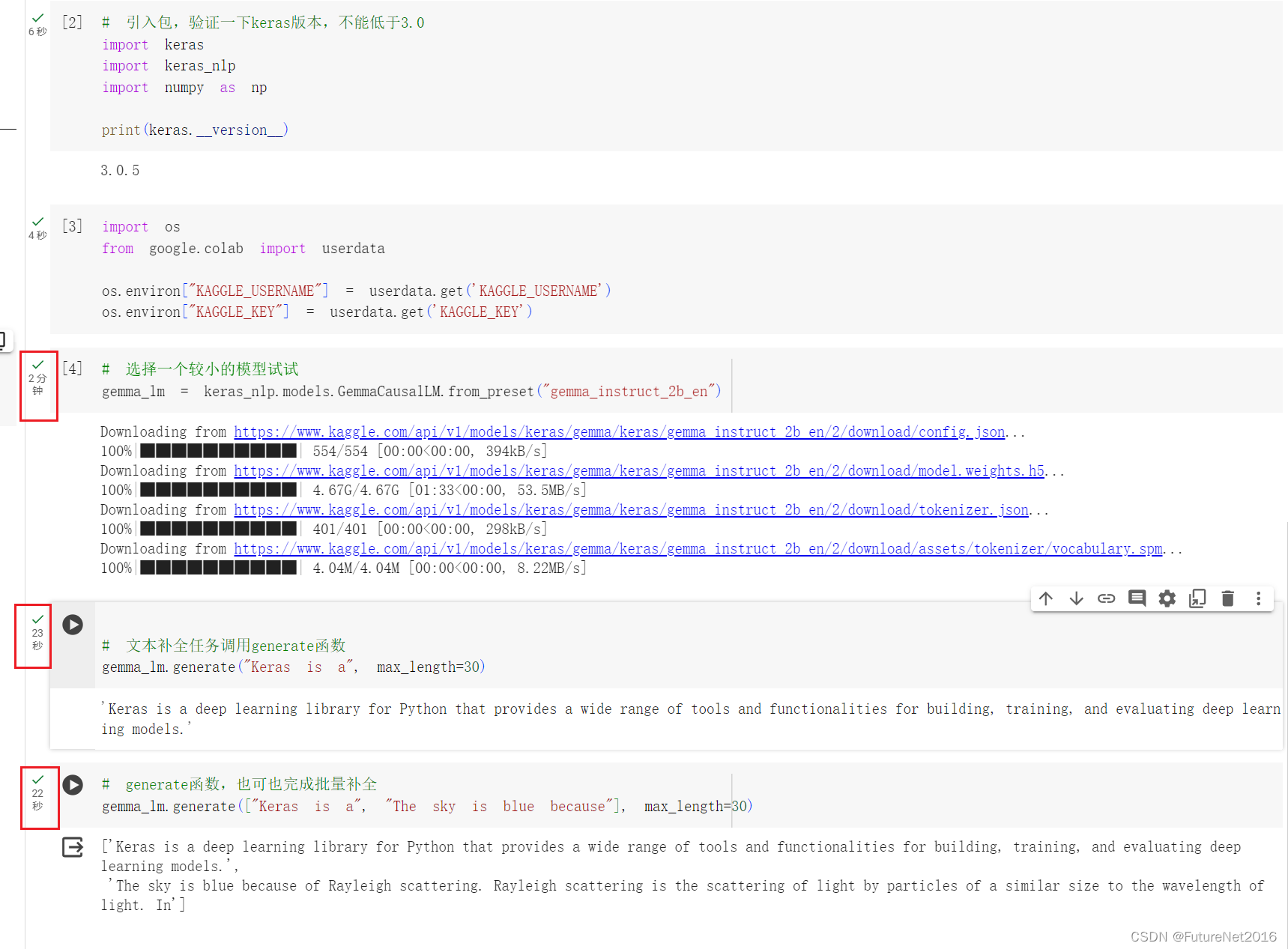

寫代碼:

# 先安裝一下keras

!pip install -U keras-nlp

!pip install -U keras# 引入包,驗證一下keras版本,不能低于3.0

import keras

import keras_nlp

import numpy as np

print(keras.__version__)#設置環境變量

import os

from google.colab import userdata

os.environ["KAGGLE_USERNAME"] = userdata.get('KAGGLE_USERNAME')

os.environ["KAGGLE_KEY"] = userdata.get('KAGGLE_KEY')# 選擇一個較小的模型試試

gemma_lm = keras_nlp.models.GemmaCausalLM.from_preset("gemma_instruct_2b_en")# 文本補全任務調用generate函數

gemma_lm.generate("Keras is a", max_length=30)# generate函數,也可也完成批量補全

gemma_lm.generate(["Keras is a", "The sky is blue because"], max_length=30)

執行結果:

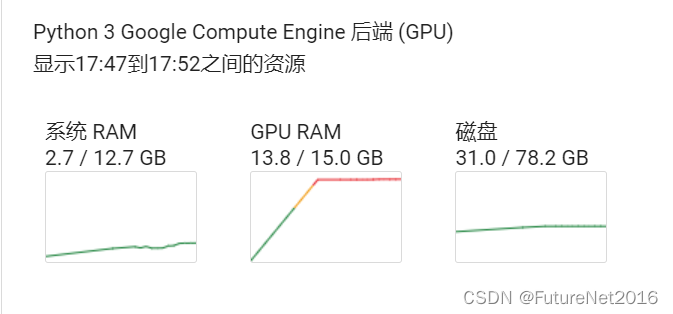

資源占用:

感覺好慢。。。

而且顯存占用太多了。。。

結果

后面再寫一篇本地部署運行的文章,看看效果怎么樣

我的電腦配置:

CPU: 12th Gen Intel? Core? i7-12700F 2.10 GHz

內存32G,顯卡RTX3060 12G

使用)

35)