上一章的內容 深度學習從入門到不想放棄-6 (qq.com)

今天講的也算基礎(這個系列后來我一尋思,全是基礎

),但是可能要著重說下,今天講前向計算和反向傳播,在哪兒它都永遠是核心,不管面對什么模型

前向計算:

有的叫也叫正向傳播,正向計算的,有的直接把前向的方法梯度下降當成前向計算的名字。熟悉我的讀者也了解,我一般不太care概念叫什么名,不重要,大家自己喜歡叫什么都行,只要理解是干啥的就行

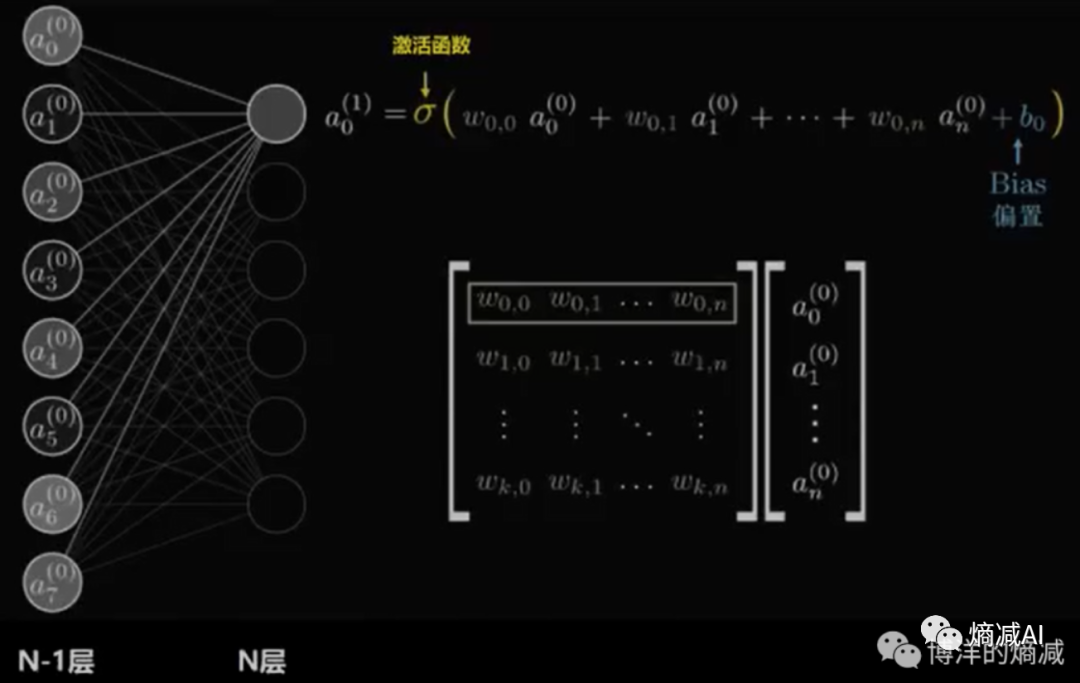

我們先看一張老圖(我用了10多遍了),神經網絡說白了,就是矩陣的乘法和加法,矩陣運算起來容易些

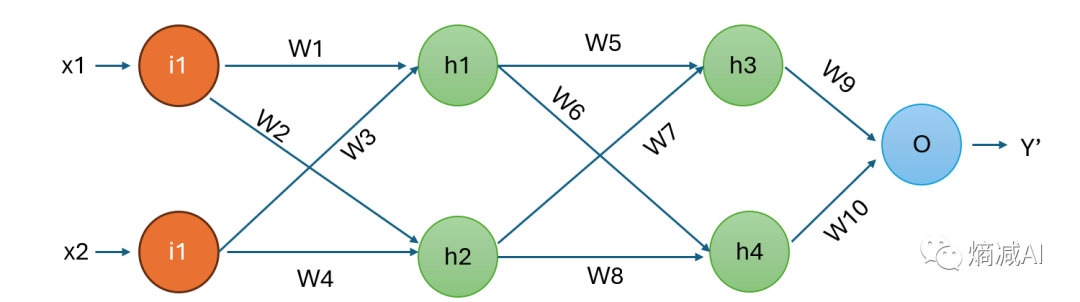

我們再把這個圖抽象成幾個神經元的網絡,如下圖

設我們的原始函數為Y=F(x)=wix1+wi'

)

)

)

)

)