前些天發現了一個巨牛的人工智能學習網站,通俗易懂,風趣幽默,忍不住分享一下給大家。點擊跳轉到教程。

一、Hadoop主要的任務部署分為3個部分,分別是:Client機器,主節點和從節點。主節點主要負責Hadoop兩個關鍵功能模塊HDFS、Map Reduce的監督。當Job Tracker使用Map Reduce進行監控和調度數據的并行處理時,名稱節點則負責HDFS監視和調度。從節點負責了機器運行的絕大部分,擔當所有數據儲存和指令計算的苦差。每個從節點既扮演者數據節點的角色又沖當與他們主節點通信的守護進程。守護進程隸屬于Job Tracker,數據節點在歸屬于名稱節點。

?

二、Hadoop核心和特點

?

Hadoop的核心就是HDFS和MapReduce,而兩者只是理論基礎,不是具體可使用的高級應用。

HDFS的設計特點是:

1、大數據文件,非常適合上T級別的大文件或者一堆大數據文件的存儲,如果文件只有幾個G甚至更小就沒啥意思了。

2、文件分塊存儲,HDFS會將一個完整的大文件平均分塊存儲到不同計算器上,它的意義在于讀取文件時可以同時從多個主機取不同區塊的文件,多主機讀取比單主機讀取效率要高得多得都。

3、流式數據訪問,一次寫入多次讀寫,這種模式跟傳統文件不同,它不支持動態改變文件內容,而是要求讓文件一次寫入就不做變化,要變化也只能在文件末添加內容。

4、廉價硬件,HDFS可以應用在普通PC機上,這種機制能夠讓給一些公司用幾十臺廉價的計算機就可以撐起一個大數據集群。

5、硬件故障,HDFS認為所有計算機都可能會出問題,為了防止某個主機失效讀取不到該主機的塊文件,它將同一個文件塊副本分配到其它某幾個主機上,如果其中一臺主機失效,可以迅速找另一塊副本取文件。

?

HDFS的關鍵元素:

1)Block:將一個文件進行分塊,通常是64M。

2)NameNode:保存整個文件系統的目錄信息、文件信息及分塊信息,這是由唯一 一臺主機專門保存,當然這臺主機如果出錯,NameNode就失效了。在 Hadoop2.* 開始支持 activity-standy 模式----如果主 NameNode 失效,啟動備用主機運行 NameNode。

3)DataNode:分布在廉價的計算機上,用于存儲Block塊文件。

?

MapReduce:

我們要數圖書館中的所有書。你數1號書架,我數2號書架。這就是“Map”。我們人越多,數書就更快。

現在我們到一起,把所有人的統計數加在一起。這就是“Reduce”。

通俗說MapReduce是一套從海量源數據提取分析元素最后返回結果集的編程模型,將文件分布式存儲到硬盤是第一步,而從海量數據中提取分析我們需要的內容就是MapReduce做的事了。

? ? ? ? MapReduce的基本原理就是:將大的數據分析分成小塊逐個分析,最后再將提取出來的數據匯總分析,最終獲得我們想要的內容。當然怎么分塊分析,怎么做Reduce操作非常復雜,Hadoop已經提供了數據分析的實現,我們只需要編寫簡單的需求命令即可達成我們想要的數據。

Hadoop典型應用有:搜索、日志處理、推薦系統、數據分析、視頻圖像分析、數據保存等。

?

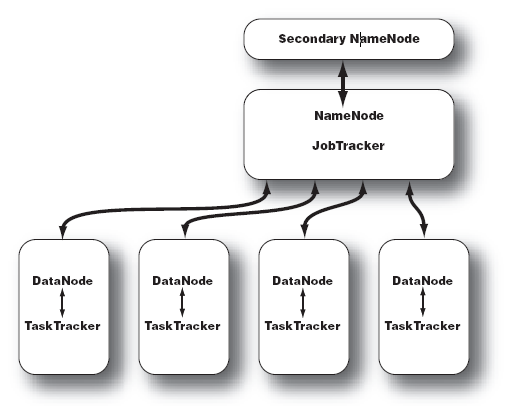

三、Hadoop的集群主要由 NameNode,DataNode,Secondary NameNode,JobTracker,TaskTracker組成。

如下圖所示:

1)NameNode:記錄了文件是如何被拆分成block以及這些block都存儲到了那些DateNode節點 .

2)NameNode:保存了文件系統運行的狀態信息 .

3)DataNode:存儲被拆分的blocks .

4)Secondary NameNode:幫助 NameNode 收集文件系統運行的狀態信息 .

5)JobTracker:當有任務提交到 Hadoop 集群的時候負責 Job 的運行,負責調度多個 TaskTracker .

6)TaskTracker:負責某一個 map 或者 reduce 任務 .

?

?

函數是什么意思)

)

)