文章目錄

- seata的部署和集成

- 一、部署Seata的tc-server

- 1.下載

- 2.解壓

- 3.修改配置

- 4.在nacos添加配置

- 5.創建數據庫表

- 6.啟動TC服務

- 二、微服務集成seata

- 1.引入依賴

- 2.修改配置文件

- TODO

- 三、TC服務的高可用和異地容災

- 1.模擬異地容災的TC集群

- 2.將事務組映射配置到nacos

- 3.微服務讀取nacos配置

seata的部署和集成

一、部署Seata的tc-server

1.下載

鏈接:https://pan.baidu.com/s/1MsbbF0rseNy74r7lLPbpwQ

提取碼:hzan

首先我們要下載seata-server包,地址在http😕/seata.io/zh-cn/blog/download.html

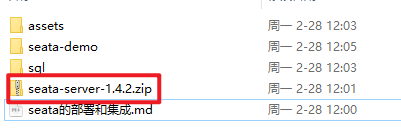

當然,課前資料也準備好了:

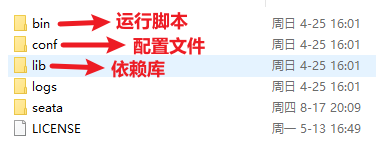

2.解壓

在非中文目錄解壓縮這個zip包,其目錄結構如下:

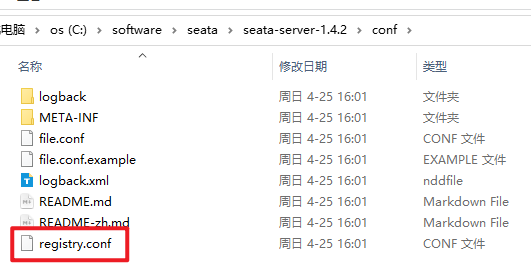

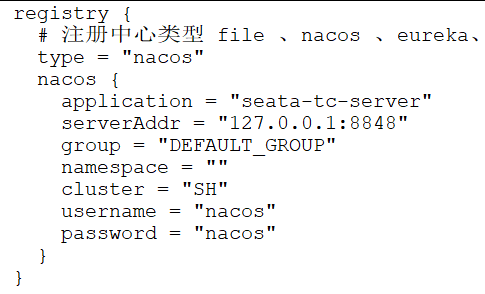

3.修改配置

修改conf目錄下的registry.conf文件:

內容如下:修改+大量刪除

registry {# tc服務的注冊中心類型,這里選擇nacos,也可以是eureka、zookeeper等type = "nacos"nacos {# seata tc 服務注冊到 nacos的服務名稱,可以自定義application = "seata-tc-server"serverAddr = "192.168.59.1:8848"group = "DEFAULT_GROUP"namespace = ""cluster = "SH"username = "nacos"password = "nacos"}

}config {# 讀取tc服務端的配置文件的方式,這里是從nacos配置中心讀取,這樣如果tc是集群,可以共享配置type = "nacos"# 配置nacos地址等信息nacos {serverAddr = "172.0.0.1:8848"namespace = ""group = "SEATA_GROUP"username = "nacos"password = "nacos"dataId = "seataServer.properties"}

}

注意:nacos地址默認127.0.0.1可以,都是本地IP,端口是8848沒錯就行

名稱換了下,中間加了一個-tc-待會兒nacos控制臺顯示的就是這個名稱

nacos組的名稱,直接到nacos控制臺查看

注冊中心是nacos,配置文件也給中心去管理,方便集群下的共享

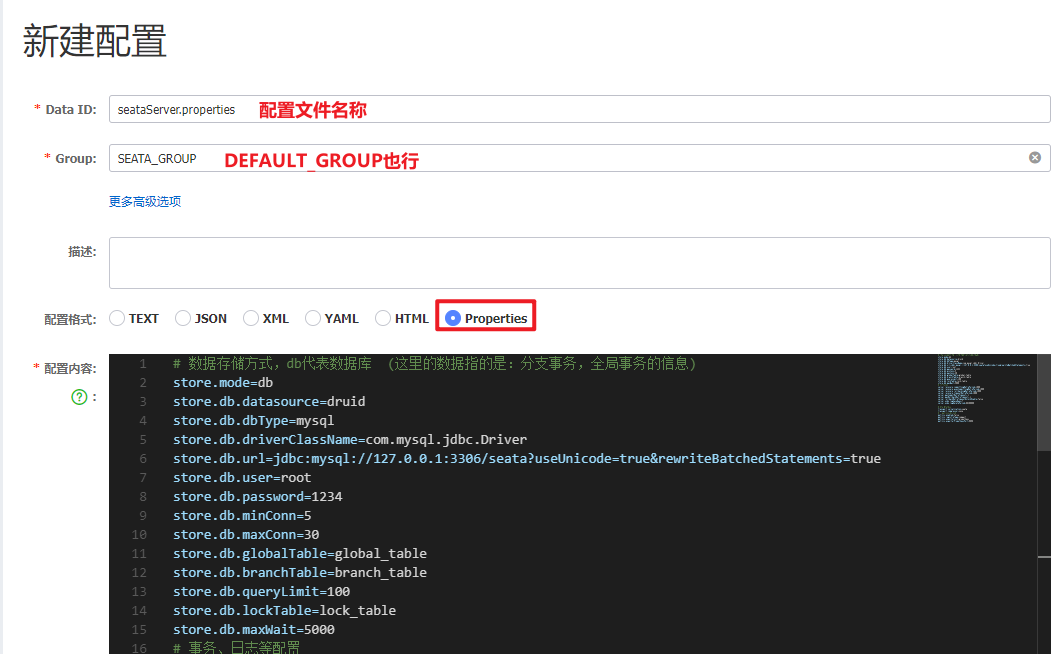

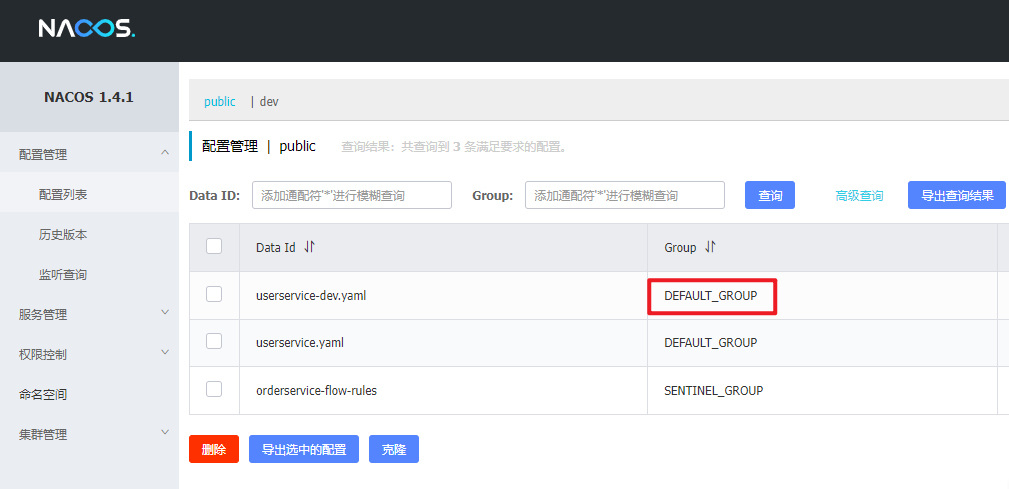

4.在nacos添加配置

特別注意,為了讓tc服務的集群可以共享配置,我們選擇了nacos作為統一配置中心。因此服務端配置文件seataServer.properties文件需要在nacos中配好。

dataId = “seataServer.properties” 上面配置文件配置的一個文件名稱

格式如下:

配置內容如下:

# 數據存儲方式,db代表數據庫 (這里的數據指的是:分支事務,全局事務的信息)

store.mode=db

store.db.datasource=druid

store.db.dbType=mysql

store.db.driverClassName=com.mysql.jdbc.Driver

store.db.url=jdbc:mysql://127.0.0.1:3306/seata?useUnicode=true&rewriteBatchedStatements=true

store.db.user=root

store.db.password=1234

store.db.minConn=5

store.db.maxConn=30

store.db.globalTable=global_table

store.db.branchTable=branch_table

store.db.queryLimit=100

store.db.lockTable=lock_table

store.db.maxWait=5000

# 事務、日志等配置

server.recovery.committingRetryPeriod=1000

server.recovery.asynCommittingRetryPeriod=1000

server.recovery.rollbackingRetryPeriod=1000

server.recovery.timeoutRetryPeriod=1000

server.maxCommitRetryTimeout=-1

server.maxRollbackRetryTimeout=-1

server.rollbackRetryTimeoutUnlockEnable=false

server.undo.logSaveDays=7

server.undo.logDeletePeriod=86400000# 客戶端與服務端傳輸方式

transport.serialization=seata

transport.compressor=none

# 關閉metrics功能,提高性能

metrics.enabled=false

metrics.registryType=compact

metrics.exporterList=prometheus

metrics.exporterPrometheusPort=9898

其中的數據庫地址、用戶名、密碼都需要修改成你自己的數據庫信息。

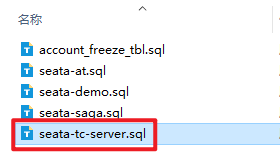

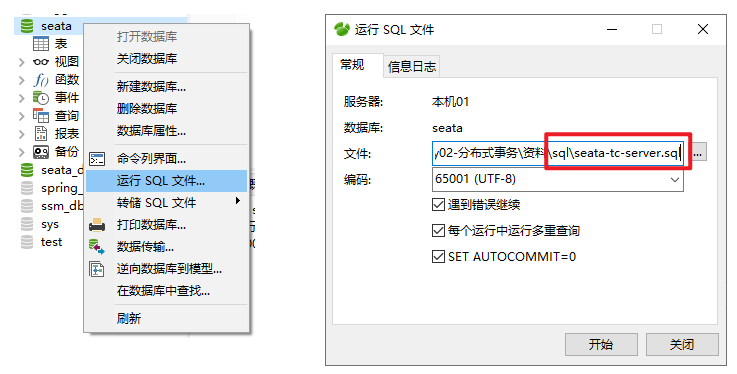

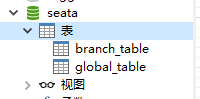

5.創建數據庫表

特別注意:tc服務在管理分布式事務時,需要記錄事務相關數據到數據庫中,你需要提前創建好這些表。

新建一個名為seata的數據庫,運行課前資料提供的sql文件:

上面nacos新增的配置項seataServer.properties,里面的數據庫地址,數據庫名稱就是 seata

先創建數據庫:

create database seata;

use seata;

再執行sql文件

這些表主要記錄全局事務、分支事務、全局鎖信息:

SET NAMES utf8mb4;

SET FOREIGN_KEY_CHECKS = 0;-- ----------------------------

-- 分支事務表

-- ----------------------------

DROP TABLE IF EXISTS `branch_table`;

CREATE TABLE `branch_table` (`branch_id` bigint(20) NOT NULL,`xid` varchar(128) CHARACTER SET utf8 COLLATE utf8_general_ci NOT NULL,`transaction_id` bigint(20) NULL DEFAULT NULL,`resource_group_id` varchar(32) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,`resource_id` varchar(256) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,`branch_type` varchar(8) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,`status` tinyint(4) NULL DEFAULT NULL,`client_id` varchar(64) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,`application_data` varchar(2000) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,`gmt_create` datetime(6) NULL DEFAULT NULL,`gmt_modified` datetime(6) NULL DEFAULT NULL,PRIMARY KEY (`branch_id`) USING BTREE,INDEX `idx_xid`(`xid`) USING BTREE

) ENGINE = InnoDB CHARACTER SET = utf8 COLLATE = utf8_general_ci ROW_FORMAT = Compact;-- ----------------------------

-- 全局事務表

-- ----------------------------

DROP TABLE IF EXISTS `global_table`;

CREATE TABLE `global_table` (`xid` varchar(128) CHARACTER SET utf8 COLLATE utf8_general_ci NOT NULL,`transaction_id` bigint(20) NULL DEFAULT NULL,`status` tinyint(4) NOT NULL,`application_id` varchar(32) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,`transaction_service_group` varchar(32) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,`transaction_name` varchar(128) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,`timeout` int(11) NULL DEFAULT NULL,`begin_time` bigint(20) NULL DEFAULT NULL,`application_data` varchar(2000) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,`gmt_create` datetime NULL DEFAULT NULL,`gmt_modified` datetime NULL DEFAULT NULL,PRIMARY KEY (`xid`) USING BTREE,INDEX `idx_gmt_modified_status`(`gmt_modified`, `status`) USING BTREE,INDEX `idx_transaction_id`(`transaction_id`) USING BTREE

) ENGINE = InnoDB CHARACTER SET = utf8 COLLATE = utf8_general_ci ROW_FORMAT = Compact;SET FOREIGN_KEY_CHECKS = 1;

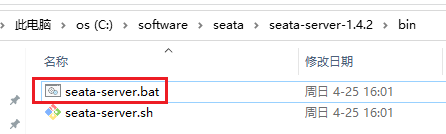

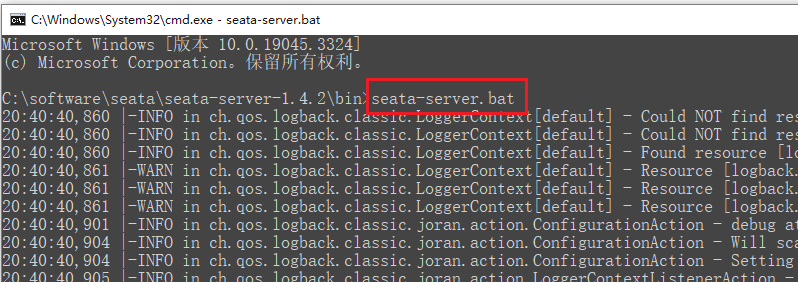

6.啟動TC服務

進入bin目錄,運行其中的seata-server.bat即可:

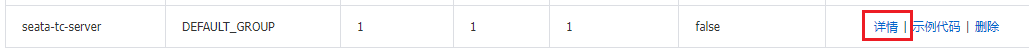

啟動成功后,seata-server應該已經注冊到nacos注冊中心了。

打開瀏覽器,訪問nacos地址:http://192.168.59.1:8848/nacos/index.html,然后進入服務列表頁面,可以看到seata-tc-server的信息:

啟動nacos的黑窗口有nacos控制臺地址

點擊詳情查看詳細信息:

二、微服務集成seata

注意:參與全局事務的每個微服務都要做下面這幾步

下面3個微服務都要做下面兩步

配置好了,各個微服務集成seata,將來各個微服務之間的分布式事務就有中心化機構,能夠自動管理了

1.引入依賴

首先,我們需要在微服務中引入seata依賴:

<dependency><groupId>com.alibaba.cloud</groupId><artifactId>spring-cloud-starter-alibaba-seata</artifactId><exclusions><!--版本較低,1.3.0,因此排除--><exclusion><artifactId>seata-spring-boot-starter</artifactId><groupId>io.seata</groupId></exclusion></exclusions>

</dependency>

<!--seata starter 采用1.4.2版本-->

<dependency><groupId>io.seata</groupId><artifactId>seata-spring-boot-starter</artifactId><version>${seata.version}</version>

</dependency>

${seata.version} 是父工程的pom.xml里配置的變量

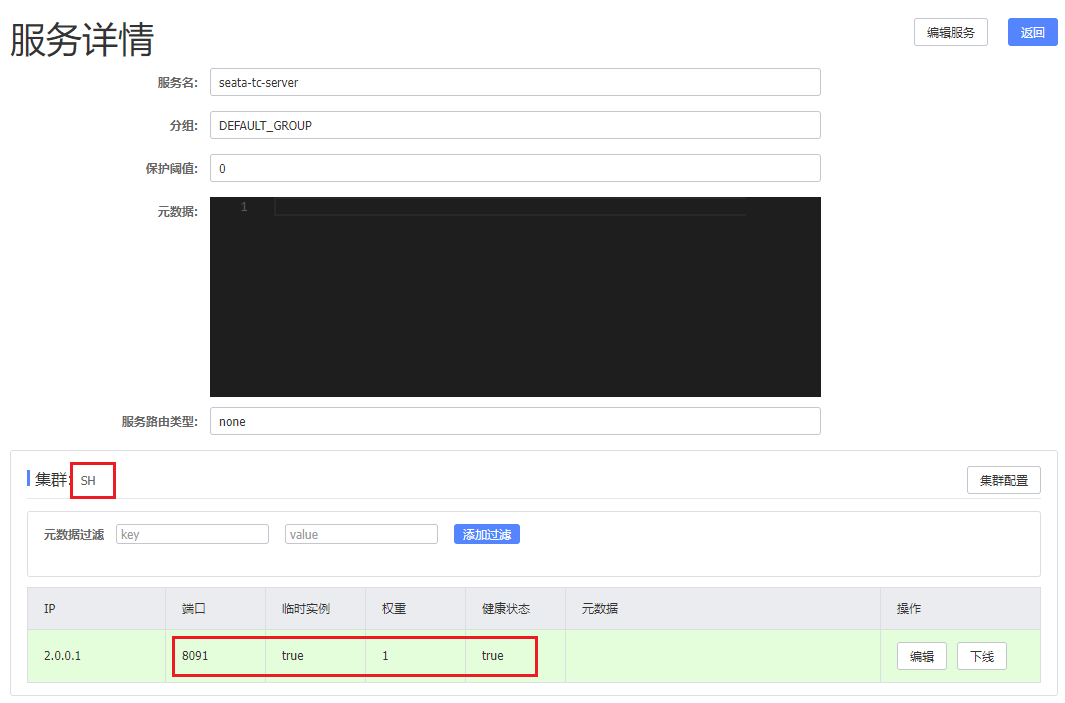

2.修改配置文件

需要修改application.yml文件,添加一些配置:

seata:registry: # TC服務注冊中心的配置,微服務根據這些信息去注冊中心獲取tc服務地址# 參考tc服務自己的registry.conf中的配置type: nacosnacos: # tcserver-addr: 127.0.0.1:8848 # 127.0.0.1就是localhostnamespace: ""group: DEFAULT_GROUPapplication: seata-tc-server # tc服務在nacos中的服務名稱cluster: SHtx-service-group: seata-demo # 事務組,根據這個獲取tc服務的cluster名稱service:vgroup-mapping: # 事務組與TC服務cluster的映射關系seata-demo: SH

配完后nacos配置了兩份,seata一份,springCloud一份,這是因為seata框架目前做得還不好,沒有做好和springCloud的集成關系,所以還得獨立再去配一次nacos

.

配置文件的配置除了集群名稱,cluster,其他完全按照TC的配置文件conf/registry.conf來配

TC已經作為一個獨立的軟件, 以微服務的形式注冊到nacos注冊中心去了

現在TM、RM需要和TC進行交流,也就是讓他們找到TC微服務就行了。(配置好,讓他們找到,后面就不需要我們操心了)

那么,要找到一個微服務,得同時知道這四個信息

仔細一看配置文件里都有

- namespace: “” 這里的空,就是默認配置public

- 這里集群的名稱配置也有點特別,因為有一個事務組的概念,后面詳細介紹,現在只需要知道訂單、商品、庫存3個微服務的3個分支事務都在一個事務組里被管理,即可。

(事務組和集群有個映射關系,所以集群名稱SH在事務組下面配置的)

- 四個配置圖示 (找到一個微服務必備的四個配置信息)

修改完成后重啟,若報錯

Error creating bean with name 'globalTransactionScanner' defined in class path resource [io/seata/spring/boot/autoconfigure/SeataAutoConfiguration.class]: Bean instantiation via factory method failed; nested

請切換到jdk8。不要用jdk17,很多類被棄用了

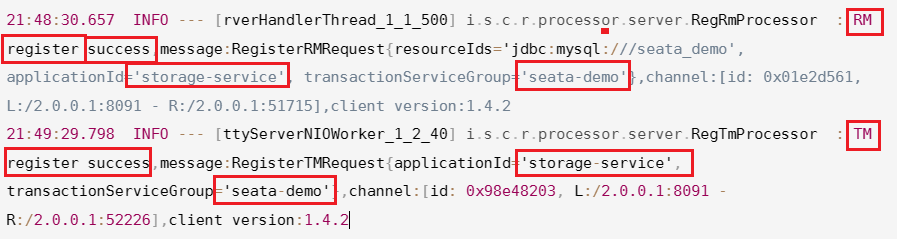

正常重啟后,seata黑窗口能看到服務的注冊信息,說明該微服務確實創建的RM和TM,并且確實都和TC中心連接上了

21:48:30.657 INFO --- [rverHandlerThread_1_1_500] i.s.c.r.processor.server.RegRmProcessor : RM register success,message:RegisterRMRequest{resourceIds='jdbc:mysql:///seata_demo', applicationId='storage-service', transactionServiceGroup='seata-demo'},channel:[id: 0x01e2d561, L:/2.0.0.1:8091 - R:/2.0.0.1:51715],client version:1.4.2

21:49:29.798 INFO --- [ttyServerNIOWorker_1_2_40] i.s.c.r.processor.server.RegTmProcessor : TM register success,message:RegisterTMRequest{applicationId='storage-service', transactionServiceGroup='seata-demo'},channel:[id: 0x98e48203, L:/2.0.0.1:8091 - R:/2.0.0.1:52226],client version:1.4.2

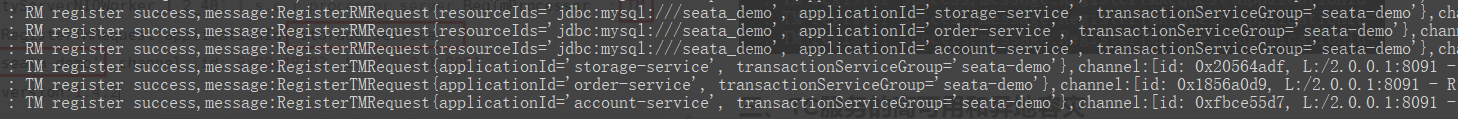

同時重啟3個微服務,會看到3個RM和3個TM的注冊信息,TM注冊比較慢,請耐心等待

TODO

三、TC服務的高可用和異地容災

1.模擬異地容災的TC集群

計劃啟動兩臺seata的tc服務節點:

| 節點名稱 | ip地址 | 端口號 | 集群名稱 |

|---|---|---|---|

| seata | 127.0.0.1 | 8091 | SH |

| seata2 | 127.0.0.1 | 8092 | HZ |

之前我們已經啟動了一臺seata服務,端口是8091,集群名為SH。

現在,將seata目錄復制一份,起名為seata2

修改seata2/conf/registry.conf內容如下:

registry {# tc服務的注冊中心類,這里選擇nacos,也可以是eureka、zookeeper等type = "nacos"nacos {# seata tc 服務注冊到 nacos的服務名稱,可以自定義application = "seata-tc-server"serverAddr = "127.0.0.1:8848"group = "DEFAULT_GROUP"namespace = ""cluster = "HZ"username = "nacos"password = "nacos"}

}config {# 讀取tc服務端的配置文件的方式,這里是從nacos配置中心讀取,這樣如果tc是集群,可以共享配置type = "nacos"# 配置nacos地址等信息nacos {serverAddr = "127.0.0.1:8848"namespace = ""group = "SEATA_GROUP"username = "nacos"password = "nacos"dataId = "seataServer.properties"}

}

進入seata2/bin目錄,然后運行命令:

seata-server.bat -p 8092

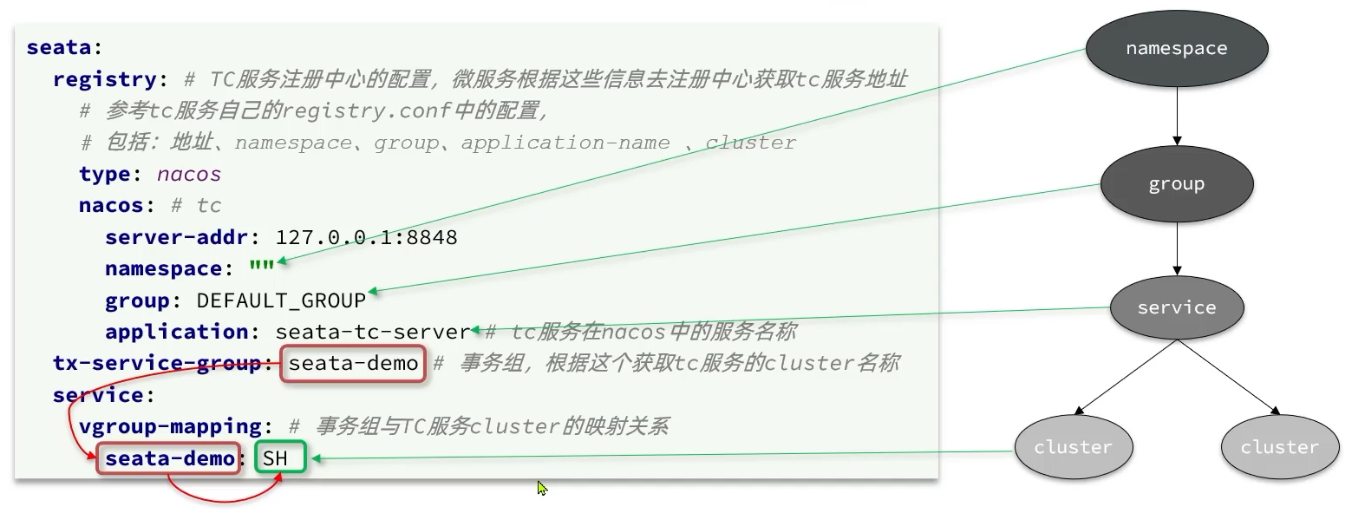

打開nacos控制臺,查看服務列表:

點進詳情查看:

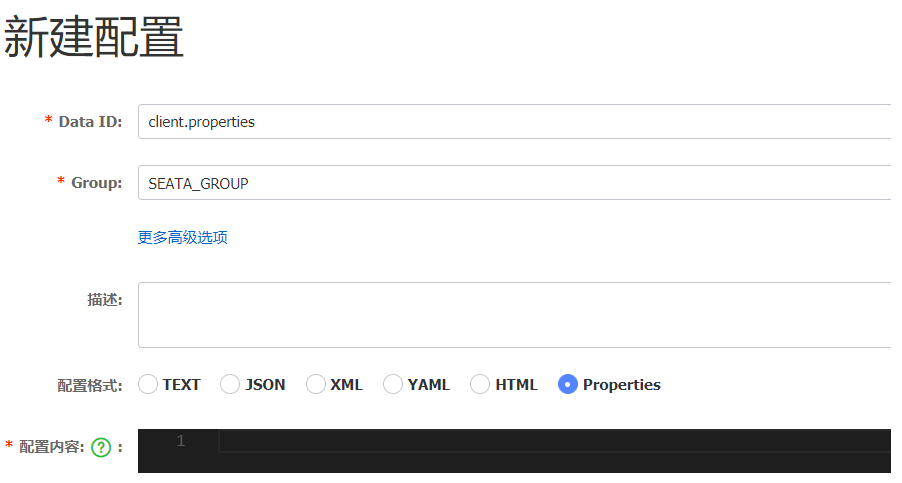

2.將事務組映射配置到nacos

接下來,我們需要將tx-service-group與cluster的映射關系都配置到nacos配置中心。

新建一個配置:

配置的內容如下:

# 事務組映射關系

service.vgroupMapping.seata-demo=SHservice.enableDegrade=false

service.disableGlobalTransaction=false

# 與TC服務的通信配置

transport.type=TCP

transport.server=NIO

transport.heartbeat=true

transport.enableClientBatchSendRequest=false

transport.threadFactory.bossThreadPrefix=NettyBoss

transport.threadFactory.workerThreadPrefix=NettyServerNIOWorker

transport.threadFactory.serverExecutorThreadPrefix=NettyServerBizHandler

transport.threadFactory.shareBossWorker=false

transport.threadFactory.clientSelectorThreadPrefix=NettyClientSelector

transport.threadFactory.clientSelectorThreadSize=1

transport.threadFactory.clientWorkerThreadPrefix=NettyClientWorkerThread

transport.threadFactory.bossThreadSize=1

transport.threadFactory.workerThreadSize=default

transport.shutdown.wait=3

# RM配置

client.rm.asyncCommitBufferLimit=10000

client.rm.lock.retryInterval=10

client.rm.lock.retryTimes=30

client.rm.lock.retryPolicyBranchRollbackOnConflict=true

client.rm.reportRetryCount=5

client.rm.tableMetaCheckEnable=false

client.rm.tableMetaCheckerInterval=60000

client.rm.sqlParserType=druid

client.rm.reportSuccessEnable=false

client.rm.sagaBranchRegisterEnable=false

# TM配置

client.tm.commitRetryCount=5

client.tm.rollbackRetryCount=5

client.tm.defaultGlobalTransactionTimeout=60000

client.tm.degradeCheck=false

client.tm.degradeCheckAllowTimes=10

client.tm.degradeCheckPeriod=2000# undo日志配置

client.undo.dataValidation=true

client.undo.logSerialization=jackson

client.undo.onlyCareUpdateColumns=true

client.undo.logTable=undo_log

client.undo.compress.enable=true

client.undo.compress.type=zip

client.undo.compress.threshold=64k

client.log.exceptionRate=100

3.微服務讀取nacos配置

接下來,需要修改每一個微服務的application.yml文件,讓微服務讀取nacos中的client.properties文件:

seata:config:type: nacosnacos:server-addr: 127.0.0.1:8848username: nacospassword: nacosgroup: SEATA_GROUPdata-id: client.properties

重啟微服務,現在微服務到底是連接tc的SH集群,還是tc的HZ集群,都統一由nacos的client.properties來決定了。

模板參數替換(Template argument substitution))

)