文章目錄

- Abstract

- 1.Introduction

- 2. Related Work

- 3. Our Method

- 3.1 Long- and Short-range Branches

- 3.2 SNR-based Spatially-varying Feature Fusion

- 3.3 SNR-guided Attention in Transformer

- 3.4 Loss Function

- 4. Experiments

- 4.1. Datasets and Implementation Details

- 4.2 Comparison with Current Methods

- 4.3 Ablation Study

- 4.4. Influence of SNR Prior

- 5. Conclusion

論文鏈接(CVPR2022):《SNR-Aware Low-light Image Enhancement》

源碼鏈接:https://github.com/dvlab-research/SNR-Aware-Low-Light-Enhance

Abstract

本文提出了一種新的弱光圖像增強解決方案,通過綜合利用Signal-to-Noise-Ratio-aware transformers和Convolution models,利用空間變化操作動態增強像素。

它們是對極低信噪比(SNR)圖像區域的long-range操作和對其他區域的short-range操作。

我們提出在引導特征融合之前先考慮信噪比,并利用一種新的自注意模型構建SNR-aware Transformer,以避免來自極低信噪比的噪聲圖像區域的token。

大量的實驗表明,在7個具有代表性的基準測試中,我們的框架始終比SOTA方法獲得更好的性能。此外,我們進行了一項大規模的用戶研究,有100名參與者來驗證我們的結果優越的感知質量。

1.Introduction

微光成像對于許多任務都是至關重要的,比如夜間的物體和動作識別[18,27]。弱光圖像通常可視性較差,不適合人類感知。同樣,當直接以弱光圖像作為輸入時,下游視覺任務也會受到影響。

目前已經提出了幾種增強弱光圖像的方法。如今,事實上的方法是學習操縱顏色、色調和對比度的神經網絡,以增強弱光圖像[12,15,41,56],而最近的一些作品考慮了圖像中的噪聲[29,48]。

本文的核心思想是:

在微光圖像中,不同的區域可以具有不同的亮度、噪聲、可見性等特征。亮度極低的區域會受到噪聲的嚴重破壞,而同一圖像中的其他區域仍然可以有合理的能見度和對比度。

為了更好的整體圖像增強,我們應該自適應地考慮弱光圖像中的不同區域。

因此,我們通過探索信噪比(signal-To-noise- ratio, SNR)[3, 54]來研究圖像空間中信噪比的關系,以實現空間變化增強。

1. 低信噪比的區域通常是不清楚的。因此,我們在更長的空間范圍內利用非局部圖像信息進行圖像增強。 (Long-range)

2. 信噪比較高的區域通常具有較高的能見度和較少的噪聲。因此,本地圖像信息通常就足夠了。(Short-Range)

下圖所示為弱光圖像舉例說明。

本文提出了對于在RGB空間下的弱光圖像增強解決方案 是同時利用long-range 和short-range的operation。

1. 具有Transfomer結構的long-range[38]捕獲非局部信息

2. 具有convolutional residual blocks[17]的short-range捕獲局部信息.

在增強每個像素時,我們根據像素的信噪比動態地確定局部(short-range)和非局部(long-range)信息的貢獻。

因此,在高信噪比區域,局部信息在增強過程中起著至關重要的作用,而在非常低信噪比區域,非局部信息是有效的。

為了實現這種空間變化的操作,我們構造了一個SNR prior,并利用它來指導特征融合。同時,我們修改了Transformer結構中的注意機制,提出了SNR-aware Transformer。

與現有的Transformer結構不同,并不是所有的token都有助于注意力計算。我們只考慮具有足夠信噪比的Token,以避免極低信噪比區域的噪聲影響。

我們的框架有效地增強了動態噪聲水平的微光圖像。在7個具有代表性的數據集上進行了廣泛的實驗:LOL (v1 [45], v2real [53], & v2-synthetic[53])、SID[5]、SMID[4]和SDSD(室內和室外)[39]。

如圖1所示,我們的框架在所有具有相同結構的數據集上都優于10種SOTA方法。此外,我們進行了大規模的用戶研究,有100名參與者來驗證我們的方法的有效性。定性比較如圖3所示。

總的來說,我們的貢獻有如下三點:

- 我們提出了一種新的信噪比感知框架,該框架利用SNR prior,并同時采用transformer structure和convolutional model來實現空間變化的弱光圖像增強。

- 我們設計了一種具有自注意模塊的SNR-aware transformer,用于弱光圖像增強。

- 我們在七個有代表性的數據集上進行了廣泛的實驗,表明我們的框架始終優于一組豐富的SOTA方法。

2. Related Work

- No-learning-based Low-light Image Enhancement

為了增強微光圖像,直方圖均衡化和伽瑪校正是擴展動態范圍和提高圖像對比度的基本工具。這些主要方法往往會在增強的真實圖像中產生不希望看到的偽影。基于retexx的方法,將反射分量視為圖像增強的似是而非的近似,能夠產生更真實和自然的結果[28,35]。然而,當增強復雜的真實圖像時,這一行方法經常會局部扭曲顏色[40]。 - Learning-based Low-light Image Enhancement

近年來提出了許多基于學習的微光圖像增強方法[2,14,20,22,29,31,42,48-50,52,53,59,60,62,63]。Wang et al.[40]提出了預測光照圖來增強曝光不足的照片。Sean等人設計了一種策略來學習三種不同類型的空間局部濾波器來增強。Yang等人提出了一種半監督方法來恢復微光圖像的線性帶表示。此外,還有非監督方法[7,14,19]。例如Guo等人[14]構建了一個輕量級網絡來估計像素級和高階曲線,用于動態范圍調整。

與之前的工作不同,我們的新方法基于一個信噪比感知框架,包括一個新的SNR-aware Transformer設計和一個卷積模型,以空間變化的方式自適應增強弱光圖像。如圖1所示,我們的框架在7個相同結構的不同基準上都取得了更好的性能。

3. Our Method

圖4顯示了我們框架的概述。輸入是一個弱光圖像,我們首先使用一個簡單而有效的策略獲得一個SNR map(詳細信息見第3.2節)。我們提出以SNR為指導,對不同signal-to-noise ratios的圖像區域自適應地學習不同的增強操作。

在我們框架的最深層隱藏層中,我們為long-range和short-range設計了兩個不同的分支。它們是專門為實現高效操作而制定的,分別由transformer[38]和卷積結構實現。為了實現長時間的工作,同時避免在極暗區域噪聲的影響,我們用一個SNR map來指導transformer的注意機制。為了采用不同的操作,我們提出了一種基于信噪比的融合策略,從long-range、short-range特征中獲得組合表示。此外,我們使用從編碼器到解碼器的skip connections來增強圖像細節。

3.1 Long- and Short-range Branches

- Necessity of spatial-varying operations

傳統的微光圖像增強網絡在最深的隱藏層采用卷積結構。這些操作大多是在short-range 獲取本地信息。局部信息可能足以恢復不是非常暗的圖像區域,因為這些像素仍然包含大量可見的圖像內容(或信號)。但是對于非常暗的區域,局部信息不足以增強像素,因為相鄰的局部區域的可見度也很弱,且大多是噪聲。

為了解決這一關鍵問題,我們利用不同的局部和非局部通信動態增強不同區域的像素。本地和非本地信息是互補的。這種效果可以根據圖像上的SNR分布來確定。一方面,對于高SNR的圖像區域,局部信息應該起主要作用,因為局部信息已經足夠增強了。它通常比long-range 非本地信息更準確。

另一方面,對于非常低信噪比的圖像區域,我們更多地關注非局部信息,因為局部區域在噪聲的主導下可能具有很少的圖像信息。與以往方法不同的是,在我們的框架中,我們明確地為非常低信噪比的圖像區域制定了一個long-range分支,為其他區域制定了一個short-range分支(見圖4)。

- Implementation of two branches

由于transformer 善于通過全局自注意機制捕獲long-range依賴關系,因此,基于transformer[38]結構實現了遠程分支。這在許多高水平任務[10,16,21,30,46,57,58]和低水平任務[6,44]中得到了證實。

在long-range 分支中,我們首先將feature map F F F (編碼器從輸入圖像 I ∈ R H × W × 3 I∈R^{H×W×3} I∈RH×W×3中提取)劃分為m個特征塊,即 F i ∈ R p × p × C F_i∈R^{p×p×C} Fi?∈Rp×p×C, I = 1 , … , m I ={1,…,m} I=1,…,m。假設feature map F F F 的大小為 h × w × C h × w × C h×w×C, patch的大小為 p × p p × p p×p,覆蓋整個feature map的feature patches有 m = h p × w p m = \frac{h}{p} × \frac{w}{p} m=ph?×pw?.

如圖4所示,我們的SNR-aware transformer是基于patch的。它由多頭自注意(MSA)模塊[38]和前饋網絡(FFN)[38]組成,兩者都由兩個全連接層組成。從transformer的output feature F 1 , . . . , F m F_1,...,F_m F1?,...,Fm? 具有相同大小的input feature。我們把 F 1 , . . . , F m F_1,...,F_m F1?,...,Fm? flatten 到1D的特征,并進行計算

y 0 = [ F 1 , F 2 , … , F m ] ,? q i = k i = v i = L N ( y i ? 1 ) ,? y ^ i = M S A ( q i , k i , v i ) + y i ? 1 ,? y i = F F N ( L N ( y ^ i ) ) + y ^ i , and? [ F 1 , F 2 , … , F m ] = y l , i = { 1 , … , l } ,? \begin{aligned}& y_0=\left[F_1, F_2, \ldots, F_m\right] \text {, } \\& q_i=k_i=v_i=L N\left(y_{i-1}\right) \text {, } \\& \widehat{y}_i=M S A\left(q_i, k_i, v_i\right)+y_{i-1} \text {, } \\& y_i=F F N\left(L N\left(\widehat{y}_i\right)\right)+\widehat{y}_i, \\& \text { and }\left[\mathcal{F}_1, \mathcal{F}_2, \ldots, \mathcal{F}_m\right]=y_l, i=\{1, \ldots, l\} \text {, } \\&\end{aligned} ?y0?=[F1?,F2?,…,Fm?],?qi?=ki?=vi?=LN(yi?1?),?y ?i?=MSA(qi?,ki?,vi?)+yi?1?,?yi?=FFN(LN(y ?i?))+y ?i?,?and?[F1?,F2?,…,Fm?]=yl?,i={1,…,l},??

式中, L N LN LN為 Layer normalization; y i y_i yi?表示第 i i i 個transformer block的輸出; M S A MSA MSA 表示 SNR-aware multi-head self-attention module (見圖5),將在第3.3節詳細介紹; Q i 、 k i 、 v i Q_i、k_i、v_i Qi?、ki?、vi?分別表示第 i i i 個多頭自我注意模塊中的查詢向量、鍵向量和值向量; l l l 表示transformer 的層數。Transformed feature F 1 , … , F m \mathcal{F}_1, \ldots, \mathcal{F}_m F1?,…,Fm? 可以合并形成2D feature map F l \mathcal{F}_l Fl?(見圖4)。

3.2 SNR-based Spatially-varying Feature Fusion

如圖4所示,我們利用編碼器 E \mathcal{E} E從輸入圖像 I I I中提取特征 F F F,然后將該特征分別由long-range 和short-range 分支進行處理,產生long-range特征 F l ∈ R h × w × C \mathcal{F}_l∈R^{h×w×C} Fl?∈Rh×w×C和short-range 特征 F s ∈ R h × w × C \mathcal{F}_s∈R^{h×w×C} Fs?∈Rh×w×C。為了自適應地結合這兩個特征,我們將信噪比映射的大小調整為 h × w h × w h×w,將其歸一化到 [0,1] 范圍內,并將歸一化后的信噪比映射 S ’ S’ S’作為插值權值,將 F l F_l Fl?和 F s Fs Fs融合為 :

F = F s × S ′ + F l × ( 1 ? S ′ ) \mathcal{F}=\mathcal{F}_s \times S^{\prime}+\mathcal{F}_l \times\left(1-S^{\prime}\right) F=Fs?×S′+Fl?×(1?S′)

其中 F ∈ R h × w × C F∈R^{h×w×C} F∈Rh×w×C是傳遞給解碼器以產生最終輸出圖像的輸出特征。由于SNR map 中的值動態地顯示了輸入圖像不同區域的噪聲水平,因此融合可以自適應地結合局部(近程)和非局部(長程)圖像信息產生 F \mathcal{F} F。

3.3 SNR-guided Attention in Transformer

- Limitation of traditional transformer structures

雖然傳統的transformer可以捕獲非局部信息來增強圖像,但它們也存在一些關鍵問題。在原始結構中,對所有的patch進行注意計算。為了增強一個像素,long-range 的注意力可能來自任何圖像區域,而不考慮信號和噪聲水平。事實上,非常低信噪比的區域是由噪聲主導的。因此,它們的信息是不準確的,嚴重干擾了圖像增強。在此,我們提出了SNR 引導下的transformer改進的注意事項。

- SNR-aware transformer

圖5顯示了我們的具有新的自注意模塊的SNR-aware Transformer。給定輸入圖像 I ∈ R H × W × 3 I∈R^{H×W×3} I∈RH×W×3,對應的SNR map S ∈ R H × W S∈R^{H×W} S∈RH×W,我們先調整S的大小為 S ’ ∈ R h × w S’∈R^{h×w} S’∈Rh×w來匹配 feature map F F F 的大小,然后按照 F F F劃分patch的方法將 S ’ S’ S’ 劃分為 m m m 個patch,并計算每個patch的平均值,即 S i ∈ R 1 , I = { 1 , … , m } S_i∈R^1, I =\{1,…,m\} Si?∈R1,I={1,…,m}。我們把這些值打包成向量 S ∈ R m S∈R^m S∈Rm。它在transformer的注意力計算中起到了掩模的作用,可以避免transformer中極低信噪比的圖像區域(見圖5)的信息傳播。S的第 i i i個元素的掩碼值表示為 :

S i = { 0 , S i < s 1 , S i ≥ s , i = { 1 , … , m } , \mathcal{S}_i=\left\{\begin{array}{ll}0, & S_i<s \\1, & S_i \geq s\end{array}, i=\{1, \ldots, m\},\right. Si?={0,1,?Si?<sSi?≥s?,i={1,…,m},

其中 s s s為閾值。接下來,我們將 S \mathcal{S} S的m個副本堆疊,形成矩陣 S ’ ∈ R m × m S’∈R^{m×m} S’∈Rm×m。設multi-head self-attention (MSA)模塊(式(1))的head數為 B B B,則Transformer第 i i i 層第b個head 的self-attention A t t e n t i o n i , b Attention_{i,b} Attentioni,b?為 :

Q i , b = q i W b q , K i , b = k i W b k , V i , b = v i W b v , and? Attention? i , b ( Q i , b , K i , b , V i , b ) = Softmax ? ( Q i , b K i , b T d b + ( 1 ? S ′ ) σ ) V i , b \begin{gathered}\mathbf{Q}_{i, b}=q_i W_b^q, \mathbf{K}_{i, b}=k_i W_b^k, \mathbf{V}_{i, b}=v_i W_b^v, \quad \text { and } \\\text { Attention }_{i, b}\left(\mathbf{Q}_{i, b}, \mathbf{K}_{i, b}, \mathbf{V}_{i, b}\right)=\operatorname{Softmax}\left(\frac{\mathbf{Q}_{i, b} \mathbf{K}_{i, b}^T}{\sqrt{d_b}}+\left(1-\mathcal{S}^{\prime}\right) \sigma\right) \mathbf{V}_{i, b}\end{gathered} Qi,b?=qi?Wbq?,Ki,b?=ki?Wbk?,Vi,b?=vi?Wbv?,?and??Attention?i,b?(Qi,b?,Ki,b?,Vi,b?)=Softmax(db??Qi,b?Ki,bT??+(1?S′)σ)Vi,b??

其中 q i , k i , v i ∈ R m × ( p × p × C ) q_i, k_i, v_i \in \mathbb{R}^{m \times(p \times p \times C)} qi?,ki?,vi?∈Rm×(p×p×C) 是式(1)中輸入的2D feature, W k q , W k k , W k v ∈ R ( p × p × C ) × C k W_k^q, W_k^k, W_k^v \in \mathbb{R}^{(p \times p \times C) \times C_k} Wkq?,Wkk?,Wkv?∈R(p×p×C)×Ck? 表示的是第k個head的投影矩陣。 Q i , b , K i , b , V i , b ∈ R m × C k Q_{i,b}, K_{i,b}, V_{i,b} \in \mathbb{R}^{m\times C_k} Qi,b?,Ki,b?,Vi,b?∈Rm×Ck? 分別是在attention 計算中的query, key, value features。

S o f t m a x ( ) Softmax() Softmax() 和 A t t e n t i o n i , b ( ) Attention_{i,b}() Attentioni,b?() 的輸出形狀分別是 m × m m\times m m×m 和 m × C k m \times C_k m×Ck?, 其中 C k C_k Ck? 是self-attention 計算中的通道數量。 d k \sqrt {d_k} dk?? 是為了歸一化,σ是一個小的負標量?1e9。 B個head的輸出都被連接到了一起,所有的值都被線性地投影在transformer的第 i i i層產生MSA的最終輸出。因此,我們保證了long-range的attention來自于具有充足SNR 的圖像區域。

3.4 Loss Function

- Data FLow

給定輸入圖像 I I I,我們首先應用一個具有卷積層的Encoder來提取特征 F F F。編碼器的每個階段包含一個卷積層和LeakyReLU[47]的堆棧。剩余卷積塊在編碼器之后使用。然后將 F F F轉發到long-range 和short-range 分支中,生成特征 F l F_l Fl?和 F s F_s Fs?。最后,我們將 F l F_l Fl?和 F S F_S FS?融合為 F F F,并使用譯碼器(與編碼器對稱)將 F F F轉換為殘差 R R R。最終輸出圖像 I ′ = I + R I ' = I +R I′=I+R

- Loss Terms

有兩個重構損失術語來訓練我們的框架,即Charbonnier loss[25]和Percepture loss。Charbonnier loss寫成 :

L r = ∥ I ′ ? I ^ ∥ 2 + ? 2 L_r=\sqrt{\left\|I^{\prime}-\widehat{I}\right\|_2+\epsilon^2} Lr?= ?I′?I ?2?+?2?

其中, I ^ \hat I I^為ground truth, ? \epsilon ? 在所有實驗中均取 1 0 ? 3 10^{?3} 10?3。Percepture loss使用L1損失來比較 I ^ \hat I I^ 和 I ‘ I‘ I‘之間的VGG特征距離。

L v g g = ∥ Φ ( I ′ ) ? Φ ( I ^ ) ∥ 1 L_{v g g}=\left\|\Phi\left(I^{\prime}\right)-\Phi(\widehat{I})\right\|_1 Lvgg?= ?Φ(I′)?Φ(I ) ?1?

其中 Φ ( ) Φ() Φ() 是從VGG網絡[37]中提取特征的操作。總的損失函數為 :

L = L r + λ L v g g L=L_r+\lambda L_{v g g} L=Lr?+λLvgg?

λ是一個超參數。

4. Experiments

4.1. Datasets and Implementation Details

我們在幾個數據集(具有可觀測噪音的微光區域)評估了我們的框架。它們是LOL (v1 & v2) [45, 53], SID [5], SMID[4]和SDSD[39]。

- LOL

LOL在v1和v2版本中都有明顯的噪音。

LOL-v1[45]包含485對low/normal-light 圖像用于訓練,15對用于測試。每一對包括一個弱光輸入圖像和一個相關的適定參考圖像。

LOL -v2[53]分為LOLv2-real和LOLv2 -synthetic。

LOLv2- v2-real包含689對低/正常光圖像對用于訓練,100對用于測試。在固定其他相機參數的情況下,通過改變曝光時間和ISO來收集大多數弱光圖像。

LOL -v2-synthetic是通過分析RAW格式中的光照分布而生成的。

- SID/SMID

對于SID和SMID,每個輸入樣本都是一對短曝光和長曝光圖像。SID和SMID都有較大的噪聲,這是因為它們是在極端黑暗的環境下拍攝的弱光圖像。

對于SID,我們使用Sony攝像機捕獲的子集,并遵循SID提供的腳本,使用rawpy的默認ISP將弱光圖像從RAW轉換為RGB。

對于SMID,我們使用它的完整圖像,也將RAWdata傳輸到RGB,因為我們的工作是在RGB域探索微光圖像增強。我們按照[4]的訓練和測試劃分。 - SDSD

最后,我們采用SDSD數據集39進行評估。它包含一個室內子集和一個室外子集,都提供低光和正常光對。

我們在PyTorch[34]中實現了我們的框架,并在帶有2080Ti GPU的PC上對其進行訓練和測試。

我們用高斯分布隨機初始化的網絡參數從頭開始訓練我們的方法,并采用標準的增廣方法,例如垂直和水平翻轉。

我們框架的編碼器有三個卷積層(即strides 1,2,2),編碼器后有一個殘差塊。解碼器與編碼器對稱,使用ChannelShuffle[36]實現上采樣機制。為了最小化損失,我們采用了Adam[23]優化器,動量設置為0.9。

4.2 Comparison with Current Methods

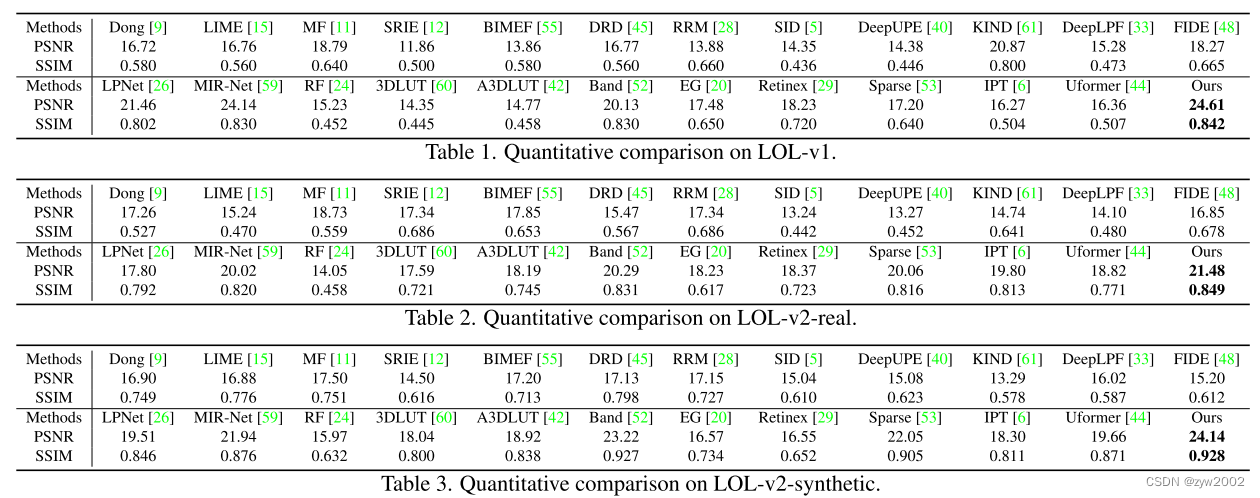

我們將我們的方法與SOTA方法中豐富的微光圖像增強方法進行了比較,包括Dong[9]、LIME[15]、MF[11]、SRIE[12]、BIMEF[55]、DRD[45]、RRM[28]、SID[5]、DeepUPE[40]、KIND[61]、DeepLPF[33]、FIDE[48]、LPNet[26]、MIR-Net[59]、RF[24]、3DLUT[60]、A3DLUT[42]、Band[52]、EG[20]、Retinex[29]和Sparse[53]。此外,我們還將我們的框架與兩種最新的用于低級任務的Transformer結構(IPT[6]和Uformer[44])進行了比較。

-

Quantitative analysis

我們采用峰值信噪比(PSNR)和結構相似度指數(SSIM)[43]進行評價。一般來說,更高的SSIM意味著結果中更高頻的細節和結構。表1-3顯示了LOL -v1、LOL -v2-real和LOL -v2synthetic的比較。我們的方法超越了所有的基線。

請注意,我們從各自的論文或運行各自的公共代碼中獲得這些數字。我們的方法(24.61/0.842)在LOL-v1上也優于22和62。表4對SID、SMID、SDSD-indoor和SDSD-outdoor的方法進行了比較。我們的算法性能最好。

-

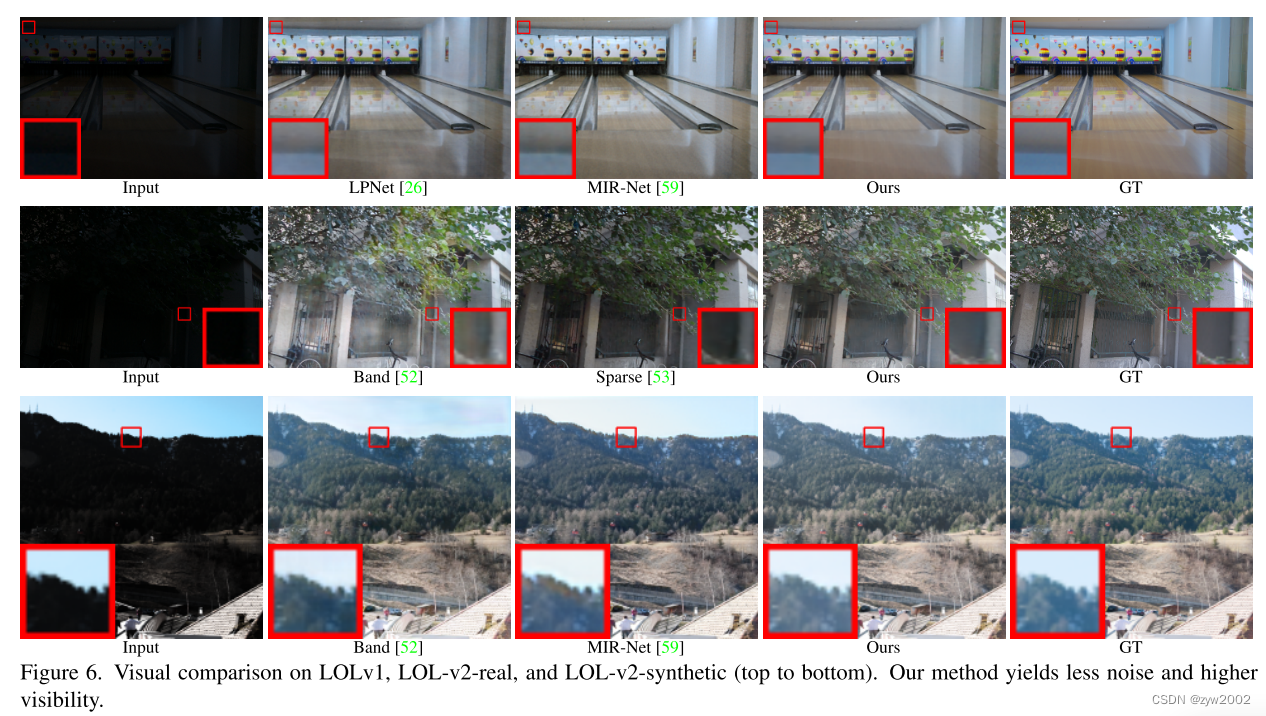

Qualitative analysis

首先,我們在圖6(最上面一行)中展示了視覺樣本,將我們的方法與在LOL-v1上獲得最佳性能(在PSNR方面)的基線進行比較。我們的方法可以得到更好的視覺質量與更高的對比度,更精確的細節,顏色一致性和更好的亮度。

圖6也顯示了LOLv2-real和lolv2 -synthetic的視覺對比。雖然這些數據集中的原始圖像存在明顯的噪聲和弱光照,但我們的方法仍然可以得到更真實的結果。此外,在具有復雜紋理的區域,我們的輸出顯示出更少的視覺偽影。

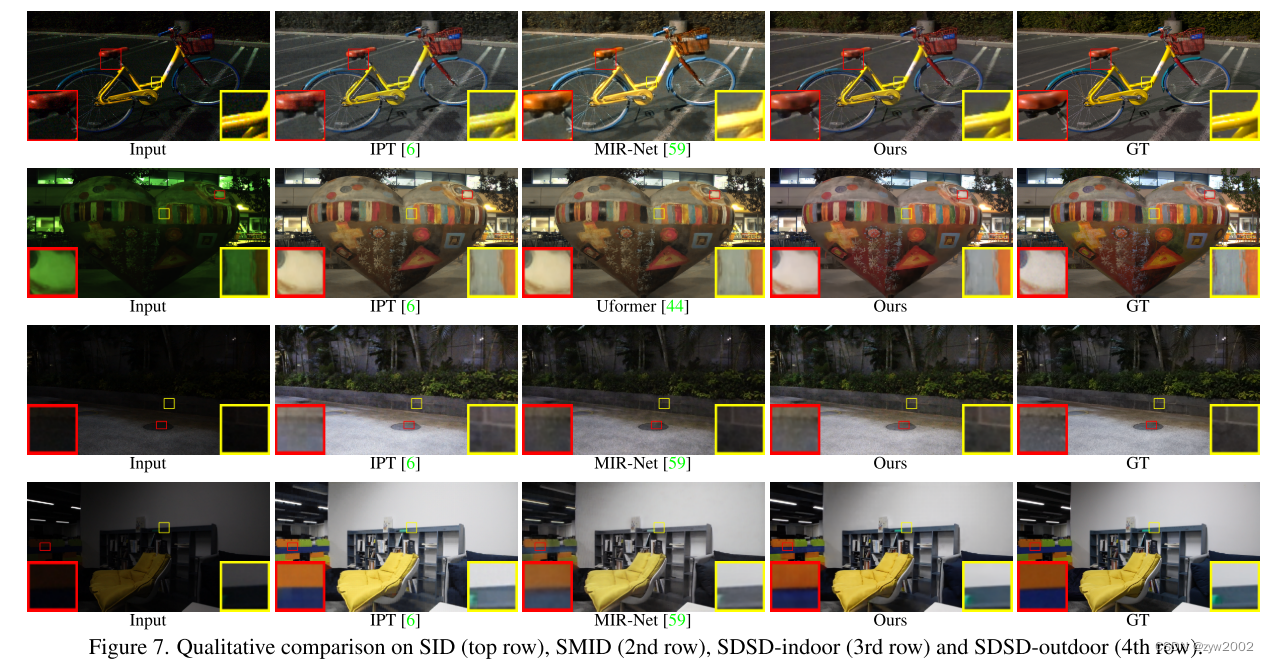

圖7(上一行)顯示了對SID的視覺比較,表明我們的方法可以有效地處理非常嘈雜的弱光圖像。圖7還顯示了SMID、sdsd -indoor和sdsd -outdoor的可視化結果。這些結果也表明,該方法在抑制噪聲的同時,能有效地增強圖像亮度,揭示圖像細節。

-

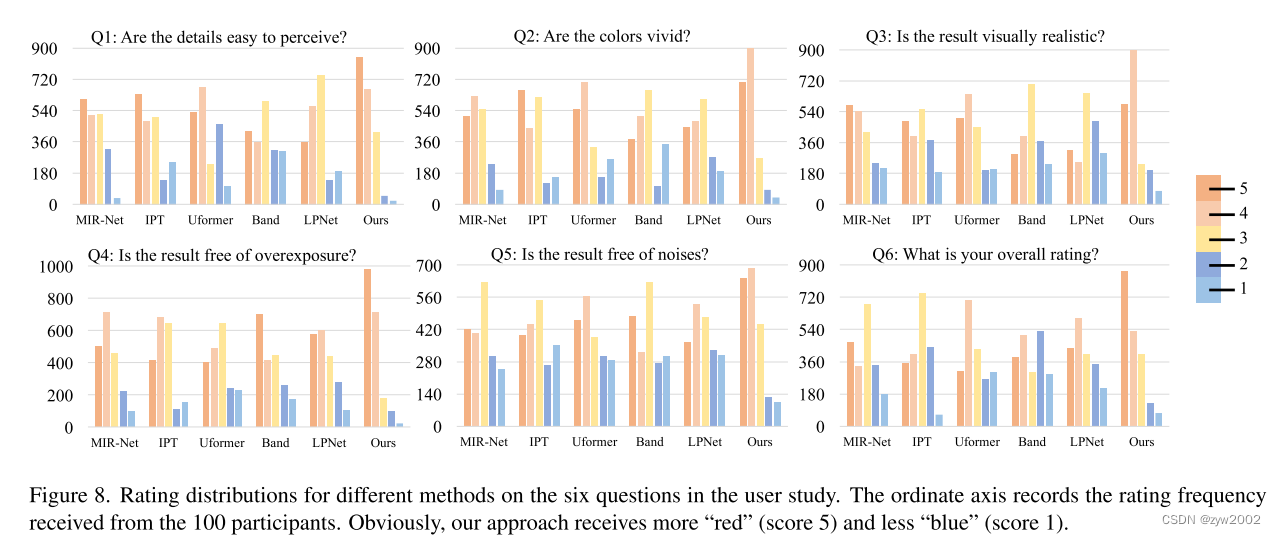

User study

我們進一步對100名參與者進行了大規模的用戶研究,以評估我們的方法和5個最強基線(通過SID、SMID和SDSD上的平均PSNR選擇)對增強iPhone X或華為P30拍攝的弱光照片的人類感知。共在道路、公園、圖書館、學校、肖像等不同環境下拍攝了30張弱光照片,50%圖像像素的強度低于30%。

在[40]中設置之后,我們使用Likert表(1(最差)到5(最好)),通過圖8中所示的6個問題的用戶評分來評估結果。所有方法都是在SDSD-outdoor上進行訓練,因為[39]表明訓練后的模型可以有效增強手機拍攝的弱光圖像。圖8顯示了不同方法的評級分布,其中我們的方法得到的“紅色”評級更多,“藍色”評級更少。此外,我們使用配對t檢驗(使用MS Excel中的t檢驗函數)對我們的方法和其他方法之間的評級進行了統計分析。在0.001的顯著水平下,所有的t檢驗結果都具有統計學意義,因為所有的pvalue都小于0.001。

4.3 Ablation Study

我們通過分別移除整體架構上的不同組件來考慮四種消融設置。

- “Our w/o L”刪除了遠程分支,所以框架只有卷積操作。

- “Our w/o S”刪除了短程分支,保持了完整的遠程分支和信噪比引導的注意力。

- “Ours w/o SA”進一步從“Ours w/o S”中刪除了信噪比引導的注意,只保留了最深層的基本Transformer結構。

- “Ours w/o A”消除了信噪比引導的注意。

我們對所有7個數據集進行了消融研究。表5總結了結果。與所有消融設置相比,我們的全消融設置產生了最高的PSNR和SSIM。“Our w/o L”、“Our w/o S”和“Our w/o SA”顯示了單獨使用卷積運算或Transformer結構的缺點,從而顯示了共同利用短程(卷積模型)和長程(Transformer結構)操作的有效性。結果還顯示了“信噪比引導的注意力”(“Ours w/o A”vs.“Ours”)和“信噪比引導的融合”(“Ours w/o S”vs.“Ours”)的影響。

4.4. Influence of SNR Prior

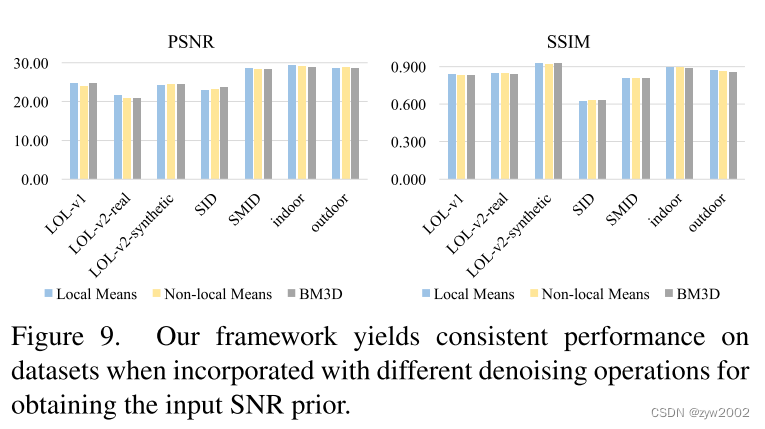

我們框架的信噪比輸入是通過對輸入幀進行不基于學習的去噪操作獲得的(式(2))。在所有的實驗中,考慮到local means去噪速度快,我們都采用local means去噪。在本節中,我們將分析引入其他操作時的影響,包括non-local means[1]和BM3D[8]。結果如圖9所示,表明我們的框架對獲取信噪比輸入的策略并不敏感。這些結果都優于基線的結果。

5. Conclusion

我們提出了一種新穎的信噪比感知框架,該框架共同利用short-range和long-range操作,以空間變化的方式動態增強像素。采用SNR prior對特征融合進行引導。SNR-aware Transformer采用了一個新的自注意模塊。大量的實驗,包括用戶研究,表明我們的框架在使用相同的網絡結構時,在有代表性的基準測試中始終保持最佳的性能。

我們未來的工作是探索其他semantics來增強空間變化機制。此外,我們計劃通過同時考慮時間和空間變化的操作,將我們的方法擴展到處理弱光視頻。另一個方向是探索微光圖像中接近黑色區域的生成方法。

)

)

)