更多資料獲取

📚 個人網站:ipengtao.com

在數據處理和分析領域,Python一直是一種強大的編程語言。然而,在處理大規模數據集和執行復雜操作時,有時候需要更高效的工具。在本文中,我們將深入探討pydash庫,這是一個專注于提高Python代碼性能的工具。

什么是pydash庫?

pydash是一個Python庫,旨在提供高性能、函數式編程風格的工具集,以簡化代碼并提高執行效率。它提供了許多有用的函數,使得在數據處理、集合操作和函數式編程方面更加輕松。

安裝pydash

在開始之前,首先需要安裝pydash。可以使用以下命令來安裝:

pip install pydash

pydash的核心功能

1. 函數式編程

pydash支持函數式編程風格,使得在處理數據時更加靈活。例如:

import pydash as _data = [1, 2, 3, 4, 5]# 使用pydash的map函數

squared_data = _.map(data, lambda x: x**2)print(squared_data)

2. 鏈式調用

pydash允許進行鏈式調用,使得代碼更加簡潔。例如:

import pydash as _data = [1, 2, 3, 4, 5]result = (_.chain(data).filter(lambda x: x % 2 == 0).map(lambda x: x**2).value()

)print(result)

3. 高性能集合操作

pydash提供了許多高性能的集合操作,例如uniq,intersection等。示例:

import pydash as _list1 = [1, 2, 3, 4, 5]

list2 = [3, 4, 5, 6, 7]common_elements = _.intersection(list1, list2)print(common_elements)

實際應用場景

在實際應用中,處理大型數據集是許多數據科學和分析任務的關鍵挑戰之一。讓我們看看pydash如何在這種場景中發揮作用,提高代碼效率。

1. 數據預處理

假設您有一個包含大量數據的CSV文件,您需要對其進行預處理以進行后續的分析。使用pydash的函數式編程風格,您可以輕松地進行各種數據清洗和轉換操作,使代碼更加簡潔易讀。

import pydash as _# 讀取大型CSV文件

data = read_large_csv("large_dataset.csv")# 數據清洗和轉換

cleaned_data = (_.chain(data).filter(lambda row: row['age'] > 18).map(lambda row: {'name': row['name'], 'age': row['age']}).value()

)

2. 并行處理

處理大型數據集時,常常面臨到需要并行處理以加速任務完成時間的情況。pydash提供了parallel函數,可以方便地在多個CPU核心上并行執行操作。

import pydash as _# 大型數據集

data = generate_large_dataset()# 并行處理數據

processed_data = _.parallel(_.map(data, expensive_operation))

3. 數據分組和聚合

當需要對大型數據集進行分組和聚合時,pydash的集合操作非常強大。考慮一個例子,需要按城市對用戶進行分組,并計算每個城市的平均年齡。

import pydash as _# 大型用戶數據集

user_data = get_large_user_dataset()# 按城市分組并計算平均年齡

average_age_by_city = (_.chain(user_data).group_by('city').map_values(lambda group: _.mean(_.pluck(group, 'age'))).value()

)

4. 多階段數據流處理

在大數據處理中,常常需要構建多階段的數據處理流程。pydash的鏈式調用使得構建這樣的數據流程非常直觀。

import pydash as _# 大型數據流處理

result = (_.chain(data).stage1_operation().stage2_operation().stage3_operation().value()

)

性能比較:pydash vs. 原生Python

為了評估pydash在性能上的優勢,我們將對比一些常見操作的執行時間,與原生Python代碼相比較。以下是一些基準測試的示例,旨在展示pydash在處理大型數據集時的潛在性能提升。

1. Map 操作

考慮一個簡單的場景,對一個包含大量元素的列表進行平方運算。

原生Python代碼:

import timedata = [i for i in range(1, 1000000)]start_time = time.time()squared_data = list(map(lambda x: x**2, data))end_time = time.time()

elapsed_time_native = end_time - start_time

print(f"原生Python代碼執行時間: {elapsed_time_native} 秒")

pydash代碼:

import time

import pydash as _data = [i for i in range(1, 1000000)]start_time = time.time()squared_data = _.map(data, lambda x: x**2)end_time = time.time()

elapsed_time_pydash = end_time - start_time

print(f"pydash代碼執行時間: {elapsed_time_pydash} 秒")

2. Filter 操作

在這個示例中,將篩選出大于100的元素。

原生Python代碼:

import timedata = [i for i in range(1, 1000000)]start_time = time.time()filtered_data = list(filter(lambda x: x > 100, data))end_time = time.time()

elapsed_time_native = end_time - start_time

print(f"原生Python代碼執行時間: {elapsed_time_native} 秒")

pydash代碼:

import time

import pydash as _data = [i for i in range(1, 1000000)]start_time = time.time()filtered_data = _.filter(data, lambda x: x > 100)end_time = time.time()

elapsed_time_pydash = end_time - start_time

print(f"pydash代碼執行時間: {elapsed_time_pydash} 秒")

3. Reduce 操作

在這個示例中,將使用reduce計算一個大型列表的總和。

原生Python代碼:

import timedata = [i for i in range(1, 1000000)]start_time = time.time()sum_native = sum(data)end_time = time.time()

elapsed_time_native = end_time - start_time

print(f"原生Python代碼執行時間: {elapsed_time_native} 秒")

pydash代碼:

import time

import pydash as _data = [i for i in range(1, 1000000)]start_time = time.time()sum_pydash = _.reduce(data, lambda acc, x: acc + x, 0)end_time = time.time()

elapsed_time_pydash = end_time - start_time

print(f"pydash代碼執行時間: {elapsed_time_pydash} 秒")

通過這些性能比較示例,可以清晰地看到pydash在一些常見操作上的性能優勢。在處理大規模數據時,pydash的高效實現使其能夠在相同任務上顯著縮短執行時間。然而,在實際應用中,具體的性能提升取決于任務的復雜性和數據的規模。讀者可以根據實際需求選擇是否使用pydash來提高代碼的執行效率。

總結

在本文中,深入探討了Python pydash庫,并著重展示了其在實際應用場景和性能方面的優勢。通過詳細的示例代碼,演示了pydash如何簡化數據處理、提供函數式編程風格以及在大型數據集上顯著提高代碼效率。在實際應用場景中,pydash通過鏈式調用、并行處理、數據分組聚合等功能,為處理大規模數據提供了靈活而高效的解決方案。

進一步,進行了性能比較,對比了pydash與原生Python在常見操作上的執行時間。結果表明,在大數據處理任務中,pydash能夠明顯縮短代碼執行時間,為開發者提供更高效的工具。然而,具體的性能提升仍取決于任務的特性和數據規模。

總體而言,pydash以其豐富的功能和高性能的特點,為Python開發者提供了一個強大的工具,特別適用于處理大規模數據和復雜操作的場景。通過優雅的函數式編程風格,鏈式調用和高性能的集合操作,pydash為數據科學家和分析師提供了一個有力的工具,能夠在大數據背景下提高代碼的可讀性和執行效率。

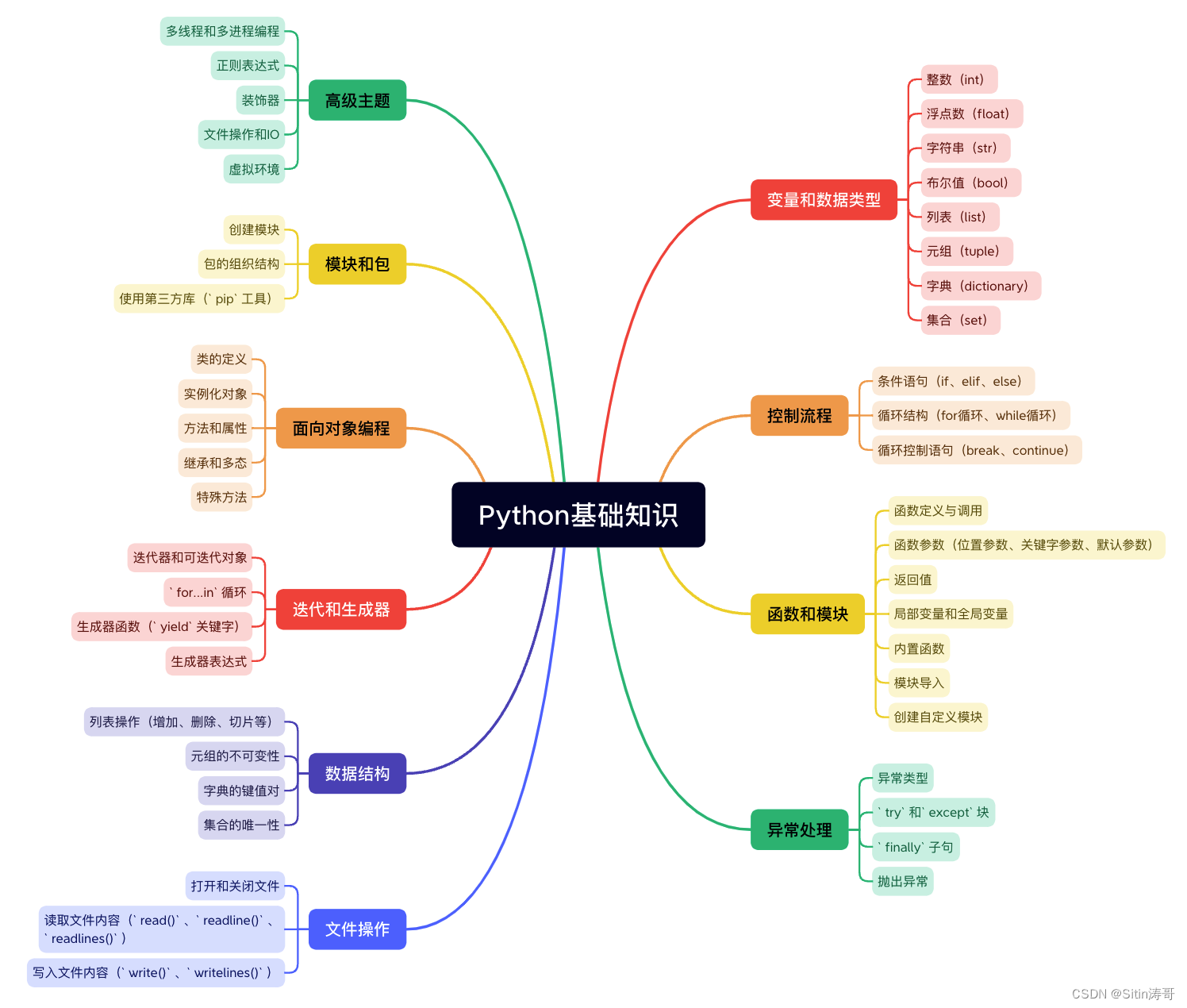

Python學習路線

更多資料獲取

📚 個人網站:ipengtao.com

如果還想要領取更多更豐富的資料,可以點擊文章下方名片,回復【優質資料】,即可獲取 全方位學習資料包。

點擊文章下方鏈接卡片,回復【優質資料】,可直接領取資料大禮包。

![[MySQL--進階篇]存儲引擎的體系結構、簡介、特點、選擇](http://pic.xiahunao.cn/[MySQL--進階篇]存儲引擎的體系結構、簡介、特點、選擇)

)

)