提示:RAM++模型:環境安裝、數據準備與說明、模型推理、模型finetune、模型pretrain等

文章目錄

- 前言

- 一、環境安裝

- 二、數據準備與解讀

- 1.數據下載

- 2.數據標簽內容解讀

- 3.標簽map內容解讀

- 三、finetune訓練

- 1.微調訓練命令

- 2.load載入參數問題

- 3.權重載入

- 4.數據加載問題

- 5.設備不匹配報錯

- 6.運行結果

- 四、pretrain預訓練

- 1.預訓練命令

- 2.swin_large_patch4_window12_384_22k.pth權重

- a.下載

- b.權重加載修改

- 3.ram_plus_tag_embedding_class_4585_des_51.pth權重

- a.下載

- b.權重加載修改

- 4.變量設備匹配問題

- 5. 預訓練成功顯示

- 五、數據加載源碼簡單解讀

- 六、推理

前言

隨著SAM模型分割一切大火之后,又有RAM模型識別一切,RAM模型由來可有三篇模型構成,TAG2TEXT為首篇將tag引入VL模型中,由tagging、generation、alignment分支構成,隨后才是RAM模型,主要借助CLIP模型輔助與annotation處理trick,由tagging、generation分支構成,最后才是RAM++模型,該模型引入semantic concepts到圖像tagging訓練框架,RAM++模型能夠利用圖像-標簽-文本三者之間的關系,整合image-text alignment 和 image-tagging 到一個統一的交互框架里。作者也將三個模型整合成一套代碼,本文將介紹RAM++模型,主要內容包含環境安裝、數據準備與說明、模型推理、模型finetune、模型pretrain等內容,并逐過程解讀,也幫讀者踩完所有坑,只要按照我我步驟將會實現RAM流暢運行。

TAG2TEXT論文鏈接:點擊這里

RAM論文鏈接:點擊這里

RAM++論文鏈接:點擊這里

github官網鏈接:點擊這里

一、環境安裝

說實話,環境安裝按照官網來,沒有報什么錯,可直接推理運行,但是訓練可能會缺一些東西,后續將介紹,環境安裝如下:

Install recognize-anything as a package:

pip install git+https://github.com/xinyu1205/recognize-anything.git

Or, for development, you may build from source

git clone https://github.com/xinyu1205/recognize-anything.git

cd recognize-anything

pip install -e .

二、數據準備與解讀

1.數據下載

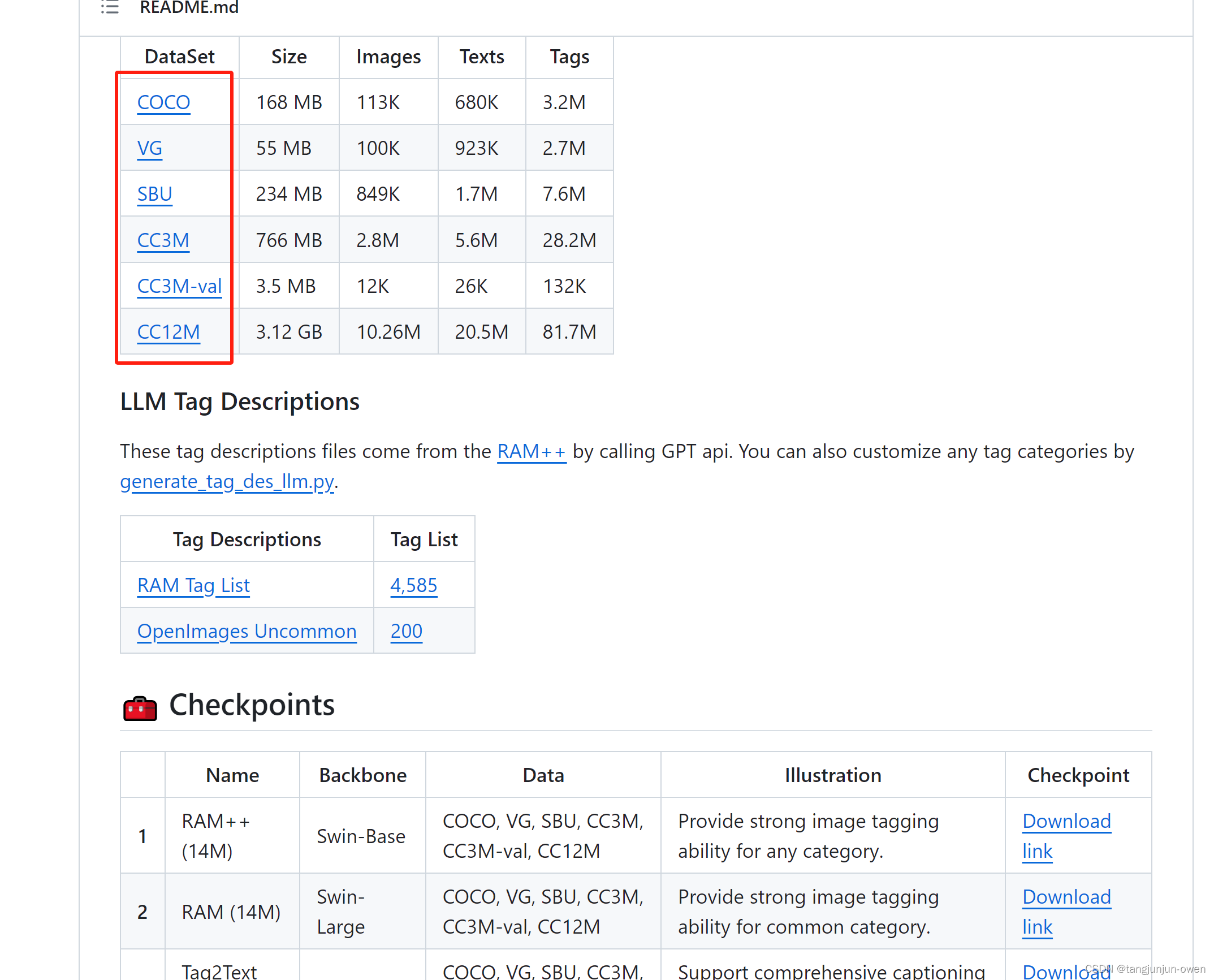

圖像數據需要根據相應內容去下載,而數據標簽下載可以去github代碼官網鏈接,點擊下面紅框即可。當然你也可轉到下面網頁鏈接。

數據標簽下載:https://huggingface.co/datasets/xinyu1205/recognize-anything-dataset-14m/tree/main

當進入標簽頁面如下:

2.數據標簽內容解讀

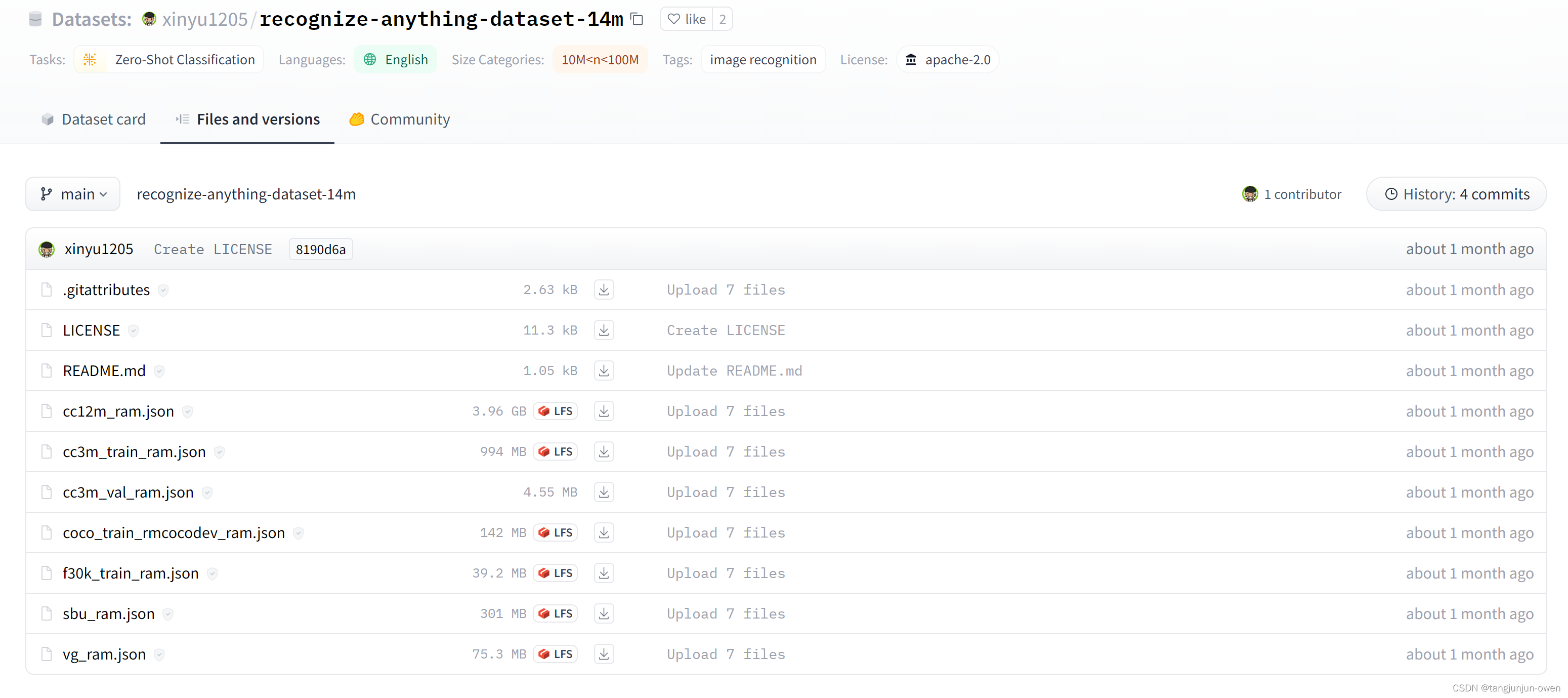

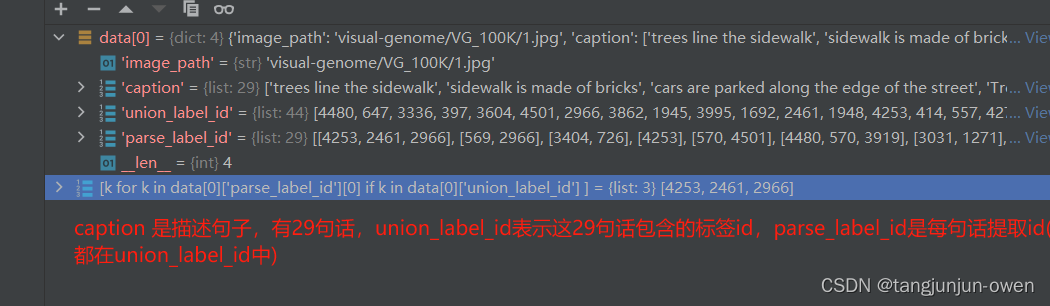

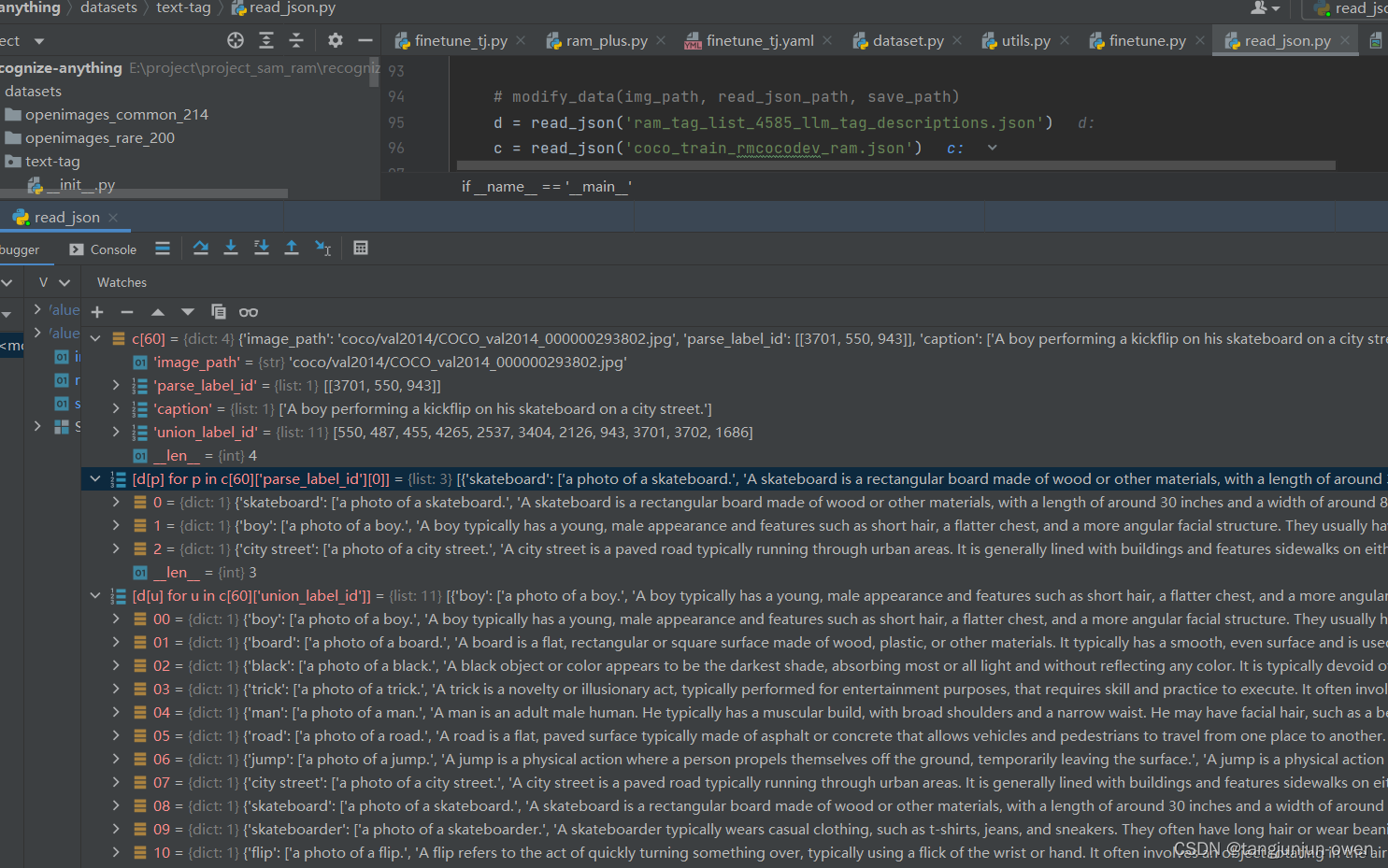

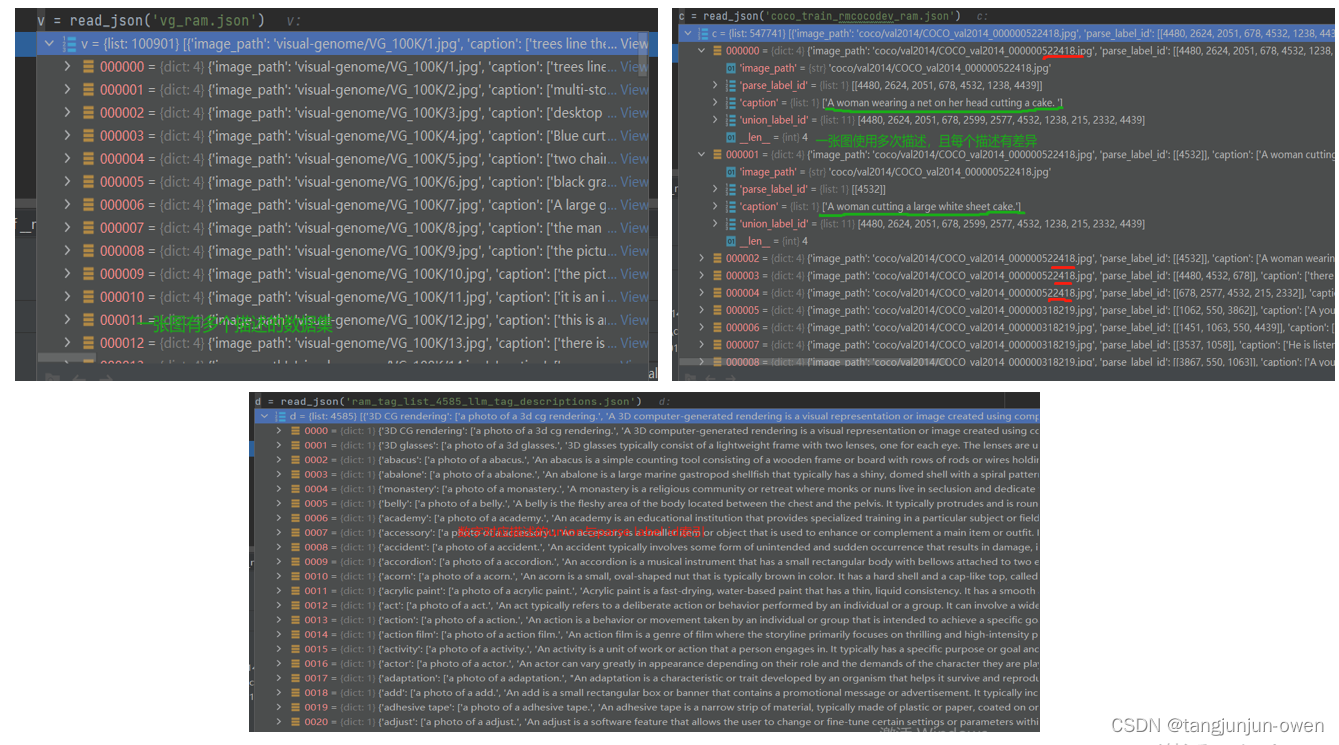

當你下載了標簽后,你能發現標簽實際是列表,列表中每個數據又是一個字典,包含image_path、caption、union_label_id、parse_label_id字典,以vg_ram.json標簽舉列,我們取第一個元素,如下圖所示:

我們進一步展開該數據,你會重點發現parse_label_id是一個二維列表,每一行是對對應caption描述取的tag而union_label_id是一維列表,parse_label_id中tag都能在union_label_id找到,反之不行。如下圖:

3.標簽map內容解讀

我們在上面可看到parse_label_id與union_label_id是數字,那么這些數字如何得到,必然有一個映射表,該表是ram_tag_list_4585_llm_tag_descriptions.json文件中,該文件也是一個列表,列表中每個元素是一個字典,該字典key就是tag,value是一個列表,是對key的描述,我查看value的列表有50個描述。其中該文件列表位置(索引)就代表key(tag),這也是parse_label_id與union_label_id的數字。如下:

當然,RAM模型數據可以一個元素的一張圖有多個描述如下左圖,也可以多個元素表示同一張圖,進行多個描述,如下:

三、finetune訓練

1.微調訓練命令

可看出訓練使用finetune.py文件,參數配置是finetune.yaml文件,模型類型選擇是ram_plus文件,如下:

python -m torch.distributed.run --nproc_per_node=8 finetune.py \ --model-type ram_plus \ --config ram/configs/finetune.yaml \ --checkpoint outputs/ram_plus/checkpoint_04.pth \ --output-dir outputs/ram_plus_ft

我是直接運行finetune.py文件,使用遠程鏈接方式運行的!

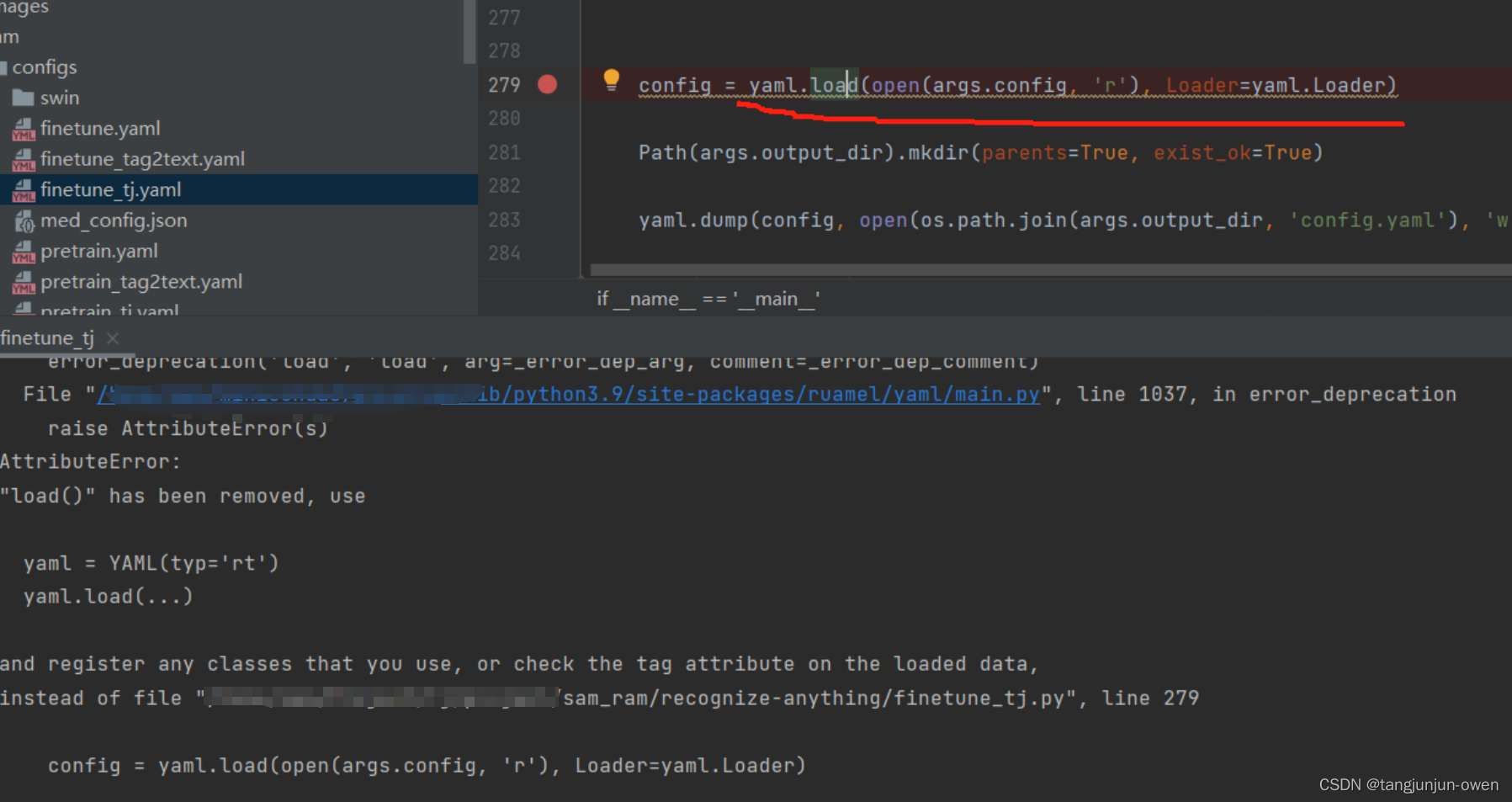

2.load載入參數問題

當執行微調命令時,我遇到yaml載入問題,如下圖:

當然這個是個小問題,與環境相關,可能你們不會遇到,若遇到可嘗試我的解決方法:

導入包ruamel.yaml,更改原有代碼

config = yaml.load(open(args.config, 'r'), Loader=yaml.Loader)

為以下代碼即可:

import ruamel.yaml yaml = ruamel.yaml.YAML(typ='rt') config = yaml.load(open(args.config, 'r'))

注:該問題pretrain可能也會遇到。

3.權重載入

第二個問題,模型權重 模型權重載入需要修改,根據你的需求可修改權重路徑,如下圖:  我使用ram++,將

我使用ram++,將model_clip, _ = clip.load("/home/notebook/data/group/huangxinyu/clip/ViT-B-16.pt")中的地址替換即可。

權重下載地址如下:

_MODELS = {

"RN50":"https://openaipublic.azureedge.net/clip/models/afeb0e10f9e5a86da6080e35cf09123aca3b358a0c3e3b6c78a7b63bc04b6762/RN50.pt",

"RN101":"https://openaipublic.azureedge.net/clip/models/8fa8567bab74a42d41c5915025a8e4538c3bdbe8804a470a72f30b0d94fab599/RN101.pt",

"RN50x4":"https://openaipublic.azureedge.net/clip/models/7e526bd135e493cef0776de27d5f42653e6b4c8bf9e0f653bb11773263205fdd/RN50x4.pt",

"RN50x16": "https://openaipublic.azureedge.net/clip/models/52378b407f34354e150460fe41077663dd5b39c54cd0bfd2b27167a4a06ec9aa/RN50x16.pt",

"RN50x64": "https://openaipublic.azureedge.net/clip/models/be1cfb55d75a9666199fb2206c106743da0f6468c9d327f3e0d0a543a9919d9c/RN50x64.pt",

"ViT-B/32": "https://openaipublic.azureedge.net/clip/models/40d365715913c9da98579312b702a82c18be219cc2a73407c4526f58eba950af/ViT-B-32.pt",

"ViT-B/16": "https://openaipublic.azureedge.net/clip/models/5806e77cd80f8b59890b7e101eabd078d9fb84e6937f9e85e4ecb61988df416f/ViT-B-16.pt",

"ViT-L/14": "https://openaipublic.azureedge.net/clip/models/b8cca3fd41ae0c99ba7e8951adf17d267cdb84cd88be6f7c2e0eca1737a03836/ViT-L-14.pt",

"ViT-L/14@336px": "https://openaipublic.azureedge.net/clip/models/3035c92b350959924f9f00213499208652fc7ea050643e8b385c2dac08641f02/ViT-L-14-336px.pt",

}

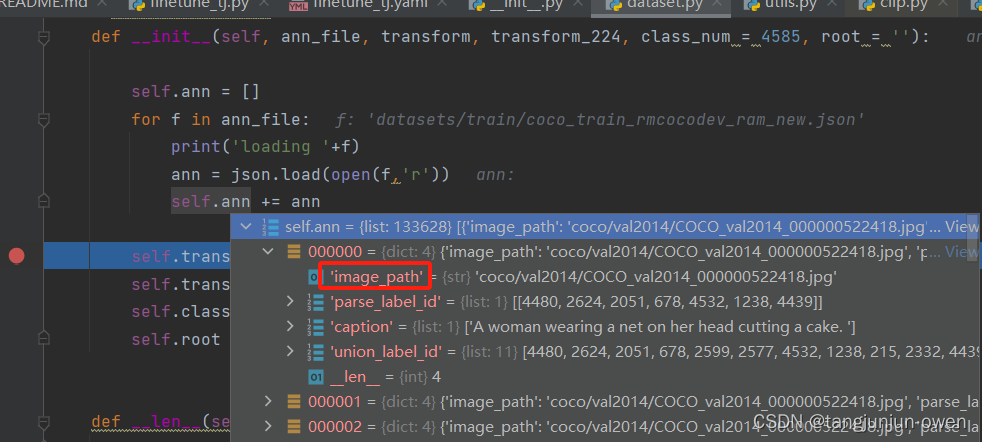

4.數據加載問題

需在finetune.yaml文件中設定image_path_root: “” 參數,使得該參數與下圖image_path合并為圖像絕對路徑,我設定如下:

image_path_root: "/home/Project/recognize-anything/datasets/train"

圖像路徑如下圖所示:

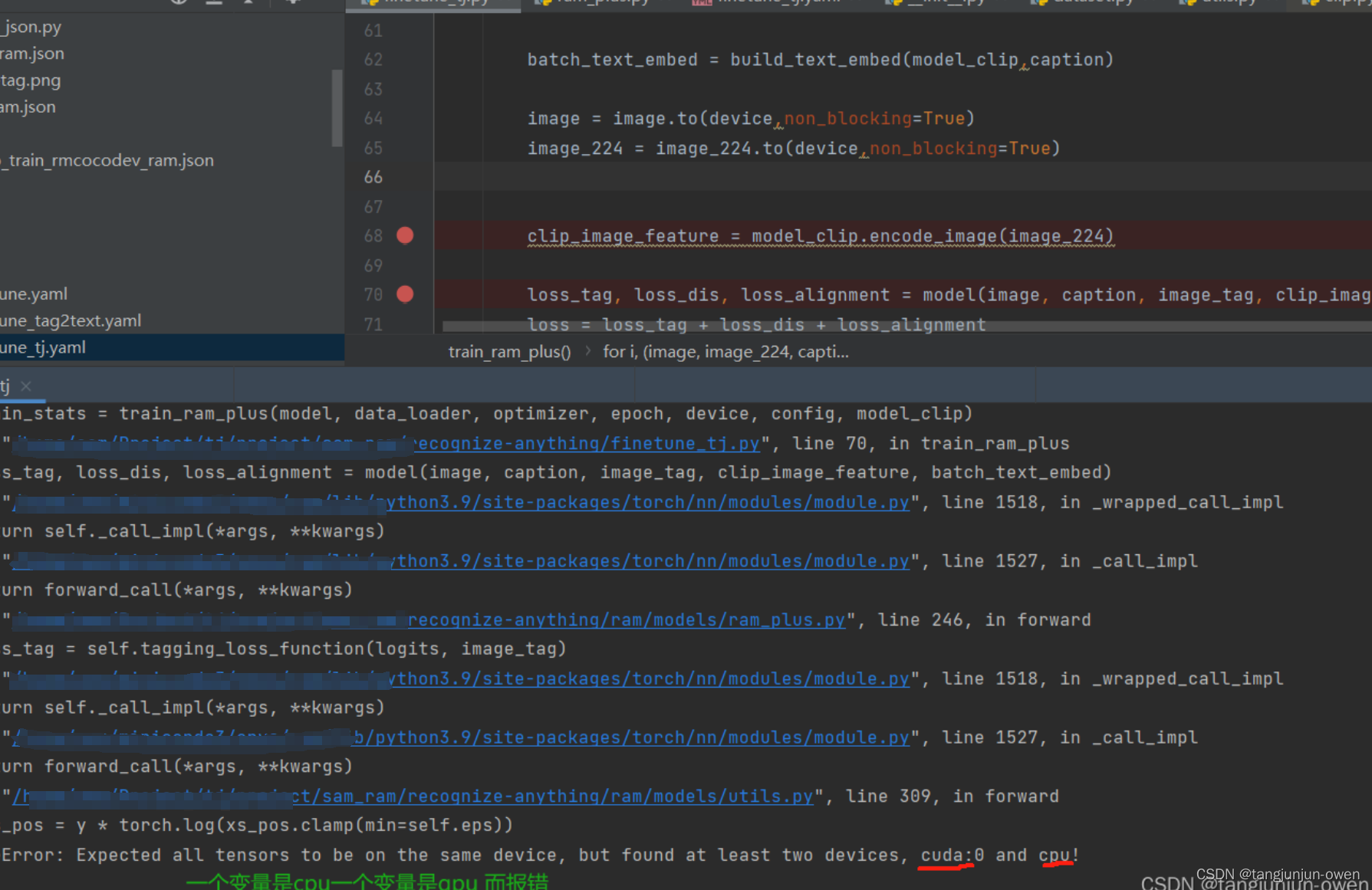

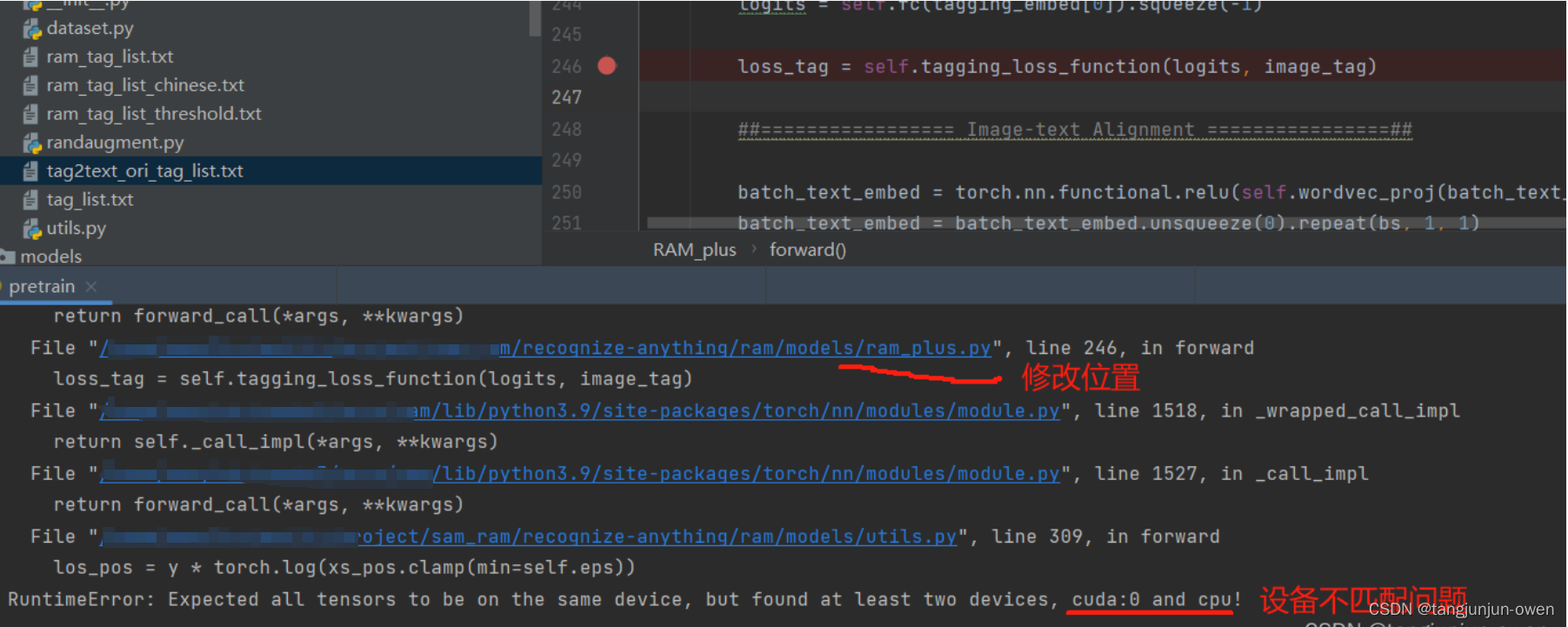

5.設備不匹配報錯

運行預訓練命令依然會報錯,如下:

該問題也是小問題,就是變量設備不匹配問題,在finetune.py文件,為image_tag變量指定設備,添加一句代碼:

image_tag = image_tag.to(device,non_blocking=True)

修改后整體代碼如下:

for i, (image, image_224, caption, image_tag, parse_tag) in enumerate(metric_logger.log_every(data_loader, print_freq, header)): optimizer.zero_grad() batch_text_embed = build_text_embed(model_clip,caption) image = image.to(device,non_blocking=True) image_224 = image_224.to(device,non_blocking=True) image_tag = image_tag.to(device,non_blocking=True) clip_image_feature = model_clip.encode_image(image_224) loss_tag, loss_dis, loss_alignment = model(image, caption, image_tag, clip_image_feature, batch_text_embed) loss = loss_tag + loss_dis + loss_alignment

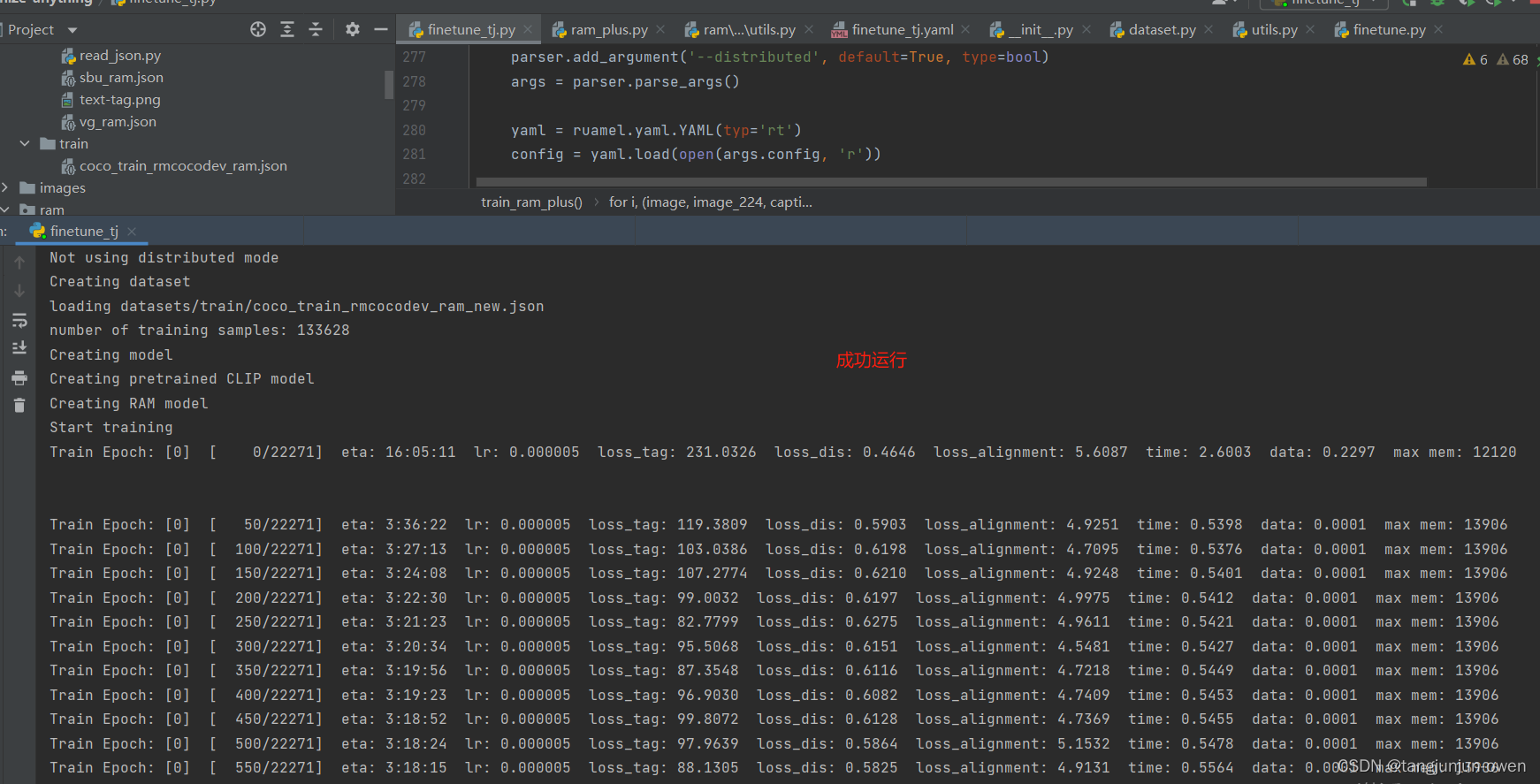

6.運行結果

之后運行結果如下:

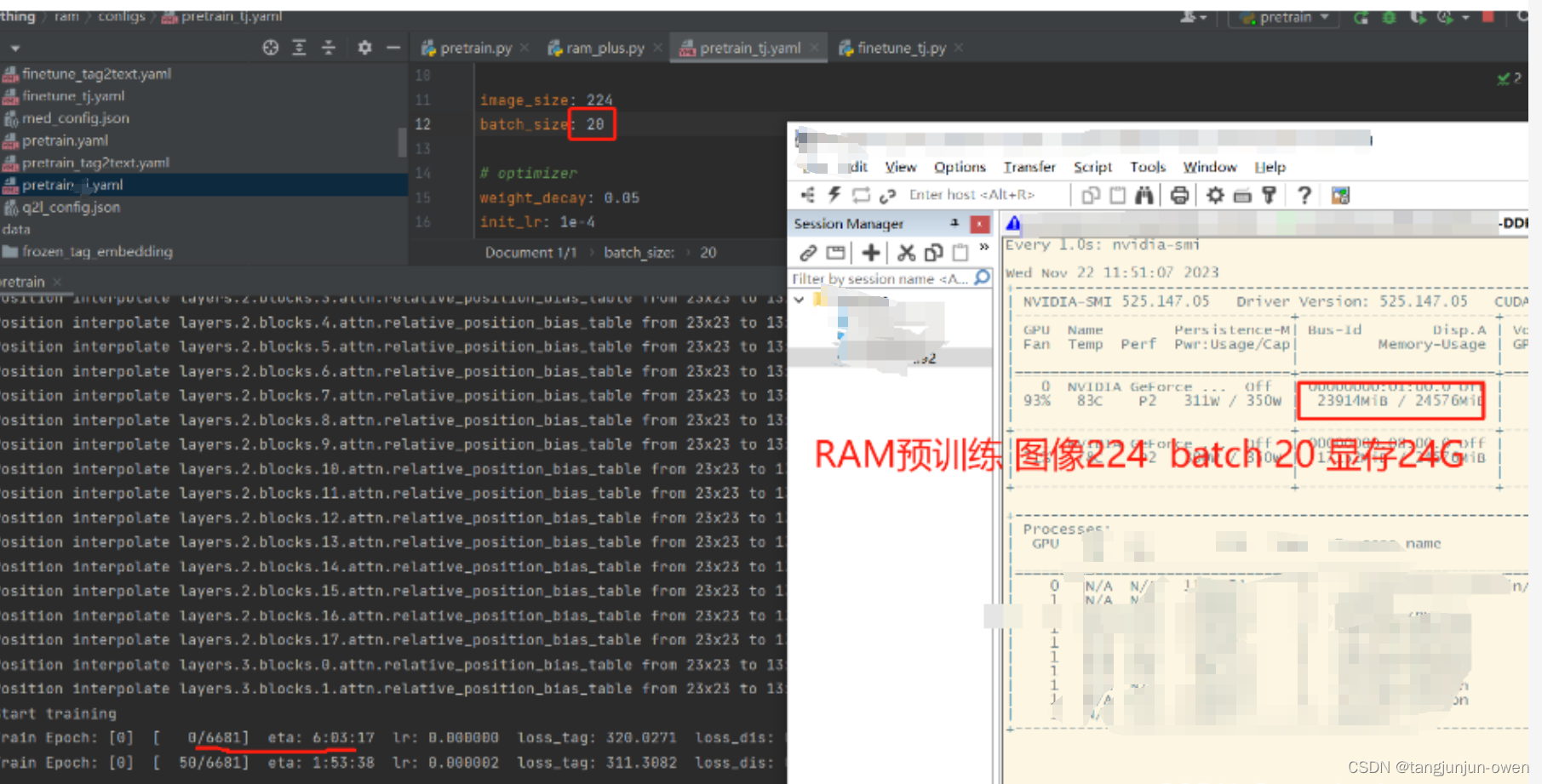

我們進一步可發現使用一張3090顯卡,batch為20即可滿負載,如下:

注:以上微調內容某些在訓練時候遇到,按其修改即可!

四、pretrain預訓練

1.預訓練命令

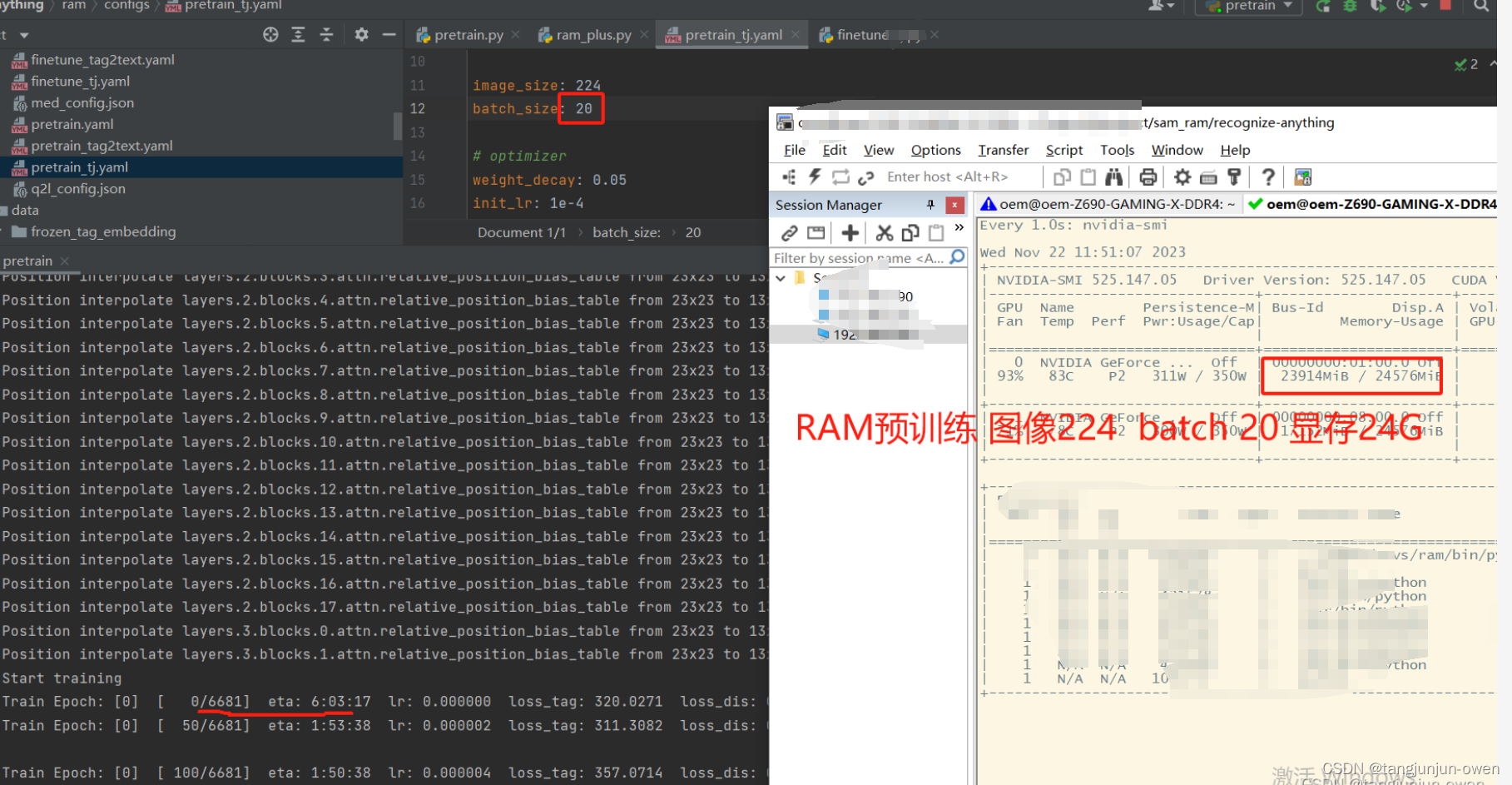

可看出預訓練使用pretrain.py文件,參數配置是pretrain.yaml文件,模型類型選擇是ram_plus文件,如下:

python -m torch.distributed.run --nproc_per_node=8 pretrain.py \--model-type ram_plus \--config ram/configs/pretrain.yaml \--output-dir outputs/ram_plus

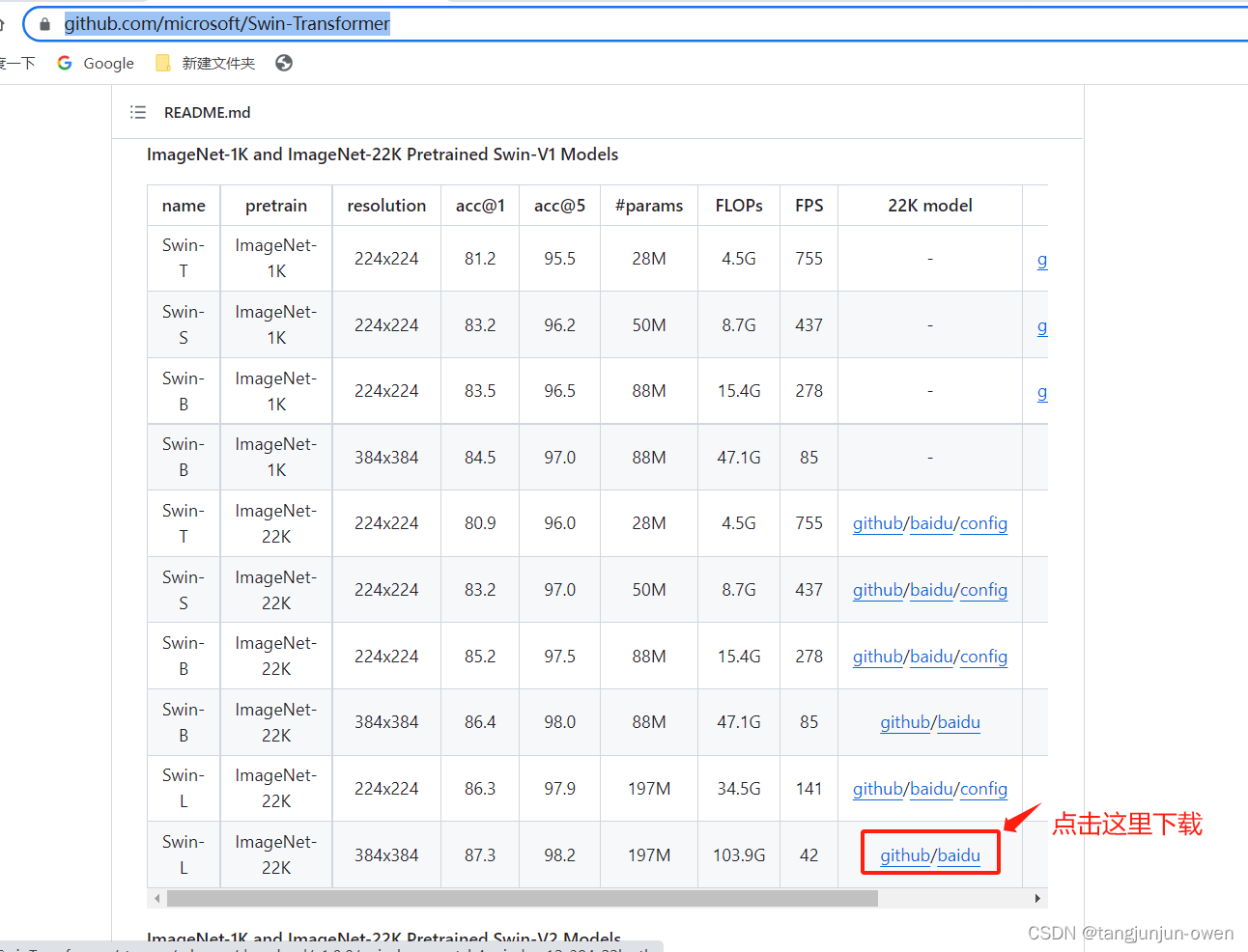

2.swin_large_patch4_window12_384_22k.pth權重

a.下載

但你直接使用該命令時候,會報如下錯誤:

以上報錯是因為缺失相應權重swin_large_patch4_window12_384_22k.pth,我們只需通過下面鏈接點擊這里,獲得如下圖權重下載即可,如下:

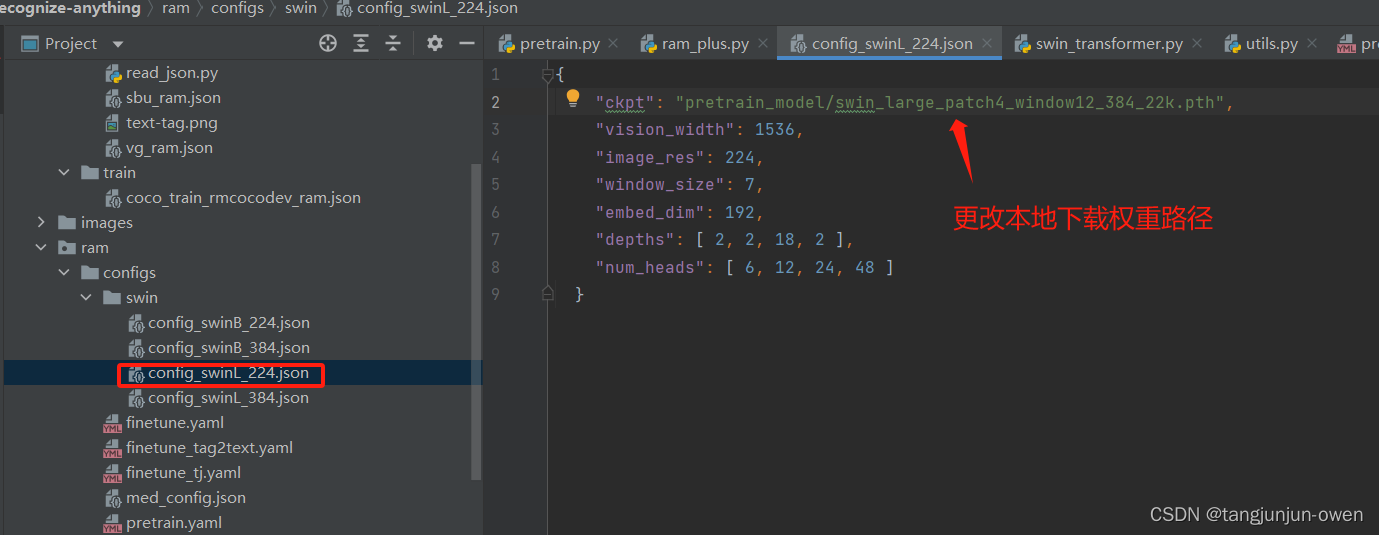

b.權重加載修改

對應權重下載實際是pretrain.yaml參數設置的vit: 'swin_l'與image_size: 224共同決定,我們將其定位為config_swinl_224.json文件,如下圖:

上面我們已知權重路徑更改位置,我們將其下載權重絕對路徑替換即可,如下代碼示列:

{

{"ckpt": "絕對路徑位置/swin_large_patch4_window12_384_22k.pth","vision_width": 1536,"image_res": 224,"window_size": 7,"embed_dim": 192,"depths": [ 2, 2, 18, 2 ],"num_heads": [ 6, 12, 24, 48 ]}}

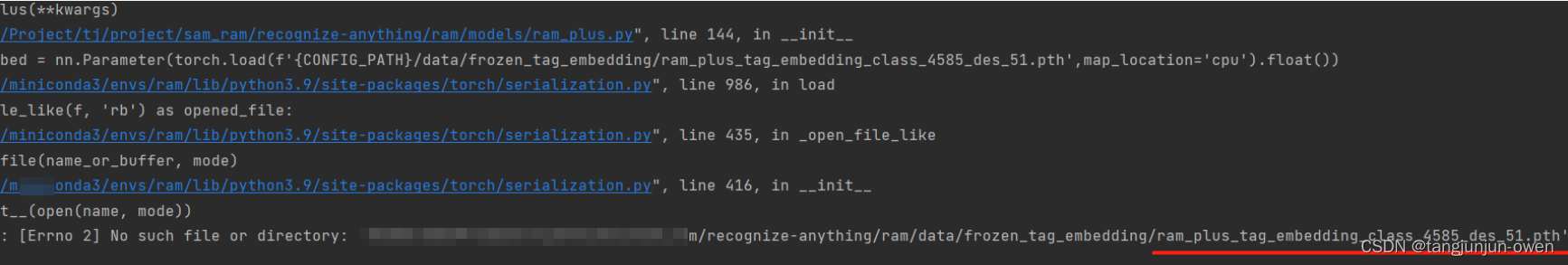

3.ram_plus_tag_embedding_class_4585_des_51.pth權重

a.下載

當你再次使用該命令時候,會報如下錯誤:

不要慌張,依然是權重問題,我們只需鏈接:點擊這里,可在huggingface下載我們想要的權重文件。

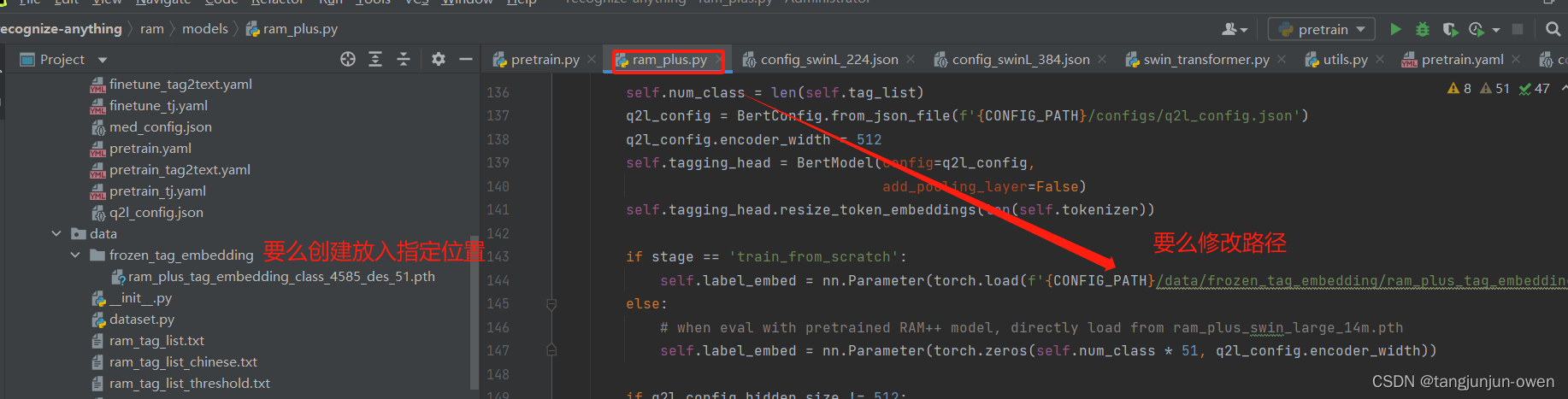

b.權重加載修改

對應權重下載后有2種方法可實現權重正確加載,第一將下載權重放到指定路,第二將在源碼ram_plus.py改成絕對路徑,如下圖:

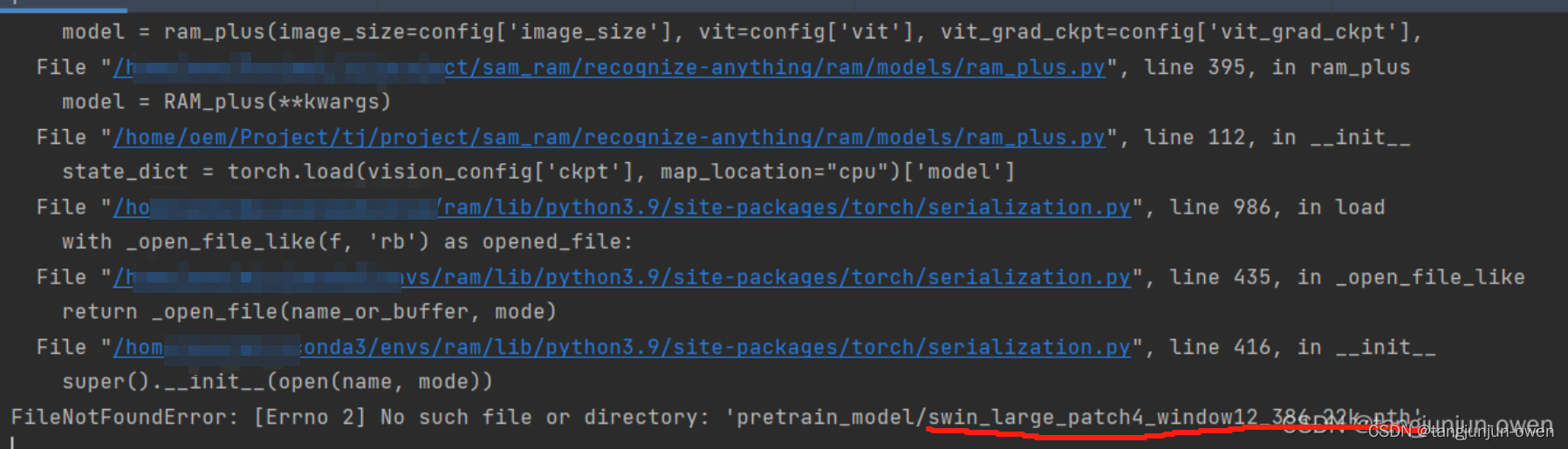

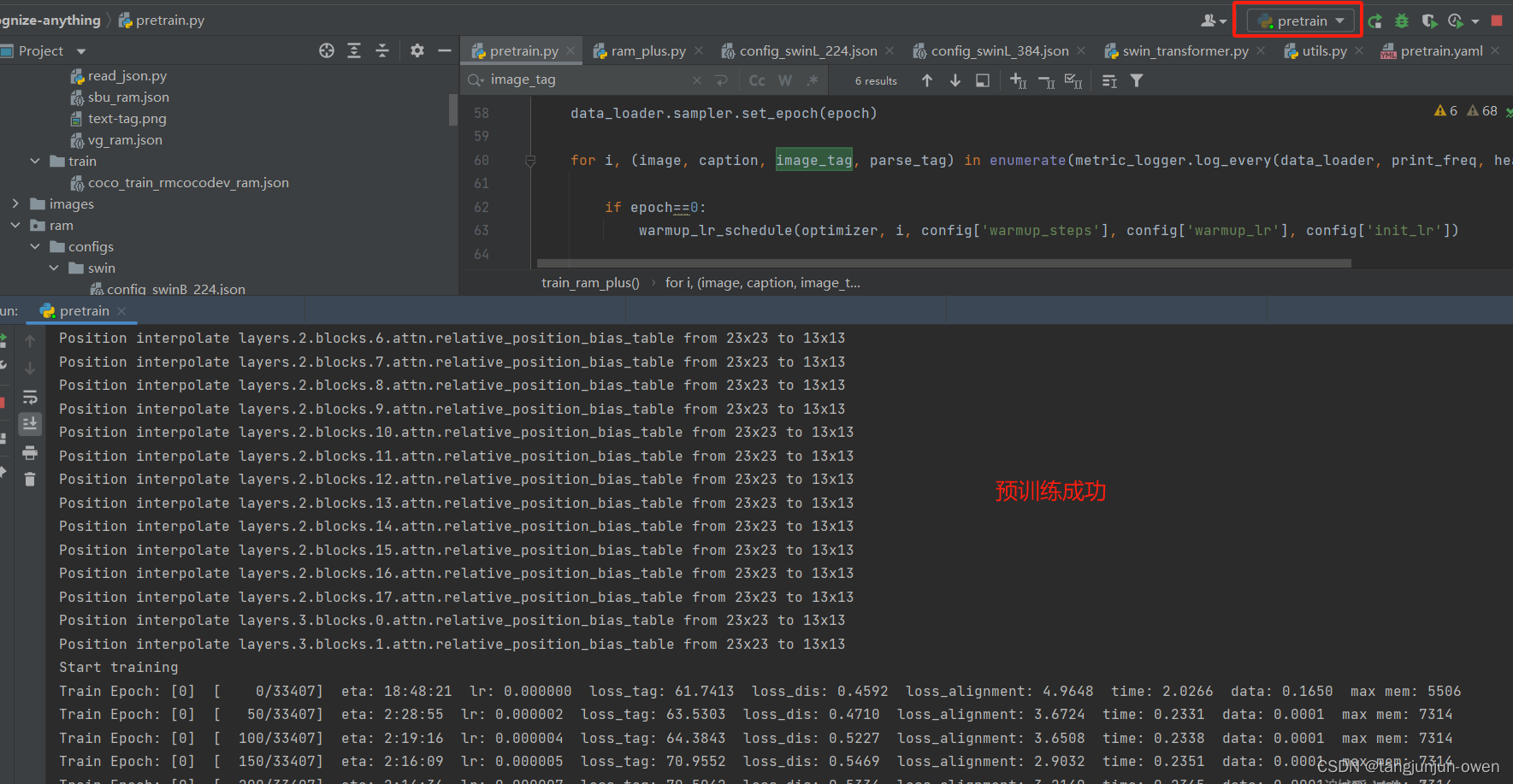

4.變量設備匹配問題

當你很開心再次使用預訓練命令時,會報如下錯誤(該錯誤在finetune也會出現):

該問題也是小問題,就是變量設備不匹配問題,從上圖報錯地方可追述到ram_plus.py文件除了問題,實際決定該問題是在pretrain.py文件調用那里,主要是image_tag是一個傳入參數未能給定device,我們在pretrain.py下面代碼給定即可,我也建議在pretrain.py修改,而不要動報錯地方修改,你只需添加image_tag = image_tag.to(device, non_blocking=True)指定設備,修改如下:

for i, (image, caption, image_tag, parse_tag) in enumerate(metric_logger.log_every(data_loader, print_freq, header)):if epoch==0:warmup_lr_schedule(optimizer, i, config['warmup_steps'], config['warmup_lr'], config['init_lr'])optimizer.zero_grad()batch_text_embed = build_text_embed(model_clip,caption)image = image.to(device,non_blocking=True)image_tag = image_tag.to(device, non_blocking=True) #5. 預訓練成功顯示

如出現下圖表示預訓練成功,如下:

我們進一步可發現使用一張3090顯卡,batch為20即可滿負載,如下:

五、數據加載源碼簡單解讀

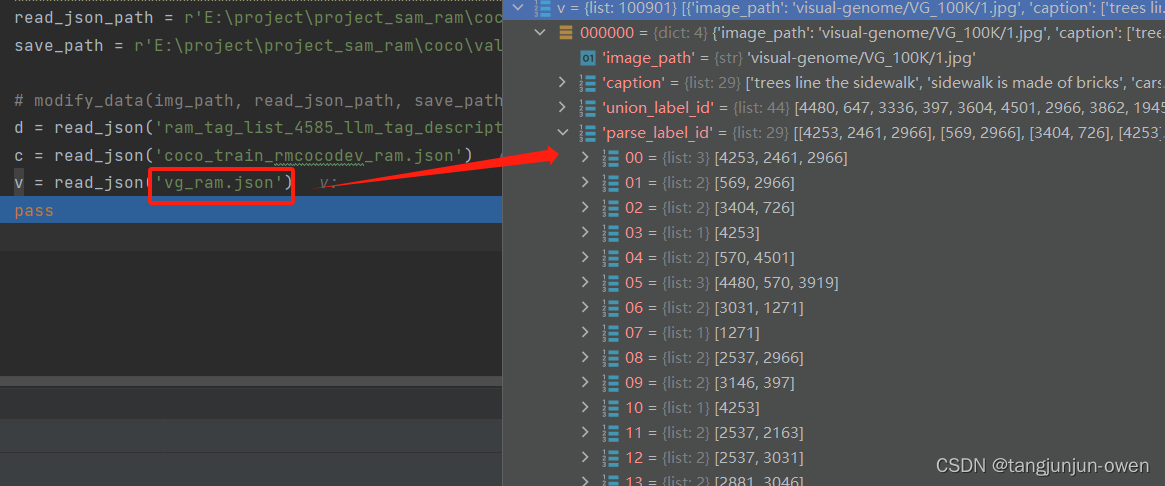

標簽源碼如下,可看到圖像做了2次加工一次該模型本身使用image,一次為圖像特征提取swin模型使用image_224,而caption為一句話(若為多句隨機選擇一句),該句話直接通過clip的文本編碼獲得特征,image_tag 是union_label_id, parse_tag是parse_label_id,具體如下代碼:

def __getitem__(self, index): ann = self.ann[index] image_path_use = os.path.join(self.root, ann['image_path'])image = Image.open(image_path_use).convert('RGB') image = self.transform(image)image_224 = Image.open(image_path_use).convert('RGB') image_224 = self.transform_224(image_224)# image_tag 是union_label_idnum = ann['union_label_id']image_tag = np.zeros([self.class_num])image_tag[num] = 1image_tag = torch.tensor(image_tag, dtype = torch.long)caption_index = np.random.randint(0, len(ann['caption'])) # 有的數據集有多個描述caption = pre_caption(ann['caption'][caption_index],30)# parse_tag是parse_label_idnum = ann['parse_label_id'][caption_index]parse_tag = np.zeros([self.class_num])parse_tag[num] = 1parse_tag = torch.tensor(parse_tag, dtype = torch.long)return image, image_224, caption, image_tag, parse_tag六、推理

推理可直接使用命令,指定權重我在pretrain已給出鏈接,可自行下載:

python batch_inference.py \ --model-type ram_plus \ --checkpoint pretrained/ram_plus_swin_large_14m.pth \ --dataset openimages_common_214 \ --output-dir outputs/ram_plus

當然,你也可以使用我的代碼,我是將一個文件夾循環推理,并將推理結果打印于圖上便于查看,如下:

'''* The Recognize Anything Plus Model (RAM++)* Written by Xinyu Huang

'''

import argparse

import osimport numpy as np

import randomimport torchfrom PIL import Image

from ram.models import ram_plus

from ram import inference_ram as inference

from ram import get_transformparser = argparse.ArgumentParser(description='Tag2Text inferece for tagging and captioning')

parser.add_argument('--image',help='path to dataset',default='images/demo/demo1.jpg')

parser.add_argument('--pretrained',help='path to pretrained model',default='路徑位置/ram_plus_swin_large_14m.pth')

parser.add_argument('--image-size',default=384,type=int,metavar='N',help='input image size (default: 448)')import cv2

import numpy as np

from PIL import Image, ImageDraw, ImageFontdef cv2ImgAddText(img, text, left, top, textColor=(0, 255, 0), textSize=20):if (isinstance(img, np.ndarray)): # 判斷是否OpenCV圖片類型img = Image.fromarray(cv2.cvtColor(img, cv2.COLOR_BGR2RGB))# 創建一個可以在給定圖像上繪圖的對象draw = ImageDraw.Draw(img)# 字體的格式fontStyle = ImageFont.truetype("/usr/share/fonts/opentype/noto/NotoSansCJK-Regular.ttc", textSize, encoding="utf-8") # 繪制文本draw.text((left, top), text, textColor, font=fontStyle)# 轉換回OpenCV格式return cv2.cvtColor(np.asarray(img), cv2.COLOR_RGB2BGR)def build_dir(out_dir):if not os.path.exists(out_dir):os.makedirs(out_dir,exist_ok=True)return out_dirif __name__ == "__main__":args = parser.parse_args()device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')transform = get_transform(image_size=args.image_size)#######load modelmodel = ram_plus(pretrained=args.pretrained,image_size=args.image_size,vit='swin_l')model.eval()model = model.to(device)total = sum(p.numel() for p in model.parameters()) # 統計個數print("模型參數總量: %.2f million\t" % (total / 1e6), " 以float32模型內存占用:%.2f M" % (total * 4 / 1e6))# 下面是推理file_root='/推理文件路徑/sam_test' # 這個是多個文件夾路徑save_file_path=build_dir('runs')for file_name in os.listdir(file_root):save_path=os.path.join(save_file_path,file_name)img_root=os.path.join(file_root,file_name)for img_name in os.listdir(img_root):img_path=os.path.join(img_root,img_name)image = transform(Image.open(img_path)).unsqueeze(0).to(device)res = inference(image, model)# print("Image Tags: ", res[0])# print("圖像標簽: ", res[1])img = cv2.imread(img_path)N=int(len(res[1])/2)r1 = res[1][:N]r2 = res[1][N:]# r3 = res[1][2*N:]img = cv2ImgAddText(img, r1, 40, 50, textColor=(255, 0, 0), textSize=20)img = cv2ImgAddText(img, r2, 40, 200, textColor=(255, 0, 0), textSize=20)# img = cv2ImgAddText(img, r2, 40, 300, textColor=(255, 0, 0), textSize=40)build_dir(save_path)cv2.imwrite(os.path.join(save_path, img_name), img)的時候發生了什么?)

可靠性)

)

)

其一,排隊的技術與算法)

)