論文題目:Uncertainty Modeling for Out-of-Distribution Generalization

論文來源:ICLR 2022

論文作者:

論文鏈接:https://arxiv.org/pdf/2202.03958

論文源碼:https://github.com/lixiaotong97/DSU

?

一、摘要

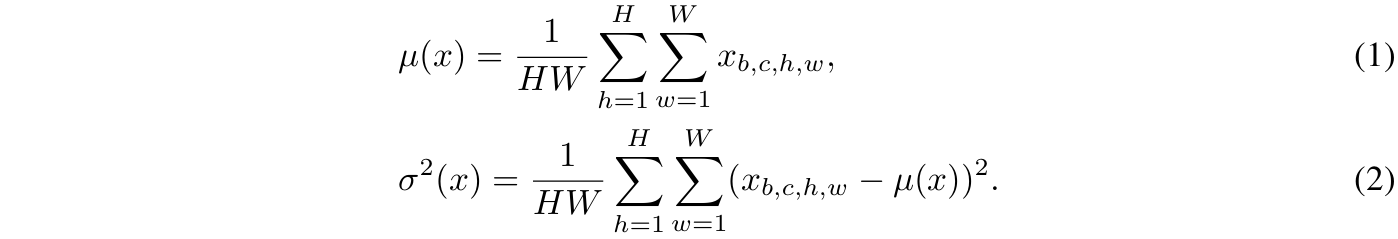

盡管深度神經網絡在多種視覺任務中取得了顯著進展,但在面對分布外(out-of-distribution)場景時,其性能仍然明顯下降。我們認為,特征統計量(均值和標準差)承載著訓練數據的領域特性,可以通過合理操控來提升模型的泛化能力。現有方法通常將這些統計量視為從特征中計算得到的確定性值,未能顯式考慮測試階段由潛在領域偏移引起的統計不確定性。本文提出在訓練階段通過建模領域偏移的不確定性來提升網絡的泛化能力。具體而言,我們假設特征統計量服從多元高斯分布,因此每個統計量不再是確定值,而是一個具有多種分布可能性的概率點。借助這種不確定特征統計量,模型可在訓練中緩解領域擾動,增強對潛在領域偏移的魯棒性。我們的方法可無縫集成到現有網絡中,無需引入額外參數或損失函數。大量實驗表明,該方法在多個視覺任務(包括圖像分類、語義分割和實例檢索)中持續提升模型的泛化性能。

二、Introduction

深度神經網絡在計算機視覺中表現卓越,但其成功嚴重依賴于"訓練與測試域服從獨立同分布"的假設(Ben-David et al., 2010; Vapnik, 1992)。然而,現實場景常違背該假設。例如:

- 在雨天/霧天環境部署晴天訓練的語義分割模型(Choi et al., 2021)

- 用照片訓練模型識別藝術畫作(Li et al., 2017)

此類??分布外部署場景??均會導致性能顯著下降。因此,??域泛化(Domain Generalization)?? ——提升模型在未知測試域上的魯棒性——成為關鍵問題。

??核心問題分析??:先前工作(Huang & Belongie, 2017; Li et al., 2021)表明,作為特征矩的??特征統計量(均值與標準差)?? 攜帶了訓練數據的領域特征(如照片風格、拍攝環境)。不同數據分布的域通常具有不一致的特征統計量(Wang et al., 2020b; Gao et al., 2021a)。主流深度學習方法遵循??經驗風險最小化(Empirical Risk Minimization)?? 原則(Vapnik, 1999),雖在訓練域表現良好,但??未顯式建模測試時統計差異的不確定性??,導致模型過擬合訓練域,對測試時的統計變化高度敏感。

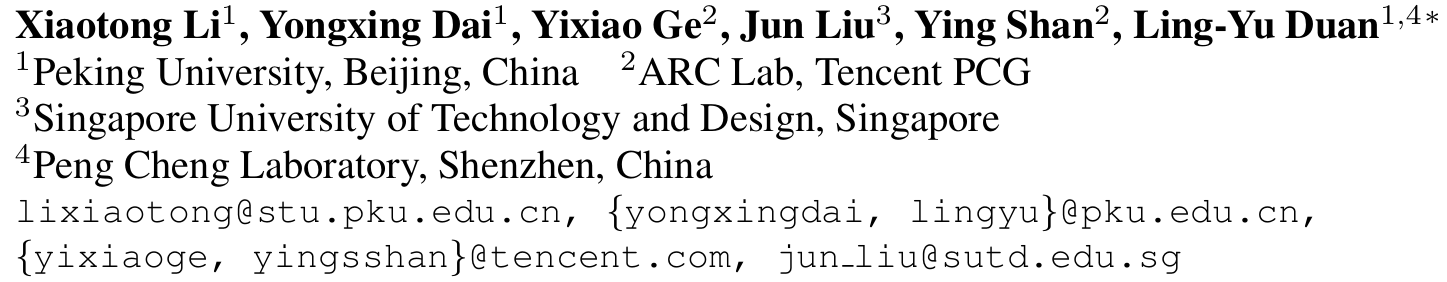

??解決方案動機??:測試域可能引發方向和強度均不確定的統計偏移(如圖1所示)。

??關鍵洞察??:通過合成特征統計量變體建模??域偏移的不確定性??,可提升網絡對不同測試分布的適應性。

本文提出??不確定性域偏移建模(Domain Shifts with Uncertainty, DSU)??:將特征統計量重新定義為??概率分布??(多元高斯分布),其中心為原始統計量,分布范圍表示潛在域偏移的變異強度。通過隨機采樣合成的統計量變體替代原始值,迫使模型學習域不變特征。

??方法優勢??:

- ??輕量化??,無額外參數,訓練階段插入,測試階段移除。

- ??通用性??,適用于圖像分類、分割、檢索等多種任務。

- ??有效性,實驗證明其顯著提升模型對域偏移的魯棒性。

三、相關工作

3.1 域泛化 (Domain Generalization)??

數據增強 (Data Augmentation)??

- 圖像級:AugMix(Hendrycks et al., 2020)、CutMix(Yun et al., 2019)

- 特征級:Mixup(Zhang et al., 2018)及其流形擴展Manifold Mixup(Verma et al., 2019)

- 統計量操作:MixStyle(Zhou et al., 2021b)對實例間統計量線性插值;pAdaIn(Nuriel et al., 2021)通過批次置換交換統計量

??不變表示學習 (Invariant Representation Learning)??

- 域對齊:最小化域間分布距離(Li et al., 2018b,c)

- 解耦表示:分離域特定/不變特征(Chattopadhyay et al., 2020; Piratla et al., 2020)

- 歸一化方法:通過標準化移除風格信息(Pan et al., 2018; Choi et al., 2021)

??學習策略 (Learning Strategies)??

- 集成學習:組合多樣化模型(Zhou et al., 2020b)或模塊(Seo et al., 2020)

- 元學習:模擬域偏移的元訓練范式(Finn et al., 2017; Li et al., 2018a)

- 自挑戰機制:如RSC(Huang et al., 2020)通過丟棄主導特征迫使模型學習通用表示

??3.2 深度學習中的不確定性 (Uncertainty in Deep Learning)??

- 數據不確定性:變分自編碼器(Kingma & Welling, 2013)建模隱空間不確定性

- 模型不確定性:Dropout(Srivastava et al., 2014)可作為貝葉斯近似(Gal & Ghahramani, 2016)

- 應用場景:處理噪聲標簽(DistributionNet)、人臉質量評估(DUL, PFE)

??本文創新??:首次將不確定性建模用于??特征統計量??,以解決分布外泛化問題,區別于前述方法。

四、方法

??4.1 預備知識

給定網絡中間層的特征張量

![]()

其中,B為批次大小,C為通道數,H和W為空間尺寸。我們定義每個實例在批次中的??通道級特征均值和標準差為

![]()

它們可通過以下等式計算得出

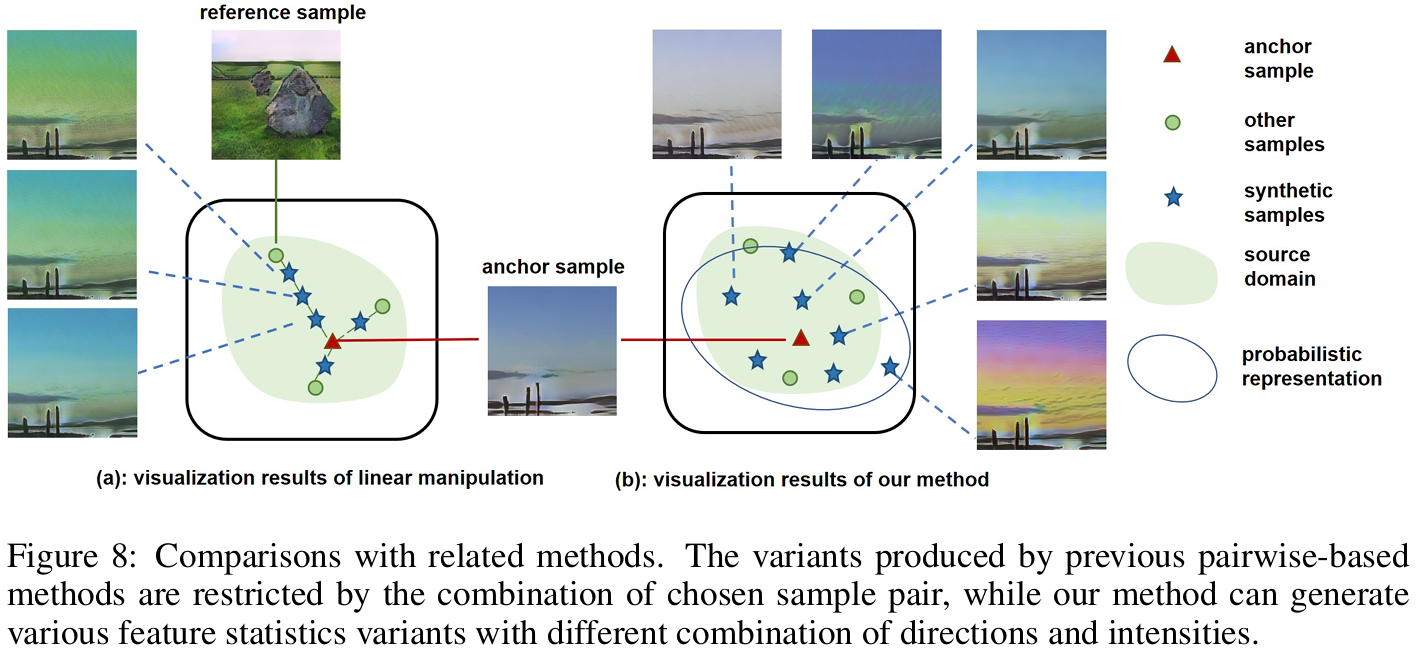

先前工作(Huang & Belongie, 2017; Li et al., 2021)表明,特征統計量可抽象化表征域的??關鍵特性??(如顏色、紋理、對比度)。在分布外場景中,不同域的統計量不一致性會削弱模型泛化能力(Wang et al., 2019a; Gao et al., 2021a)。現有方法(如MixStyle、pAdaIN)通過樣本間線性操作(交換或插值)生成新統計量,但受限于參考樣本的選擇,其生成的??變異方向與強度有限??,難以覆蓋真實域偏移的多樣性。

??4.2 不確定性域偏移建模

針對測試域特征統計量的??任意方向與強度偏移??(圖1),我們提出??不確定性域偏移建模(DSU)??:

假設每個特征統計量在考慮潛在不確定性后服從??多元高斯分布??,即均值μ和標準差σ分別服從

![]()

?和

![]()

分布中心為原始統計量,標準差Σ描述潛在偏移的不確定性范圍。

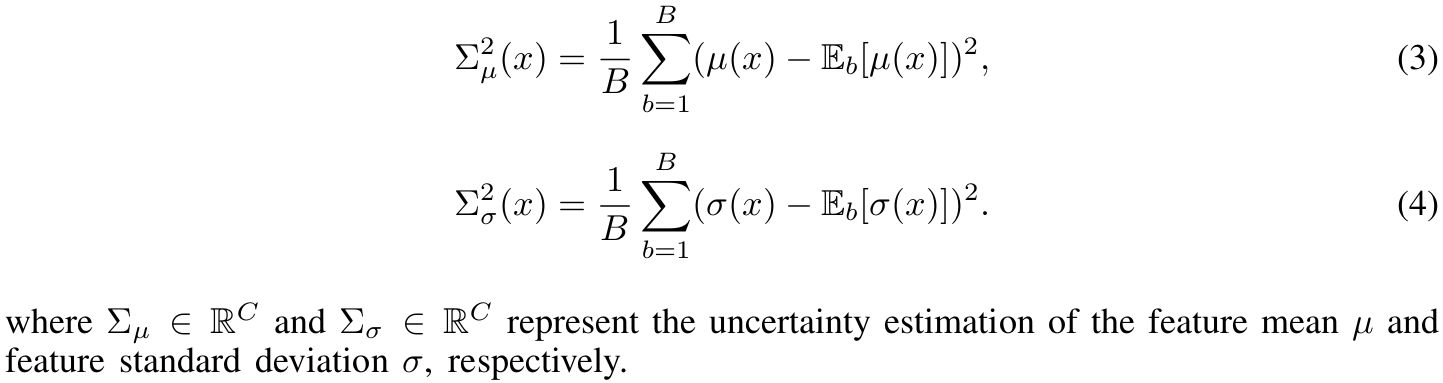

??4.2.1 不確定性估計

由于測試域未知,我們提出??非參數化估計方法??,利用批次統計量方差指導變異范圍:

這里的是指對batch維度求期望(均值),且

.

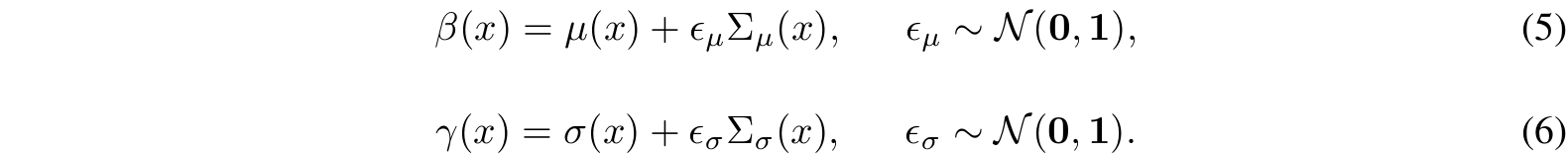

??4.2.2 特征統計量的概率分布

通過重參數化技巧(Kingma & Welling, 2013)從分布中采樣新統計量:

該操作生成方向和強度隨機組合的多樣化統計量變體。

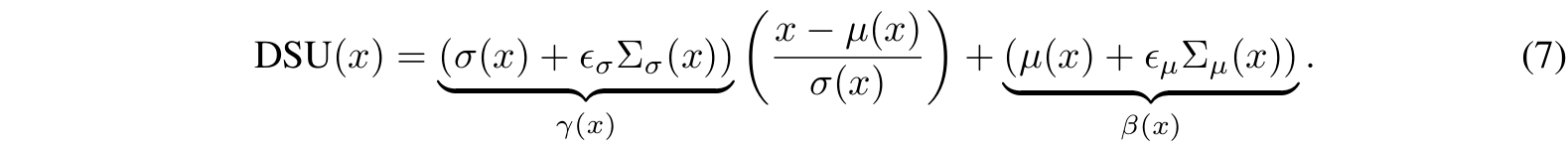

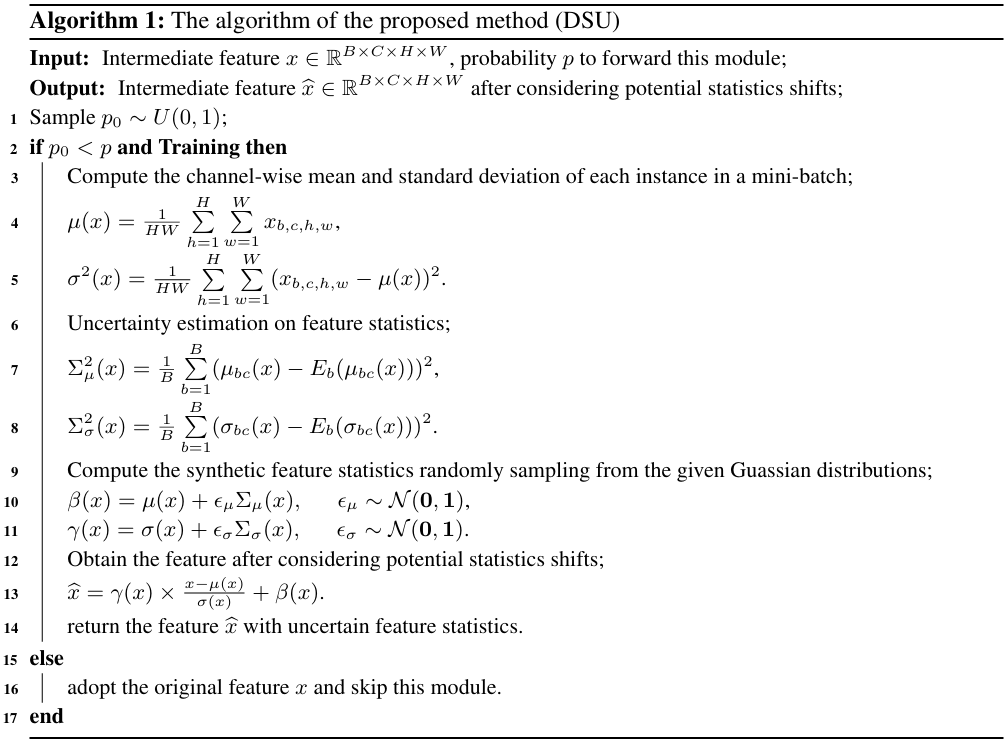

??4.2.3 實現

通過??自適應實例歸一化(AdaIN)??(Huang & Belongie, 2017)實現特征變換:

該模塊可插入網絡任意位置,??訓練時按概率p激活??,測試時移除。算法流程如下:

五、實驗

我們在多種視覺任務上驗證了所提出方法的有效性,包括圖像分類、語義分割、實例檢索以及對圖像損壞的魯棒性測試。這些任務的訓練和測試數據之間存在不同類型的分布偏移,例如風格變化、合成到現實的差距、場景變化和像素級損壞。

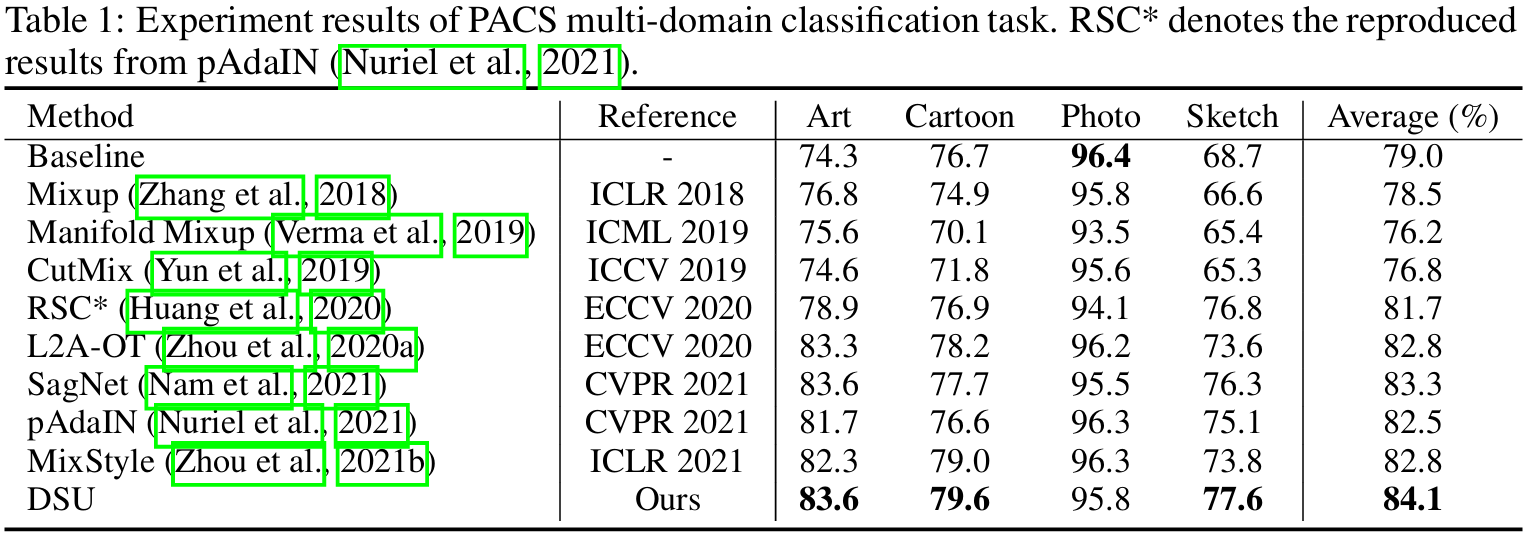

5.1 多領域分類任務

- 設置與實現細節:我們在PACS數據集上進行評估,該數據集包含四種風格:藝術畫(Art)、卡通(Cartoon)、照片(Photo)和素描(Sketch)。采用留一領域驗證協議(leave-one-domain-out),使用ResNet18作為骨干網絡,訓練設置與MixStyle一致。此外,我們還在Office-Home數據集上進行了實驗。

- 實驗結果:如表1所示,我們的方法相比基線方法有顯著提升,尤其是在Art和Sketch領域,平均準確率提升近10%。與現有方法(如 MixStyle、pAdaIN、SagNet 等)相比,DSU也表現出更強的泛化能力。

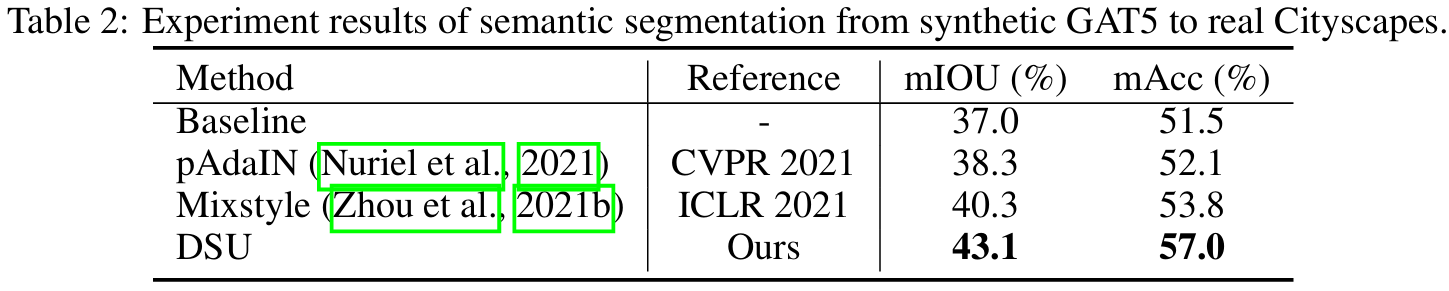

5.2 語義分割任務

- 設置與實現細節:使用合成數據集GTA5訓練,真實數據集Cityscapes測試。采用DeepLab-v2網絡(ResNet101骨干),評估指標為mIOU和mAcc。

- 實驗結果:如表2所示,DSU在mIOU和mAcc上分別提升了6.1%和5.5%,顯著優于基線和其他方法。可視化結果表明,DSU能更好地保留細節并適應真實場景。

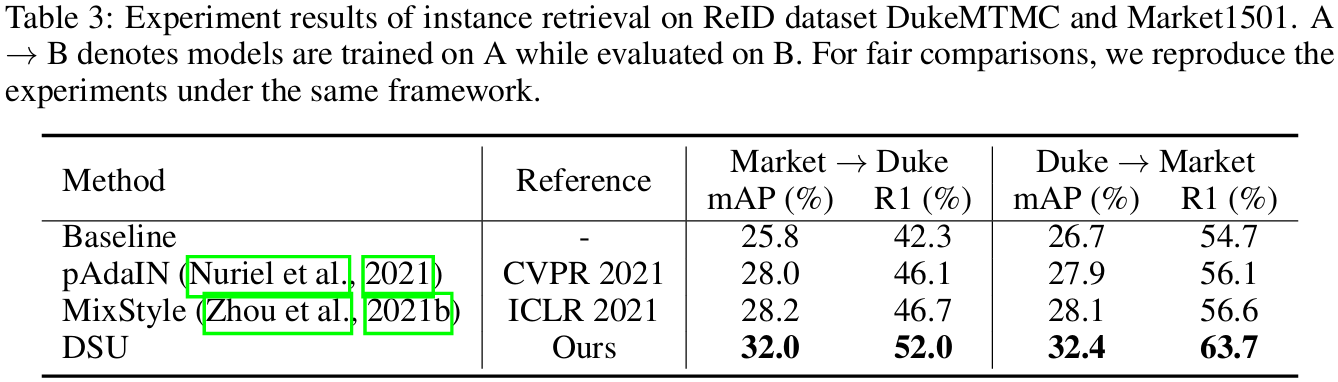

5.3 實例檢索任務

- 設置與實現細節:在DukeMTMC和Market1501數據集上進行跨域行人重識別實驗,使用ResNet50骨干網絡,評估指標為mAP和Rank-1準確率。

- 實驗結果:如表3所示,DSU在兩項指標上均顯著優于基線,并超越MixStyle和pAdaIN。這表明DSU在細粒度任務中也能有效保留關鍵信息并提升泛化能力。

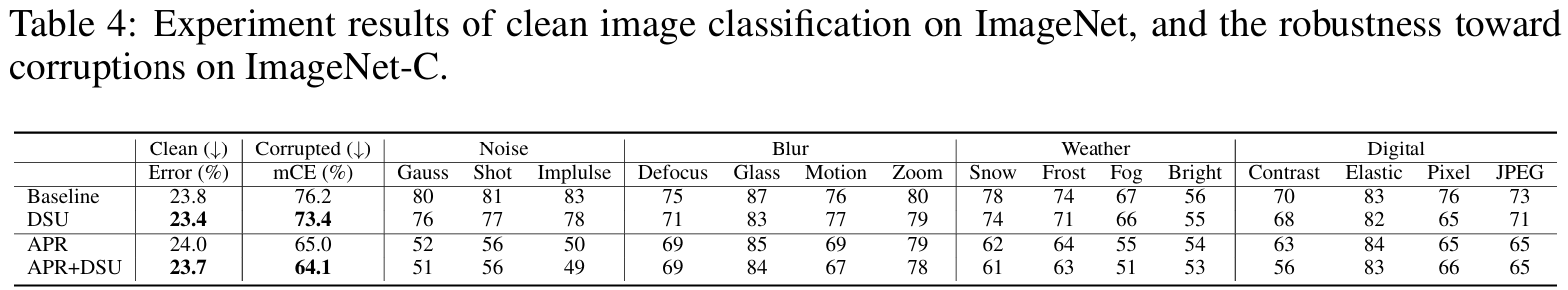

5.4 對圖像損壞的魯棒性

- 設置與實現細節:在ImageNet-C數據集上測試模型對15種圖像損壞的魯棒性,使用ResNet50骨干網絡,評估指標為Clean Error和mCE(平均損壞誤差)。

- 實驗結果:如表4所示,DSU在保持清潔圖像性能的同時,顯著提升了模型對損壞圖像的魯棒性。與APR方法結合后,mCE從65.0%降至64.1%,表明DSU可與其他增強方法兼容并進一步提升性能。

5.5 其它實驗

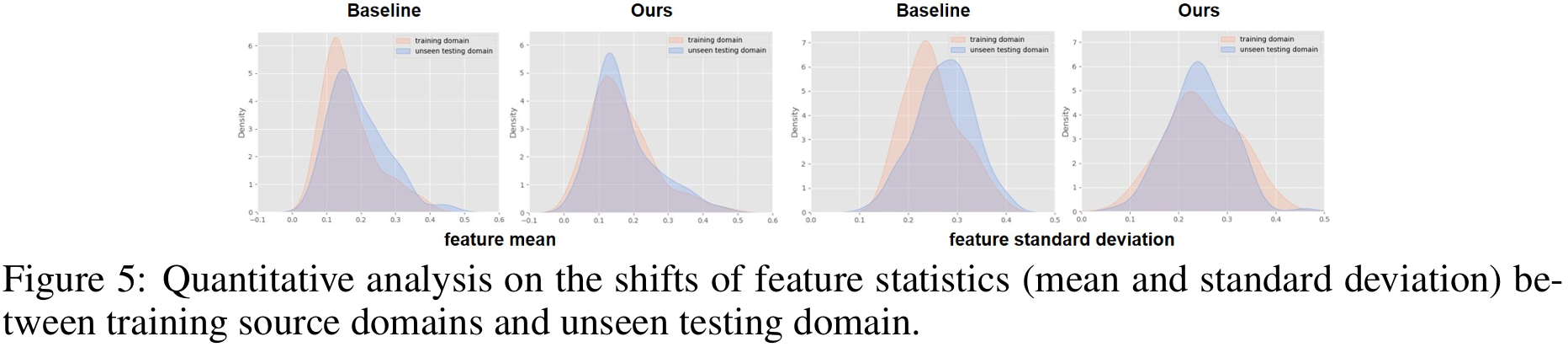

圖5定量對比了baseline與DSU模型在未見域上的特征統計量(均值+標準差)分布。DSU的分布明顯更靠近訓練域,說明其通過不確定性擾動有效抑制了統計偏移。

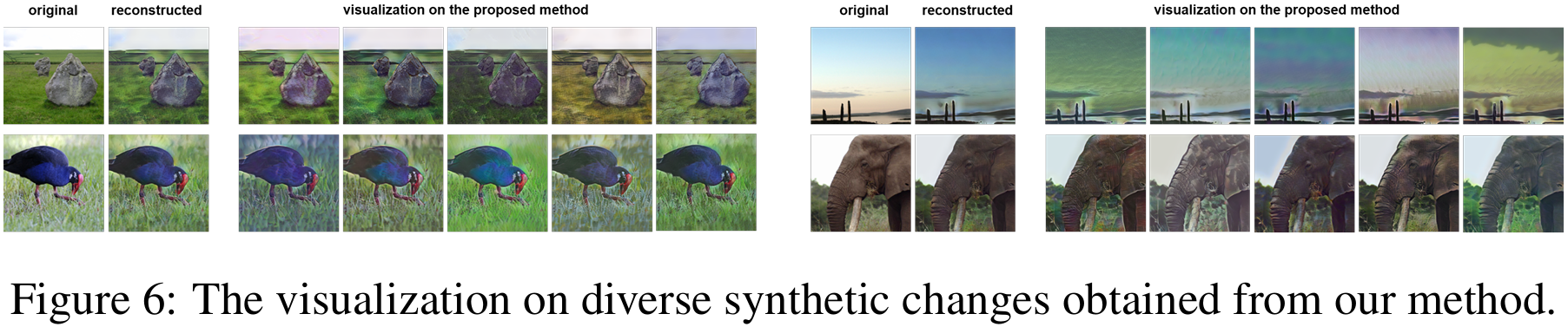

圖6用自編碼器把DSU擾動后的特征重建回圖像,展示同一輸入可生成多樣風格、紋理與對比度變化。這些可視化證實DSU能在特征空間產生豐富且合理的域偏移樣本,從而提升模型泛化能力。

圖8對比MixStyle/pAdaIN的線性插值或交換與DSU的多元高斯采樣:后者無需參考樣本即可生成方向與強度更豐富的特征統計變異,突破訓練域凸包限制。

六、結論

在本文中,我們提出了一種概率化的方法,通過在訓練階段建模領域偏移的不確定性,并利用合成的特征統計量來提升網絡的泛化能力。具體而言,我們假設每個特征統計量服從一個多元高斯分布,以建模各種潛在的偏移情況。由于生成的特征統計量具有多樣化的分布可能性,模型能夠對不同的領域偏移具備更好的魯棒性。實驗結果驗證了我們所提出方法在提升網絡泛化能力方面的有效性。

七、個人思考與理解

1. 不確定性是如何嵌入到模型的學習過程的?

不確定性來源:

- 小批統計量的通道方差

- 重參數化時注入的標準高斯噪聲

如何嵌入到模型:通過等式(7)對進行特征變換,然后使用變換后的統計量進行特征歸一化(類似AdaIN操作),于是不確定性就嵌入到模型的學習過程中。

2. DSU的本質是什么?

一種無參數的、非監督的、基于特征統計擾動的方法。

3. 與LLM的潛在結合之處有哪些?

- 特征統計擾動的泛化思想遷移:在Transformer中,LayerNorm也使用了均值和方差進行歸一化;可以嘗試對LayerNorm的統計量進行類似的“擾動建模”,增強模型對文本風格、領域變化的魯棒性。

- 不確定性建模用于提示學習(Prompt Learning):在soft prompt或continuous prompt中,prompt embedding可視為隨機變量;引入類似DSU的不確定性建模,增強prompt的泛化能力。

- 數據增強策略:在文本表示空間(如[CLS]向量或中間層表示)引入統計擾動,作為一種表示級數據增強;有助于提升模型在跨域文本(如新聞 vs 微博、正式 vs 口語)上的泛化能力。

- 對抗魯棒性提升:DSU的擾動機制可視為一種隱式對抗訓練;可用于提升LLM在面對輸入擾動(如拼寫錯誤、風格變化)時的魯棒性。

4. 重參數化是什么?

一種將隨機采樣操作轉化為可微表達式的技巧,支持梯度回傳。可以看一下博客:搞明重參數化。感覺說得還算清楚。

狀態管理深度解析:從Cookie+Session到JWT的演進之路)

詳解——建造者模式(1))

)