ETLCloud中如何使用Kettle組件在當今數據驅動的時代,數據處理和分析已成為企業決策的關鍵。為了更高效地處理海量數據,ETL(Extract, Transform, Load)工具變得至關重要。而在眾多ETL工具中,Kettle作為一款開源、靈活且功能強大的工具備受青睞。而在ETLCloud平臺上,可以通過Kettle組件的應用輕松實現各種復雜的數據處理任務。

一、靈活設計,隨心所欲的轉換流程

Kettle的核心優勢在于其圖形化的界面設計和豐富的轉換步驟。在ETLCloud中,您可以直接利用Kettle的轉換文件,從簡單的數據清洗、過濾、合并,到復雜的自定義腳本執行、數據加密解密等。這種高度的靈活性讓即便是復雜的數據轉換邏輯也能一目了然,易于管理和維護。

二、ETL中運用Kettle組件

我們這里先來使用 Kettle數據同步組件,這是ETLCLoud針對kettle轉換處理邏輯設計的組件,來了解一下兩個工具的特性。

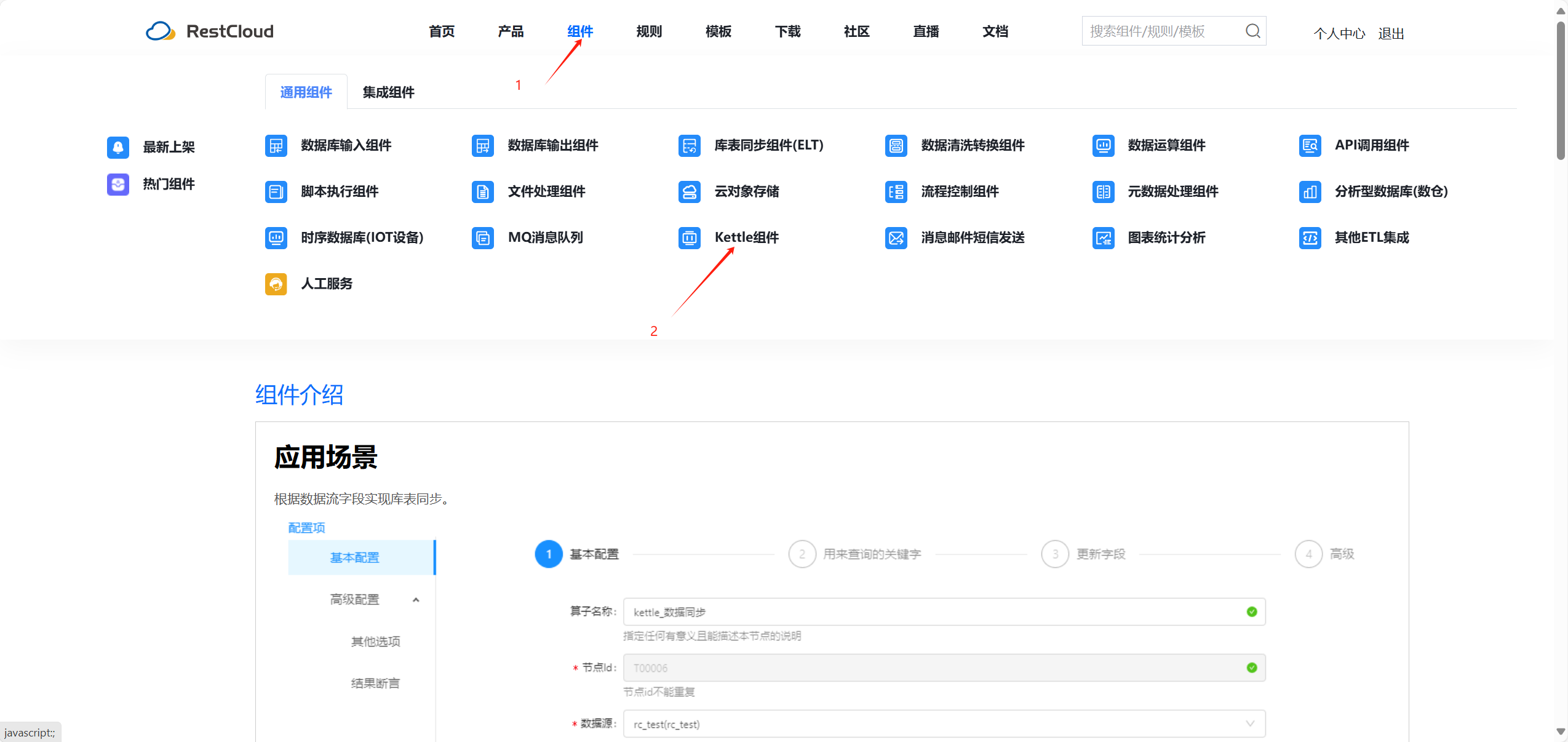

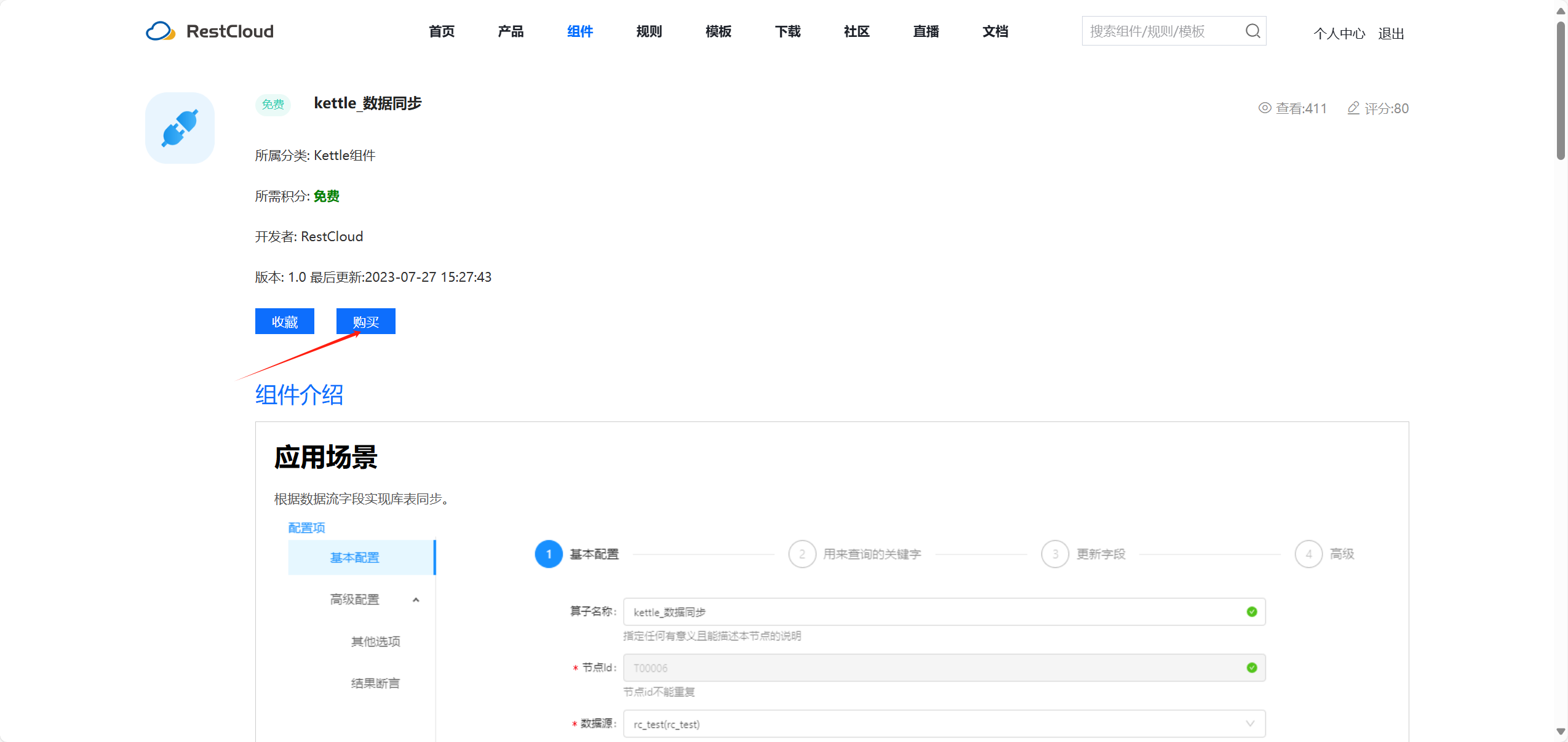

可以從ETLCLoud官網的Kettle分類下載該組件,也可以直接搜索kettle關鍵詞。下載安裝后,我們前往ETLCloud的流程設計界面,使用該組件。

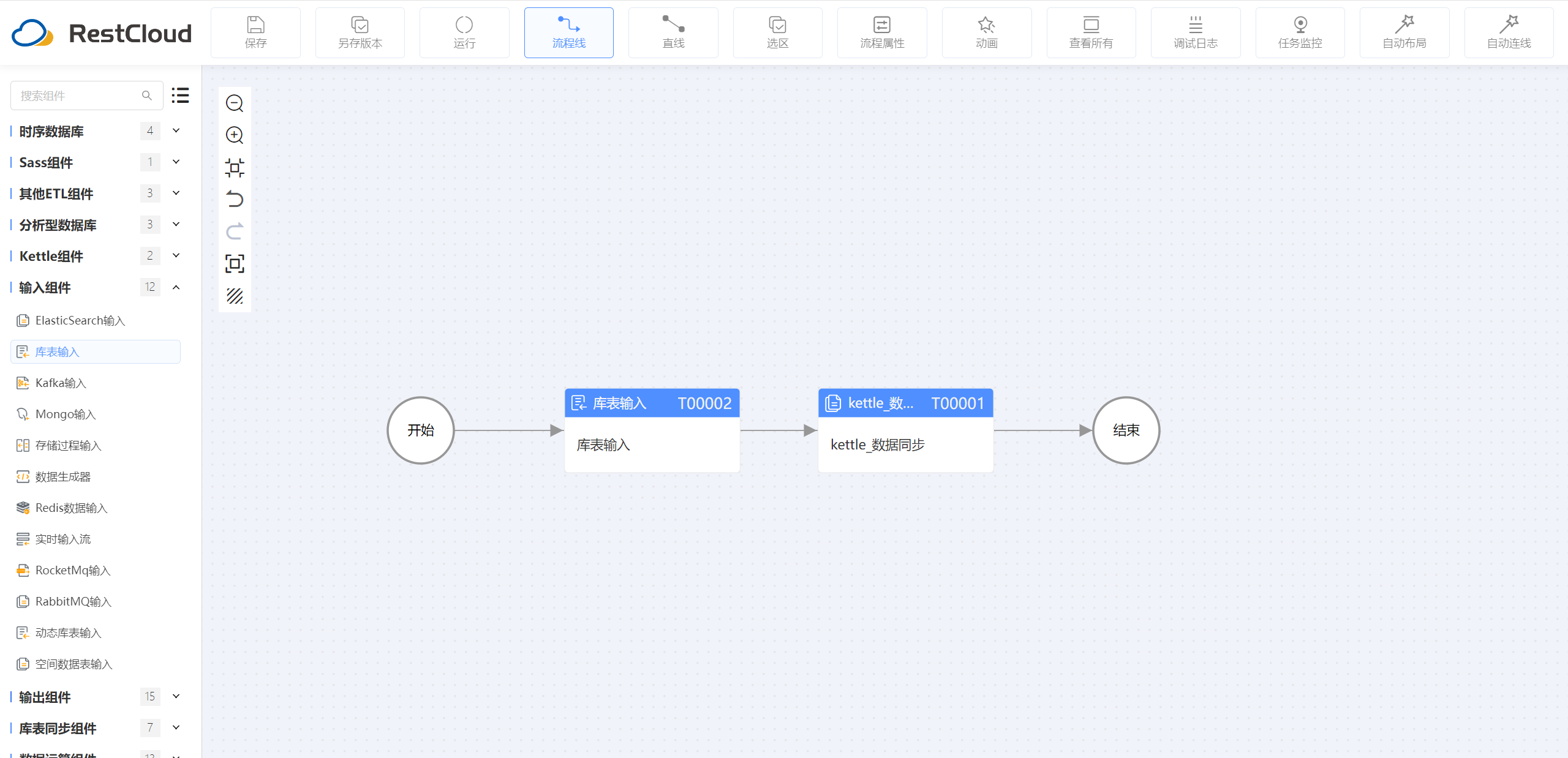

流程設計如下:

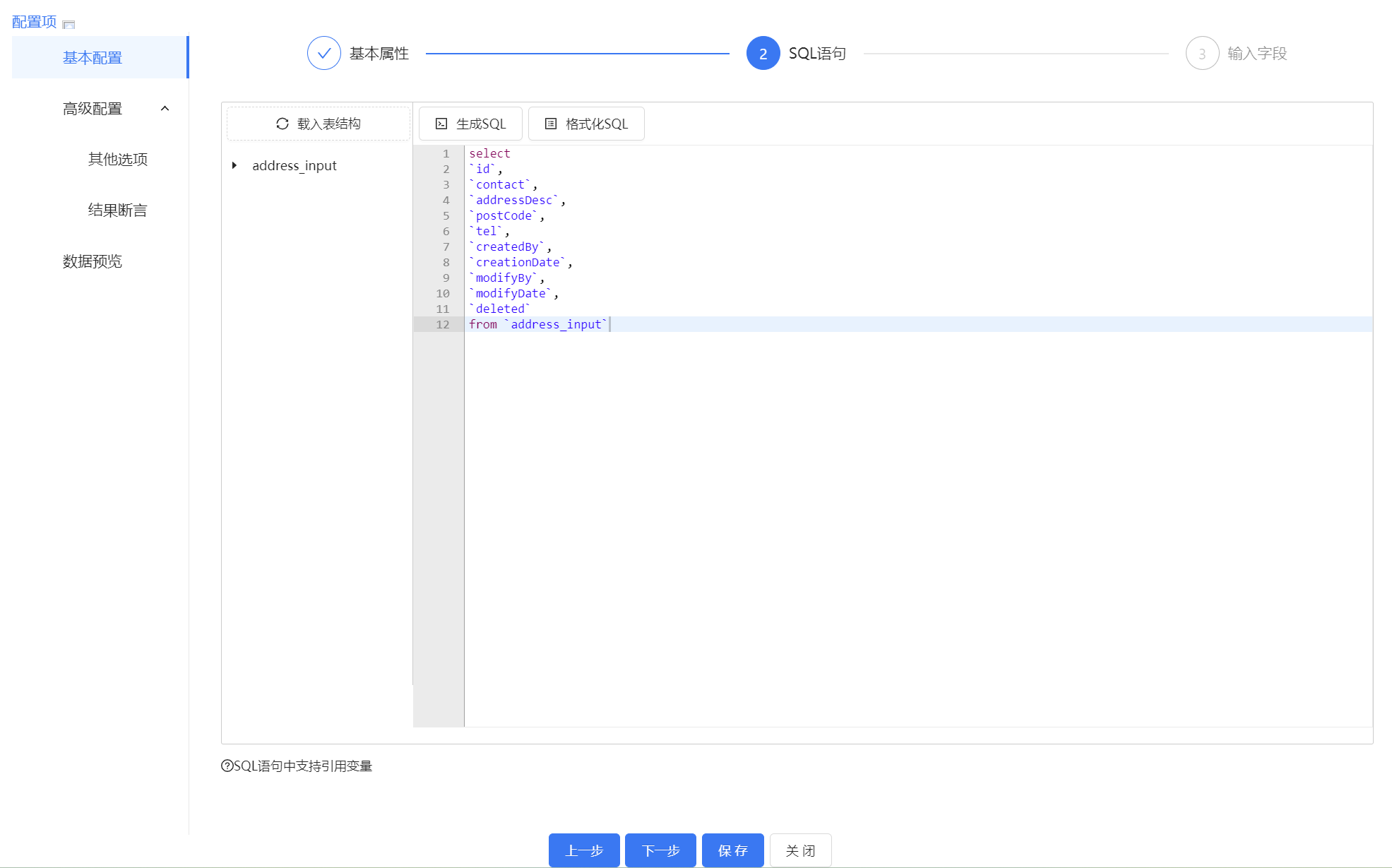

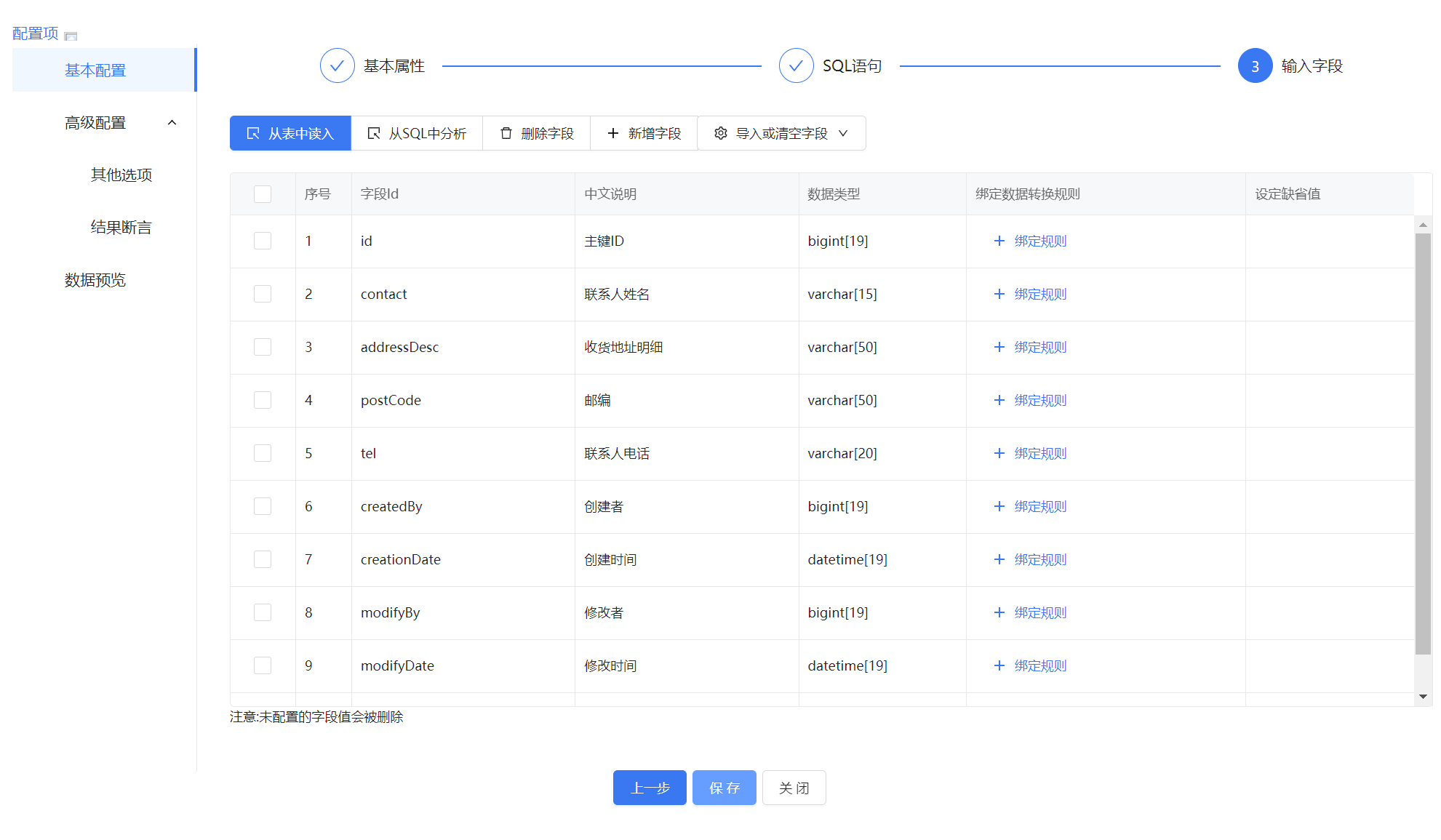

庫表輸入組件配置如下:

庫表輸入組件的作用,就是從配置的數據庫表中讀取數據到ETL平臺中進行處理。數據源相關的配置可以參考ETLCLoud官網的幫助文檔,這里重點說Kettle組件的配置。

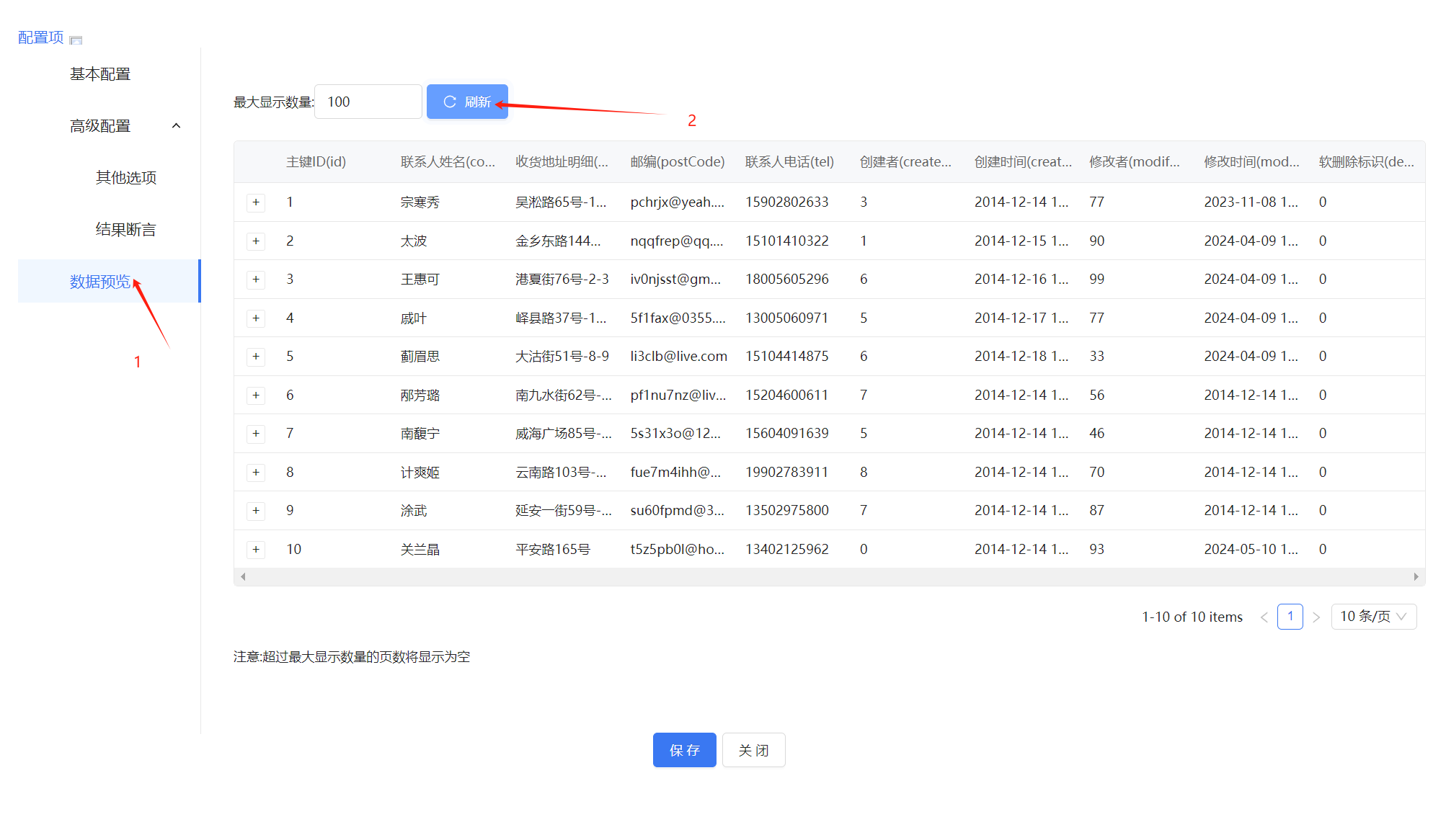

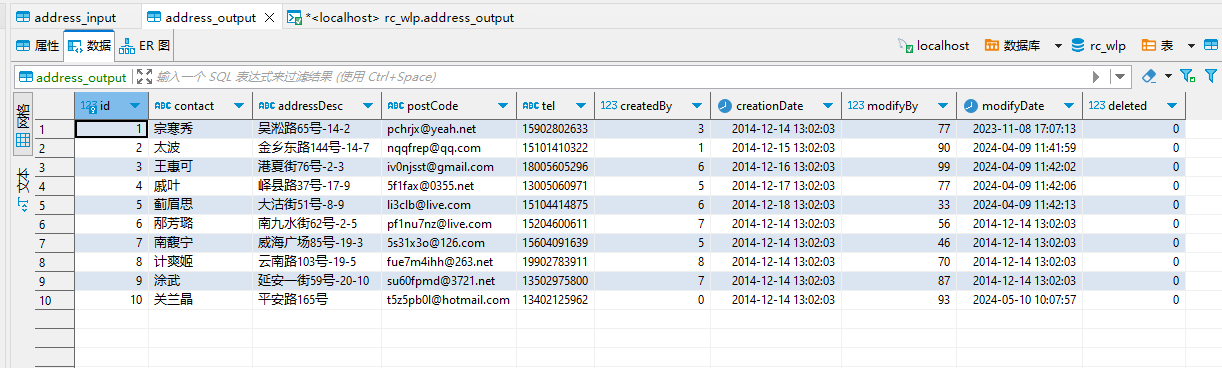

可以預覽源表的數據(本文所有數據都是由數據生成器生成的隨機數據,不涉及個人隱私):

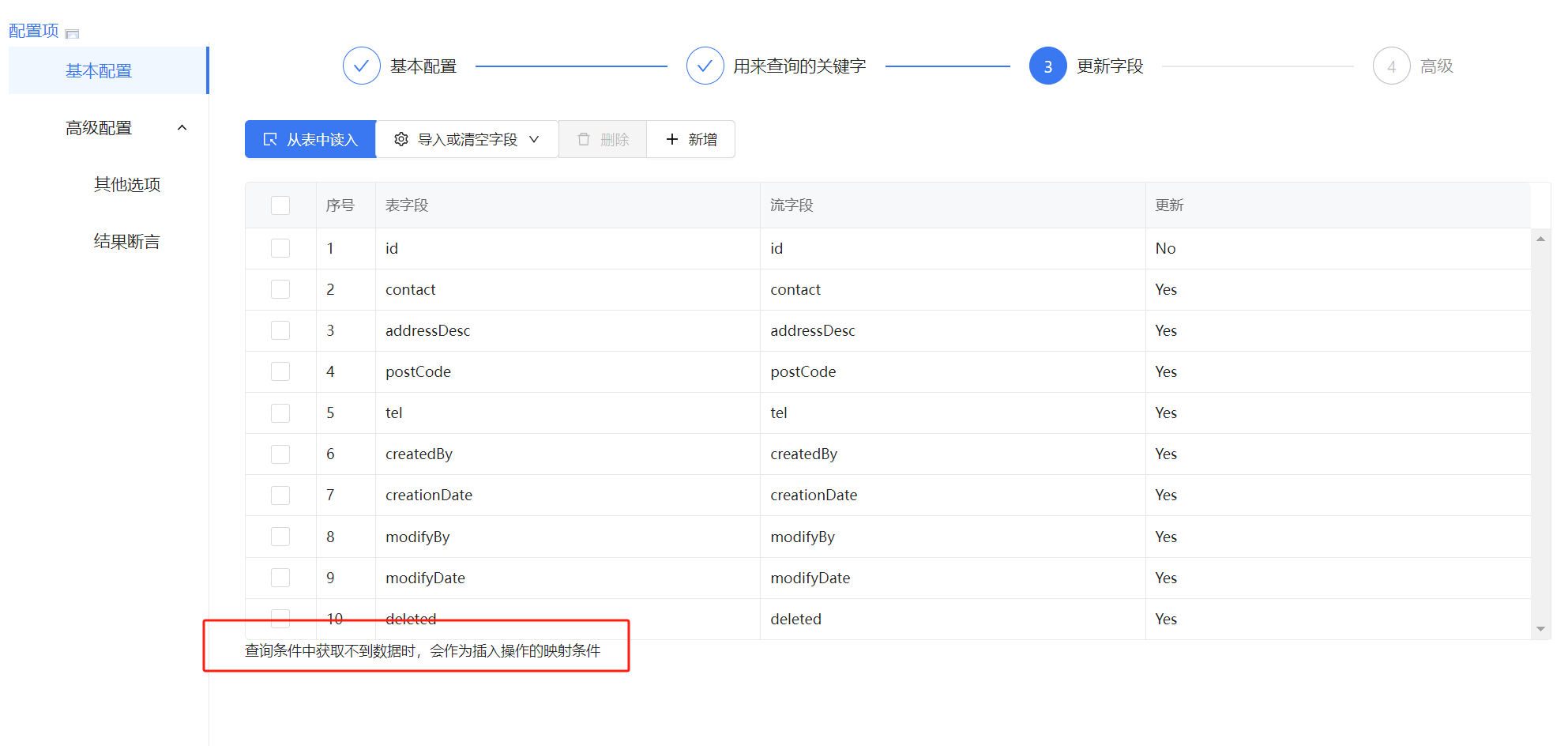

kettle_數據同步組件配置如下:

這里可以根據字段配置對插入數據進行對應操作:

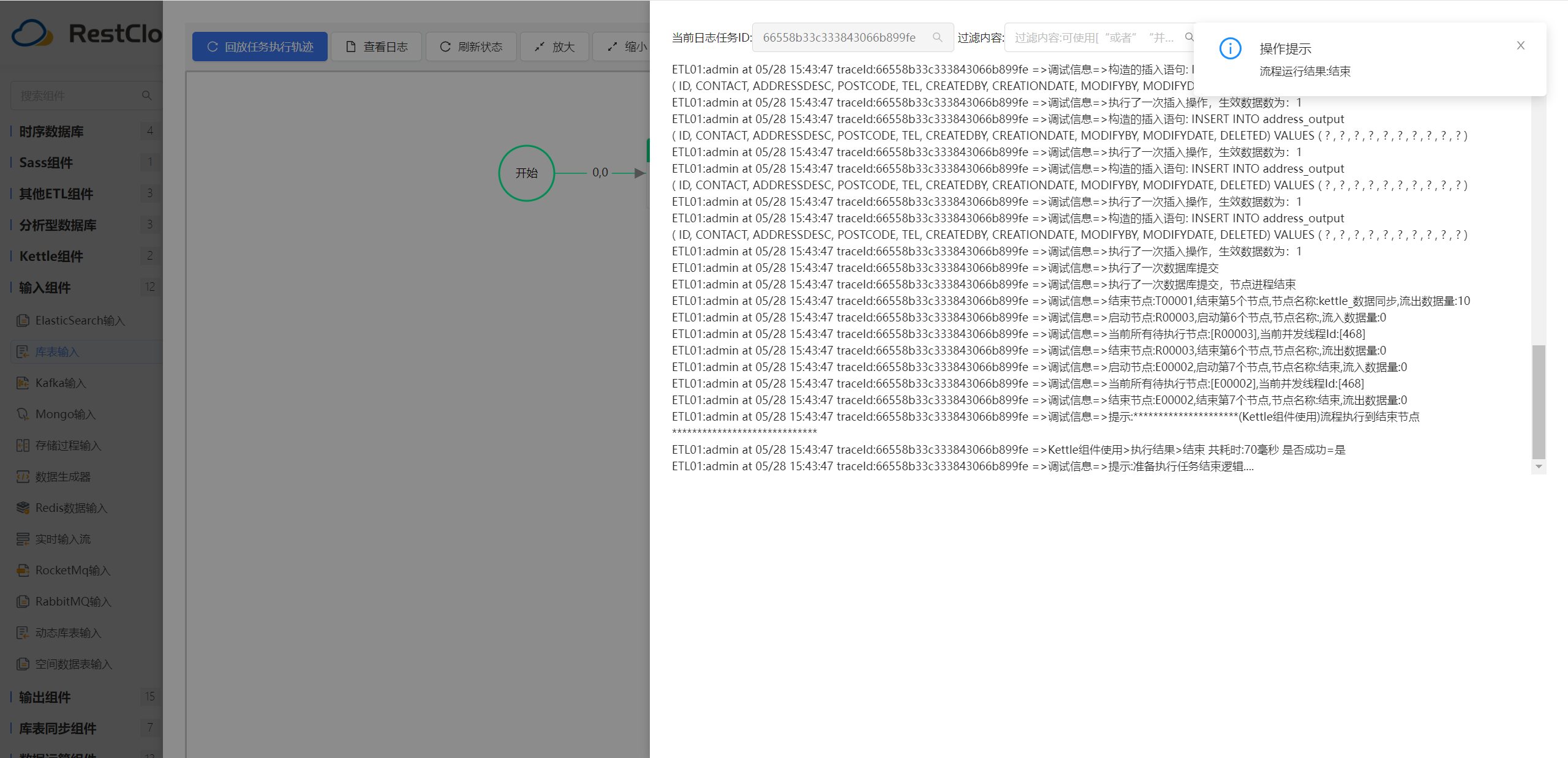

保存后,運行流程:

目標表數據:

如果習慣使用Kettle執行ETL業務,這個組件可以很好的符合Kettle的設計思想,并加快適應ETLCLoud工具的使用習慣。

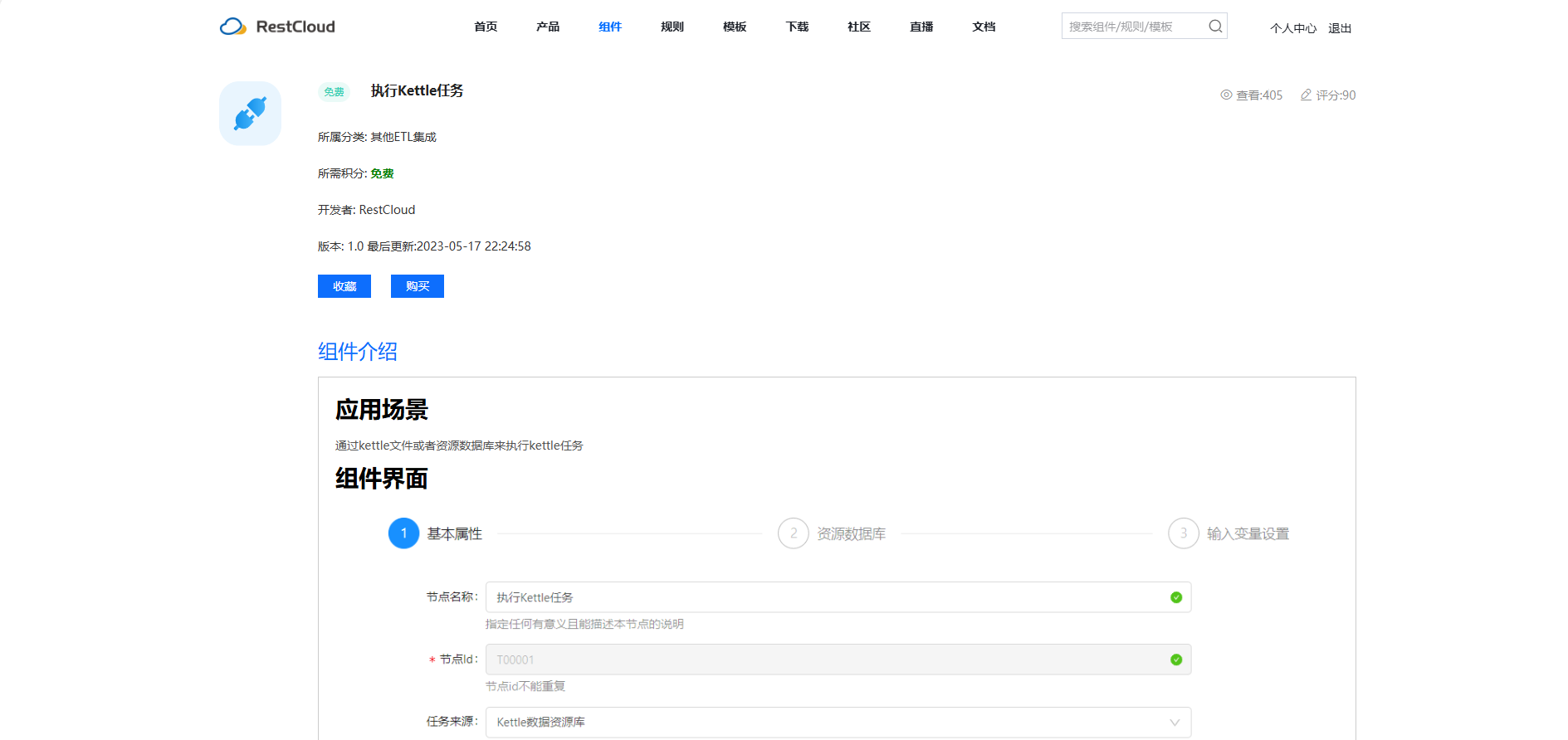

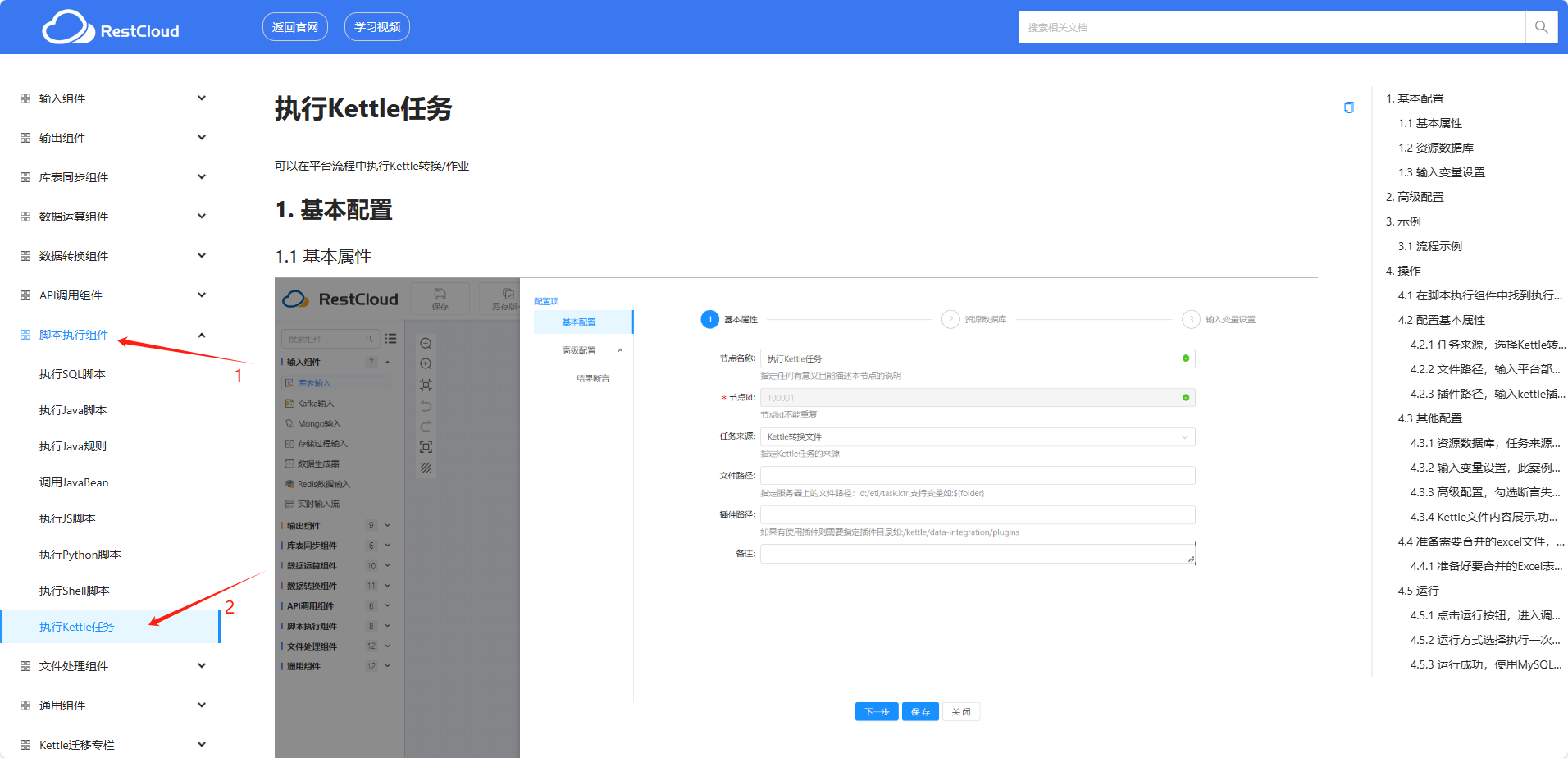

當然,如果想要在ETLCloud平臺上直接使用、運行Kettle的轉換作業文件,這也是支持的。只需要前往官網購買安裝 執行Kettle任務組件配置使用即可。

具體的使用案例,在官方幫助文檔中有詳細的演示:

通過使用 執行Kettle 任務組件,可以直接調度執行Kettle的kjb、ktr業務文件(需要服務端有Kettle插件),也是非常方便的。

三、結尾

借助ETLCloud的彈性計算能力,Kettle作業在ETLCLoud平臺的運行效率得到了顯著提升。平臺可根據任務負載自動分配資源,確保高并發下的穩定運行。此外,ETLCloud還支持任務調度與監控,您可以根據業務需求設定定時任務,自動化執行Kettle作業,同時實時監控作業運行狀態,一旦發現異常,立即觸發報警機制,確保數據處理的連續性和可靠性。

)

)