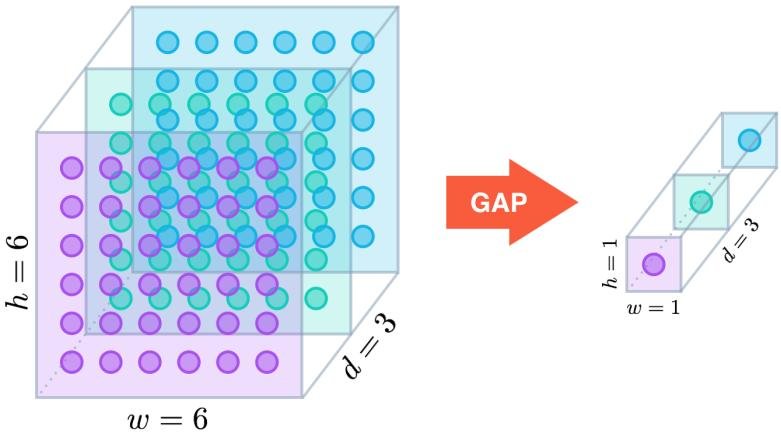

全局平均池化(Global Average Pooling, GAP)是一種用于卷積神經網絡(CNN)中的池化操作,其主要作用和優點包括:

-

減少參數數量:全局平均池化層將每個特征圖通過取其所有元素的平均值,壓縮成一個單一值。這有效地減少了模型中的參數數量,相比于全連接層,它不需要額外的權重參數,從而減小了模型的復雜度和過擬合的風險。

-

空間信息整合:通過對整個特征圖進行平均池化,全局平均池化能夠整合全局的空間信息,而不僅僅是局部的信息。這種整合方式可以更好地捕捉特征圖的全局特性。

-

避免過擬合:由于全局平均池化沒有額外的參數,可以減少模型的過擬合風險。這對處理數據量較少或復雜度較高的任務尤其有利。

-

位置不變性:全局平均池化對特征圖的輸入位置不敏感,主要關注的是特征的存在與否,而不是其具體位置。這種位置不變性在很多視覺任務中是有益的,特別是對于圖像分類任務。

-

簡化模型結構:全局平均池化可以作為卷積層和全連接層之間的橋梁,減少模型的層數和結構復雜性。例如,在經典的卷積神經網絡如ResNet中,GAP被用來替代傳統的全連接層,簡化了模型結構,并保持或提升了性能。

-

增強對類別特征的聚合:在分類任務中,GAP通過將每個類別的特征圖聚合成一個數值,使得網絡更直接地學習到每個類別的全局特征。這有助于提升分類性能。

通過這些作用,全局平均池化在現代卷積神經網絡中成為一種常用且有效的技術,尤其在深度網絡結構中如Inception和ResNet等,廣泛應用于分類任務中。

)

、表格(QTableWidget)與樹形(QTreeWidget)結構)

】)

)