ICLR 2025

- 盡管 LoRA 有諸多優勢,但近期研究表明,它在大規模訓練數據集和復雜任務(如數學推理和代碼生成)中,仍然落后于全參數微調(FFT)

- 一個合理的解釋是:低秩約束限制了 LoRA 的表達能力

- Biderman 等(2024)實證發現,FFT 所需的有效秩比典型的 LoRA 配置高出 10 到 100 倍

- Zeng 與 Lee(2024)則從理論上證明:Transformer 網絡若要逼近一個同規模的模型,其所需秩至少為模型維度的一半

- 盡管可訓練參數數量受限,導致表達能力受限,但近期研究仍然指出 LoRA 參數中存在冗余性

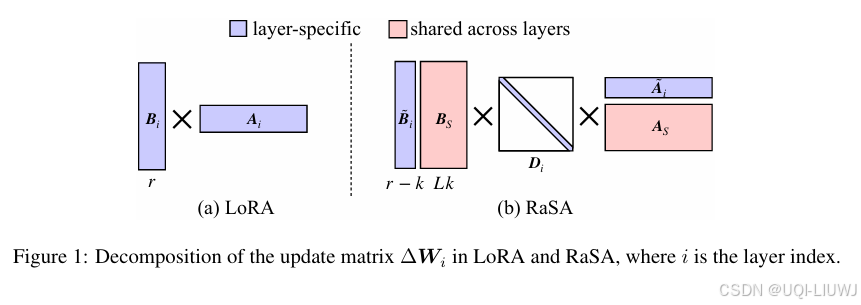

- ——>基于以上兩點觀察,論文提出了 Rank-Sharing Low-Rank Adaptation(RaSA),一種通過在層間部分共享秩來提升 LoRA 表達能力的方法

完整指南)

![[實戰]巴特沃斯濾波器全流程解析:從數學原理到硬件實現](http://pic.xiahunao.cn/[實戰]巴特沃斯濾波器全流程解析:從數學原理到硬件實現)

詳解 + Python實現)

安裝包免費免激活版下載 附圖文詳細安裝教程)

(補題))

![[Linux]git_gdb](http://pic.xiahunao.cn/[Linux]git_gdb)

)

)

的封裝)

)