精讀威斯康星大學綜述《Coreference Resolution: A Survey》,揭秘NLP中"實體鏈接"的核心技術

一、什么是共指消解?為什么它是NLP的基石?

共指消解(Coreference Resolution)?旨在識別文本中指向同一實體的不同表述。例如:

text

[李華]?昨天去了書店。[他]?買了[一本《深度學習》]?。[這本書]?的價格是100元。

標注說明:相同下標(如?)表示指向同一實體

核心價值:

問答系統:理解"他"指代誰

文本摘要:合并重復指代

知識圖譜:鏈接實體別名

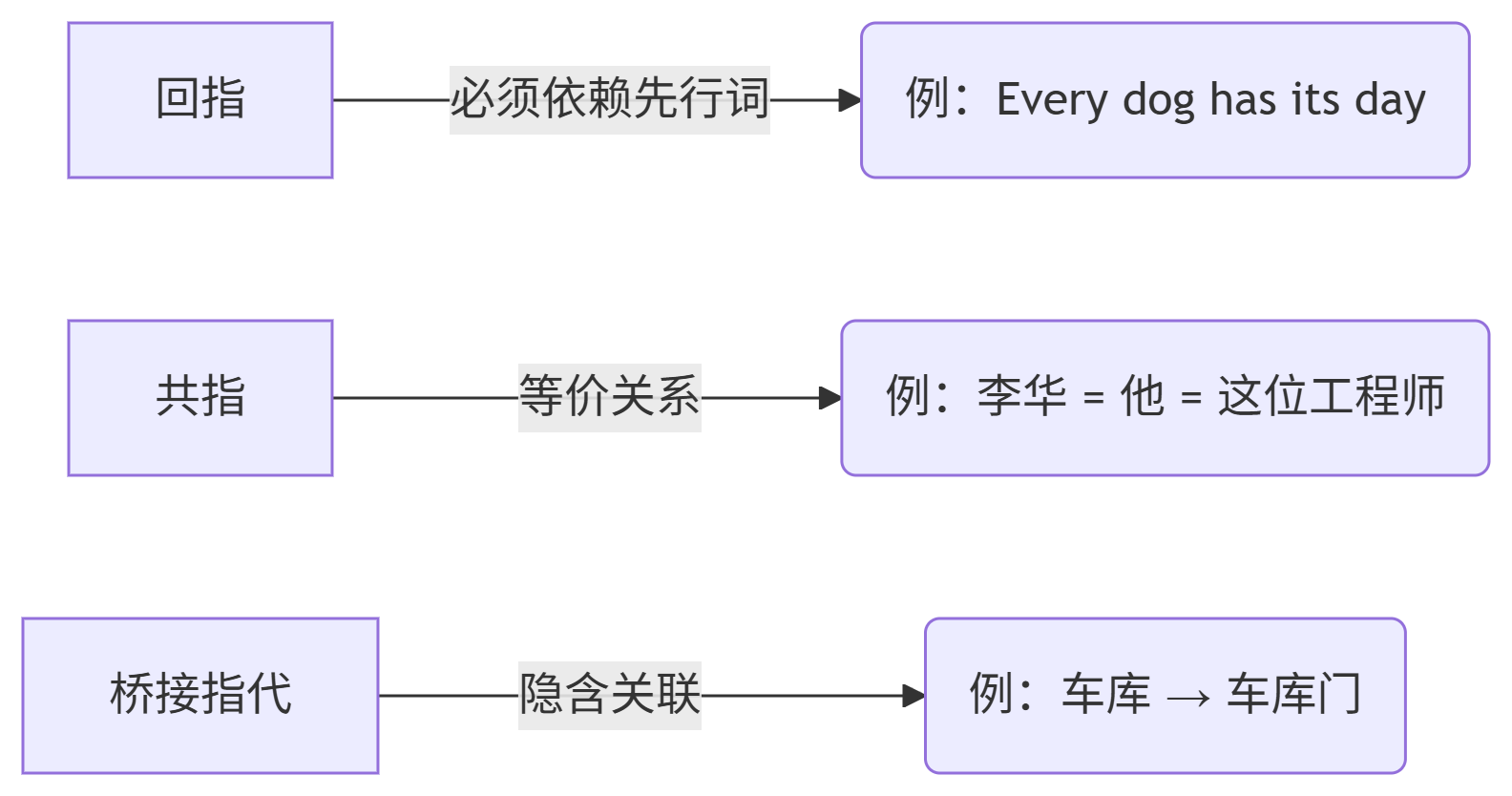

與回指(Anaphora)的區別(論文2.1節核心觀點):

二、語言學方法:規則驅動的早期探索

1. Hobbs算法(1976)

基于句法樹的遍歷策略:

優先在當前句廣度優先左向右搜索

滿足綁定約束(如代詞不能指代從句主語)

回溯前序句子(反向時序)

# 偽代碼實現(簡化版)

def hobbs_algorithm(pronoun, parse_tree):# 當前句內搜索for node in bfs_left_to_right(parse_tree.current_sentence):if match_constraints(node, pronoun):return node# 回溯前序句子for sent in reversed(previous_sentences):for node in bfs_left_to_right(sent.parse_tree):if match_constraints(node, pronoun):return nodereturn None2. 中心理論(Centering Theory)

動態追蹤文本焦點(論文2.2節核心模型):

前視中心(Cf)?:當前句的實體列表(按顯著性排序)

后視中心(Cb)?:上一句的核心焦點實體

狀態轉移:

延續(CONTINUE)?:Cb不變且是Cf中最顯著 →?最優

保持(RETAIN)?:Cb不變但非最顯著

轉移(SHIFT)?:Cb改變

📌?經典案例(論文2.2節示例):

“Terry犯錯”→“他興奮”→“他邀請Tony”→“他6點打電話”→“他生病了”

最后一句的"他"指代Tony(焦點轉移),需領域知識才能解析

三、機器學習方法:數據驅動的現代突破

1. 特征工程進化史

| 特征類型 | 代表特征 | 論文章節 |

|---|---|---|

| 基礎屬性 | 距離、性別、數一致性 | 3.1 |

| 句法特征 | 語法角色(主語/賓語) | 3.2 |

| 語義特征 | WordNet路徑相似度 | 3.2 |

| 別名特征 | "奧巴馬" ≈ "Barack Obama" | 3.2 |

2. 三大主流模型對比

| 模型 | 核心思想 | F1@MUC-6 | 優勢 |

|---|---|---|---|

| 決策樹(Soon et al.) | 指代對二分類 | 68.2% | 特征可解釋性強 |

| 條件隨機場(CRF) | 建模指代鏈全局依賴 | 73.0% | 解決傳遞依賴(A=B,B=C?A=C) |

| 聚類方法(Cardie) | 無監督NP聚類 | 65.8% | 避免三角矛盾 |

3. 橋接指代解析創新方案

解決隱含關聯問題(如"車庫→門"):

網絡挖掘:搜索共現模式(論文2.6節)

python

# 基于搜索引擎的關聯度計算

def bridging_score(phrase1, phrase2):query = f"\"{phrase1} and {phrase2}\""results = search_engine(query)return results.count / MAX_RESULTS知識庫補全:WordNet擴展(論文3.4節)

四、領域差異:文體如何影響指代分布?

關鍵發現:

新聞報道:專有名詞占比高(22.2%)

小說:代詞占比超30%

學術文本:7.25%代詞(需長距離消解)

💡?實踐建議:

新聞領域優先優化命名實體鏈接,小說領域需強化代詞解析

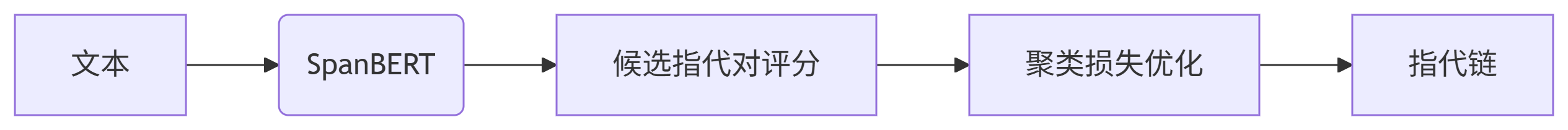

五、2025技術銜接:從傳統方法到SOTA模型

?

?

低資源解決方案:

半監督學習:協同訓練(論文3.6節)

提示學習:

[PRO]他[MASK]指代誰?

中文場景挑戰:

零指代問題:"? 去了書店"(省略主語)

解決方案:清華ChineseBERT+規則后處理

六、實用工具與復現推薦

# 主流工具庫

pip install allenai-allennlp # 包含端到端共指模型

pip install stanza # 支持中文共指消解# 論文復現代碼

git clone https://github.com/msg-systems/corefhub訓練建議:

# 添加領域自適應層(針對中文小說)

model.add_adapter("chinese_novel")

model.train_adapter("chinese_novel")參考文獻

Elango P. (2006). Coreference Resolution: A Survey.?University of Wisconsin-Madison

延申閱讀

[SpanBERT: Improving Pre-training by Representing and Predicting Spans]

[CorefQA:基于問答的共指消解框架]

博主總結:共指消解是NLP的"實體鏈接器",需結合語言學規則與深度學習。選擇方案時務必考慮領域特性!

歡迎在評論區交流指代消解實戰問題 👇

【#NLP避坑指南】【#指代消解論文精讀】

)

)

模型)

答疑解惑)

)

)

)