Change Data Capture (CDC) 是一種高效的數據同步技術,能夠捕獲數據庫的變更(插入、更新、刪除)并實時傳輸到其他系統。結合 Kafka Connect,我們可以構建一個可靠、可擴展的 CDC 管道,實現數據庫與數據湖、數據倉庫或消息隊列的無縫集成。

本文將介紹:

- CDC 的基本概念 及其應用場景

- Kafka Connect 的架構 及其在 CDC 中的作用

- Debezium 作為 CDC 工具 的工作原理

- 完整示例:如何使用 Kafka Connect + Debezium 捕獲 MySQL 變更并寫入 Kafka

- 最佳實踐 與常見問題

1. Change Data Capture (CDC) 簡介

什么是 CDC?

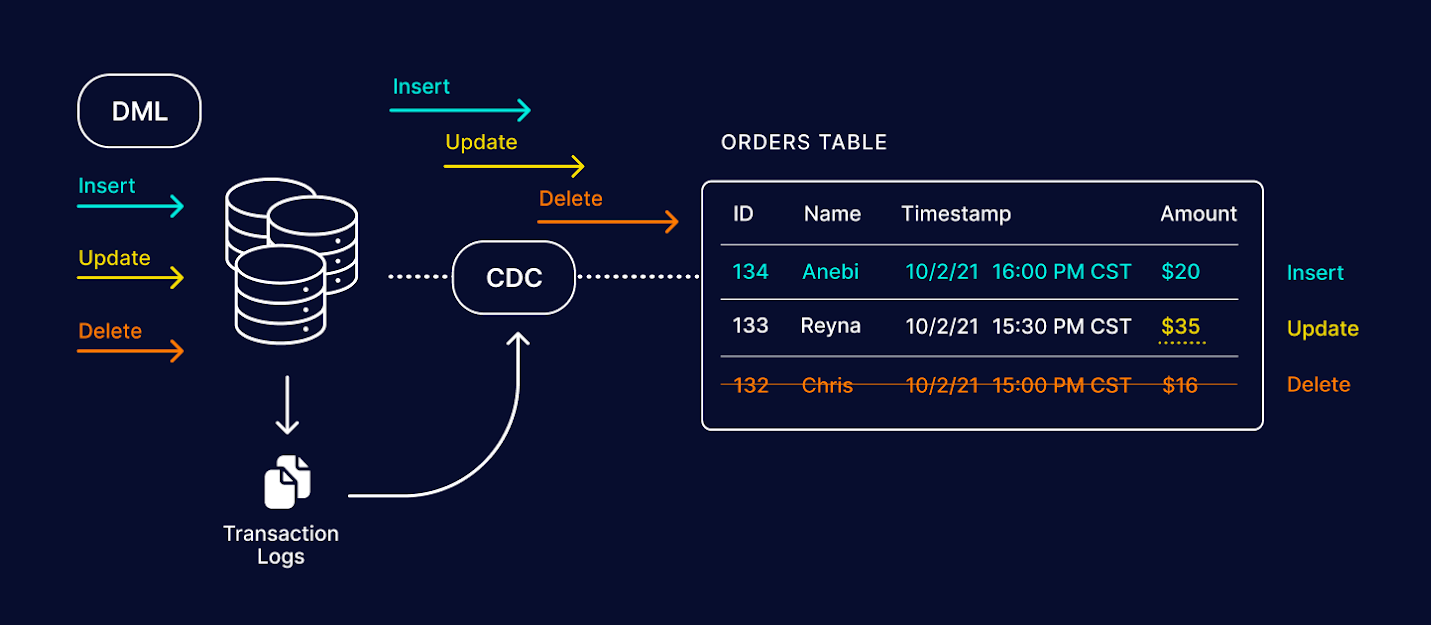

CDC 是一種實時數據變更捕獲技術,它監聽數據庫的日志(如 MySQL 的 binlog、PostgreSQL 的 WAL),提取變更事件(INSERT/UPDATE/DELETE),并將其傳輸到下游系統(如 Kafka、數據倉庫、搜索引擎等)。

CDC 的典型應用場景

- 實時數據分析:將數據庫變更同步到數據湖或數據倉庫(如 Snowflake、BigQuery)

- 事件驅動架構:數據庫變更觸發下游微服務處理(如訂單狀態更新觸發通知)

- 緩存更新:數據庫變更自動更新 Redis 或 Elasticsearch

- 數據備份與同步:跨數據中心或云環境的數據同步

2. Kafka Connect 與 CDC

Kafka Connect 是什么?

Kafka Connect 是 Apache Kafka 的數據集成框架,提供Source Connector(從外部系統讀取數據)和Sink Connector(將數據寫入外部系統)的能力。

Kafka Connect 在 CDC 中的角色

- Source Connector(如 Debezium)從數據庫捕獲變更并寫入 Kafka

- Sink Connector 將 Kafka 中的數據寫入目標系統(如 Elasticsearch、Snowflake)

Kafka Connect 的優勢:

? ??分布式 & 可擴展??:支持多 Worker 并行處理

? ??插件化架構??:支持數百種 Connector(如 MySQL、PostgreSQL、MongoDB)

? ??容錯 & 恢復??:自動記錄偏移量(offset),故障后可恢復

3. Debezium:開源 CDC 工具

Debezium 是什么?

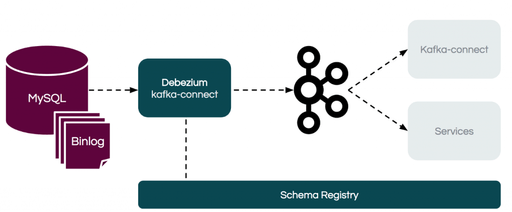

Debezium 是一個開源的 CDC 平臺,基于 Kafka Connect 構建,支持多種數據庫(MySQL、PostgreSQL、MongoDB、SQL Server 等)。

Debezium 的工作原理

- 監聽數據庫日志(如 MySQL 的 binlog)

- 解析變更事件(INSERT/UPDATE/DELETE)

- 轉換為 Kafka 消息(JSON 或 Avro 格式)

- 寫入 Kafka Topic(每個表對應一個 Topic)

4. 完整示例:MySQL CDC + Kafka Connect

環境準備

- MySQL(啟用 binlog)

- Kafka(單節點或集群)

- Zookeeper(Kafka 依賴)

- Kafka Connect(支持 Debezium Connector)

步驟 1:配置 MySQL 啟用 binlog

在 MySQL 配置文件(my.cnf)中啟用 binlog:

[mysqld]

server-id=1

log-bin=mysql-bin

binlog-format=ROW

binlog-row-image=FULL

重啟 MySQL 使配置生效。

步驟 2:啟動 Kafka & Zookeeper

# 啟動 Zookeeper

bin/zookeeper-server-start.sh config/zookeeper.properties# 啟動 Kafka

bin/kafka-server-start.sh config/server.properties

步驟 3:啟動 Kafka Connect

bin/connect-distributed.sh config/connect-distributed.properties

步驟 4:部署 Debezium MySQL Connector

向 Kafka Connect 提交 Connector 配置(JSON 格式):

{"name": "mysql-connector","config": {"connector.class": "io.debezium.connector.mysql.MySqlConnector","tasks.max": "1","database.hostname": "localhost","database.port": "3306","database.user": "debezium","database.password": "password","database.server.id": "184054","database.server.name": "mysql-server","database.include.list": "inventory","table.include.list": "inventory.products","database.history.kafka.bootstrap.servers": "localhost:9092","database.history.kafka.topic": "schema-changes.inventory"}

}

通過 Kafka Connect REST API 提交:

curl -X POST -H "Content-Type: application/json" \--data @mysql-connector.json http://localhost:8083/connectors

步驟 5:驗證 CDC 數據

-

在 MySQL 中插入數據:

INSERT INTO inventory.products (name, description) VALUES ('Laptop', 'High-performance laptop'); -

在 Kafka 中消費變更事件:

bin/kafka-console-consumer.sh \--bootstrap-server localhost:9092 \--topic mysql-server.inventory.products \--from-beginning輸出示例:

{"before": null,"after": {"id": 1001,"name": "Laptop","description": "High-performance laptop"},"source": {"version": "1.9.6.Final","connector": "mysql","name": "mysql-server","ts_ms": 1630000000000,"table": "products","db": "inventory","server_id": 1,"gtid": null,"file": "mysql-bin.000003","pos": 456,"row": 0,"thread": 1,"query": null},"op": "c","ts_ms": 1630000000123 }op: "c"表示 INSERT 操作after包含變更后的數據

5. 最佳實踐與常見問題

最佳實踐

? 啟用 binlog:確保數據庫配置正確(MySQL 需 binlog-format=ROW)

? ??合理分區??:Kafka Topic 分區策略影響并行消費能力

? ??監控延遲??:使用 Kafka Lag 監控工具(如 Burrow、Confluent Control Center)

? ??數據轉換??:使用 Kafka Connect 的 ??Single Message Transform (SMT)?? 過濾或修改數據

常見問題

? 問題:Kafka Connect 無法連接 MySQL

? ??解決??:檢查 MySQL 用戶權限(需 REPLICATION SLAVE 權限)

? 問題:CDC 數據丟失

? ??解決??:確保 Kafka 和 Connect 的 offsets 正確持久化

? 問題:性能瓶頸

? ??解決??:增加 Kafka Partition 數量,優化 Connector 并行度

總結

Change Data Capture (CDC) 結合 Kafka Connect 是構建實時數據管道的強大方案。通過 Debezium 捕獲數據庫變更,并利用 Kafka 的高吞吐能力,我們可以實現:

? ??實時數據同步??(數據庫 → 數據倉庫/搜索引擎)

? ??事件驅動架構??(數據庫變更觸發下游處理)

? ??可靠的數據備份??(跨數據中心同步)

無論是構建實時數據分析平臺,還是實現微服務間的事件驅動通信,CDC + Kafka Connect 都是值得考慮的解決方案。

部署 MySQL 操作流程)

-day25)

)