目錄

windows dify:

ollma 配置

ollma下載地址:

qwen3 模型下載

這個自動下載,下載后自動運行。?

配置環境變量:修改監聽后很慢

測試命令:

模型配置url:

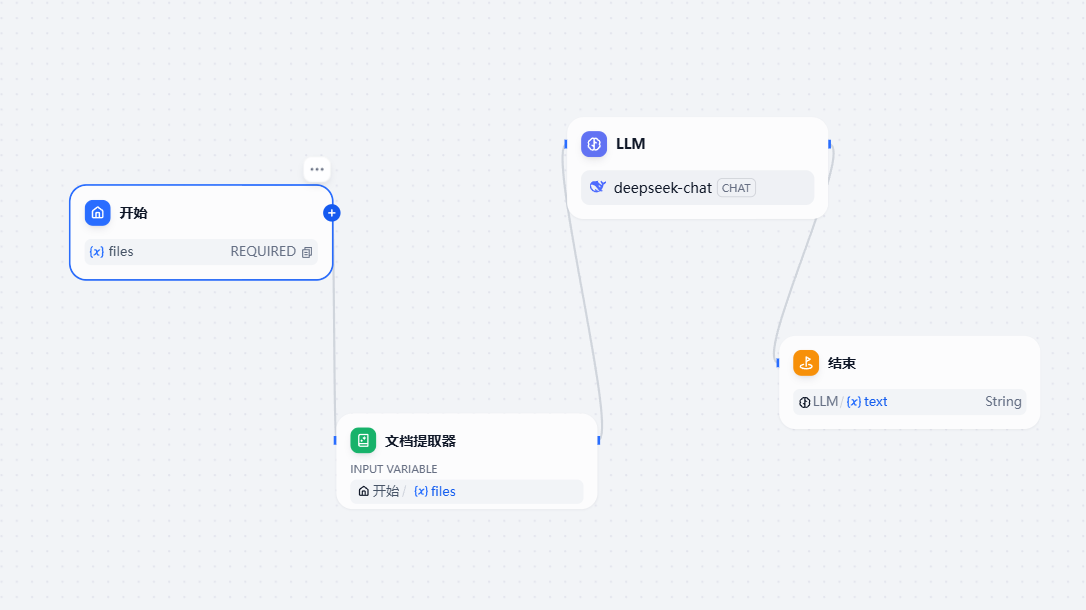

搭建工作流

windows dify:

下載 dify代碼:

https://github.com/langgenius/dify

copy .env.example .env

docker compose up -d

ollma 配置

ollma下載地址:

Download Ollama on macOS

qwen3 模型下載

ollama pull qwen3:8b

這個自動下載,下載后自動運行。?

ollama run qwen3:0.6b

ollama run qwen3:8b

配置環境變量:修改監聽后很慢

?

OLLAMA_HOST

0.0.0.0:11434

OLLAMA_MODELS

C:\Users\Administrator\.ollama\models

變快的方法:

OLLAMA_HOST:127.0.0.1:11434

測試命令:

curl http://192.168.1.8:11434/api/tags

ollama list 模型配置url:

參考:https://zhuanlan.zhihu.com/p/1925558582130217565

http://host.docker.internal:11434

模型名稱: qwen3:8b

在模型名稱中填寫上一步下載的模型,如果不知道模型名稱可以打開cmd,輸入ollama list查看已經安裝的模型。基礎URL代表的是Ollama 服務地址,Ollama是默認暴露11434端口進行API調用,如果Dify是通過Docker部署的話,在基礎URL中填入http://host.docker.internal:11434即可,如果是其他方式部署的Dify,可以參考幫助文檔:https://docs.dify.ai/zh-hans/development/models-integration/ollama。剩余參數保持默認即可。最后點擊保存

如果保存按鈕變成灰色并且遲遲沒有保存成功,可以參考一下步驟重新啟動Dify的Docker服務以及重新啟動大模型。

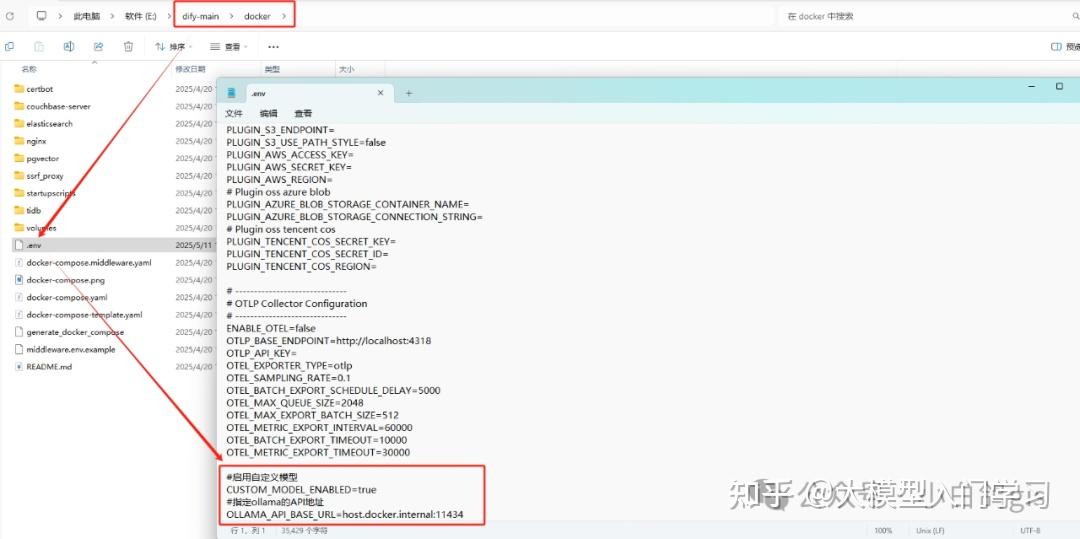

進入到Dify的工程文件,找到docker文件夾里的.env文件,用記事本打開,并在最后添加以下內容:

#啟用自定義模型

CUSTOM_MODEL_ENABLED=true

#指定ollama的API地址

OLLAMA_API_BASE_URL=host.docker.internal:11434

搭建工作流

深度優先遍歷 暴力搜索 C++解題思路 每日一題)

)

android 端集成百度地圖sdk)