25年3月來自 UC Riverside、U Wisconsin 和 TAMU 的論文"UniOcc: A Unified Benchmark for Occupancy Forecasting and Prediction in Autonomous Driving"。

UniOcc 是一個全面統一的占用預測基準(即基于歷史信息預測未來占用)和基于攝像頭圖像的當前幀占用預測。UniOcc 整合來自多個真實數據集(例如 nuScenes、Waymo)和高保真駕駛模擬器(例如 CARLA、OpenCOOD)的數據,提供帶有逐體素流標注的 2D/3D 占用標簽,并支持協作自動駕駛。在評估方面,與依賴次優偽標簽進行評估的現有研究不同,UniOcc 采用不依賴于真實占用的全新指標,從而能夠對占用質量的其他方面進行穩健評估。通過對最先進模型進行大量實驗,證明大規模、多樣化的訓練數據和明確的流信息可顯著提升占用預測和預報性能。

UniOcc 概述如圖所示:

如下表所示:UniOCC和其他占用數據集的比較

統一的數據格式和特征

基準測試支持各種以占用為中心的任務,包括占用預測、單幀占用預測和流量估計。該框架定義以下與任務無關的數據格式:

語義占用標簽。將場景表示為一個 3D 體素網格 G ∈ {0,…,C},其中 C 表示類別數,L、W、H 分別表示網格沿自車航向軸、橫軸和縱軸的尺寸。該網格以自車為中心,+x 軸與行駛方向對齊,+y 軸向左,+z 軸向上。對于某些 2D 任務(例如,運動規劃),通過優先級方案(例如,行人 > 汽車 > 道路)折疊高度維度,使得每個垂直柱采用其最高優先級體素的標簽。這種方法可以防止重要目標類別(例如行人)被同一網格列中優先級較低的標簽遮擋,從而確保后續任務能夠獲得有意義的表示。

攝像機圖像。將原始 RGB 圖像存儲在四維張量 I ∈ {0,…,255} 中,K_cam 表示機載攝像機的數量,每幅圖像的分辨率為 Img_x × Img_y。

攝像機視場 (FOV) 掩碼。二元的三維張量 U ∈ {0, 1} 表示哪些體素位于每個攝像機的可觀察視錐體內(U = 1 表示可見體素,U = 0 表示其他體素)。對于需要明確描繪遮擋區域或未觀察空間的基于攝像機占用方法而言,此掩碼至關重要。

攝像機內參和外參。將相機內參表示為 Int,而外部變換(從每個相機到自身坐標系)則表示為 Ext,其中 SE(3) 表示一組三維齊次變換。這些參數統一從三維自身坐標系到二維圖像平面的投影。

自身到世界坐標系的變換。齊次變換矩陣 T_e^w 表示自身車輛在全局世界坐標系中的姿態,從而能夠精確地對齊來自多個傳感器和坐標系的數據。

前向占用流。定義一個四維張量 F,用于記錄每個體素的前向運動矢量。與之前的方法 [49] 為物體的所有體素分配單一速度(因此忽略物體的旋轉)不同,該方法計算單個體素流,同時捕捉平移和旋轉。分別計算動態前景目標(例如汽車、行人)和靜態背景環境(例如道路、植被)的光流,并將動態和靜態光流合并到 F_n^t 中。如圖所示,這種體素級光流捕捉完整的三維運動,包括旋轉。

后向占用光流。與前向光流類似,定義一個四維張量 B 來捕捉后向運動矢量。不是計算每個體素從 t 到 t + 1 的位移,而是評估從 t 到 t ? 1 的運動。這種后向光流對于那些受益于逆-時間監督或多個-未來訓練策略的模型尤其有用 [24]。

如圖所示目標級和體素級流示意圖(二維),表示一輛汽車右轉。目標級流為所有體素分配相同的速度矢量,從而忽略汽車的旋轉。

目標注釋。還以字典列表的形式提供目標級注釋,每個字典包含:(1) 智體到自車的轉換。變換矩陣 T_a^e 將智體的局部坐標系映射到自車框架。這可以捕捉智體相對于自車的位置和方向。(2) 尺寸。一個 3D 向量 d,描述智體的邊框尺寸(長、寬、高)。(3) 類別。目標的語義類別標簽,定義見如下表:

任務類別

統一的輸入支持廣泛的以占用為中心的任務,涵蓋靜態預測和動態預測。通過在多個領域采用統一的表示,簡化了跨數據集訓練,并允許公平地比較解決不同子問題的方法。下面,概述三個代表性任務:

占用預測。在此,模型使用過去 W_obs 個相機幀 {It?W_obs,…,t},以及它們的視場掩碼 {Ut?W_obs,…,t} 和相機參數(內參 Int,外參 Ext)。輸出是當前的 3D 占用網格 G^t,它捕獲時間 t 的場景。

使用可選流進行占用預測。在預測設置中,輸入是 W_obs 個幀的歷史數據——體素網格 {Gt?W_obs,…,t} 或相機圖像 {It?W_obs,…,t}。該模型預測未來的占用 {Gt,…,t+W_fut},并可選擇以細粒度的自車軌跡 T_e^w, t: t+W_fut^ 或高級駕駛意圖(例如,右轉)為條件。對于某些用例,預測方法還可以生成未來流 F^t: t+W_fut^ 或未來自車運動 T_e^w,t: t+W_fut。這種聯合占用和流預測方案,有助于捕捉隨時間推移的復雜運動模式。流場默認位于自車坐標系中,但可選擇為旋轉不變模型提供以智體為中心的流變型 [44, 63]。

基于可選流的協作占用預測和預報。在協作設置下,多輛車聯網車輛 (CAV) 通過共享圖像或占用數據進行協作。從自車的角度來看,它接收共享的歷史觀測值 {I_CAVt?W_obs,…,t} 或 {G_CAV^t?W_obs,…,t},以及將 CAV 幀映射到自我幀的變換。輸出保持不變(即單-自車占用或預測),但增加的視點覆蓋范圍可以減輕遮擋并提升整體場景理解。

統一數據集

從以下來源構建統一數據集:

? nuScenes [3] 和 Waymo [35]。這兩個數據集都提供攝像頭圖像、激光雷達掃描數據和目標級標注。由于它們均未直接包含 3D 占用標簽,通過三個偽標簽流程——Occ3D [36]、OpenOccupancy [43] 和 SurroundOcc [48]——來合成占用真值。這種多工具方法提高標簽輸出的魯棒性和多樣性。

? CARLA [5]。使用 CARLA 的仿真引擎生成無限多樣的虛擬駕駛場景,從中提取“完美”的 3D 占用標簽(網格、目標狀態等)。這些逼真且可控的場景已公開發布,可輕松進行大規模訓練。該框架支持生成任意長度的數據。

? OpenCOOD [54]。OpenCOOD 基于 CARLA 構建,提供多車協作場景。擴展其數據生成腳本,以便從模擬網格導出 3D 占用信息,從而通過協作駕駛示例擴展數據集。

統一占用處理工具包

大多數基于占用信息的方法僅專注于生成占用網格,但提供的下游處理或運動分析工具有限。為了彌補這一缺陷,其框架包含一個工具包,用于直接在體素空間內進行目標分割和跟蹤,從而支持更高級的任務,例如形狀分析或運動規劃。

目標識別

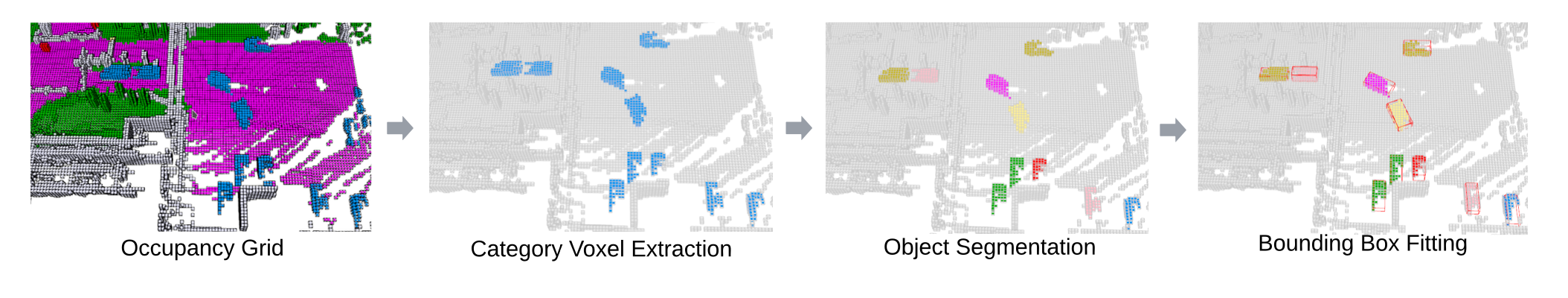

給定一個占用網格 G ∈ {0, …, C },按照以下步驟識別和分割相關目標,如圖所示:

- 目標分割。按類別(例如,汽車、行人)提取體素,然后通過廣度優先搜索實現 6 連通域標記 (CCL):

L = CCL(G), t ∈ {0,1,…,T}, (1)

其中 L ∈ {1,…,N} 為每個連通域分配一個唯一的目標 ID,N 為目標總數。

- 體素提取。對于每個目標 ID n,收集其體素坐標 V_n:

V_n = {< x,y,z > | L(x,y,z) = n}, (2)

-

橫軸邊框。體素預測可能不完整(如圖所示),因此直接測量邊框(長度、寬度、高度)并不可靠。因此,使用旋轉卡尺法(rotating calipers) [38] 在水平面上擬合一個邊界矩形,其目標體素數量為 O(n^2),假設每個目標平行于地面運動。這將得到一個二維最小邊界矩形,由此可以恢復航向和平面大小。

-

維度提取。將矩形的長和寬作為內部的平面尺寸,然后根據體素的垂直范圍計算高度。所有尺寸均按體素分辨率 ε 縮放,轉換為公制單位。

目標跟蹤

利用體素預測的前向占用光流,還提供一種簡單的基于占用光流的目標跟蹤算法:

- 目標體素提取。對于第 t 幀占用網格中已識別的每個目標,檢索其體素坐標 V_nt(??2)和相應的光流矢量 F_n^t。

- 步長預測。通過添加流來估計下一幀體素位置 ~V_n^t+1:

~V_nt+1 = V_nt + F_n^t,(3)

- 質心提取。令 ~c_nt+1 為預測體素集 ~V_nt+1 的質心。還計算第 t + 1 幀的真實目標體素 V _nt+1 及其質心 c_n^t+1。

- 二分關聯。使用匈牙利算法將預測質心 {~c_pt} 與觀測質心 {c_q^t+1} 進行匹配,以最小化成對距離。

上述過程產生跨幀關聯,可以統一隨時間變化的目標身份,從而能夠直接在體素空間中進行運動解釋和分析。

目標對齊

最后,將追蹤目標的體素集對齊,以便進行形狀分析或一致性檢查:

- 平移對齊。將每個目標的體素坐標平移至原點中心,即 V ?_n^t。

- 旋轉對齊。將主成分分析 (PCA) 應用于每幀的體素集,以解析出一個規范的方向。為了保持一致性,調整新主軸的符號,使其與前一幀的方向對齊。最終旋轉后的體素坐標表示為 ?V_n^t。通過這些步驟,可以在占用網格域內進行完全以目標為中心的分析(例如,測量形狀變化或旋轉一致性),而無需參考真值標簽或注釋。

統一評估指標

基準測試包含多個用于評估生成或預測占用網格質量的指標。

基于體素的評估

基于先前的占用預測 [57] 和預測 [2, 42, 47, 61] 研究,采用兩個標準指標:幾何 IoU(或簡稱為 IoU_geo)和 mIoU(跨語義類別的平均交并比)。具體來說,對于預測的占用網格 G_pred 和真實網格 G_gt,

對于多類別占用(總共 C 個類別),mIoU 的計算方式如下:

雖然這些基于體素的指標很簡單,但它們可能會懲罰超過偽真實值的預測(如圖所示)。此外,像多模態預測這樣的任務,可能會產生許多單一參考標簽無法捕捉的合理未來結果。出于這些原因,本文提出一些不需要完美真實值的評估策略。

無真值評估

除了依賴標簽的 IoU 之外,其提出一些無需參考單一真值場景即可評估幾何合理性的指標。這些指標對于多模態生成或真值標簽不完整的情況尤其有用。

關鍵目標的維度概率。給定一個預測目標的邊框 < l, w, h>,并將其歸類為類別 c,通過計算高斯混合模型 (GMM) 的似然來評估其合理性。具體來說,每個類別 c 都有一個預訓練的 GMM,記為 GMM_c,該模型是從統一數據集中的真實或合成數據中學習而來的。在推理時,使用目標的尺寸來查詢 GMM_c。這個查詢概率 P_n 可以啟發式地判斷該目標是否具有與其報告類別相符的實際尺寸。使用經驗值 ρ = 0.5 作為閾值來確定該形狀是否真實存在。

時域前景目標形狀一致性。對于跨多幀預測的動態目標,通過隨時間序列對齊每個目標的體素并計算體素交集而非并集來測量形狀一致性 IoU_object。較高的 IoU_object 表示從 t 幀到 t + 1 幀的形狀幾何形狀穩定。然后,在每個類別中計算這些 IoU 的平均值,以評估整體的隨時間序列一致性。

時域背景環境一致性。對于靜態背景區域,預期在重疊視野內的連續幀之間持續占用。令 V_et 為時間 t 時的環境體素,~V_e^t+1 為它們在 t + 1 時的投影坐標(使用已知的自車運動)。舍棄超出邊界的體素,并計算重疊部分的二值 IoU,即 IoU_bg。即使沒有完美的真實標簽,較高的 IoU_bg 也表明跨幀的靜態背景一致。

總體而言,這些無真實值的指標補充標準 IoU,能夠更深入地洞察場景真實性和時間連貫性,這對于生成性或多模態占用任務尤其有價值。

——大數據的意義與趨勢)

之三)