可調優的內核變量存在兩種主要接口:sysctl命令和/proc文件系統,proc中與進程無關的所有信息都被移植到sysfs中。IPV4協議棧的sysctl參數主要是sysctl.net.core、sysctl.net.ipv4,對應的/proc文件系統是/proc/sys/net/ipv4和/proc/sys/net/core。只有內核在編譯時包含了特定的屬性,該參數才會出現在內核中。

? ? 對于內核參數應該謹慎調節,這些參數通常會影響到系統的整體性能。內核在啟動時會根據系統的資源情況來初始化特定的變量,這種初始化的調節一般會滿足通常的性能需求。

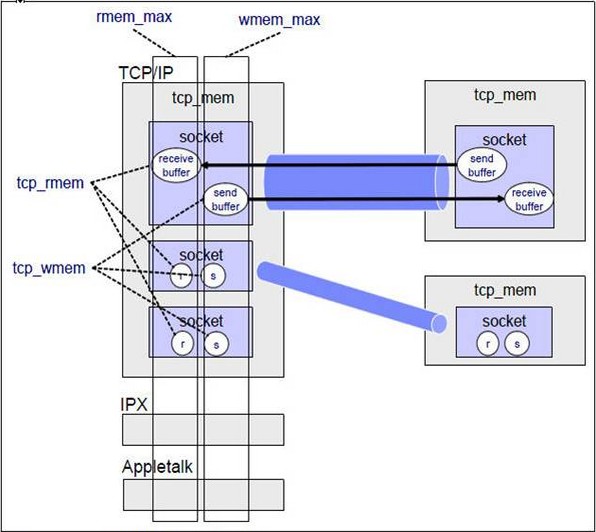

? ? 應用程序通過socket系統調用和遠程主機進行通訊,每一個socket都有一個讀寫緩沖區。讀緩沖區保存了遠程主機發送過來的數據,如果緩沖區已滿,則數據會被丟棄,寫緩沖期保存了要發送到遠程主機的數據,如果寫緩沖區已慢,則系統的應用程序在寫入數據時會阻塞。可知,緩沖區是有大小的。

socket緩沖區默認大小:

/proc/sys/net/core/rmem_default ? ? 對應net.core.rmem_default

/proc/sys/net/core/wmem_default ? ? 對應net.core.wmem_default

? ? 上面是各種類型socket的默認讀寫緩沖區大小,然而對于特定類型的socket則可以設置獨立的值覆蓋默認值大小。例如tcp類型的socket就可以用/proc/sys/net/ipv4/tcp_rmem和tcp_wmem來覆蓋。

socket緩沖區最大值:

/proc/sys/net/core/rmem_max ? ? ? ?對應net.core.rmem_max

/proc/sys/net/core/wmem_max ? ? ? ?對應net.core.wmem_max

/proc/sys/net/core/netdev_max_backlog ? ?對應 net.core.netdev_max_backlog

? ? 該參數定義了當接口收到包的速率大于內核處理包的速率時,設備的輸入隊列中的最大報文數。

/proc/sys/net/core/somaxconn ? ? ? ?對應 net.core.somaxconn

? ? 通過listen系統調用可以指定的最大accept隊列backlog,當排隊的請求連接大于該值時,后續進來的請求連接會被丟棄。

/proc/sys/net/core/optmem_max ? ? ? ? ?對應 net.core.optmem_max

? ? 每個socket的副緩沖區大小。

TCP/IPV4內核參數:

? ? 在創建socket的時候會指定socke協議和地址類型。TCP socket緩沖區大小是他自己控制而不是由core內核緩沖區控制。

/proc/sys/net/ipv4/tcp_rmem ? ? 對應net.ipv4.tcp_rmem

/proc/sys/net/ipv4/tcp_wmem ? ? 對應net.ipv4.tcp_wmem

? ? 以上是TCP socket的讀寫緩沖區的設置,每一項里面都有三個值,第一個值是緩沖區最小值,中間值是緩沖區的默認值,最后一個是緩沖區的最大值,雖然緩沖區的值不受core緩沖區的值的限制,但是緩沖區的最大值仍舊受限于core的最大值。

/proc/sys/net/ipv4/tcp_mem ?

? ? 該內核參數也是包括三個值,用來定義內存管理的范圍,第一個值的意思是當page數低于該值時,TCP并不認為他為內存壓力,第二個值是進入內存的壓力區域時所達到的頁數,第三個值是所有TCP sockets所允許使用的最大page數,超過該值后,會丟棄后續報文。page是以頁面為單位的,為系統中socket全局分配的內存容量。

socket的結構如下圖:

/proc/sys/net/ipv4/tcp_window_scaling ? ? ?對應net.ipv4.tcp_window_scaling

? ? 管理TCP的窗口縮放特性,因為在tcp頭部中聲明接收緩沖區的長度為26位,因此窗口不能大于64K,如果大于64K,就要打開窗口縮放。

/proc/sys/net/ipv4/tcp_sack ? ?對應net.ipv4.tcp_sack

? ? 管理TCP的選擇性應答,允許接收端向發送端傳遞關于字節流中丟失的序列號,減少了段丟失時需要重傳的段數目,當段丟失頻繁時,sack是很有益的。

/proc/sys/net/ipv4/tcp_dsack ? 對應net.ipv4.tcp_dsack

? ? 是對sack的改進,能夠檢測不必要的重傳。

/proc/sys/net/ipv4/tcp_fack ? ?對應net.ipv4.tcp_fack

? ? 對sack協議加以完善,改進tcp的擁塞控制機制。

TCP的連接管理:

/proc/sys/net/ipv4/tcp_max_syn_backlog ? ?對應net.ipv4.tcp_max_syn_backlog

? ? 每一個連接請求(SYN報文)都需要排隊,直至本地服務器接收,該變量就是控制每個端口的 TCP SYN隊列長度的。如果連接請求多余該值,則請求會被丟棄。

/proc/sys/net/ipv4/tcp_syn_retries ? ?對應net.ipv4.tcp_syn_retries

? ? 控制內核向某個輸入的SYN/ACK段重新發送相應的次數,低值可以更好的檢測到遠程主機的連接失敗。可以修改為3

/proc/sys/net/ipv4/tcp_retries1 ? ?對應net.ipv4.tcp_retries1

? ? 該變量設置放棄回應一個tcp連接請求前,需要進行多少次重試。

/proc/sys/net/ipv4/tcp_retries2 ? ?對應net.ipv4.tcp_retries2

? ? 控制內核向已經建立連接的遠程主機重新發送數據的次數,低值可以更早的檢測到與遠程主機失效的連接,因此服務器可以更快的釋放該連接,可以修改為5

TCP連接的保持:

/proc/sys/net/ipv4/tcp_keepalive_time ? ? ? ?對應net.ipv4.tcp_keepalive_time

? ? 如果在該參數指定的秒數內連接始終處于空閑狀態,則內核向客戶端發起對該主機的探測

/proc/sys/net/ipv4/tcp_keepalive_intvl ? ?對應net.ipv4.tcp_keepalive_intvl

? ? 該參數以秒為單位,規定內核向遠程主機發送探測指針的時間間隔

/proc/sys/net/ipv4/tcp_keepalive_probes ? 對應net.ipv4.tcp_keepalive_probes

? ? 該參數規定內核為了檢測遠程主機的存活而發送的探測指針的數量,如果探測指針的數量已經使用完畢仍舊沒有得到客戶端的響應,即斷定客戶端不可達,關閉與該客戶端的連接,釋放相關資源。

/proc/sys/net/ipv4/ip_local_port_range ? 對應net.ipv4.ip_local_port_range

? ? 規定了tcp/udp可用的本地端口的范圍。

TCP連接的回收:

/proc/sys/net/ipv4/tcp_max_tw_buckets ? ? 對應net.ipv4.tcp_max_tw_buckets

? ?該參數設置系統的TIME_WAIT的數量,如果超過默認值則會被立即清除。

/proc/sys/net/ipv4/tcp_tw_reuse ? ? ? ? ? 對應net.ipv4.tcp_tw_reuse

? ?該參數設置TIME_WAIT重用,可以讓處于TIME_WAIT的連接用于新的tcp連接

/proc/sys/net/ipv4/tcp_tw_recycle ? ? ? ? 對應net.ipv4.tcp_tw_recycle

? ?該參數設置tcp連接中TIME_WAIT的快速回收。

/proc/sys/net/ipv4/tcp_fin_timeout ? ? ? 對應net.ipv4.tcp_fin_timeout

? ?設置TIME_WAIT2進入CLOSED的等待時間。

/proc/sys/net/ipv4/route/max_size

? ?內核所允許的最大路由數目。

/proc/sys/net/ipv4/ip_forward

? ?接口間轉發報文

/proc/sys/net/ipv4/ip_default_ttl

? ?報文可以經過的最大跳數

虛擬內存參數:

/proc/sys/vm/

? ?在linux kernel 2.6.25之前通過ulimit -n(setrlimit(RLIMIT_NOFILE))設置每個進程的最大打開文件句柄數不能超過NR_OPEN(1024*1024),也就是100多w(除非重新編譯內核),而在25之后,內核導出了一個sys接口可以修改這個最大值/proc/sys/fs/nr_open。shell里不能直接更改,是因為登錄的時候pam已經從limits.conf中設置了上限,ulimit命令只能在低于上限的范圍內發揮了。

Linux中查看socket狀態:

cat /proc/net/sockstat #(這個是ipv4的)

sockets: used 137

TCP: inuse 49 orphan 0 tw 3272 alloc 52 mem 46

UDP: inuse 1 mem 0

RAW: inuse 0

FRAG: inuse 0 memory 0

說明:

sockets: used:已使用的所有協議套接字總量

TCP: inuse:正在使用(正在偵聽)的TCP套接字數量。其值≤ netstat –lnt | grep ^tcp | wc –l

TCP: orphan:無主(不屬于任何進程)的TCP連接數(無用、待銷毀的TCP socket數)

TCP: tw:等待關閉的TCP連接數。其值等于netstat –ant | grep TIME_WAIT | wc –l

TCP:alloc(allocated):已分配(已建立、已申請到sk_buff)的TCP套接字數量。其值等于netstat –ant | grep ^tcp | wc –l

TCP:mem:套接字緩沖區使用量(單位不詳。用scp實測,速度在4803.9kB/s時:其值=11,netstat –ant 中相應的22端口的Recv-Q=0,Send-Q≈400)

UDP:inuse:正在使用的UDP套接字數量

RAW:

FRAG:使用的IP段數量

轉自:http://blog.chinaunix.net/uid-9688646-id-4049599.html

——Linux MySQL主從配置)