目錄

簡介

安裝準備

spark安裝

配置文件配置

簡介

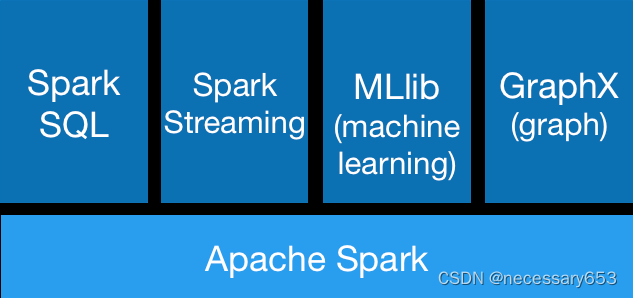

????????Spark主要?于?數據的并?計算,?Hadoop在企業主要?于?數據的存儲(?如HDFS、Hive和HBase 等),以及資源調度(Yarn)。但是也有很多公司也在使?MR2進?離線計算的開發。Spark + Hadoop在當前自建平臺技術中,是離線計算任務開發的主流組合方式。

數據存儲:HDFS

資源調度:Yarn

數據計算:Spark或MapReduce,取決于具體的企業需求場景

安裝準備

????????linux免密登錄

????????zookeeper安裝

? ? ? ??hadoop安裝

spark安裝

wget https://archive.apache.org/dist/spark/spark-3.5.0/spark-3.5.0-bin-hadoop3.tgz

然后進行解壓,清空壓縮包,設置軟連接。

tar -zxf spark-3.5.0-bin-hadoop3.tgz

rm -rf spark-3.5.0-bin-hadoop3.tgz

ln -s spark-3.5.0-bin-hadoop3/ spark

配置文件配置

? ? ? ? 在$SPARK_HOME/conf 下,壓縮包中自帶一個標準格式文件,將其更名為spark-env.sh便可。

[hadoop@vm02 conf]$ cp spark-env.sh.template spark-env.sh

[hadoop@vm02 conf]$ ll

total 44

-rw-r--r-- 1 hadoop hadoop 1105 Sep 9 10:08 fairscheduler.xml.template

-rw-r--r-- 1 hadoop hadoop 3350 Sep 9 10:08 log4j2.properties.template

-rw-r--r-- 1 hadoop hadoop 9141 Sep 9 10:08 metrics.properties.template

-rw-r--r-- 1 hadoop hadoop 1292 Sep 9 10:08 spark-defaults.conf.template

-rwxr-xr-x 1 hadoop hadoop 4694 Dec 10 23:02 spark-env.sh

-rwxr-xr-x 1 hadoop hadoop 4694 Sep 9 10:08 spark-env.sh.template

-rw-r--r-- 1 hadoop hadoop 865 Sep 9 10:08 workers.template? ? ? ? 本文使用簡易配置作為演示,關于其他參數在配置文檔中已經寫明注釋,可以根據實際情況進行閱讀或選擇性配置。本文在該文檔下只設置主節點hostname,所有節點同步

export SPARK_MASTER_HOST=vm02

export JAVA_HOME=/jdk/jdk1.8.0_144/

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=${JAVA_HOME}/lib:${JRE_HOME}/lib

export ZOOKEEPER_HOME=/home/hadoop/zookeeper

#HADOOP_HOME

export HADOOP_HOME=/home/hadoop/hadoop

export HBASE_HOME=/home/hadoop/hbase

·? ? ? ? 設置vm03,vm04為工作節點

[hadoop@vm02 conf]$ cp workers.template workers

[hadoop@vm02 conf]$ vim workers

vm03

vm04 ? ? ? ? 配置spark環境變量

vim /etc/profile,將一下環境變量配置加入到文件中

export PATH=$SPARK_HOME/bin:$PATH

export SPARK_HOME=/home/hadoop/spark

重新加載環境變量

source /etc/profile啟動spark

##進入$SPARK_HOME/sbin 目錄下啟動spark

start-all.sh

注意:spark的啟動指令的命令的名稱和hadoop的啟動名稱是一樣的,所以不要設置$SPARK_HOME/sbin 的PATH環境變量

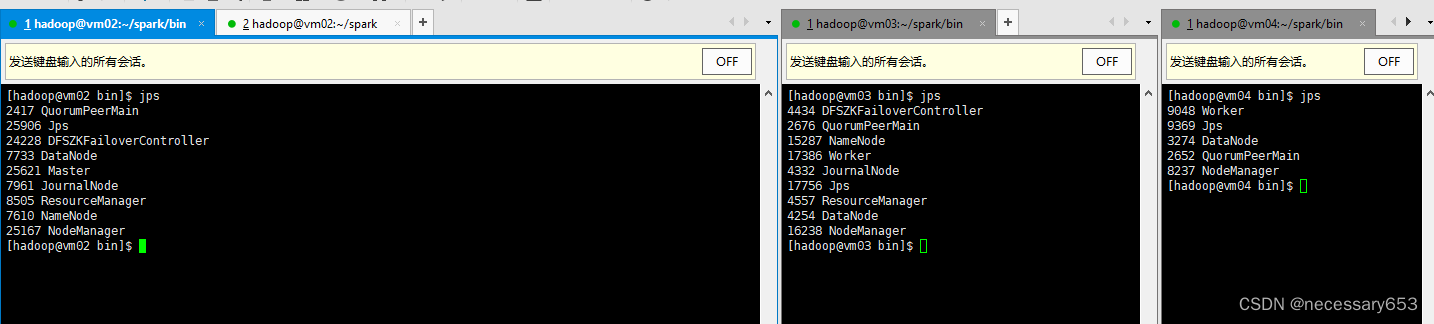

啟動完成后可以只看到,marster在vm02上,vm03,vm04都是work節點。

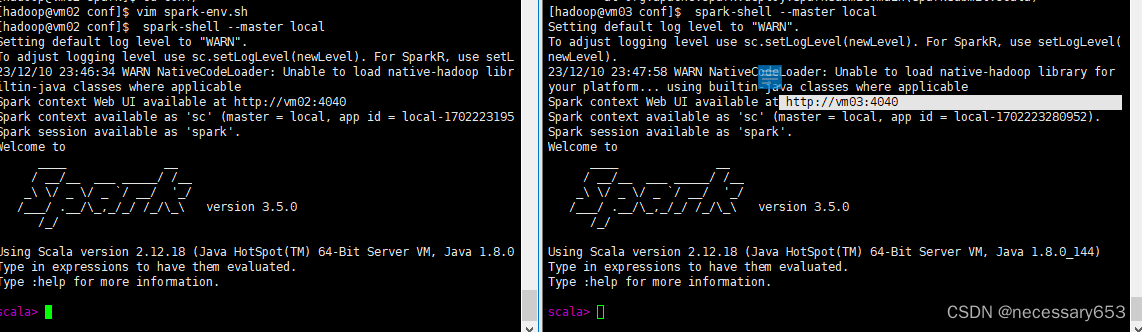

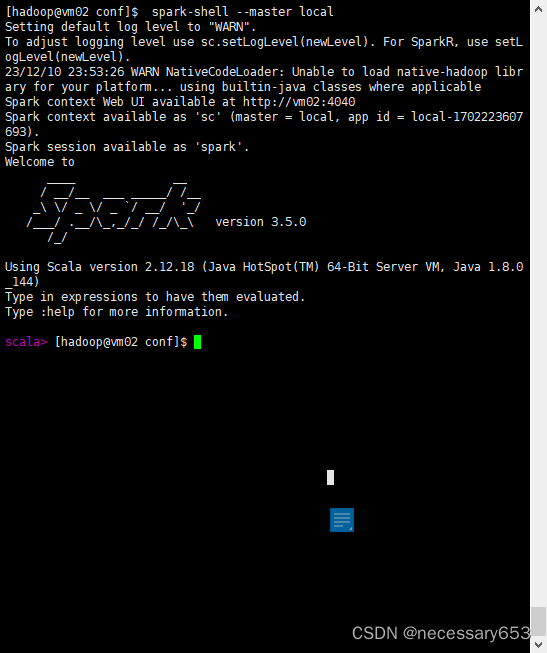

在所有節點均可以使用以下命令進入spark的交互端口,

spark-shell --master local

?

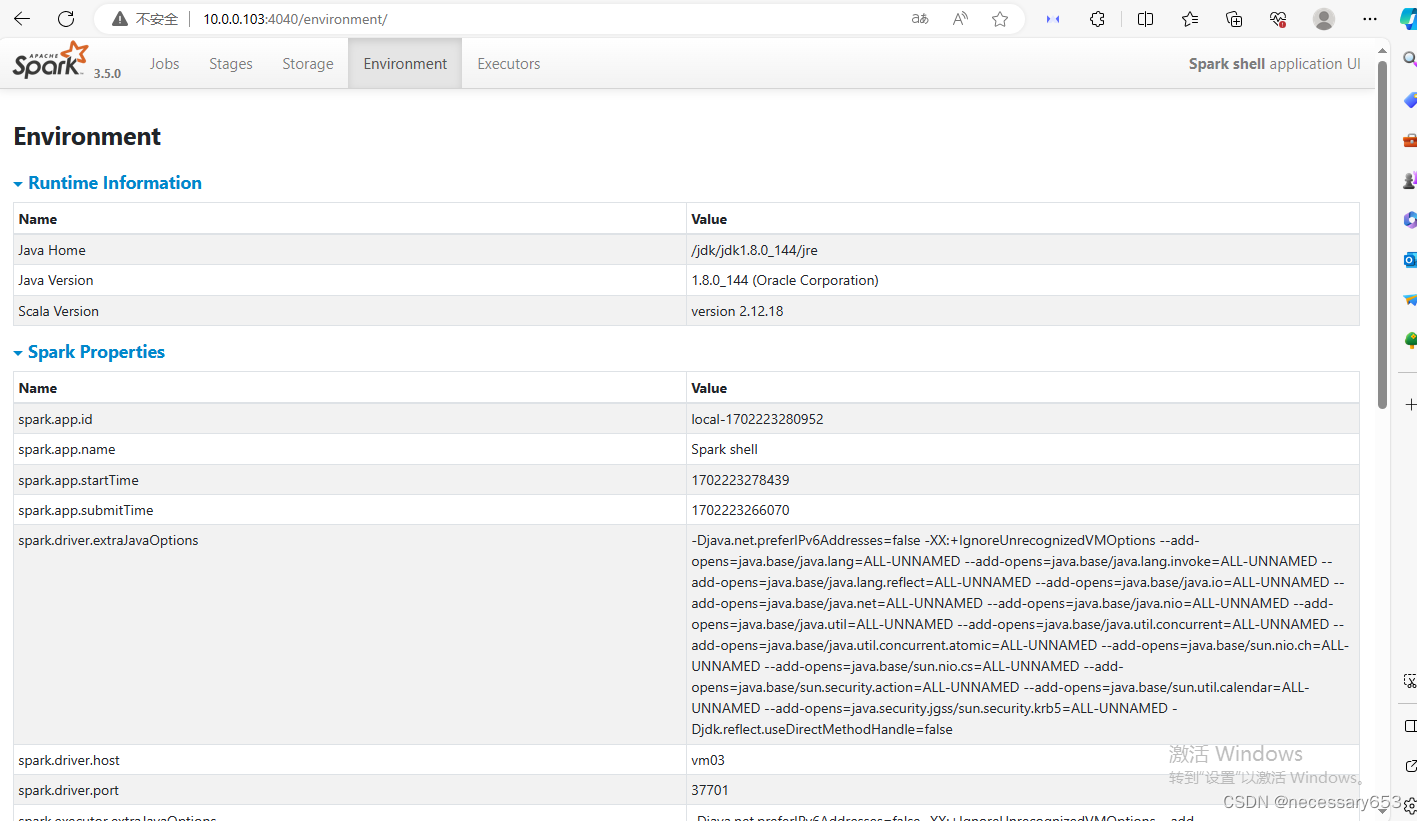

?只有當進入到交互命令行時,才可以訪問對應節點的webui頁面,默認端口是4040

使用ctrl+c便可以退出交互行

????????spark的安裝也是相當方便。讀者有什么疑問,可以私信咨詢。

)

)

詳解)

:在 jvm 平臺使用 jni 實現桌面端與 C/C++ 互操作)

-升級k8s集群)

燈光、陰影、霧(源碼))

【debug篇】)

——集成技術(Bagging——隨機森林分類器和回歸))