有好幾篇論文已經這樣做了,先擺出一篇,然后再慢慢更新

第一篇

該篇論文提出了一種稱為深增強ALNS(DR-ALNS)的方法,它利用DRL選擇最有效的破壞和修復運營商,配置破壞嚴重性參數施加在破壞算子上,并設置ALNS框架內的驗收標準值。DRL在每次搜索迭代時配置ALNS。與其他基于DRL的針對特定的優化問題的方法,這篇論文的目標是以一種概括的方式利用DRL。

為了實現這一點,該方法除了定義的破壞算子和修復算子,不依賴于任何特定于問題的信息。下圖提供了用于DR-ALNS的偽代碼和訓練算法。

在該方法中,學習選擇破壞和修復策略,配置破壞度,并在自適應大鄰域搜索過程的每次迭代中設置驗收標準參數。

將這個學習問題建模為一個連續的決策過程,在這個過程中,代理人通過采取行動和觀察結果與環境進行交互。該過程使用稱為馬爾可夫決策過程(MDP)的數學框架來建模,其表示為元組<S,A,R,P>。

狀態空間S為DRL代理提供了所需的信息,用于在搜索迭代期間做出明智的決策以選擇最佳的可能動作。為了實現這一點,我們將S表示為包含7個問題不可知特征的一維向量,如表1所示。這些特征為代理提供了關于搜索過程的相關信息,

包括:

當前解決方案是否是迄今為止找到的最佳解決方案,

最佳解決方案最近是否已被改進,

當前解決方案最近是否已被接受

新的當前解決方案是否是新的最佳解決方案,

與最佳解決方案的成本差異百分比,

未改進最佳解決方案的迭代次數

剩余搜索預算百分比

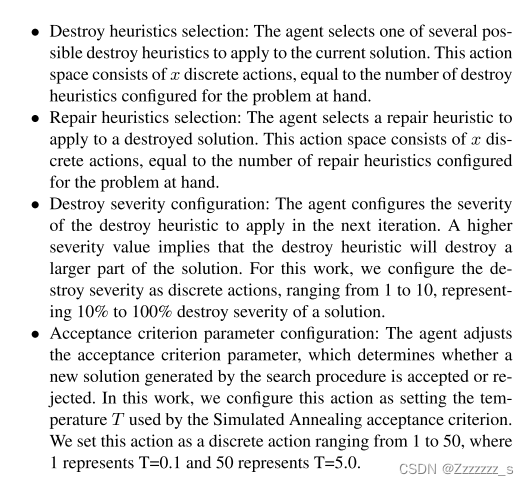

動作空間A由破壞算子選擇、修復算子選擇、破壞度配置、驗收標準參數設置四個動作空間組成。在每個時間步,DRL代理必須為每個空間選擇一個操作。

?不是選擇一組動作而是選擇單個動作?

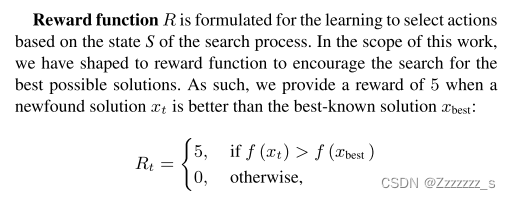

獎勵函數:

狀態轉移函數P是由DRL主體通過與環境交互來學習的,因為主體沒有關于它的先驗知識。通過以這種方式制定MDP,我們為DRL主體提供了一個問題不可知的環境來學習如何選擇動作。這意味著狀態空間S和獎勵函數R不依賴于任何特定于問題的信息。為了使用該方法,實踐者只需要定義破壞“和修復”算子,然后使用它們在MDP中創建動作空間A。

?不是選擇一組動作而是選擇單個動作?

沒讀懂…

摘要中寫

.ALNS在搜索過程中自適應地選擇各種算法,利用它們的優勢為優化問題找到好的解決方案。然而,ALNS的有效性取決于其選擇和驗收參數的適當配置。為了解決這一限制,我們提出了一種深度強化學習(DRL)方法,該方法在搜索過程中選擇算法、調整參數并控制接受標準。

ALNS的殼,DRL的芯?

所提出的方法的目的基于搜索狀態,學習如何配置ALNS的下一次迭代,以獲得良好的解決方案的基礎優化問題。

第二篇

這個是根據表現選擇算法對兒 ,該框架使用深度強化學習(Deep RL)作為ALNS自適應層的替代方案,與僅考慮搜索引擎的過去性能以用于未來選擇的自適應層不同,深度RL代理能夠考慮來自搜索過程的附加信息,例如,迭代之間目標值的差異,以做出更好的決策。這是由于深度學習方法的表示能力和深度RL代理的決策能力,可以學習適應不同的問題和實例特征。

常見的算子也給改了

狀態空間

動作空間就是選擇啟發式

獎勵函數 5310

這兩篇的訓練方法都是PPO

)

- Linux內核網絡基礎)

)