作者:靖蘇

在 AI 與云原生協同創新的浪潮下,多模型、多場景智能應用日益普及。開發者面臨的首要挑戰,是如何實現模型之間、服務之間的高效協同,以及如何便捷地將自主研發能力拓展到云端,形成靈活可擴展的智能服務。MCP 即模型上下文協議(Model Context Protocol) ,其提供了一套通用的上下文管理和交互規范,幫助開發者聚焦于模型推理及業務創新,同時解決模型集成、通訊、調度和上下文共享等復雜問題。開發者可以根據自身業務場景,自主開發符合 MCP 協議的服務代碼,并通過簡單配置,一鍵部署至 Function AI 平臺,并通過平臺提供的訪問地址提供給你進行調用,實現與模型服務的快速開發與集成。

Function AI 提供 MCP 代碼一鍵上云的全流程能力

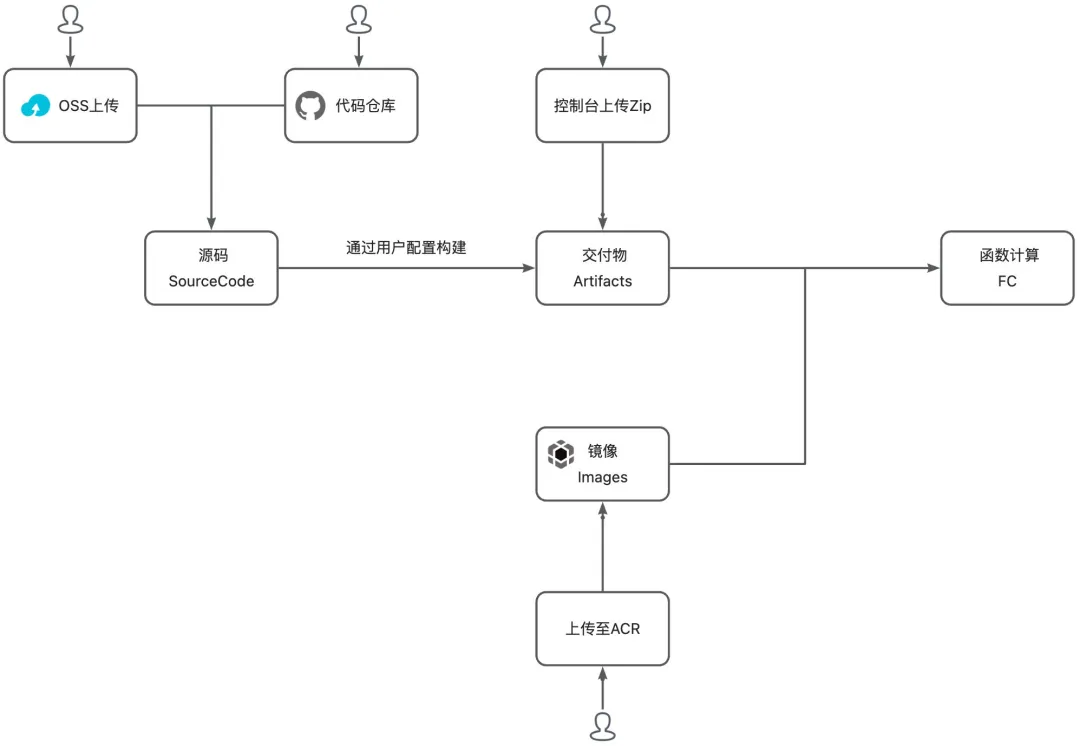

為了讓開發者更高效地將自主實現的 MCP 協議代碼構建、部署到云端服務,Function AI 針對開發階段,提供了如下圖所示的多途徑的便捷構建和部署能力。

開發者可以將源碼、交付物或鏡像上傳或托管至 Function AI 平臺,通過修改構建配置和運行配置,點擊部署后,便可將你的 MCP 服務源碼部署至平臺,平臺提供公網訪問地址可以連接你云端部署的 MCP 服務。

1. 綁定代碼倉庫,自動拉取代碼進行構建部署

Function AI 提供了 Github、Gitee、Gitlab 和 Codeup 源碼倉庫代碼一鍵構建部署的能力。MCP 服務的代碼開發者只需將 MCP 代碼托管到源碼倉庫,Function AI 支持倉庫綁定獲取源碼,自動觸發構建和一鍵部署。每一次提交后,平臺都能持續集成,使云端部署與本地開發同步,適合團隊協作及敏捷交付。

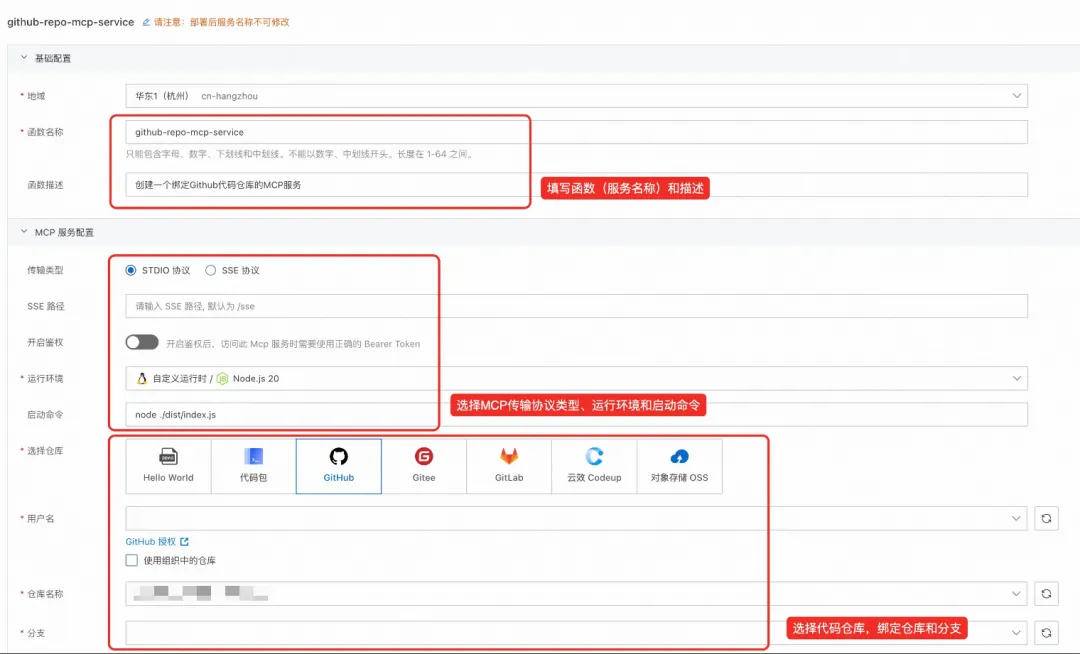

首先登錄?Function AI 平臺【1】,點擊創建項目,在項目下創建一個 MCP 服務。

進入基礎配置,可以定義你的 MCP 服務(函數)名稱和描述。進入下面的 MCP 服務配置,選擇你想綁定的代碼倉庫(Github、Gitee、Gitlab 或 Codeup)。點擊“授權”,跳轉到代碼倉庫的頁面,將你的賬號授權給平臺,獲取你的倉庫和分支信息。授權完畢后,選擇你想綁定的代碼倉庫和分支。

綁定完成后,需要選擇你的代碼運行環境和運行啟動命令。Function AI 支持 NodeJS、Python、Java 等多個 MCP 服務依賴運行時,你可以選擇相應的運行時,并填寫代碼的啟動命令啟動代碼。Function AI 支持 MCP STDIO 協議和 SSE 協議,你可以選擇你 MCP 服務中的對應協議類型。

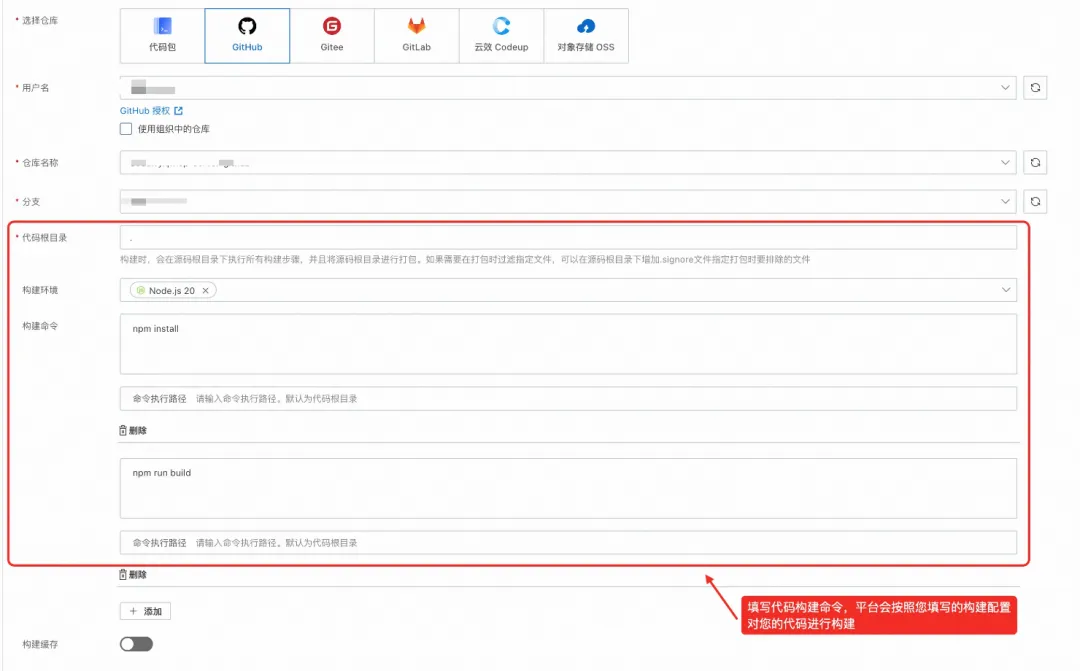

下一步是填寫構建配置:首先填寫代碼根目錄,平臺會將你填寫的代碼根目錄下的代碼上傳到平臺進行構建。此外,需要你填寫代碼的構建環境和構建命令。

例如,我想部署一個 Nodejs 代碼開發的 MCP 服務,在這里要填寫對應的構建環境和構建命令(在對應的路徑下執行相應的構建命令),一般來說,構建的命令用于幫助你的代碼安裝相關環境依賴。

在這里:

- 示例中代碼根目錄填寫的是.,平臺將上傳代碼倉庫的源碼,其根目錄就是運行時的根目錄;

- 示例中的 MCP 服務是基于 Nodejs 進行開發的,因此選擇了 Node.js20 作為構建環境;

- 代碼首選需要通過?npm install?安裝相關依賴,隨后執行?npm run build?編譯相關源碼,在構建命令中填寫相應命令,命令執行路徑不填,默認會使用代碼根目錄,即在代碼倉庫的根目錄下執行此條命令;

- 如你需要在構建階段使用緩存,可打開緩存開關配置緩存路徑,詳細見:緩存路徑配置【2】

隨后,你可以按需選擇此 MCP 服務需要的資源配置和網絡配置。資源配置決定了你的服務是否需要開啟極速模式預留實例快照以及此服務需要的 CPU 和內存規格。網絡配置決定了你的 MCP 服務是否要綁定 VPC 進行內網訪問以及是否禁用公網 URL。

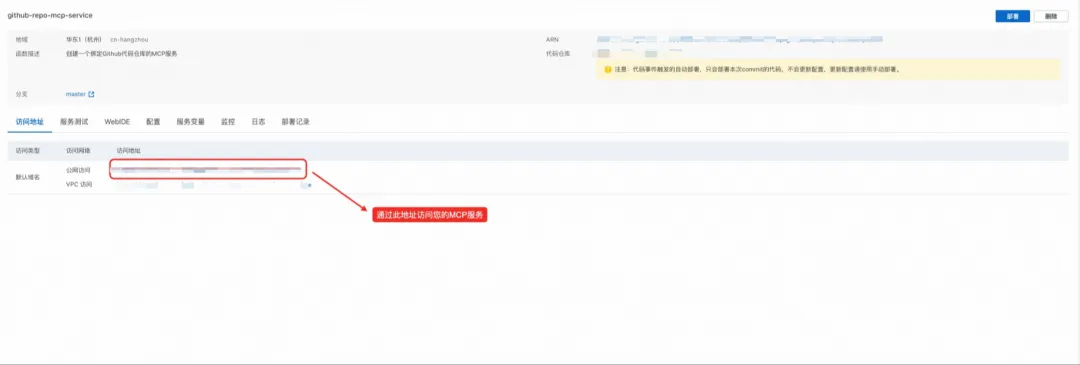

在配置好以上信息后,點擊部署服務,即可將服務構建并部署至 Function AI 平臺上。你可以點擊部署記錄查看構建和部署日志(包含安裝代碼依賴、部署程序至函數計算服務中)。

部署成功后,你可以點擊“訪問地址”查看公網訪問地址和私網訪問地址,你可以根據此地址,將此 MCP 服務注冊到百煉等第三方模型服務提供平臺,提供給大模型進行調用。

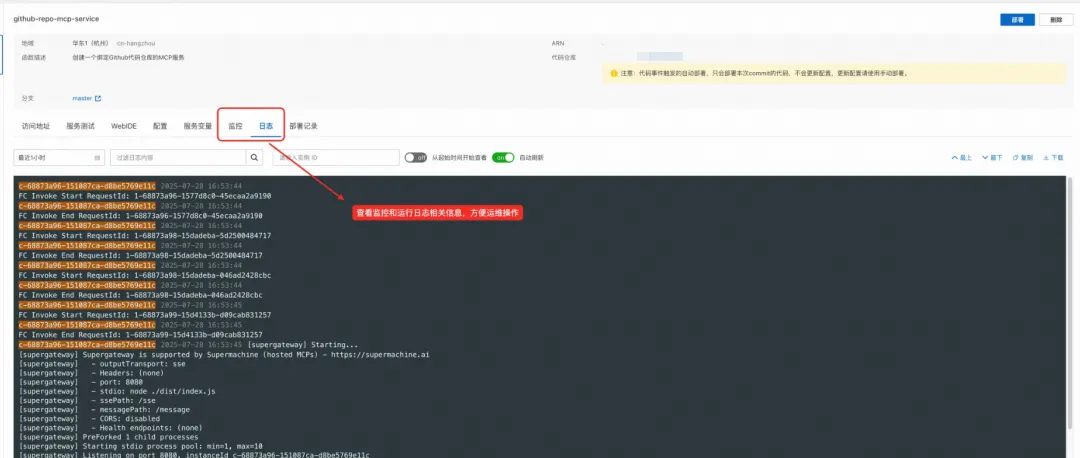

后期你可以點擊監控和日志,查看當前 MCP 服務運行的日志和指標情況,方便你進行后續運維。

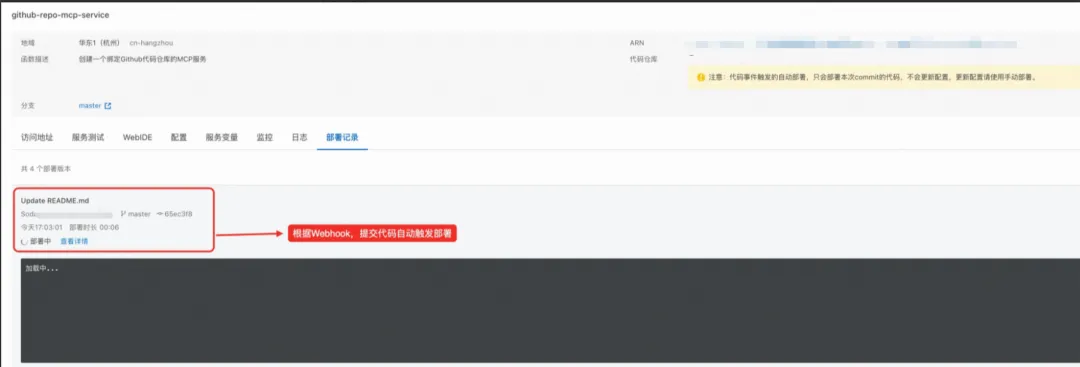

若你選擇通過綁定代碼倉庫,獲取源碼構建部署 MCP 服務,平臺會自動創建 Webhook 至你的代碼倉庫,后續該綁定分支的提交操作,將自動觸發構建部署流程,使每一次代碼更新都能夠實時集成并快速上線,無需手動干預,大幅提升開發效率與發布頻率,保障你的服務持續迭代與高效交付。

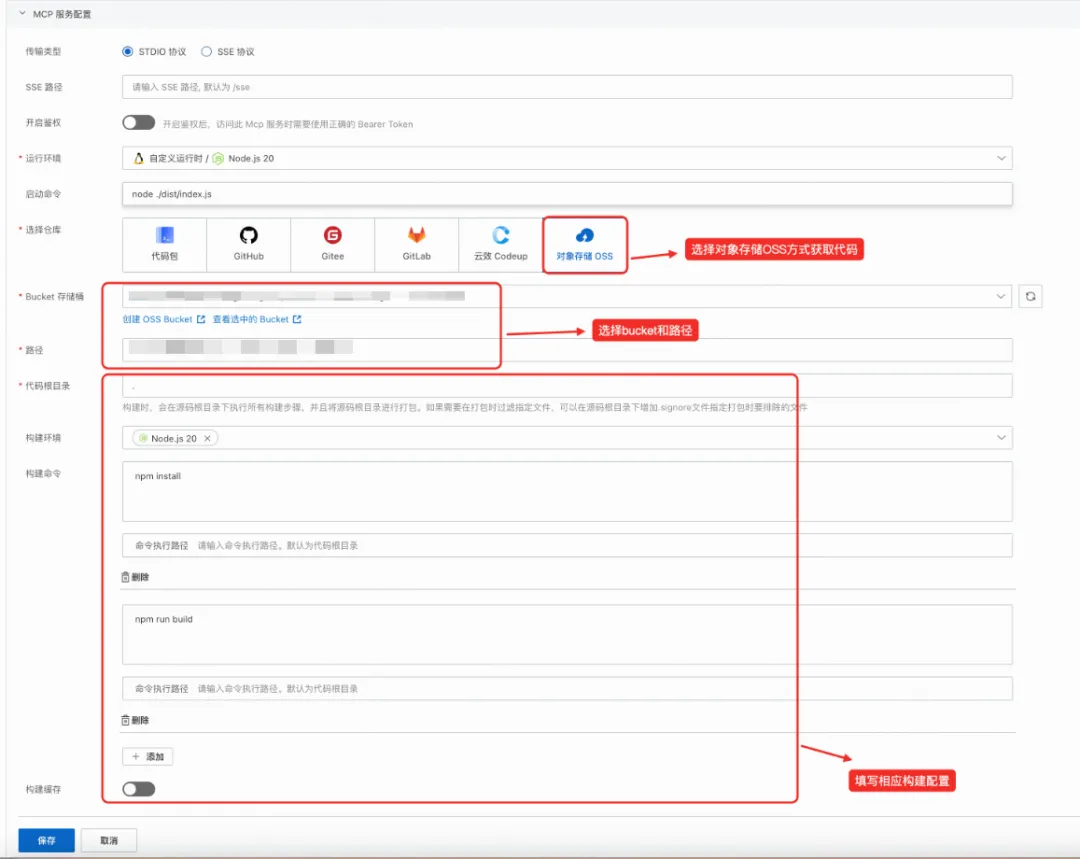

2. 上傳源碼包到 OSS 構建

如你或團隊已開通對象存儲(OSS)服務,可將完整源碼包上傳至 OSS。Function AI 會自動拉取你上傳到 OSS 的源碼,按照配置高效完成構建和部署,幫你助你實現資源管理與交付流程的統一。

新建 MCP 服務,點擊 OSS 上傳,你可以選擇你當前賬號下的 Bucket 和 Object 目錄,如果上傳的 Object 為 ZIP 壓縮文件,平臺會自動幫你解壓縮,在代碼根目錄下執行構建命令,同樣填寫運行配置、資源配置和網絡配置后(步驟與第一節相同),點擊部署,便可將你的代碼部署至 Function AI 平臺。

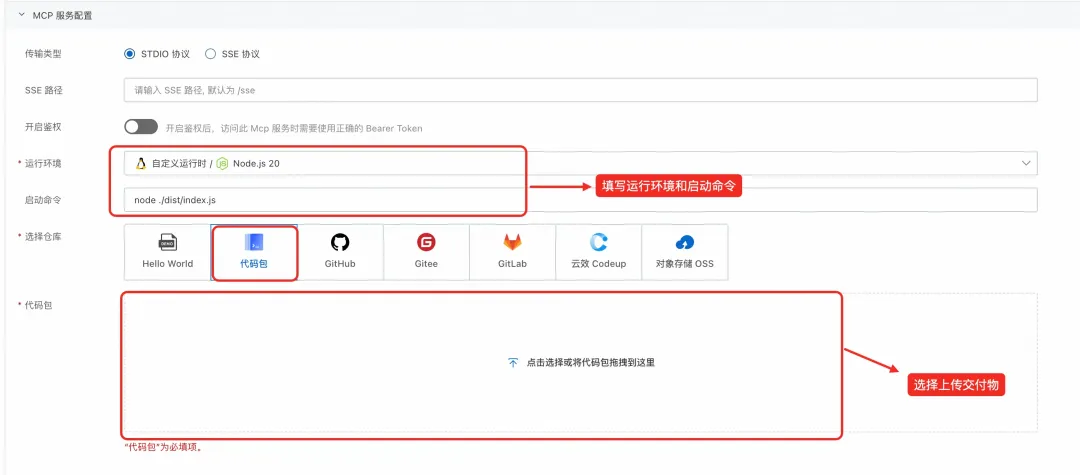

3. 上傳本地構建交付物

如果你覺得在本地構建的方式更加自由和靈活,Function AI 提供了上傳本地交付物直接進行部署的能力。你可以本地編譯、打包好可執行文件(例如二進制文件、JAR 包、安裝好依賴的解釋性語言包等)后,即可通過 ZIP 壓縮包上傳至 Function AI,由平臺自動完成部署,無需平臺端二次構建,大幅縮短部署周期。

新建 MCP 服務,點擊代碼包上傳,你可以將你本地的構建好的交付物壓縮為 ZIP 文件,拖拽至控制臺進行上傳。平臺會自動幫你解壓縮。由于你上傳的是交付文件,平臺將不為你進行代碼構建,在填寫運行配置、資源配置和網絡配置后(步驟與第一節相同),點擊部署,便可將你的交付物部署至 Function AI 平臺。

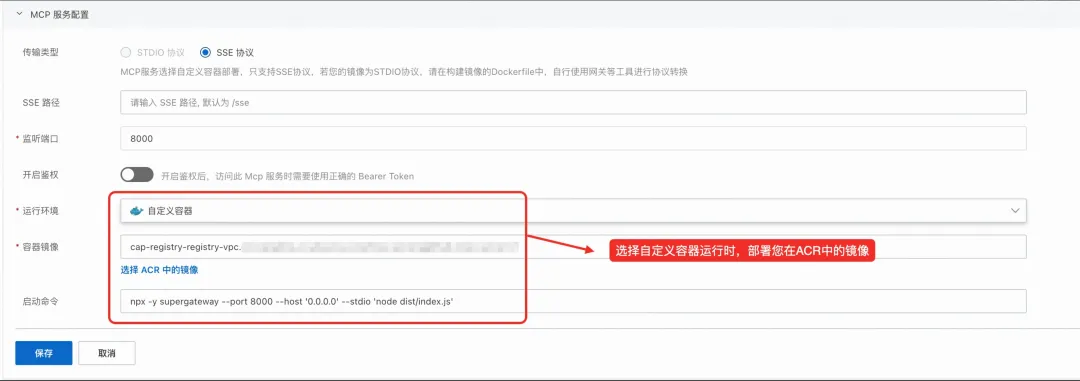

4. 鏡像上傳至 ACR,平臺自動部署

考慮到 MCP 服務的定制遇到復雜運行環境時,傳統的基于程序語言的運行時可能不能滿足你的需求,Function AI 提供了容器化的部署方式。

新建 MCP 服務,選擇自定義容器作為運行環境,將本地構建的 MCP 服務的 Docker 鏡像上傳至阿里云 ACR 鏡像倉庫,填寫監聽端口和啟動命令。Function AI 平臺拉取鏡像后立即部署,兼容 DevOps 流程,保障一致性與可控性。

注:MCP 服務鏡像部署只支持 SSE 協議,你可以使用相應開源 Proxy,完成 STDIO 協議和 SSE 協議的轉換。

面向未來,打造開放且高效的 Serverless AI 應用開發平臺

Function AI 致力于支持 MCP 服務開發的每一個階段,無論你是獨立開發者還是企業技術團隊,使用 MCP 協議自研代碼,都可憑借 Function AI 平臺,享受:

- 一鍵式 MCP 代碼部署體驗

- 靈活適配不同需求研發流程

- 快速聯通云端 AI 資源

- 版本管理與可追蹤上線

讓每一次本地創新,都能自在上云,融入智能生態。現在就來體驗 Function AI 的強大云端部署能力,讓你的 MCP 服務模型更快、更安全、更智能地服務業務創新!

【1】Function AI 平臺

https://cap.console.aliyun.com/explore

【2】使用OSS緩存插件加速構建

https://help.aliyun.com/zh/functioncompute/fc-3-0/use-the-oss-cache-plug-in-to-accelerate-dependency-building

點擊此處,立即體驗?Function AI 的強大云端部署能力

)

)

)

![[Oracle] DUAL數據表](http://pic.xiahunao.cn/[Oracle] DUAL數據表)

8.5)