llama-factory快速開始

文章目錄

- llama-factory快速開始

- 前言

- 一、環境配置

- 1.1 訓練順利運行需要包含4個必備條件

- 1.2 llama-factory下載

- 1.3 環境下載

- 1.4 硬件環境校驗

- 二、啟動

前言

https://github.com/hiyouga/LLaMA-Factory/blob/main/README_zh.md

這是GitHub中文介紹文檔,里面的教程更加詳細,本人記錄是方便本人看,對于我已經熟練的部分,教程中可能不會細說甚至跳過。

不同的是,我用的模型是qwen3-4B

一、環境配置

1.1 訓練順利運行需要包含4個必備條件

1.機器本身的硬件和驅動支持(包含顯卡驅動,網絡環境等)

2.本項目及相關依賴的python庫的正確安裝(包含CUDA, Pytorch等)

3.目標訓練模型文件的正確下載

4.訓練數據集的正確構造和配置

1.2 llama-factory下載

git clone https://github.com/hiyouga/LLaMA-Factory.git

conda create -n llama_factory python=3.10

conda activate llama_factory

cd LLaMA-Factory

pip install -e '.[torch,metrics]'

上述的安裝命令完成了如下幾件事

1.新建一個LLaMA-Factory 使用的python環境(可選) 安裝LLaMA-Factory

2.所需要的第三方基礎庫(requirements.txt包含的庫) 安裝評估指標所需要的庫,包含nltk, jieba,

3. rouge-chinese 安裝LLaMA-Factory本身,然后在系統中生成一個命令 llamafactory-cli(具體用法見下方教程)

1.3 環境下載

安裝對應版本工具

1.cuda

2.pytorch等核心工具

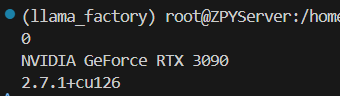

測試torch版本:

import torch

print(torch.cuda.current_device())

print(torch.cuda.get_device_name(0))

print(torch.__version__)

如果識別不到可用的GPU,則說明環境準備還有問題,需要先進行處理,才能往后進行。

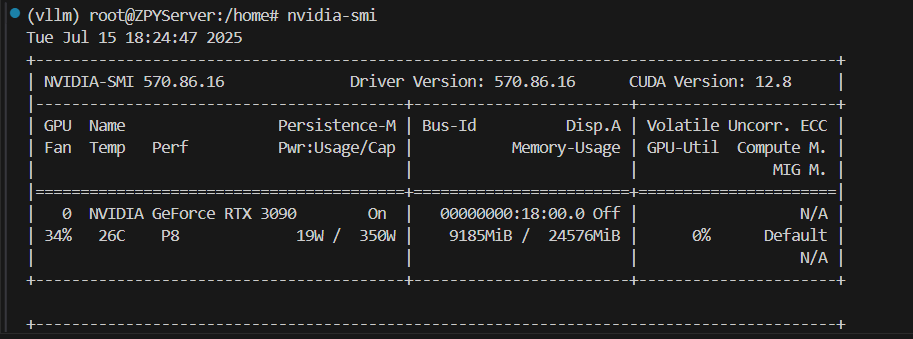

1.4 硬件環境校驗

nvidia-smi

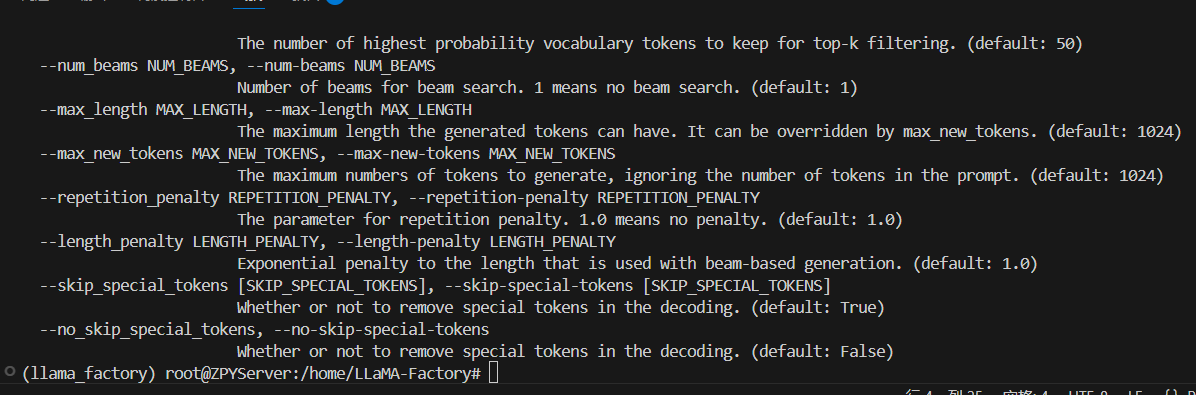

同時對本庫的基礎安裝做一下校驗,輸入以下命令獲取訓練相關的參數指導, 否則說明庫還沒有安裝成功

llamafactory-cli train -h

3.3 模型下載與可用性校驗

參考鏈接:

下面文章的2.2部分

https://blog.csdn.net/2401_85252837/article/details/149342446?spm=1001.2014.3001.5502

或者

1.項目支持通過模型名稱直接從huggingface 和modelscope下載模型,但這樣不容易對模型文件進行統一管理,所以這里筆者建議使用手動下載,然后后續使用時使用絕對路徑來控制使用哪個模型。

以Meta-Llama-3-8B-Instruct為例,通過huggingface 下載(可能需要先提交申請通過)

git clone https://huggingface.co/meta-llama/Meta-Llama-3-8B-Instruct2.modelscope 下載(適合中國大陸網絡環境)

git clone https://www.modelscope.cn/LLM-Research/Meta-Llama-3-8B-Instruct.git

或者#模型下載

from modelscope import snapshot_download

model_dir = snapshot_download('LLM-Research/Meta-Llama-3-8B-Instruct')

由于網絡環境等原因,文件下載后往往會存在文件不完整的很多情況,下載后需要先做一下校驗,校驗分為兩部分,第一先檢查一下文件大小和文件數量是否正確,和原始的huggingface顯示的做一下肉眼對比

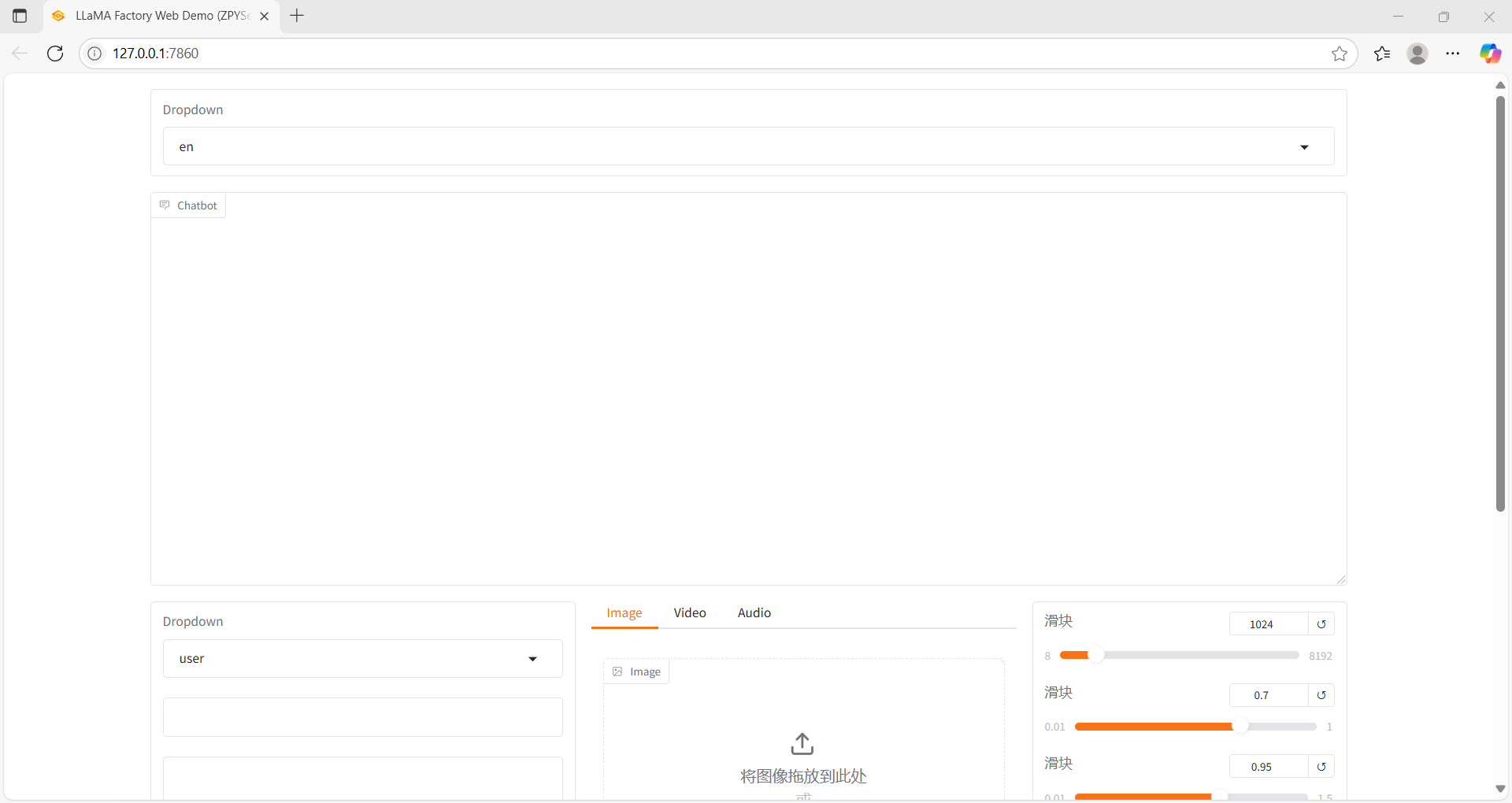

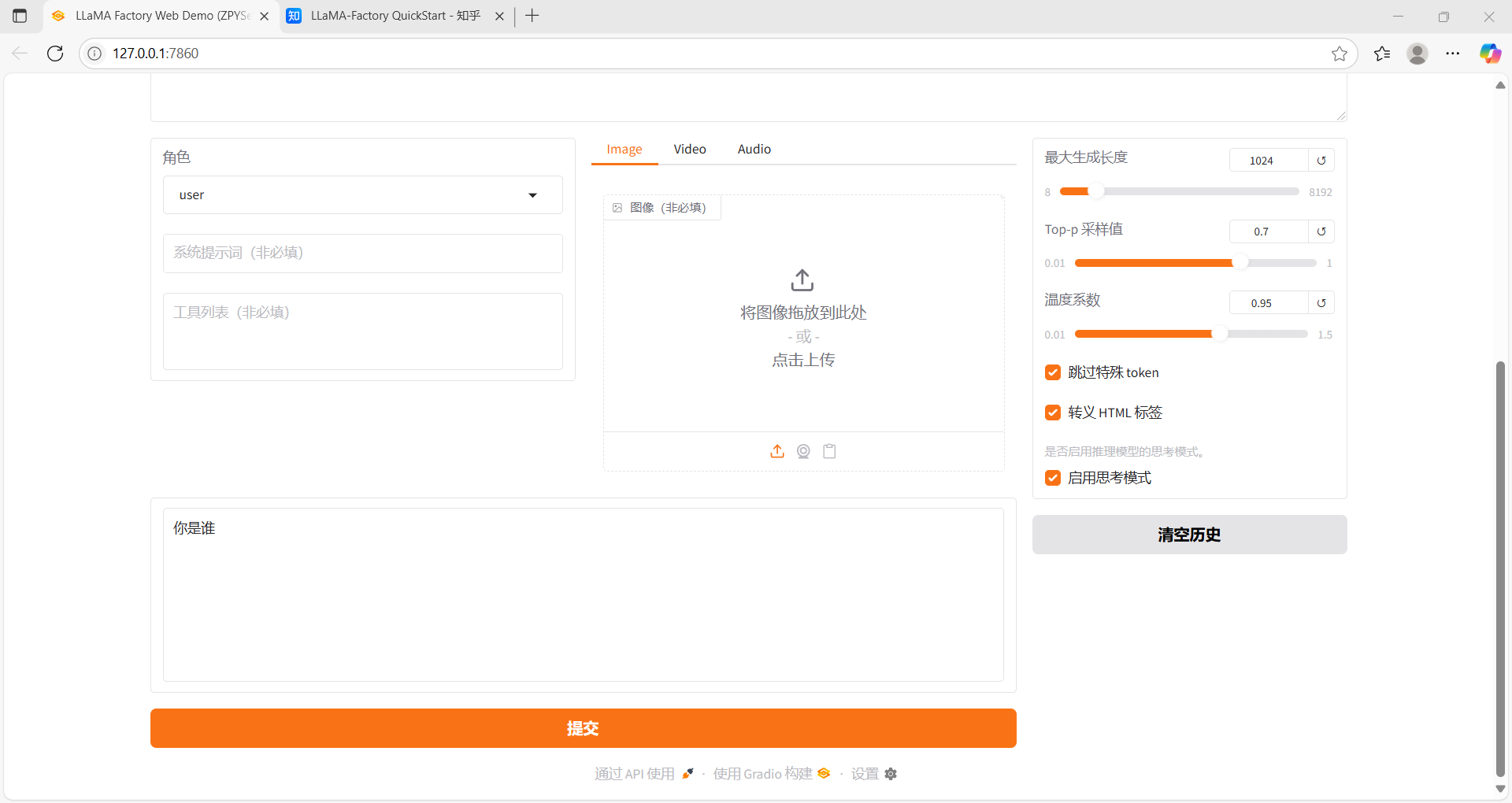

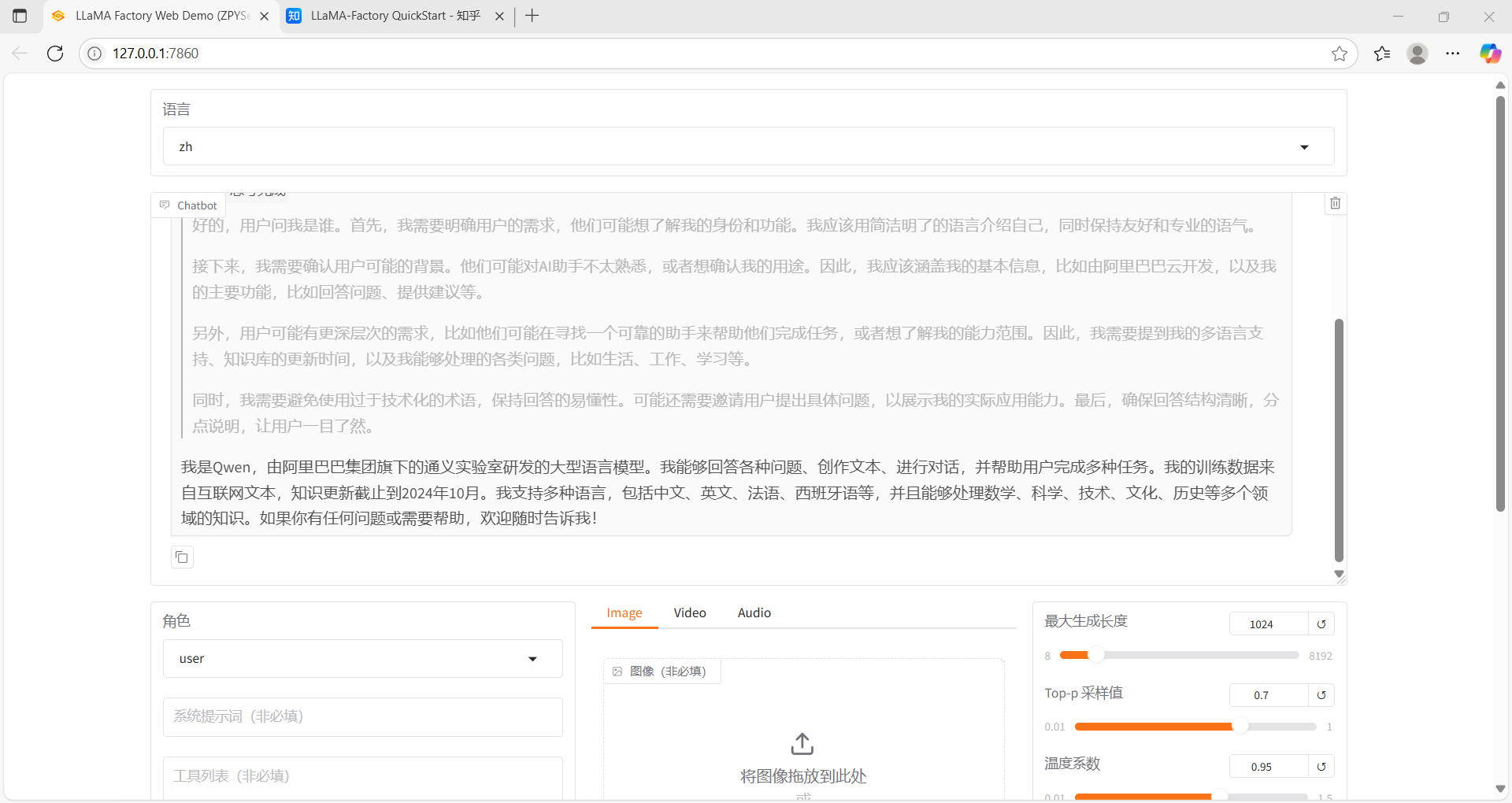

二、啟動

CUDA_VISIBLE_DEVICES=0 llamafactory-cli webchat \--model_name_or_path //home/models/Qwen3-4B \--template qwen \

)

免費API接口教程)

)

)