引言

在當今人工智能技術快速發展的時代,大型語言模型(LLM)已成為構建智能應用的核心組件。MCP(Modular Conversational Platform)作為一個強大的對話平臺,為開發者提供了將LLM能力與自定義工具集成的標準化方式。本文將詳細介紹如何使用Python開發一個能夠連接MCP服務器的LLM聊天機器人客戶端。通過本教程,您將掌握從環境配置到完整功能實現的全過程,構建一個具有工具調用能力的智能對話客戶端。

正文內容

系統要求與環境配置

在開始開發MCP客戶端之前,需要確保您的系統滿足以下基本要求:

- Mac或Windows操作系統

- 已安裝最新版本的Python

- 已安裝最新版本的uv工具

環境配置步驟如下:

# 創建項目目錄

uv init mcp-client

cd mcp-client# 創建虛擬環境

uv venv# 激活虛擬環境(Windows)

.venv\Scripts\activate

# 或MacOS/Unix

source .venv/bin/activate# 安裝必要包

uv add mcp anthropic python-dotenv# 移除樣板文件

rm main.py# 創建主文件

touch client.py

這些命令將創建一個干凈的Python項目環境,并安裝開發MCP客戶端所需的核心依賴項。使用虛擬環境可以隔離項目依賴,避免與其他Python項目產生沖突。

API密鑰配置

與大多數云服務類似,使用MCP客戶端需要配置API密鑰進行身份驗證。Anthropic API密鑰可以從Anthropic控制臺獲取,然后應存儲在項目根目錄下的.env文件中:

# 創建.env文件

touch .env# 在.env文件中添加密鑰

ANTHROPIC_API_KEY=<your_key_here># 確保.gitignore包含.env

echo ".env" >> .gitignore

這種配置方式既方便又安全,避免了將敏感信息硬編碼在源代碼中。.gitignore配置確保密鑰不會被意外提交到版本控制系統。

客戶端基礎結構

MCP客戶端的核心是一個管理會話和資源的主類。以下是基礎結構的實現:

import asyncio

from typing import Optional

from contextlib import AsyncExitStackfrom mcp import ClientSession, StdioServerParameters

from mcp.client.stdio import stdio_clientfrom anthropic import Anthropic

from dotenv import load_dotenvload_dotenv() # 從.env加載環境變量class MCPClient:def __init__(self):# 初始化會話和客戶端對象self.session: Optional[ClientSession] = Noneself.exit_stack = AsyncExitStack()self.anthropic = Anthropic()

這個基礎結構使用了Python的異步特性(asyncio)來管理并發操作,AsyncExitStack確保資源被正確釋放。ClientSession對象將管理與MCP服務器的通信,而Anthropic客戶端用于與Claude模型交互。

服務器連接管理

連接MCP服務器是客戶端的關鍵功能之一。以下是實現細節:

async def connect_to_server(self, server_script_path: str):"""連接到MCP服務器Args:server_script_path: 服務器腳本路徑(.py或.js)"""is_python = server_script_path.endswith('.py')is_js = server_script_path.endswith('.js')if not (is_python or is_js):raise ValueError("服務器腳本必須是.py或.js文件")command = "python" if is_python else "node"server_params = StdioServerParameters(command=command,args=[server_script_path],env=None)stdio_transport = await self.exit_stack.enter_async_context(stdio_client(server_params))self.stdio, self.write = stdio_transportself.session = await self.exit_stack.enter_async_context(ClientSession(self.stdio, self.write))await self.session.initialize()# 列出可用工具response = await self.session.list_tools()tools = response.toolsprint("\n連接到服務器,可用工具:", [tool.name for tool in tools])

此方法支持連接Python和Node.js實現的MCP服務器,驗證腳本類型后建立適當的通信通道。連接成功后,它會列出服務器上可用的工具,為后續的交互做好準備。

查詢處理邏輯

客戶端的核心功能是處理用戶查詢并與LLM和工具交互:

async def process_query(self, query: str) -> str:"""使用Claude和可用工具處理查詢"""messages = [{"role": "user", "content": query}]response = await self.session.list_tools()available_tools = [{"name": tool.name,"description": tool.description,"input_schema": tool.inputSchema} for tool in response.tools]# 初始Claude API調用response = self.anthropic.messages.create(model="claude-3-5-sonnet-20241022",max_tokens=1000,messages=messages,tools=available_tools)# 處理響應和工具調用final_text = []assistant_message_content = []for content in response.content:if content.type == 'text':final_text.append(content.text)assistant_message_content.append(content)elif content.type == 'tool_use':tool_name = content.nametool_args = content.input# 執行工具調用result = await self.session.call_tool(tool_name, tool_args)final_text.append(f"[調用工具 {tool_name} 參數 {tool_args}]")# 更新對話上下文assistant_message_content.append(content)messages.append({"role": "assistant","content": assistant_message_content})messages.append({"role": "user","content": [{"type": "tool_result","tool_use_id": content.id,"content": result.content}]})# 獲取Claude的下一個響應response = self.anthropic.messages.create(model="claude-3-5-sonnet-20241022",max_tokens=1000,messages=messages,tools=available_tools)final_text.append(response.content[0].text)return "\n".join(final_text)

這段代碼實現了完整的查詢處理流程:獲取工具列表、發送查詢到Claude、處理響應、執行工具調用、整合結果。它維護了對話上下文,使LLM能夠基于之前的交互做出更準確的響應。

交互式聊天界面

為了讓用戶能夠與客戶端交互,需要實現一個簡單的命令行界面:

async def chat_loop(self):"""運行交互式聊天循環"""print("\nMCP客戶端已啟動!")print("輸入查詢或'quit'退出")while True:try:query = input("\n查詢: ").strip()if query.lower() == 'quit':breakresponse = await self.process_query(query)print("\n" + response)except Exception as e:print(f"\n錯誤: {str(e)}")async def cleanup(self):"""清理資源"""await self.exit_stack.aclose()

這個循環持續讀取用戶輸入,處理查詢并顯示結果,直到用戶輸入"quit"。基本的錯誤處理確保異常不會導致程序崩潰。

主入口點

最后,我們需要一個主函數來協調整個客戶端的執行:

async def main():if len(sys.argv) < 2:print("用法: python client.py <服務器腳本路徑>")sys.exit(1)client = MCPClient()try:await client.connect_to_server(sys.argv[1])await client.chat_loop()finally:await client.cleanup()if __name__ == "__main__":import sysasyncio.run(main())

這個入口點處理命令行參數,初始化客戶端,管理主循環,并確保資源被正確清理。

關鍵組件詳解

1. 客戶端初始化

MCPClient類使用AsyncExitStack進行資源管理,這是Python中管理異步上下文資源的推薦方式。它同時初始化了與Claude交互的Anthropic客戶端,配置了API密鑰。這種結構確保了資源的高效使用和安全釋放。

2. 服務器連接

客戶端設計支持連接Python和Node.js實現的MCP服務器,驗證服務器腳本類型后建立標準輸入/輸出通信通道。連接成功后,它會初始化會話并獲取服務器上可用的工具列表,為后續交互做好準備。

3. 查詢處理

查詢處理邏輯維護完整的對話上下文,包括用戶消息、AI響應和工具調用結果。它能夠:

- 處理Claude的文本響應

- 識別并執行工具調用請求

- 將工具結果整合回對話流

- 生成連貫的最終響應

這種設計使客戶端能夠處理復雜的多輪交互,充分利用LLM和工具的能力^^參考內容中的"Query Processing"部分^^。

4. 交互界面

雖然實現了基本的命令行界面,但這個架構可以輕松擴展為更豐富的用戶界面,如GUI或Web應用。當前的實現包括:

- 簡單的提示和輸入處理

- 響應格式化輸出

- 基本錯誤顯示

- 優雅的退出機制

這些功能為用戶提供了基本的交互能力,同時保持代碼簡潔。

5. 資源管理

客戶端的資源管理設計考慮了可靠性:

- 使用AsyncExitStack確保所有資源被正確釋放

- 包含連接問題的錯誤處理

- 實現優雅的關閉流程

- 防止資源泄漏

這些特性對于構建健壯的客戶端應用至關重要。

常見自定義點

工具處理

開發者可以根據需要修改process_query()方法:

- 為特定工具類型添加專用處理邏輯

- 實現自定義的錯誤處理和恢復機制

- 調整工具結果的呈現方式

這些定制使客戶端能夠更好地適應特定的應用場景。

響應處理

響應處理可以進一步定制:

- 添加結果過濾或轉換邏輯

- 實現更復雜的日志記錄

- 支持多種輸出格式(如Markdown、HTML)

- 添加緩存機制提高性能

這些擴展可以增強客戶端的靈活性和實用性。

用戶界面

雖然本教程實現了基礎命令行界面,但可以擴展為:

- 圖形用戶界面(GUI)

- 基于Web的交互界面

- 支持富文本和控制字符的控制臺輸出

- 添加命令歷史、自動補全等高級功能

這些改進可以大幅提升用戶體驗。

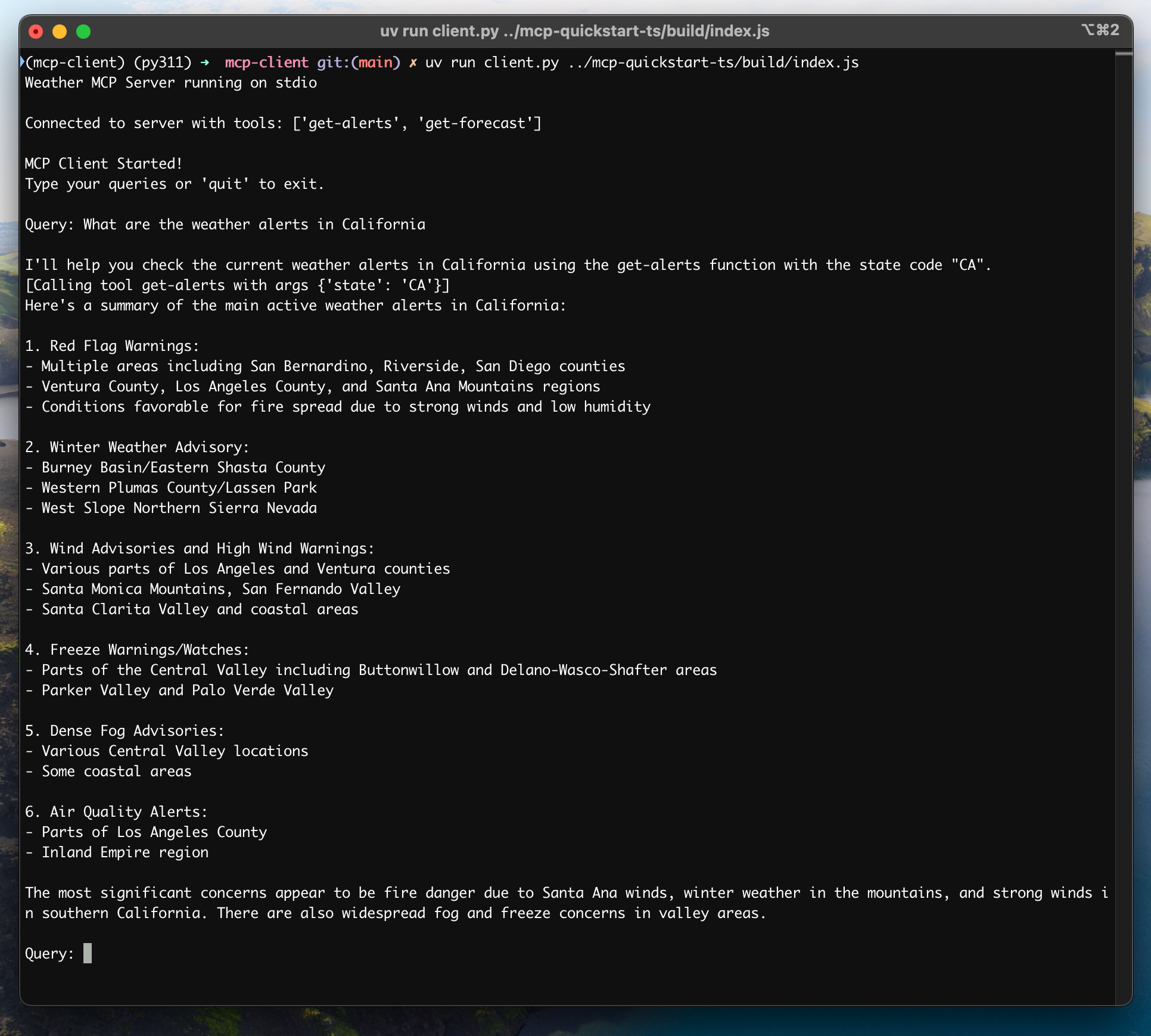

運行客戶端

要使用MCP服務器運行客戶端,執行以下命令:

uv run client.py path/to/server.py # Python服務器

uv run client.py path/to/build/index.js # Node.js服務器

客戶端將:

- 連接到指定服務器

- 列出可用工具

- 啟動交互式聊天會話

- 處理用戶查詢和工具調用

- 顯示Claude的響應。

工作原理

當用戶提交查詢時,客戶端執行以下流程:

- 從服務器獲取可用工具列表

- 將查詢和工具描述發送給Claude

- Claude決定是否/如何使用工具

- 客戶端通過服務器執行請求的工具調用

- 將工具結果發送回Claude

- Claude生成自然語言響應

- 向用戶顯示最終響應

這種架構充分利用了LLM的理解能力和專用工具的執行能力。

最佳實踐

錯誤處理

- 將所有工具調用包裝在try-catch塊中

- 提供清晰、有意義的錯誤信息

- 優雅處理連接問題

- 實現重試機制處理暫時性故障

這些實踐提高了客戶端的健壯性。

資源管理

- 始終使用AsyncExitStack進行資源清理

- 操作完成后及時關閉連接

- 處理服務器意外斷開的情況

- 監控資源使用情況

這些措施防止資源泄漏和系統不穩定。

安全性

- 安全存儲API密鑰(.env文件)

- 驗證所有服務器響應

- 謹慎管理工具權限

- 實現適當的訪問控制

安全意識對于生產級應用至關重要。

故障排除

服務器路徑問題

常見問題包括:

- 路徑不正確(使用絕對路徑或檢查相對路徑)

- Windows路徑分隔符問題(使用/或轉義的)

- 文件擴展名錯誤(應為.py或.js)

- 文件權限問題

驗證路徑是解決連接問題的第一步。

響應時間

- 首次響應可能需要30秒(服務器初始化、LLM處理)

- 后續響應通常更快

- 避免在初始化期間中斷進程

- 考慮增加超時設置處理復雜查詢

理解這些特性有助于設置合理的用戶期望。

常見錯誤

- FileNotFoundError: 檢查服務器路徑

- Connection refused: 確保服務器正在運行

- 工具執行失敗: 驗證環境變量和依賴項

- 超時錯誤: 調整客戶端超時設置

這些問題的系統化處理方法能提高調試效率。

結論

本文詳細介紹了如何開發一個基于MCP的LLM聊天機器人客戶端,涵蓋了從環境配置到完整功能實現的各個方面。通過Python實現,我們構建了一個支持工具調用、維護對話上下文的智能客戶端。關鍵點包括:

- 使用異步編程模型處理并發操作

- 標準化連接管理支持多種服務器類型

- 實現復雜的查詢處理流程整合LLM和工具

- 設計可擴展架構支持未來功能增強

- 遵循最佳實踐確保健壯性和安全性

這個客戶端為構建更復雜的AI應用提供了堅實基礎,開發者可以基于此實現各種創新解決方案。

系列文章:

MCP快速入門—快速構建自己的服務器

MCP核心架構解析

)

)

)

)