閱讀時間:2023-12-20

1 介紹

年份:2022

作者:Lina M. Tran,Adam Santoro,谷歌DeepMind

期刊: Proceedings of the National Academy of Sciences

引用量:13

代碼:https://github.com/linamnt/dnn-neurogenesis

Tran L M, Santoro A, Liu L, et al. Adult neurogenesis acts as a neural regularizer[J]. Proceedings of the National Academy of Sciences, 2022, 119(45): e2206704119.

本文探討成人神經發生(adult neurogenesis)在大腦中的作用,特別是它如何作為一種神經調節器來促進學習過程中的泛化能力。類似神經發生的進程作為一種正則化手段,促進類別學習任務中的泛化。在一個用于訓練CIFAR-10對象識別數據集的卷積神經網絡(CNN)中模擬了神經發生,將其視為一種替換/更替機制,即在模型學習對10個不同類別的對象進行分類時,隨機選擇一小部分隱藏層神經元的權重被重新初始化為新值。研究發現,與沒有神經發生的網絡相比,神經發生增強了在未見過的測試數據上的泛化能力。但是實驗表明隨機選擇和針對性選擇在性能上沒有顯著差異。

2 創新點

- 神經發生作為正則化機制的假設:提出成人神經發生可能在大腦中起到類似于機器學習中正則化技術的作用,這是一種新的視角,將神經科學的理論與機器學習的技術聯系起來。

- 計算模型的應用:使用計算模型來模擬神經發生過程,這種方法允許研究者在控制條件下測試神經發生對學習泛化能力的影響。

- 卷積神經網絡(CNN)的模擬:在CNN中模擬神經發生,通過重新初始化隱藏層中一小部分神經元的權重來模擬新神經元的整合,這種方法提供了一種新的神經網絡訓練策略。

- 神經發生的替換/更替機制:將神經發生視為一種替換機制,這種機制在神經網絡中通過隨機選擇并重新初始化權重來模擬新神經元的加入,這與以往研究不同,它專注于權重的動態變化。

- 與傳統正則化方法的比較:將神經發生作為一種正則化手段與傳統的正則化技術(如dropout、權重衰減和神經噪聲)進行了比較,發現神經發生至少與傳統正則化手段一樣有效。

- 神經興奮性的調節:研究了通過增加新神經元的激活來模擬其高興奮性是否能夠進一步促進網絡的正則化和性能提升。

- 針對性神經發生的探索:探索了是否有可能通過針對性地選擇哪些神經元進行更替來提高網絡性能,雖然結果表明隨機選擇和針對性選擇在性能上沒有顯著差異,但這為未來的研究提供了新的方向。

- 網絡魯棒性的分析:研究了神經發生對網絡依賴于單個神經元與分布式編碼的影響,發現神經發生可能通過不同于減少對單個神經元依賴的機制來提高泛化能力。

- 實驗代碼的公開:作者將實驗的代碼公開在GitHub上,這為其他研究者復現實驗結果和進一步研究提供了便利。

3 相關研究

論文《Hoel E. The overfitted brain: Dreams evolved to assist generalization[J]. Patterns, 2021, 2(5).》和《Richards, B.A., & Frankland, P.W. (2017). The Persistence and Transience of Memory. Neuron, 94, 1071-1084.》提出神經噪聲可能是大腦執行正則化以更好地提取經驗的統計規律性的一種策略。

4 算法

- CNN架構:使用的CNN包含多個卷積層和池化層,后接全連接層。輸入層接收32x32像素的RGB圖像,然后數據通過卷積層和池化層進行特征提取,最終通過全連接層進行分類。

- 神經發生模擬:在CNN的隱藏層中模擬神經發生,通過在訓練過程中隨機選擇一小部分神經元,并重新初始化它們的權重來模擬新神經元的整合。

- 替換/更替機制:神經發生被建模為一種“替換/更替”機制,其中選定的神經元的輸入和輸出權重被重置為新值,而成熟神經元的連接保持不變。選定的方式有隨機、權重大的部分、權重小的部分三種方式。

- 訓練過程:使用隨機梯度下降進行網絡訓練。在訓練過程中,神經發生以持續的方式實施,即在每個mini-batch更新后有一定概率發生神經元的更替。

- 超參數調整:確定神經發生發生頻率和每次更替事件中要重置的神經元數量,使用貝葉斯優化進行超參數調整。

- 增強興奮性:為了評估新神經元的興奮性對正則化的影響,實驗中增加了一個興奮性組件,在每次前向傳播中將新神經元的激活乘以一個興奮性因子。

5 實驗分析

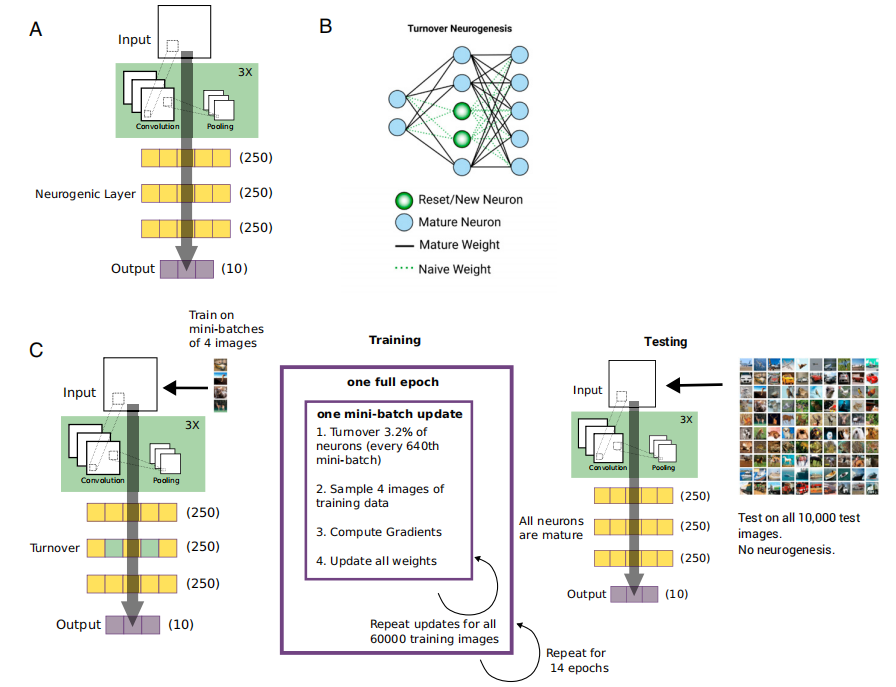

(1)神經發生實現過程圖示

- 圖1A 展示了在實驗中使用的卷積神經網絡(CNN)的結構示意圖。這個CNN包含多個卷積層和池化層,以及隨后的全連接層。輸入層接收32x32像素的RGB圖像,然后通過卷積層和池化層提取特征,最后通過全連接層進行分類。

- 圖1B 描述了如何在CNN中實施替換/更替(replacement/turnover)類型的神經發生。在這個過程中,全連接層中隨機選擇的一小部分神經元的權重會被重新初始化,模擬新神經元的整合。這種模擬不影響網絡的整體大小,但改變了網絡的連接模式。

- 圖1C 說明了在訓練過程中如何進行帶有神經發生的訓練,以及在測試時不進行任何神經發生的事件。訓練時,每隔一定數量的 minibatch 更新,就會執行一次神經發生的權重重置。而在測試階段,不進行任何權重的重置或神經元的更替。

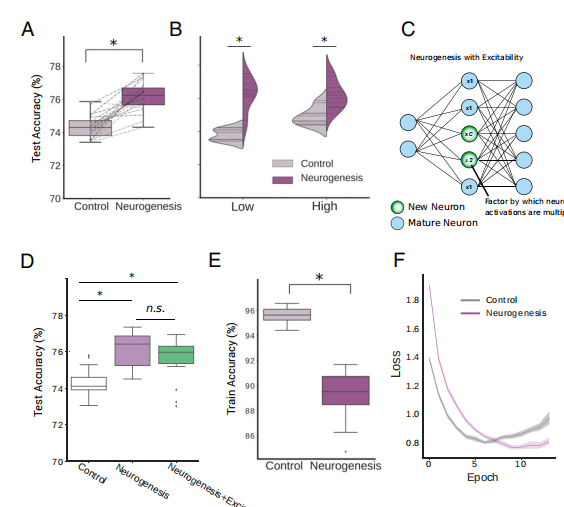

(2)訓練準確率和測試準確率的對比實驗

- 圖2A 展示了對照網絡(未引入神經發生)和神經發生網絡(引入了神經發生)在訓練后的測試準確率的箱線圖。箱線圖顯示了數據的分布和中位數,同時t檢驗的結果顯示神經發生網絡的測試準確率顯著高于對照網絡。

- 圖2B 通過小提琴圖展示了對照組和神經發生組在最低分(左側)和最高分(右側)的得分分布。小提琴圖提供了更詳細的信息,顯示了每個分數的頻率分布。t檢驗結果表明,無論是在最低分還是最高分的網絡中,引入神經發生都能顯著提高性能。

- 圖2C 示意了如何在神經發生網絡中實現新神經元的增強興奮性。通過將新神經元的激活乘以一個興奮性因子c,來模擬新神經元的高興奮性。

- 圖2D 展示了對照網絡、神經發生網絡以及增強興奮性的神經發生網絡在測試準確率上的箱線圖。ANOVA(方差分析)和Tukey’s HSD(Tukey誠實顯著性差異)測試表明,引入神經發生和增強興奮性的網絡在性能上均優于對照網絡。

- 圖2E 展示了對照組和神經發生組在訓練結束時的訓練準確率的箱線圖。t檢驗結果顯示,盡管神經發生網絡在訓練準確率上有所下降,但這種差異是顯著的。

- 圖2F 展示了在訓練過程中對照網絡和神經發生網絡的驗證損失變化。這有助于觀察模型在訓練過程中的泛化能力。

實驗結論:

引入神經發生的網絡,在訓練準確率上略有下降,但是在測試準確率高于未引入神經發生的對照網絡,這表明神經發生通過正則化效應提高了網絡的泛化能力。

(3)與其他正則化方法相比較

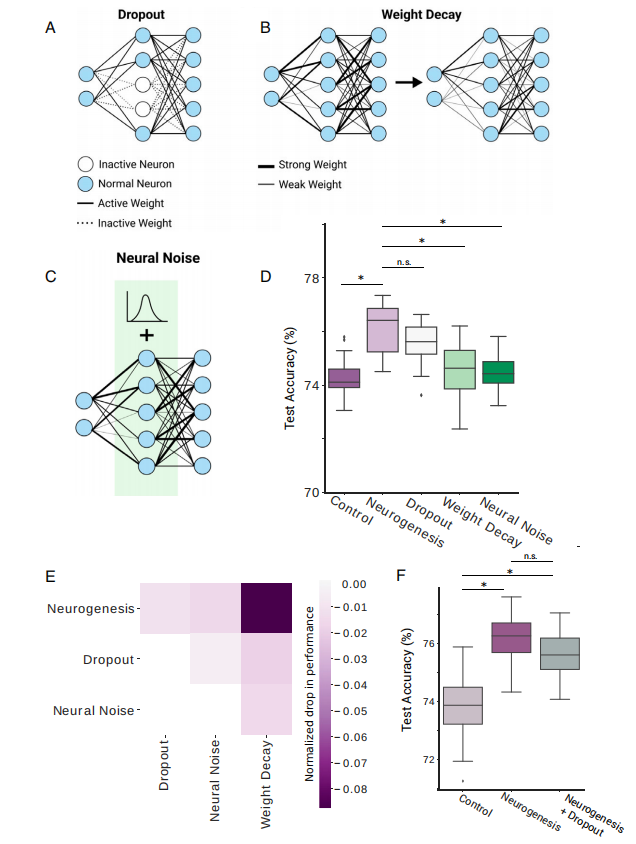

- 圖3A 展示了Dropout正則化方法:在每次前向傳播過程中,隨機地停用一部分神經元及其權重。

- 圖3B 展示了權重衰減(Weight decay):在損失函數中添加一個小的懲罰項,這個懲罰項會懲罰大的權重值,導致大的權重隨時間衰減。

- 圖3C 展示了神經噪聲(Neural noise):在每一層的激活值中添加高斯噪聲。

- 圖3D 展示了神經發生(Neurogenesis)與其他正則化方法(包括Dropout、權重衰減和神經噪聲)相比的測試準確率的箱線圖。方差分析(ANOVA)和Tukey’s HSD測試結果表明,神經發生與傳統的對照組相比有顯著提高,與Dropout相比沒有顯著差異,但與權重衰減和神經噪聲相比則有顯著提高。

- 圖3E 展示了使用組合正則化方法的網絡相對于僅使用神經發生的網絡的測試性能的熱圖。z分數表示性能的變化,熱圖顯示了不同組合方法的性能差異。

- 圖3F 展示了使用較低參數值的Dropout(0.1)和神經發生(每1000次更新更替一次)組合時的性能圖。方差分析顯示,這種組合方法并沒有比單獨使用神經發生的方法有更好的性能。

實驗結論:

神經發生作為一種正則化手段,在提高CNN的測試準確率方面與傳統的Dropout方法相當,并且優于權重衰減和神經噪聲方法。這表明神經發生可以作為一種有效的正則化技術,提高模型的泛化能力。當使用組合正則化方法時,例如同時使用神經發生和Dropout,并沒有觀察到性能的進一步提升。這可能表明,這些正則化方法的組合并不總是帶來累加的效果,甚至可能相互抵消。在某些情況下,組合使用不同的正則化技術可能會降低模型的性能。這些發現強調了在選擇正則化策略時需要考慮正則化方法之間的相互作用,以及它們對特定任務和模型架構的適應性。

(4)探討神經發生的條件

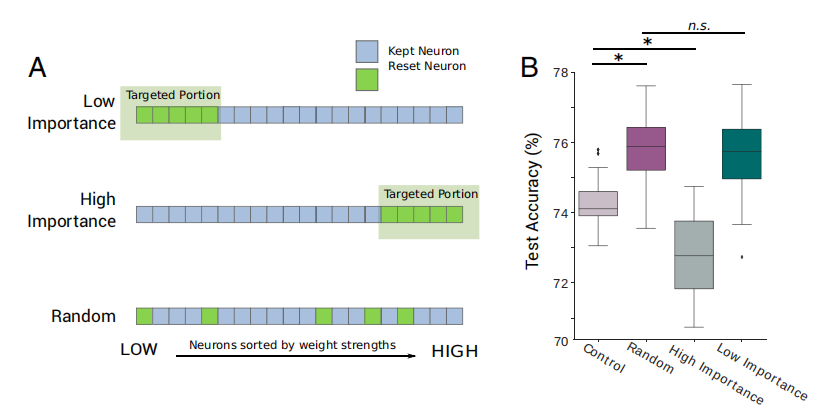

- 圖4A 展示了在隱藏層中實施目標神經發生(Targeted Neurogenesis)的示意圖。在這個方法中,神經元根據輸入權重的大小進行排序,然后選擇權重最低的(認為較不重要的)或權重最高的(認為較重要的)神經元進行神經發生處理,即重置這些神經元的權重。還有一種情況是不進行目標選擇,即隨機選擇神經元進行神經發生(Random)。

- 圖4B 展示了對照組(Control)、隨機神經發生(Random Neurogenesis)、針對權重最高的神經元的目標神經發生(High Importance Neurons,作為陽性對照組)、以及針對權重最低的神經元的目標神經發生(Low Importance Neurons)的模型測試準確率的箱線圖。圖中還包括了方差分析(ANOVA)和Tukey’s HSD(Tukey誠實顯著性差異)的統計測試結果。

實驗結論:

實驗結果表明,與隨機神經發生相比,目標性地對權重最高的神經元進行神經發生(High Importance Neurons)會顯著降低模型的測試準確率,這可能是因為這些權重較高的神經元對網絡性能有重要貢獻,重置它們的權重可能損害了網絡已經學到的有用特征。另一方面,目標性地對權重最低的神經元進行神經發生(Low Importance Neurons)并沒有比隨機神經發生帶來性能上的提升。這表明在權重大小的基礎上進行的目標選擇可能不是提高神經發生效果的有效策略。簡單地基于權重大小來選擇哪些神經元進行神經發生可能不足以優化網絡性能。可能需要更復雜的方法來確定哪些神經元對網絡學習最關鍵,以及如何通過神經發生來有效地調節網絡的泛化能力。

(5)消融實驗

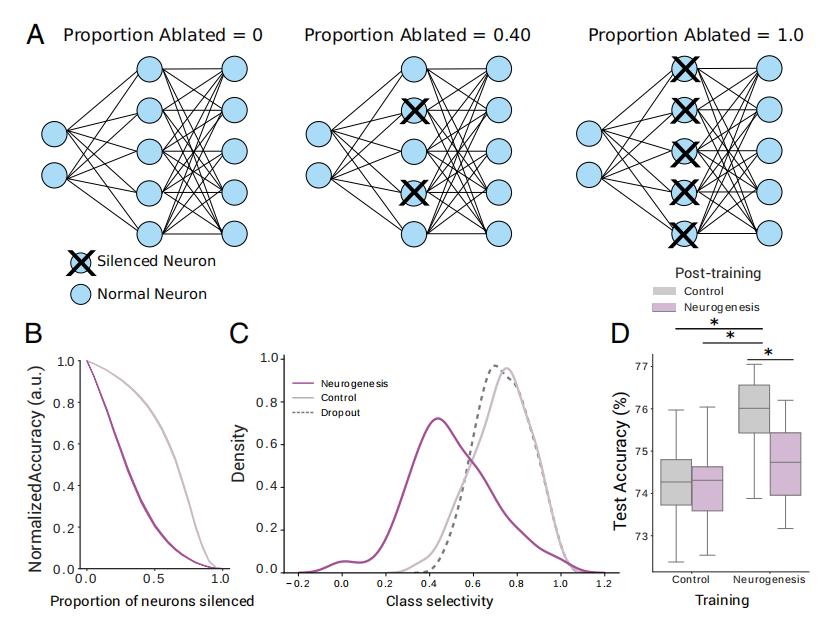

- 圖5A 展示了消融實驗(Ablation Experiments)的示意圖。消融實驗是一種評估網絡中單個神經元或神經元組重要性的方法,通過逐漸移除(消融)網絡中的神經元,并觀察這對網絡性能的影響。

- 圖5B 展示了隨著網絡中逐漸增加消融神經元數量,20次重復實驗的平均歸一化準確率的變化曲線。歸一化準確率是將消融后的準確率與原始準確率進行比較,以衡量消融對網絡性能的影響。

- 圖5C 展示了對照組、神經發生組和Dropout組在第二隱藏層神經元的類選擇性(Class Selectivity)的密度圖。類選擇性是指神經元對特定類別的激活程度,反映了神經元對不同類別的偏好性。

- 圖5D 展示了訓練后測試準確率的箱線圖,這些網絡在訓練時有或沒有引入神經發生,并在測試時有或沒有添加新神經元。此外,還展示了重復測量方差分析(Repeated-measures ANOVA)的結果,用以分析訓練和測試后添加新神經元的交互效應。

實驗結論:

引入神經發生的網絡相對于對照網絡,在消融神經元后顯示出較低的魯棒性。這意味著,雖然神經發生提高了網絡的泛化能力,但這些網絡對單個神經元的依賴性更高,消融較少比例的神經元就足以顯著影響性能。

類選擇性密度圖顯示了不同網絡條件下神經元的類選擇性分布。這可能表明神經發生對網絡中信息編碼方式的影響,以及不同網絡如何通過其神經元對輸入數據進行分類。

6 思考

(1)只在全連接層實現的神經元更替,不具有代表性,應該在其他網絡結構上也試一試效果

(2)神經發生組相對于對照組訓練準確率低,但測試準確率高的現象,可以通過以下幾個方面來解釋:

- 正則化效應:神經發生可以作為一種正則化機制。在機器學習中,正則化技術用來減少模型對訓練數據的過擬合,提高模型在未見數據上的泛化能力。神經發生通過在訓練過程中引入新的、未經訓練的神經元,增加了模型的噪聲,這迫使網絡學習更加魯棒的特征表示,而不是僅僅記住訓練數據。

- 減少對訓練數據的過度擬合:對照組網絡可能在訓練數據上表現得很好,但可能過于適應這些數據,導致在新的測試數據上泛化能力下降。而神經發生組雖然在訓練數據上的表現不如對照組,但因為減少了對特定訓練樣本的依賴,它能夠更好地泛化到新的測試數據上。

- 促進特征的泛化表示:神經發生的引入可能促進了網絡權重的更優分布,使得網絡能夠捕捉到更加泛化的特征表示,這些特征在新的測試集上同樣有效。

- 權重重置帶來的靈活性:在神經發生過程中,新神經元的權重是隨機初始化的,這為網絡提供了額外的靈活性來調整其參數,以更好地適應測試數據。

- 損失景觀的探索:神經發生可能幫助網絡在權重空間中探索更廣闊的區域,從而有可能找到比傳統訓練方法更優的局部最小值。

- 訓練和測試的權衡:神經發生組可能在訓練過程中犧牲了一些準確率,但這種犧牲換來了在測試集上的更高準確率,這表明模型在訓練時避免了對噪聲或特定樣本的過度學習。

- 統計學習理論:根據統計學習理論,適當的模型復雜度和正則化可以幫助模型更好地捕捉數據的潛在分布,即使這可能導致訓練誤差的略微增加。

(3)本文算法存在的缺點

沒有確定如何進行神經元替換(神經元發生),沒有一個明確的指標。簡單地基于權重大小來選擇哪些神經元進行神經發生可能不足以優化網絡性能。可能需要更復雜的方法來確定哪些神經元對網絡學習最關鍵,以及如何通過神經發生來有效地調節網絡的泛化能力。

(4)什么是類選擇性?有什么作用?

類選擇性(Class Selectivity)是指神經元對特定類別或類別之間差異的響應特性。在神經網絡和機器學習的背景下,每個神經元可能會對輸入數據的某些特征表現出更高的激活水平,這反映了它對該特征的“偏好”或“選擇性”。當一個神經元對特定類別的輸入表現出顯著高于其他類別的激活時,我們稱這個神經元具有高類選擇性。類選擇性也是評估網絡泛化能力的一個指標。通常認為,具有高類選擇性的神經元可能有助于網絡在特定任務上的表現,但也可能降低網絡對新或未見類別的泛化能力。相反,低類選擇性可能表明網絡能夠更靈活地響應多種輸入,從而提高泛化能力。

類選擇性密度圖是展示網絡中神經元對不同類別的響應強度分布。在這種圖中,每個點或區域代表一個神經元,而它們在圖中的位置表示對不同類別的偏好程度。

)

)

)

類型字段支持選擇字段轉化為int或者boolean)

.getDimension引起的問題)