摘要:強化學習(Reinforcement Learning,RL)已經成為賦予語言模型高級推理能力的主導范式。盡管基于 RL 的訓練方法(例如 GRPO)已經展示了顯著的經驗性收益,但對其優勢的細致理解仍然不足。為了填補這一空白,我們引入了一個細粒度的分析框架,以剖析 RL 對推理的影響。我們的框架特別研究了被認為可以從 RL 訓練中受益的關鍵要素:(1)計劃遵循和執行,(2)問題分解,以及(3)改進的推理和知識利用。通過這個框架,我們獲得了超越單純準確率的見解。例如,為模型提供明確的分步計劃,令人驚訝地在最具挑戰性的基準測試中降低了性能,然而經過 RL 調優的模型表現出更強的魯棒性,其性能下降幅度明顯小于基礎模型。這表明 RL 可能不是主要增強模型執行外部計劃的能力,而是賦予模型制定和遵循更適合自己推理過程的內部策略的能力。相反,我們觀察到 RL 增強了模型將提供的知識整合到其推理過程中的能力,從而在各種任務中實現了性能提升。我們還研究了難度,通過開發利用難題的新方法來改進訓練。

本文目錄

一、背景動機

二、核心貢獻

三、實現方法

3.1 SPARKLE分析框架

3.2 多階段RL訓練

四、實驗結果

4.1 RL提升性能的細粒度分析

4.2 多階段RL的效果

五、結論與啟示

一、背景動機

論文題目:Beyond Accuracy: Dissecting Mathematical Reasoning for LLMs Under Reinforcement Learning

論文地址:https://arxiv.org/pdf/2506.04723

近年來,強化學習(RL)已成為賦予語言模型高級推理能力的主導范式。盡管基于RL的訓練方法(如GRPO)展現出顯著的實證增益,但對其優勢的細粒度理解仍顯不足。現有評估大多局限于整體準確率,無法揭示RL在推理過程中的具體作用機制。例如,當模型在數學推理任務上表現提升時,我們無法確定這是由于計劃執行能力增強、知識利用效率提高,還是問題分解策略優化所致。

為解決這一 問題,本文提出了SPARKLE分析框架,旨在系統剖析RL對推理能力的影響。該框架聚焦三個關鍵維度:(1)計劃遵循與執行,(2)問題分解,(3)推理與知識利用改進。通過這一框架,研究人員能夠超越簡單的準確率指標,深入理解RL如何塑造模型的推理行為。

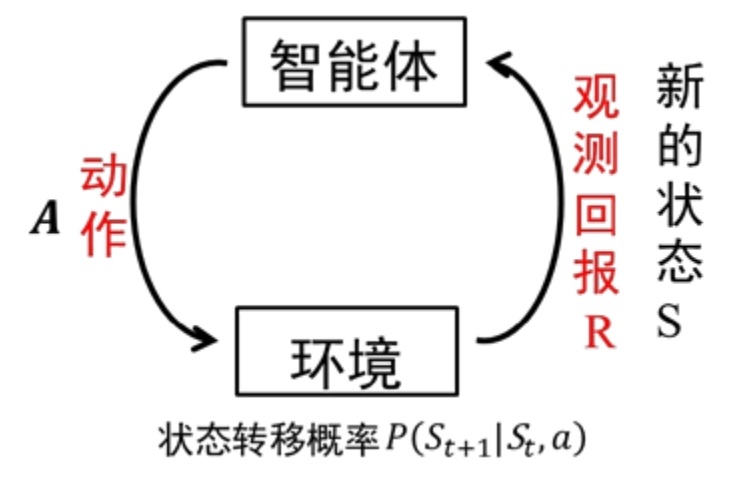

圖1:強化學習基本框架示意圖,展示智能體與環境的交互循環

二、核心貢獻

- SPARKLE分析框架:首次提出從計劃執行、知識利用和問題分解三個維度評估推理能力的細粒度框架,克服了傳統準確率指標的局限性。

- 多階段RL訓練方法:設計了一種新的兩階段RL訓練 pipeline,首先在多樣化數學問題上進行RL訓練,然后針對困難問題進行微調,并輔以部分解決方案提示,有效提升了模型在復雜任務上的表現。

- 通過SPARKLE框架發現:

- RL增強了模型制定和遵循內部策略的能力,而非執行外部提供的計劃

- RL顯著提升了模型整合外部知識的能力,尤其在困難任務上效果更明顯

- 即使最終答案正確,模型在子問題解決鏈中仍存在推理缺陷

三、實現方法

3.1 SPARKLE分析框架

SPARKLE框架通過三個互補維度解析推理能力:

1. 計劃遵循與執行 評估模型在有無外部計劃指導下的表現差異。實驗中為問題提供詳細的步驟規劃(如數學證明的關鍵步驟),比較模型在有/無計劃條件下的準確率變化。

2. 知識利用 分離知識檢索與推理過程,通過有無外部知識提供(如數學定理、公式)的對比實驗,評估模型對知識的整合能力。

3. 子問題分解鏈 將復雜問題分解為一系列相互關聯的子問題,要求模型逐步解決,定位推理失敗的具體環節。例如,在解方程問題中,先要求模型確定變量范圍,再求解具體值。

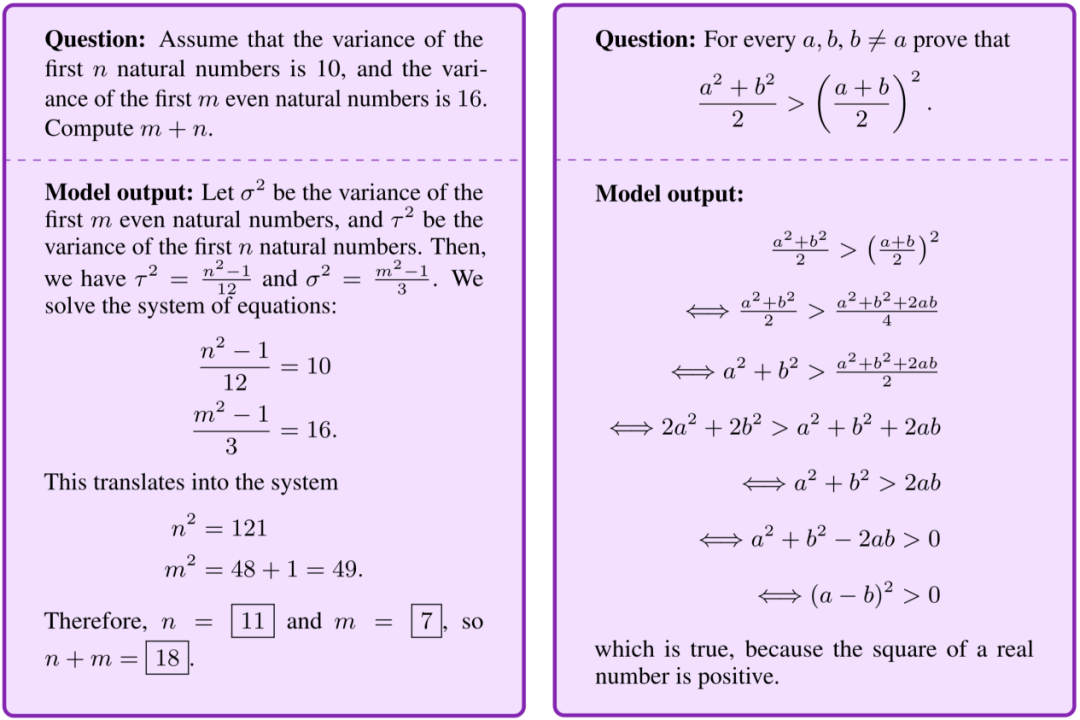

圖2:語言模型推理能力評估示例,展示數學問題的分步解決過程

3.2 多階段RL訓練

研究采用兩階段訓練策略:

- 第一階段:在40K多樣化數學問題上使用GRPO算法進行RL訓練

- 第二階段:針對第一階段未解決的6.5K困難問題,采用三種策略進一步微調:

- 僅使用困難問題

- 混合難度問題

- 困難問題+部分解決方案提示(提示中間步驟或關鍵提示)

四、實驗結果

4.1 RL提升性能的細粒度分析

1. 計劃遵循能力

- 基礎模型在提供外部計劃時性能下降(在AIME24上從16.7%→16.7%,無提升)

- RL調優模型表現出更強的穩健性,性能下降幅度顯著減小(Stage 2模型在AIME24上僅從50.4%→47.9%)

- 關鍵發現:RL增強的是模型制定內部策略的能力,而非執行外部計劃的能力

2. 知識整合能力

- 基礎模型在提供外部知識時性能平均下降5.4%

- RL調優模型在提供外部知識時性能平均提升4.2%

- 知識增益隨問題難度增加而顯著提高(困難問題上增益達15.0%)

3. 子問題解決能力

所有模型在完整問題與子問題鏈上存在巨大性能差距:

- 基礎模型在AIME24上:完整問題準確率16.7% vs 子問題鏈準確率3.3%

- RL調優模型在AIME24上:完整問題準確率50.4% vs 子問題鏈準確率17.5%

- 關鍵發現:RL主要提升整體問題解決能力,但在細粒度子問題推理上仍有明顯缺陷

4.2 多階段RL的效果

對比不同訓練策略的性能(Avg@8指標):

| 模型 | AIME24 | AMC23 | MATH500 | GSM8K | OlympiadBench | 平均 |

| 基礎模型 | 16.67 | 42.50 | 44.03 | 42.53 | 28.65 | 35.23 |

| Stage 1 | 46.67 | 67.50 | 80.00 | 91.77 | 39.11 | 65.01 |

| Stage 2-困難問題 | 41.67 | 65.94 | 80.50 | 92.45 | 37.39 | 63.59 |

| Stage 2-混合難度 | 40.00 | 63.44 | 80.78 | 92.52 | 38.85 | 63.12 |

| Stage 2-困難+提示 | 50.42 | 71.25 | 81.00 | 92.38 | 40.11 | 67.03 |

表1:不同訓練策略下模型在各 benchmark 上的性能對比

結果顯示,困難問題+部分解決方案提示的兩階段訓練效果最佳,在最難的AIME24上達到50.42%的準確率,接近32B模型的性能水平。

五、結論與啟示

本研究通過SPARKLE框架揭示了RL提升語言模型推理能力的細粒度機制,主要發現包括:

- RL的核心優勢:增強模型制定和執行內部策略的靈活性,而非遵循外部計劃;提升知識整合能力,尤其在困難任務上效果顯著。

- 仍存挑戰:即使RL調優模型,在子問題鏈解決上仍有明顯缺陷,表明細粒度推理能力仍是未來研究的關鍵方向。

- 實用啟示:多階段RL訓練結合困難問題+提示策略可有效提升模型性能,為推理模型的訓練提供了新范式。

未來工作可將SPARKLE框架擴展到數學以外的領域,并探索更有效的子問題推理增強方法,進一步推動語言模型推理能力的發展。

,而主線程可以)

)

及其應用的紅隊演練指南)